第 12 章:AI 基准测试

目标

为什么系统化测量是机器学习系统工程进步的基础?标准化基准测试又如何推动这一新兴领域的科学发展?

工程学科的进步离不开测量与比较,基准测试已成为机器学习系统开发的核心环节。没有系统化的评测框架,优化效果缺乏科学依据,硬件投资缺乏数据支撑,系统改进也无法验证或复现。基准测试将主观印象转化为客观数据,使工程师能够区分真正的进步与实现细节带来的假象。由于 ML 系统涉及算法、硬件与数据的复杂交互,性能难以凭直觉预测,测量纪律尤为重要。标准化基准为不同研究团队建立了共享基线,推动可复现的累积性进步,并为工程决策提供实证基础。掌握基准测试原理,能够驱动系统性评估与持续改进,确立机器学习系统工程的科学属性。

学习目标

- 分析传统计算基准到现代 ML 评测框架的演变,解释基准作弊的教训如何影响当前 ML 基准设计

- 区分 ML 基准的三大维度(算法、系统、数据),评估各自对系统评测的贡献

- 比较训练与推理基准方法,识别各阶段适用的指标与评测协议

- 应用 MLPerf 标准评测硬件与软件方案,解读结果指导系统优化

- 设计统计严谨的实验方案,考虑 ML 系统的变异性,包括样本量与置信区间报告

- 批判性分析现有基准结果,识别常见谬误与陷阱,区分基准性能与真实部署效果

- 实施生产监控,将基准测试原则延伸到运维环境,包括 A/B 测试与持续模型验证

- 综合评估准确率、延迟、能耗、公平性等多维性能权衡,针对特定场景优化 ML 系统

机器学习基准框架

系统性评估机器学习系统,是性能工程领域的核心方法论挑战。前几章已建立了全面的优化框架,尤其是硬件加速策略(详见 第 11 章:AI 加速 ),而这些优化的有效性,必须通过超越传统计算基准的严谨测量方法来验证。

工程师在评估 AI 硬件方案时常遇到这样的难题:厂商可能在精心挑选的基准上展示出色性能,但在实际生产负载下却无法复现。没有全面的评测框架,难以区分真正的进步与实现细节带来的假象。这正说明了系统化测量为何是机器学习系统工程进步的基石。

本章将基准测试作为一门实证学科,系统梳理机器学习系统在多样化场景下的性能评估方法。基准测试为工程决策提供了方法论基础,使从业者能够系统比较不同方案、验证优化策略,并确保研究与生产环境下的性能声明可复现。

机器学习基准面临独特挑战,区别于传统系统评测。ML 算法的概率性带来固有的性能波动,传统确定性基准难以刻画。ML 系统性能受数据特性、模型结构、计算资源等多因素影响,形成多维评测空间,需要专门的测量方法。

现代 ML 系统要求评测框架能兼顾多重、甚至相互冲突的性能目标。除了计算效率,还需考察预测准确率、收敛特性、能耗、公平性与稳健性等维度。这一多目标评测范式,要求基准方法能刻画权衡关系,指导系统设计决策。

本领域已发展出覆盖三大核心维度的综合评测方法:

机器学习基准测试

机器学习基准测试 是对 计算性能、算法效果与数据质量 的系统性评估。它衡量 系统能力、模型准确率与收敛性、数据可扩展性与代表性,以优化各类工作负载下的系统表现。ML 基准使工程师和研究者能够 量化权衡、提升部署效率、确保研究与生产的可复现性。

本章将系统梳理机器学习基准方法,首先回顾计算评测框架的历史演变及其如何适应概率性系统的特殊需求。我们将分析如 MLPerf 等标准化评测框架,如何为多样硬件架构与实现方案建立可比基线。随后,探讨训练与推理评测的本质区别,解析各自所需的专用指标与方法。

讨论还将延伸到资源受限的移动与边缘部署场景,分析其独特的测量挑战。最后,探讨如何将基准测试原则延伸到生产监控,实现从实验室到运维环境的动态评测。通过本章,读者将理解如何用严谨测量验证前述章节的优化与加速成果,并为后续部署策略(见第四部分)奠定实证基础。

历史背景

从简单性能指标到全面 ML 基准的演变,经历了三次关键方法论转变,每一步都针对前一代评测范式的失败,总结出直接指导当前方法的经验。

性能基准

早期基准作弊现象暴露后,评测从合成操作转向代表性工作负载。主机时代的 Whetstone(1964)和 LINPACK(1979)只测算单一操作,厂商可针对性优化,难以反映实际性能。SPEC CPU(1989)首创用真实应用负载,确保评测贴合实际部署。MLPerf 采用 ResNet-50、BERT 等真实模型,正是吸取了这一教训,避免只在理想化测试下优化。

随着应用场景多样化,基准从单一指标转向多目标评测。图形基准兼顾画质与速度,移动基准同时考察续航。正如 第 9 章:高效 AI 所述,现代 ML 评测需平衡准确率、延迟、能耗等多维目标。

分布式计算兴起后,基准从组件级转向系统级。单一部件优化无法预测整体性能,ML 训练不仅依赖加速器算力(见 第 11 章:AI 加速 ),还受数据管道、梯度同步、存储吞吐等影响。MLPerf 评测完整流程,强调性能源自组件协同。

这些经验最终汇聚于 MLPerf(2018),融合了代表性负载、多目标评测与系统集成测量,并针对 ML 特有挑战做出创新。

能耗基准

多目标评测范式自然扩展到能效,尤其在移动与大规模计算场景下。移动设备强调续航,数据中心则关注能耗成本。SPEC Power1、Green5002、ENERGY STAR3 等基准,使能效成为与性能并列的核心指标。

尽管进步显著,能耗基准仍面临多样负载与系统配置的挑战。MLPerf Power 等新方法,专为 ML 负载能耗测量设计,回应 AI 计算能效日益重要的趋势。

能耗评测不仅限于硬件功耗,算法优化同样关键。剪枝可使 BERT 模型参数减少 10 倍,推理加速 4~8 倍,能耗降低 8~12 倍。量化(如 INT8)通常带来 4 倍推理加速与能耗降低,准确率损失极小。知识蒸馏与 MobileNet 等高效架构,使移动与边缘 AI 成为可能。

能效基准需同时评估硬件功耗与算法效率,如稀疏化带来的 FLOP 降低、压缩减少的内存访问、量化的计算能耗优势。算法优化往往比硬件提升更显著,是现代 AI 能效评测不可或缺的一环。

随着 AI 与边缘计算发展,能耗基准将驱动软硬件协同创新,直接关联 第 18 章:可持续 AI 的绿色设计理念。

行业专用基准

计算多样化催生了面向特定领域的专用基准,弥补通用指标的不足。专用基准主要关注三类特性:

- 部署约束决定核心指标。数据中心追求吞吐与高功耗,移动 AI 受限于 2~5W,IoT 仅有毫瓦级。指标优先级直接受 第 9 章:高效 AI 影响。

- 应用需求带来功能与合规要求。医疗 AI 需可解释性,金融系统要求微秒级延迟与审计,自动驾驶需安全认证(ASIL-D)。这些需求与 第 17 章:可信 AI 的责任原则紧密相关。

- 运行环境决定实际可用性。自动驾驶需耐受极端温度与传感器失效,数据中心需应对网络分区,工业 IoT 要求多年免维护。硬件能力只有在真实环境下验证才有意义。

ML 是专用基准转型的典型代表。传统 CPU/GPU 基准难以评估 ML 负载的计算、带宽与数据流复杂交互。MLPerf 针对三类场景:Training(数据中心多节点)、Inference(服务器到边缘)、Tiny(微控制器),系统性覆盖了部署、应用与环境三大需求。

专用基准的优势在于能捕捉通用基准忽略的特殊需求,驱动软硬件有针对性的优化,确保改进真正转化为实际部署价值,而非仅在实验室条件下“刷分”。

这一从通用到能效再到专用的历史演进,为理解现代 ML 基准挑战奠定了基础。代表性负载、多目标评测、系统集成三大经验,直接塑造了今天的 AI 评测方法。

机器学习基准

历史演进的终点是机器学习基准,其复杂性超越以往所有计算领域。与确定性负载不同,ML 系统因概率性带来固有不确定性。CPU 基准同输入必得同结果,ML 模型则因数据、初始化、操作顺序等多因素波动。正因如此,三维评测框架成为必然选择。

基于前述框架与优化技术,ML 基准不仅要评估计算效率,更要考察算法、硬件与数据的复杂耦合。早期 ML 基准只关注算法性能,随着应用规模与算力需求激增,系统性能与硬件效率成为焦点,数据质量则成为第三维。

AI 基准与传统性能指标的最大不同,是准确率成为与速度、能耗并列的核心维度。模型的概率性决定了同一系统面对不同数据可能表现迥异,准确率成为性能评估的决定性因素。这使得基准设计更为复杂:不仅要测算效率,还要权衡准确率、泛化能力与资源约束。

能效成为三维框架的交叉主题:算法选择影响计算复杂度与功耗,硬件决定能效权衡,数据特性影响训练能耗。这一多维评测方式,已远超早期只关注单一指标的基准。

基准复杂性的演变,正反映了业界对 ML 成功要素的认识转变。算法创新曾是进步的唯一衡量标准,实际部署暴露了硬件效率的重要性,现实失败又凸显了数据质量对可靠性与公平性的决定作用。理解三维交互,已成为准确评估 ML 系统、指导开发与衡量技术进步的必备基础。

ML 测量挑战

ML 系统的独特特性,带来了传统基准无法遇到的测量挑战。与给定输入必然产生相同输出的确定性算法不同,ML 系统因多种因素(如算法随机性、硬件状态、系统负载、环境变化等)导致性能波动。这种波动性要求采用严谨的统计方法,区分真实的性能提升与测量噪声。

为应对这种波动,基准测试需多次实验,使用不同随机种子。每个基准测试运行 5-10 次,并报告标准差或 95% 置信区间等统计指标,量化结果稳定性,帮助从业者识别真实的性能提升。

近期研究表明,统计严谨性不足可能导致误导性结论。许多强化学习论文报告的改进,实际上都在统计噪声范围内;而 GAN 比较常常缺乏适当的实验方案,不同随机种子下排名不一致。这些发现强调了建立全面测量方案的必要性,以应对 ML 的概率特性。

代表性负载选择对基准有效性至关重要。合成微基准往往无法捕捉真实 ML 负载的复杂性,如数据移动、内存分配与动态批处理等性能模式。全面基准需使用反映实际部署模式的工作负载,如语言模型中的可变序列长度、混合精度训练方案,以及包含预处理开销的真实数据加载模式。

统计显著性与实际显著性的区别,需要谨慎解读。小幅性能提升可能在数百次试验中达到统计显著,但如果在测量噪声范围内,或成本超过收益,则在实际操作中可能无关紧要。

解决这一问题需通过优先选择代表性负载而非合成测试的基准设计。有效的系统评估依赖于端到端应用基准,如 MLPerf,涵盖数据预处理并反映真实部署模式。当开发自定义评估框架时,分析生产负载有助于识别有意义评估所需的代表性数据分布、批量大小与计算模式。

当前基准范式常因仅测量狭隘任务性能,而忽视决定真实系统有效性的特征。大多数现有基准评估监督学习在静态数据集上的表现,主要测试模式识别能力,而非生产部署所需的适应性与稳健性。为弥补这些不足,全面系统评估必须同时测量学习效率、持续学习能力与分布外泛化能力,以及传统指标。

算法基准

算法基准专注于我们框架的第一维度:测量模型的性能、准确性与效率。尽管硬件系统与训练数据质量确实会影响结果,但算法基准刻意孤立模型能力,以清晰理解准确性、计算复杂度与泛化能力之间的权衡。

AI 算法面临着多重性能目标的复杂平衡挑战,包括准确性、速度、资源效率与泛化能力。随着机器学习应用涵盖计算机视觉、自然语言处理、语音识别与强化学习等多个领域,评估这些相互竞争的目标需要针对每个领域独特挑战的标准化方法。算法基准,如 ImageNet4,建立了这些评估框架,为不同机器学习方法的比较提供了一致的基础。

机器学习算法基准

ML 算法基准 是对机器学习模型在 标准化任务 上的评估,使用 预定义数据集和指标。这些基准测量 准确性、效率和泛化能力,确保不同模型之间的 客观比较。算法基准提供 性能基线,使模型复杂性与计算成本之间的权衡得以系统评估,推动技术进步,识别现有方法的局限性。

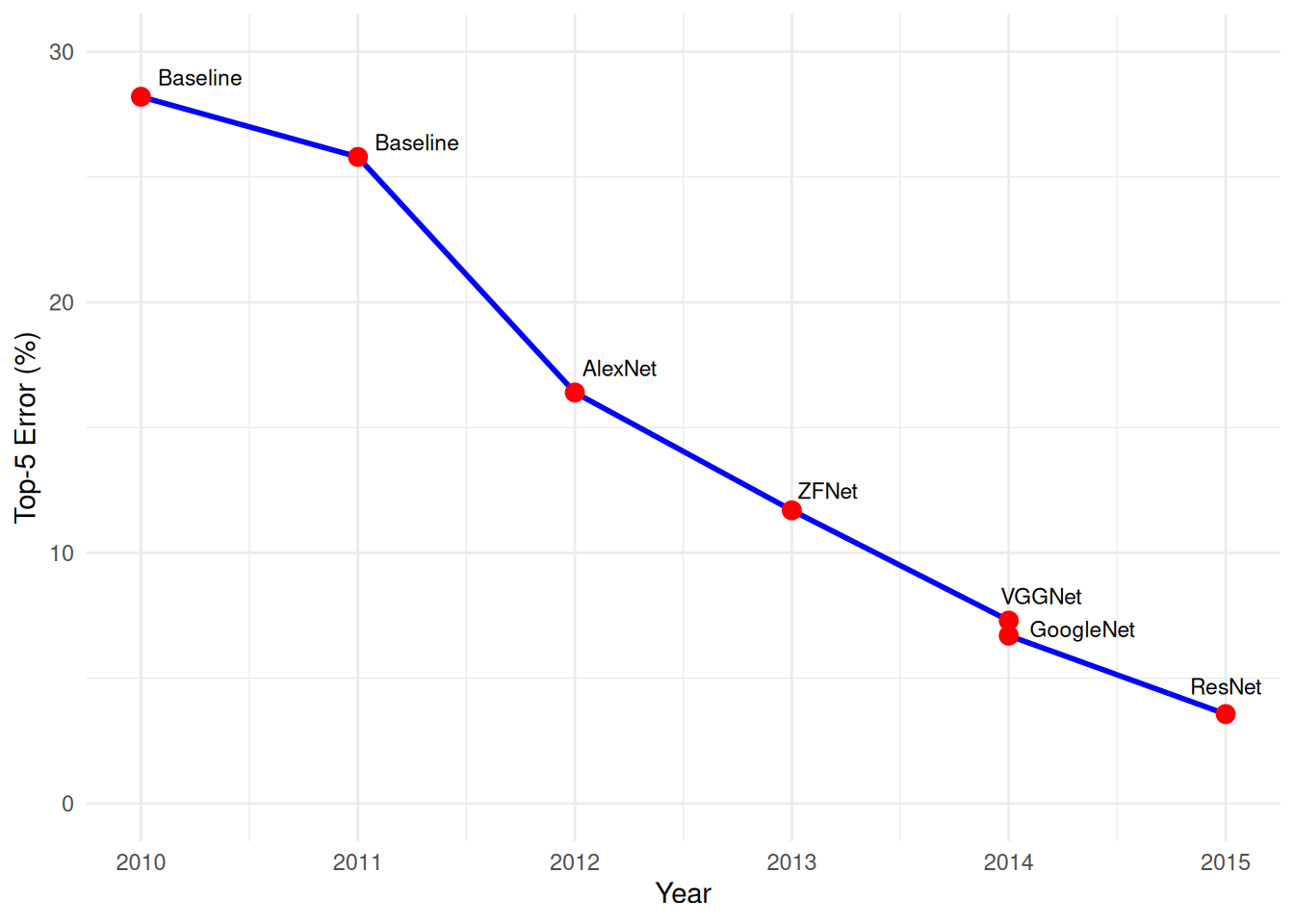

图 1 中的图表展示了在 ImageNet 大规模视觉识别挑战赛 (ILSVRC) 分类任务上,错误率随时间的降低。从 2010 年和 2011 年的基线模型开始,2012 年 AlexNet5 的出现将错误率从 25.8% 降至 16.4%。随后,ZFNet、VGGNet、GoogleNet 和 ResNet6 等模型延续了这一趋势,至 2015 年 ResNet 达到 3.57% 的错误率。这一进展凸显了算法基准如何衡量当前能力并推动 AI 性能提升。

系统基准

转向我们框架的第二维度,关注不同计算系统执行机器学习工作负载的效率。系统基准测量支撑算法能力的计算基础,系统性地检验硬件架构、内存系统与互连如何影响整体性能。理解这些硬件限制与能力,对于优化算法与系统的交互至关重要。

AI 计算对计算资源的需求,远超传统计算负载。底层硬件基础设施,包括通用 CPU、图形处理单元(GPU)、张量处理单元(TPU)7 和专用集成电路(ASIC)8,决定了 AI 解决方案的速度、效率与可扩展性。系统基准建立了评估硬件在 AI 工作负载下性能的标准化方法,测量计算吞吐量、内存带宽、能效与扩展特性等指标。

这些系统基准在 AI 生态系统中发挥着两个关键作用。首先,通过提供跨系统配置的性能比较数据,使开发者与组织能够在选择 AI 应用硬件平台时做出明智决策。评估因素包括训练速度、推理延迟、能效与性价比。其次,硬件制造商依赖这些基准量化代际间的性能提升,指导专用 AI 加速器的开发,推动计算能力的进步。

机器学习系统基准

ML 系统基准 是对用于执行 AI 工作负载的 计算基础设施 的评估,测量在标准化条件下的 性能、能效与可扩展性。这些基准测量 吞吐量、延迟、功耗与资源利用率,确保不同系统配置之间的 客观比较。系统基准提供 性能与能效权衡 的洞察,指导 基础设施选择、能效优化 和 可持续计算架构的进步。

然而,有效的基准解读需要深入理解目标硬件固有的性能特征。关键在于理解特定 AI 工作负载是受限于计算还是内存的性能瓶颈。计算强度(以 FLOPS9 每字节数据计算)决定性能极限。以 NVIDIA A100 GPU 为例,其张量性能为 312 TFLOPS,内存带宽为 1.6 TB/s,计算强度阈值为 195 FLOPS/字节。前文 第 11 章:AI 加速 中建立的硬件特性基础,帮助解读系统基准结果。

以某些 AI 模型操作中的密集矩阵乘法为例,其计算强度通常超过 200 FLOPS/字节,能够接近 A100 的计算吞吐量峰值。例如,ResNet-50 在大批量(256 以上)下的前向传播,计算强度约为 300 FLOPS/字节,达到了峰值张量性能的 85-90%(约 280 TFLOPS 实际达到 vs 312 TFLOPS 理论值)。相反,某些轻量级操作(如激活函数)则可能因计算强度低于 10 FLOPS/字节而受限于内存带宽。例如,批量大小为 1 的 BERT 推理,其计算强度仅为 8 FLOPS/字节,性能限制在 12.8 TFLOPS(1.6 TB/s × 8 FLOPS/字节),仅为峰值计算能力的 4%。

这种定量分析在屋顶线模型10中得到了形式化,为特定工作负载的算法设计与硬件选择提供了系统指导。理解这些定量关系,使工程师能够准确预测性能瓶颈,优化模型架构与部署策略。例如,将变换器推理的批量大小从 1 增加到 32,可以将操作从受限于内存(8 FLOPS/字节)转变为受限于计算(150 FLOPS/字节),GPU 利用率从 4% 提升至 65%。

系统基准在不同规模(从单芯片到大规模分布式系统)与 AI 工作负载(包括训练与推理任务)上评估性能。这一评估方法确保基准准确反映真实部署场景,提供指导硬件选择与系统架构设计的洞察。图 2 展示了 ImageNet 分类错误率与 2010 年至 2014 年 GPU 采用率之间的相关性,说明了硬件能力与算法进步如何共同推动计算机视觉性能提升。

上述 ImageNet 示例,表明硬件进步如何实现算法突破,但有效的系统基准需理解工作负载特征与硬件利用之间的微妙关系。由于计算模式、内存层次结构与系统架构之间的复杂相互作用,现代 AI 系统很少能达到理论峰值性能。理论性能与实际性能之间的差距,影响着有意义的系统基准设计。

理解现实硬件利用模式,对可操作的基准设计至关重要。不同 AI 工作负载与硬件架构的交互方式各异,导致利用率因模型架构、批量大小与精度选择而异。以 ResNet-50 训练为例,批量大小为 64 时 GPU 利用率为 85%,而批量大小为 1 时仅为 15%(You et al. 2019),原因在于并行性不足。内存带宽利用率在参数密集型变换器模型中为 20%,而在以激活为主的卷积网络中可达 90%,直接影响不同精度水平下的可实现性能。

能效考虑为系统基准增加了一个关键维度。不同计算平台的性能/瓦特差异可达三个数量级,使得能效成为生产部署中的关键基准维度。利用率显著影响能效:未充分利用的 GPU 在提供微薄性能的同时消耗大量电力,造成显著的能效损失,影响运营成本与环境影响。

分布式系统性能引入了额外的复杂性,系统基准必须捕捉这些复杂性。传统屋顶线模型可扩展至多 GPU 和多节点场景,但分布式训练引入的通信瓶颈往往主导性能。节点间带宽限制、NUMA 拓扑效应与网络拥塞,造成单节点基准无法揭示的性能变化。

生产环境中的分布式系统面临的挑战,要求基准测试方法针对真实部署场景进行专门设计。多节点训练中的网络分区,影响梯度同步与模型一致性,需评估在部分连接下的容错能力。时钟同步对于跨地理分布节点的准确性能测量至关重要,时间戳漂移可能使基准结果失效。

扩展性效率测量揭示了生产 ML 工作负载中的关键分布式系统瓶颈。大多数模型的线性扩展效率在 64-128 节点后显著下降,通信开销增大:ResNet-50 训练在 32 节点时可达 90% 扩展效率,但在 128 节点时仅为 60%。传统参数服务器架构中,梯度聚合延迟随集群规模的平方增长,而全归约通信模式在高带宽互连下表现更佳。

跨分布式节点的基准完成共识机制,引入了单节点评估所不存在的协调挑战。基准完成的确定需在收敛标准、节点故障处理与状态一致性等方面达成分布式协议,确保所有参与节点的一致状态。在多个管理域或云提供商之间的基准测试中,拜占庭容错变得必要。

网络拓扑效应显著影响生产环境中分布式训练性能。InfiniBand 互连以 200 Gbps 每链路的速度和微秒级延迟,支持通信密集型工作负载的近线性扩展。而基于 Ethernet 的集群,尽管链路速度为 100 Gbps,却因延迟高出 10-100 倍而限制了梯度密集型模型的扩展效率。节点内的 NUMA 拓扑造成的内存带宽争用,影响局部梯度计算与网络通信的顺序。

生产分布式系统中的动态资源分配,要求基准框架考虑资源异构性与时间变化。具有不同内存容量、CPU 速度与网络带宽的云实例,可能造成负载不均,降低整体训练性能。抢占实例的可用性波动,要求容错基准测试,测量节点故障恢复时间与资源扩展响应能力。

这些分布式系统的考虑,突显了理想化单节点基准与生产部署现实之间的差距。因此,有效的分布式 ML 基准必须评估通信模式、容错能力、资源异构性与协调开销,以指导真实世界的系统设计决策。

这些硬件利用率的洞察,直接为基准设计原则提供了依据。有效的系统基准必须在现实的利用场景中评估性能,而非仅关注理论峰值能力。这一方法确保基准结果可转化为实际部署指导,使工程师能够做出明智的硬件选择、系统配置与优化策略决策。

从计算基础设施评估的转变,自然引出全面 ML 系统基准的第三个同样关键的维度:数据质量评估。

数据基准

我们框架的第三维度,系统性地检查数据质量、代表性与偏见对机器学习评估的影响。数据基准评估数据集特性如何影响模型性能,并揭示算法或系统指标无法显现的关键局限性。数据质量约束往往决定了真实世界的部署成功,独立于算法复杂性或硬件能力。

数据质量、规模与多样性直接影响机器学习系统的性能,决定算法学习与泛化新情境的有效性。为应对这一依赖性,数据基准建立了标准化数据集与评估方法,确保不同方法的比较一致性。这些框架评估数据质量的关键方面,包括领域覆盖、潜在偏见,以及对真实世界输入数据变化的稳健性。创建可靠基准所需的数据工程实践详见 第 6 章:数据工程 ,而基准设计中的公平性考虑则与 第 17 章:可信 AI 中更广泛的责任 AI 原则相关联。

机器学习数据基准

ML 数据基准 是对机器学习中 数据集和数据质量 的评估,测量 覆盖范围、偏见和稳健性。这些基准在不同 AI 方法之间确保 客观比较,提供对数据可靠性的洞察,指导 数据集选择、偏见缓解 和 数据驱动 AI 系统的改进。

数据基准在理解 AI 系统在多样数据条件下的行为中发挥着重要作用。通过系统评估,它们帮助识别常见的失败模式,揭示数据覆盖的关键缺口,以及可能显著影响模型行为的潜在偏见。通过提供数据评估的共同框架,这些基准使 AI 社区能够系统性地提高数据质量,并在生产环境中部署系统之前解决潜在问题。这种对数据质量的主动评估,随着 AI 系统在不同领域承担更复杂和重要的任务而变得愈发重要。

社区驱动的标准化

基于我们三维框架,面临的关键挑战是如何在性能、能效和特定领域应用的基准中建立行业标准。早期计算基准主要测量简单指标,如处理器速度和内存带宽,而现代基准则需评估系统性能的复杂方面,从复杂的功耗曲线到高度专业化的应用能力。这一范围和复杂性的演变,要求计算机领域,尤其是机器学习等快速发展的领域,建立全面的验证和共识。

任何基准的持久影响,关键在于其被更广泛研究社区接受的程度。没有广泛的社区参与而开发的基准,往往因缺乏关键指标而难以获得实质性认可。成功的基准通常是在学术机构、行业合作伙伴和领域专家的共同参与下开发的。这种包容性的方法确保基准评估对推动该领域发展的关键能力,同时平衡理论与实践的考虑。

相反,经过广泛合作而开发的基准,因其权威性而推动广泛采用,而那些被视为推动特定企业利益的基准,则面临怀疑和有限的接受度。ImageNet 的成功便是一个典范,通过研讨会和挑战赛的持续社区参与,建立了长期的生命力和影响力。这种社区驱动的发展,为正式标准化奠定了基础,IEEE 和 ISO 等组织将这些基准转化为官方标准。

标准化过程为基准的正式化和采用提供了关键基础设施。 IEEE 工作组 将社区开发的基准方法转化为正式的行业标准,建立测量和报告的精确规范。 IEEE 2416-2019 系统功耗建模标准就是这一过程的典范,规范了通过社区共识发展起来的最佳实践。同样, ISO/IEC 技术委员会 制定国际标准,确保全球研究和工业界的一致评估。这些组织在社区驱动的创新与正式标准化之间架起了桥梁,提供了可靠比较不同机构和地理区域结果的框架。

成功的社区基准建立了明确的治理结构,以管理其演变。通过严格的版本控制系统和详细的变更文档,基准在纳入新进展的同时保持向后兼容性。这一治理结构包括提议、审查和实施变更的正式流程,确保基准在保持稳定性的同时保持相关性。现代基准越来越强调可复现性要求,纳入自动化验证系统和标准化评估环境。

开放获取加速了基准的采用,确保了一致的实施。提供开源参考实现、全面文档、验证套件和容器化评估环境的项目,降低了准入门槛。这一标准化使研究团队能够使用统一的方法和指标评估解决方案。若没有这种协调一致的实施框架,组织可能会对基准的解释不一致,从而损害结果的可复现性和跨研究的有意义比较。

最成功的基准在学术严谨性与行业实用性之间取得了微妙平衡。学术界的参与确保了理论的合理性和全面的评估方法,而行业的参与则使基准扎根于实际约束和应用中。这一平衡在机器学习基准中尤为重要,因为理论进展必须转化为实际部署系统的改进。本章将贯穿这一评估方法原则,指导训练与推理基准的设计。

社区共识确保基准的持久相关性,而碎片化则阻碍科学进步。通过协作开发和透明运作,基准演变为衡量进步的权威标准。最成功的基准在能效和特定领域应用中共享这一社区发展与治理的基础,证明了集体智慧和共同目标在快速发展的领域中产生持久影响的能力。

基准粒度

上述三维框架和测量基础,为基准测试提供了概念结构。然而,实施这些原则需要选择适当的评估细节层次,从单个张量操作到完整的 ML 应用。正如 第 10 章:模型优化 中的优化技术在不同粒度上操作,基准也必须调整其评估范围,以匹配特定的优化目标。这一分层视角使从业者能够在微观层面上隔离性能瓶颈,或在宏观层面上评估系统整体行为。

系统级基准提供了一种结构化、系统化的方法,评估 ML 系统在各个维度的性能。鉴于 ML 系统的复杂性,我们可以通过不同粒度层次剖析其性能,全面了解系统的效率,识别潜在瓶颈,并确定改进领域。为此,各种基准应运而生,并持续发展。

图 3 显示了 ML 系统不同粒度层次。在应用层面,端到端基准评估整体系统性能,考虑数据预处理、模型训练和推理等因素。而在模型层面,基准则专注于评估特定模型的效率和准确性,包括模型对新数据的泛化能力及其在训练和推理过程中的计算效率。基准测试还可以扩展到硬件和软件基础设施,检查 GPU 或 TPU 等单个组件的性能。

微基准

微基准是评估机器学习过程中特定组件或操作的专用工具。这些基准孤立出单个任务,以提供对特定系统元素(从神经网络层到优化技术,再到激活函数)的计算需求的详细洞察。例如,微基准可能测量深度学习模型中卷积层的执行时间,或评估准备训练数据的数据预处理操作的速度。

微基准的一个关键领域是张量操作11,它们是深度学习的计算核心。NVIDIA 的 cuDNN 12 库提供了测量不同硬件配置下卷积和矩阵乘法等基本计算的基准。这些测量帮助开发者理解其硬件如何处理主导 ML 工作负载的核心数学运算。

微基准还单独检查激活函数和神经网络层。这包括在受控条件下测量各种激活函数(如 ReLU、Sigmoid13 和 Tanh14)的性能,以及评估在处理标准化输入时,各种神经网络组件(如 LSTM15 单元或变换器块)的计算效率。

DeepBench 是最早展示全面微基准价值的工具之一。它评估了不同硬件平台上这些基本操作的性能,为开发者优化深度学习实现提供了详细数据。通过孤立和测量单个操作,DeepBench 实现了对硬件平台的精确比较和潜在性能瓶颈的识别。

宏基准

宏基准则评估完整的机器学习模型。这一从组件级到模型级的转变,提供了架构选择与组件交互如何影响整体模型行为的洞察。例如,尽管微基准可能显示单个卷积层的最佳性能,但宏基准则揭示了这些层在完整卷积神经网络中的协同工作方式。

宏基准测量模型级别上才会显现的多维性能指标。这些指标包括预测准确性(模型对新数据的泛化能力)、不同批量大小和序列长度下的内存消耗模式、在不同计算负载下的吞吐量,以及在不同硬件配置下的延迟。理解这些指标有助于开发者做出有关模型架构、优化策略和部署配置的明智决策。

完整模型的评估在标准化条件下进行,使用既定数据集和任务。例如,计算机视觉模型可能在 ImageNet 上进行评估,测量计算效率和预测准确性。自然语言处理模型可能在翻译任务上进行评估,检查它们在不同语言对之间的质量与速度平衡。

多个行业标准基准使得跨平台的一致性模型评估成为可能。 MLPerf Inference 提供了适应不同计算环境的全面测试套件。 MLPerf Mobile 专注于移动设备的限制, MLPerf Tiny 则针对微控制器部署。对于嵌入式系统, EEMBC 的 MLMark 强调性能与能效的结合。 AI-Benchmark 套件专注于移动平台,评估从图像识别到人脸解析等多种任务的模型。

端到端基准

端到端基准提供超越 ML 模型本身的全面评估。这些基准不仅关注机器学习模型的计算效率或准确性,还涵盖整个 AI 系统的全流程。这包括初始的 ETL(提取 - 转换 - 加载)或 ELT(提取 - 加载 - 转换)数据处理、核心模型性能、结果后处理,以及存储和网络系统等关键基础设施组件。

数据处理是所有 AI 系统的基础,将原始数据转化为适合模型训练或推理的格式。在 ETL 管道中,数据经历从源系统提取、通过清洗和特征工程转换,到加载为模型准备格式的全过程。这些预处理步骤的效率、可扩展性和准确性,对整体系统性能有着重要影响。端到端基准必须评估这些管道在标准化数据集上的表现,以确保数据准备不会成为瓶颈。

后处理阶段同样重要。它涉及对模型原始输出的解释,将分数转换为有意义的类别、根据预定义任务过滤结果或与其他系统集成。例如,计算机视觉系统可能需要对检测边界进行后处理,应用置信度阈值,并格式化结果以供下游应用使用。在实际部署中,这一阶段对提供可操作的洞察至关重要。

除了核心 AI 操作,基础设施组件对整体性能和用户体验的影响也很大。存储解决方案,无论是基于云的、本地的还是混合的,都可能显著影响数据检索和存储时间,尤其是在处理大规模 AI 数据集时。网络交互对于分布式系统至关重要,如果未优化,可能成为性能瓶颈。端到端基准必须在规定的环境条件下评估这些组件,以确保对整个系统的可复现测量。

迄今为止,还没有公开的端到端基准能够完全考虑数据存储、网络和计算性能。尽管 MLPerf Training 和 Inference 接近于端到端评估,但它们主要关注模型性能,而非真实世界的部署场景。然而,它们为评估 AI 系统能力提供了有价值的基线指标。

鉴于端到端基准的特定性,组织通常通过对生产部署进行仪表化,内部执行这些评估。这使得工程师能够根据现实工作负载制定结果解释指南,但由于信息的敏感性和特异性,这些基准很少在公开场合出现。

粒度权衡与选择标准

如表 1 所示,AI 系统生命周期的不同阶段会出现不同的挑战。每种基准方法提供独特的洞察:微基准帮助工程师优化 GPU 内核实现或数据加载操作等特定组件,宏基准指导模型架构决策和算法选择,而端到端基准则揭示生产环境中系统级的瓶颈。

| 组件 | 微基准 | 宏基准 | 端到端基准 |

|---|---|---|---|

| 关注点 | 单个操作 | 完整模型 | 整个系统管道 |

| 范围 | 张量操作、层、激活 | 模型架构、训练、推理 | ETL、模型、基础设施 |

| 示例 | cuDNN 上的卷积层性能 | ImageNet 上的 ResNet-50 | 生产推荐系统 |

| 优点 | 精确的瓶颈识别、组件优化 | 模型架构比较、标准化评估 | 现实性能评估、系统范围洞察 |

| 挑战 | 可能忽略交互效应 | 基础设施洞察有限 | 难以标准化、通常是专有的 |

| 典型用途 | 硬件选择、操作优化 | 模型选择、研究比较 | 生产系统评估 |

图 4 展示了基准粒度在诊断能力与现实代表性之间的权衡。这一关系说明了为何全面的 ML 系统评估需要多种基准类型:微基准为孤立组件提供精确的优化指导,而端到端基准则捕捉生产系统中出现的复杂交互。最佳基准策略结合所有三个层次的洞察,以平衡详细的组件分析与现实的系统级评估。

组件交互常常会产生意想不到的行为。例如,尽管微基准可能显示单个卷积层的优秀性能,宏基准可能证明完整模型的强大准确性,但端到端评估可能揭示数据预处理在高负载时段造成的意外瓶颈。这些系统级洞察在组件孤立测试时常被忽视。

确立基准粒度后,理解评估哪个层次符合特定优化目标,接下来我们将审视构成任何粒度层次基准实施的具体组件。

基准组件

基于我们建立的框架,接下来我们将审视构成任何基准实施的实际组件。这些组件为跨越所有三维同时测量性能提供了具体结构。无论是评估模型准确性(算法维度)、测量推理延迟(系统维度),还是评估数据集质量(数据维度),基准都共享共同的结构要素,以确保系统化和可复现的评估。

前面确立的粒度水平,直接影响这些组件的具体实现。测量张量操作的微基准需要合成输入,以孤立特定计算模式,精确表征单个内核的性能,如 第 11 章:AI 加速 中所述。评估完整模型的宏基准,则需要像 ImageNet 这样捕捉真实任务复杂性的代表性数据集,以便在架构之间进行标准化比较。端到端基准则需纳入反映真实世界数据特征的数据集,包括分布变化、噪声和边缘情况,这些在策划的评估集中是缺失的。同样,不同粒度下的评估指标侧重点不同:微基准强调 FLOPS 和内存带宽利用率,宏基准则在准确性和推理速度之间寻求平衡,而端到端基准则优先考虑系统在负载下的可靠性和操作效率。理解这种系统化的变化,确保组件选择与评估目标一致,而非在不同基准粒度上应用统一的方法。

确立基准粒度如何影响评估范围(从孤立张量操作的微基准到完整系统的端到端评估)后,接下来我们将审视这些概念层次如何转化为具体的基准实施。上述抽象讨论的组件,必须通过对任务、数据集、模型和指标的具体选择进行实例化。这一实施过程遵循系统化工作流,确保无论选择何种粒度水平,评估都具有可复现性和意义。

AI 基准提供了这一结构化框架,用于系统评估人工智能系统。尽管单个基准在具体重点和粒度上差异显著,但它们共享共同的实施组件,使得不同方法之间的评估和比较得以持续进行。

图 5 展示了这一结构化工作流,展示了任务定义、数据集选择、模型选择和评估指标等基本组件如何相互关联,形成完整的评估管道。每个组件都建立在前一个组件的基础上,形成从问题规范到部署评估的系统化进程。

有效的基准设计必须考虑前几章建立的优化技术。量化和剪枝会影响模型的准确性 - 效率权衡,基准需同时测量加速和准确性保持。硬件加速技术则影响算术强度和内存带宽利用率,需进行屋顶线模型分析以正确解读结果。理解这些优化基础,确保基准选择能够验证所声称的改进,而非测量人为的场景。

问题定义

如图 5 所示,基准实施始于对机器学习任务及其评估标准的正式定义。在机器学习中,任务代表 AI 系统必须解决的明确定义的问题。以处理音频信号以识别异常的音频异常检测系统为例,图 5 中的工业监控应用展示了如何将正式任务规范转化为实际实施。

任何基准任务的正式定义,包含计算问题及其评估框架。尽管具体任务因领域而异,但主要 AI 研究领域已出现了公认的类别。自然语言处理任务包括机器翻译、问答和文本分类。计算机视觉则采用标准化任务,如目标检测、图像分割和人脸识别。

每个基准任务规范必须定义三个基本要素。输入规范确定系统处理的数据类型。在图 5 中,这包括音频波形数据。输出规范描述系统响应的要求,如正常与异常模式的二元分类。性能规范则建立准确性、处理速度和资源利用率的定量要求。

任务设计直接影响基准有效评估 AI 系统的能力。音频异常检测的示例清晰地说明了这一关系,其具体要求包括:处理连续信号数据、适应不同噪声条件、在严格时间限制内操作。这些实际约束为评估模型性能创建了详细框架,确保评估反映真实世界的操作需求。

基准的实施过程系统地遵循这一基础任务定义。每个后续阶段,从数据集选择到部署,均直接基于这些初始规范构建,确保评估在不同方法和实施之间保持一致,同时满足定义的要求。

标准化数据集

在前一阶段的任务定义基础上,标准化数据集提供了训练和评估模型的基本依据。这些经过精心策划的集合,确保所有模型在相同条件下接受测试,使不同方法和架构之间的直接比较成为可能。图 5 通过音频异常检测示例,展示了波形数据作为评估检测性能的标准化输入。

在计算机视觉领域, ImageNet 、 COCO 和 CIFAR-10 16 等数据集,作为参考标准。自然语言处理则使用 SQuAD 17、 GLUE 18 和 WikiText 等集合,履行类似功能。这些数据集涵盖了各种复杂性和边缘情况,以全面评估机器学习系统。

标准化数据集的战略选择,如图 5 早期工作流所示,塑造了所有后续实施步骤,并最终决定基准的有效性。在音频异常检测的示例中,数据集必须同时包含正常操作的代表性波形样本和各种异常情况的全面示例。相关示例包括 ToyADMOS 用于工业制造异常,Google Speech Commands 用于一般声音识别。无论选择何种具体数据集,数据量必须足够用于模型训练和验证,同时包含反映部署条件的真实世界信号特征和噪声模式。

基准数据集的选择直接影响实验结果和模型评估。有效的数据集必须平衡两个关键要求:准确反映现实世界挑战,同时具有足够的复杂性以有意义地区分模型性能。尽管研究中常使用简化数据集如 ToyADMOS19,但这些受控环境虽然对方法论发展有价值,却可能无法完全捕捉真实世界部署的复杂性。

模型选择

在数据集规范之后,基准过程系统地推进到模型架构的选择与实施。这一关键阶段建立了性能基线,并确定了特定任务的最佳建模方法。选择过程直接基于 第 4 章:DNN 架构 中建立的架构基础,并必须考虑 第 7 章:AI 框架 中讨论的框架特定考虑因素。图 5 通过模型选择阶段和后续训练代码开发,展示了这一进程。

基线模型作为评估新方法的参考点,涵盖从基本实现(如线性回归和逻辑回归)到在相似领域取得成功的高级架构。基线选择关键在于部署框架——PyTorch 实现可能因框架特定的优化和操作实现,与 TensorFlow 实现表现出不同的性能。在自然语言处理应用中,像 BERT20 这样的高级语言模型,已成为比较分析的标准基准。变换器的架构细节及其性能特征在 第 4 章:DNN 架构 中得到了全面介绍。

基线模型的正确选择,需对架构与基准要求进行仔细评估。这一选择过程直接影响训练代码的开发,而训练实现是基准可复现性的基石。训练实施必须详细记录模型管道的各个方面,从数据预处理到训练过程,确保模型行为在研究团队之间的精确复制。

在模型架构选择后,模型开发主要有两个优化路径:训练优化和推理优化。在训练优化过程中,重点是达到目标准确性指标,同时在计算约束内操作。训练实施必须在规定条件下持续达到性能阈值。

与此同时,推理优化路径则解决部署相关问题,特别是从开发到生产环境的关键过渡。例如,通过数值优化技术进行精度降低,从高精度表示逐步过渡到低精度表示,以提高部署效率。这一过程需要仔细校准,以在降低资源需求的同时保持模型准确性。基准必须详细说明量化方法和验证程序,以确认性能保持。

这两条优化路径与现实约束的交集,形成了整体部署策略。全面基准因此必须同时规定训练和推理场景的要求,确保模型在开发到部署的整个过程中保持一致的性能。这一开发与生产指标之间的关键联系,自然引出评估标准的建立。

优化过程必须平衡四个关键目标:模型准确性、计算速度、内存利用率和能效。遵循我们三维基准框架,这一复杂的优化格局,要求 robust 的评估指标,有效量化算法、系统和数据维度的性能。在模型从开发过渡到部署时,这些指标作为指导优化决策和验证性能提升的关键工具。

评估指标

在模型选择确立的优化框架基础上,评估指标提供了评估机器学习模型性能所需的定量标准。这些指标建立了比较不同方法的客观标准,使研究人员和从业者能够评估解决方案的有效性。适当指标的选择是基准设计的关键方面,因为它们必须与任务目标对齐,同时提供对模型在训练和部署场景中行为的有意义的洞察。重要的是,指标计算在不同框架之间可能有所不同—— 第 8 章:AI 训练 中的训练方法论述了不同框架如何处理损失计算和梯度累积,从而影响报告的指标。

特定任务的指标量化模型在其预期功能上的表现。例如,分类任务使用准确率(整体正确预测)、精确率(正类预测准确率)、召回率(正类检测率)和 F1 分数(精确率 - 召回率调和均值)等指标。回归问题则利用均方误差(MSE)和平均绝对误差(MAE)等误差测量,评估预测准确性。特定领域的应用往往需要专业化指标——例如,机器翻译使用 BLEU 分数21 评估机器生成翻译与人工参考翻译之间的语义和句法相似性。

然而,随着模型从研究过渡到生产部署,实施指标同样重要。模型大小(以参数或内存占用衡量)直接影响在不同硬件平台上的部署可行性。处理延迟(通常以每次推理的毫秒数衡量)决定模型是否满足实时要求。能耗(以每次推理的瓦特或焦耳衡量)则指示操作效率。这些实际考虑反映了对平衡准确性与计算效率的解决方案日益增长的需求。生产环境中维护这些指标的挑战,详见部署策略(见 第 13 章:机器学习运维 )。

因此,适当指标的选择需要仔细考虑任务需求和部署约束。单一指标很少能捕捉现实场景中性能的所有相关方面。例如,在异常检测系统中,如果模型产生频繁的误报,即使准确率很高也未必表示良好的性能。同样,快速但准确率低的模型也无法提供实际价值。

图 5 展示了这种多指标评估方法。异常检测系统在多个维度上报告性能:模型大小(270K 参数)、处理速度(10.4 毫秒/推理)和检测准确率(0.86 AUC22)。这些指标的组合确保模型满足现实部署场景中的技术和操作要求。

基准测试工具(Benchmark Harness)

虽然评估指标为测量提供了框架,但基准测试工具(harness)则实现了在受控条件下评估模型性能的系统化基础设施。该关键组件通过管理输入如何传递给被测系统,以及如何收集测量数据,确保测试可复现,将理论指标转化为可量化的实际测量。

工具的设计应与预期部署场景和使用模式相匹配。对于服务器部署,工具会实现模拟真实流量的请求模式,通常采用泊松分布(Poisson distribution)23 生成输入,以模拟随机但统计规律一致的服务器负载。工具还需管理并发请求和不同负载强度,以评估系统在多种运行条件下的表现。

对于嵌入式和移动应用,工具需生成反映实际部署条件的输入模式。例如,移动视觉应用可能需要顺序注入图像,自动驾驶系统则需同步多传感器流。如此精确的输入生成与时序控制,确保系统体验到真实的操作模式,揭示实际设备部署中会出现的性能特征。

工具还需支持不同的吞吐量模型。批处理场景需评估系统在大批量并行输入下的性能,而实时应用则需对顺序处理进行精确时序控制。图 5 在嵌入式实现阶段展示了这一点,工具需支持每次推理的时间和能耗的精确测量。

为保证可复现性,工具需在不同评估轮次中保持一致的测试条件。这包括控制可能影响性能测量的环境因素,如后台进程、热状态和电源状态。工具还需提供收集和记录性能指标的机制,且不能对被测系统产生显著影响。

系统规格(System Specifications)

与控制测试执行的基准工具相辅相成,系统规格是机器学习基准的基础组成部分,直接影响模型性能、训练时间和实验可复现性。这些规格涵盖完整的计算环境,确保基准结果能够被准确地解读、比较和复现。

硬件规格通常包括:

- 处理器类型与主频(如 CPU 型号、时钟频率)

- GPU 或 TPU,包括型号、内存容量,以及分布式训练时的数量

- 内存容量与类型(如 RAM 大小、DDR4)

- 存储类型与容量(如 SSD、HDD)

- 网络配置(如分布式计算相关)

软件规格一般包括:

- 操作系统及版本

- 编程语言及版本

- 机器学习框架与库(如 TensorFlow、PyTorch)及其版本

- 编译器信息与优化参数

- 基准过程中使用的自定义软件或脚本

- 环境管理工具及配置(如 Docker 容器24、虚拟环境)

对这些规格的精确记录对于实验有效性和可复现性至关重要。详细文档使其他研究者能够高保真地复现实验环境,为解读性能指标提供关键背景,并有助于理解不同模型和任务的资源需求与扩展特性。

在许多情况下,基准可能包含多种硬件配置下的结果,以全面展示模型在不同计算环境下的表现。这种方式尤其有价值,因为它突出了模型复杂度、计算资源与性能之间的权衡。

随着领域发展,硬件和软件规格越来越多地纳入能耗指标和计算效率指标,如 FLOPS/瓦和训练总能耗。这反映了对大规模机器学习模型环境影响的关注,并推动更可持续的 AI 实践。详尽的规格文档因此兼具可复现性、公平比较和推动技术与环境进步的多重作用。

运行规则(Run Rules)

除了技术基础设施外,运行规则为基准结果的可靠复现建立了程序性框架,补充了系统规格定义的技术环境。这些准则对于验证研究结论、继承前人工作和推动机器学习进步至关重要。AI 基准可复现性的核心在于对受控随机性的管理,即对权重初始化、数据洗牌等随机过程的系统化处理,确保结果的一致性和可验证性。

超参数的全面记录是可复现性的关键组成部分。超参数是控制模型学习过程的配置项,如学习率、批量大小等,必须详细记录以便复现。即便是微小的超参数调整也可能显著影响模型性能,因此其精确记录至关重要。基准还要求保存和共享训练与评估数据集。若因隐私或许可限制无法直接共享数据,基准需详细说明数据预处理和选择标准,使研究者能够构建可比数据集或理解原始实验数据的特性。

代码溯源与可用性也是可复现性准则的重要方面。现代基准通常要求研究者将实现代码发布到版本控制仓库,涵盖模型实现及数据预处理、训练、评估的完整脚本。高级基准还常提供容器化环境,封装所有依赖与配置。实验日志需详尽,包括系统记录训练指标、模型检查点及所有实验调整的文档。

这些可复现性准则具有多重重要作用:提升透明度、支持严格的同行评审、加速 AI 研究的科学进步。遵循这些协议,研究社区能够有效验证结果、迭代成功方法并识别方法学局限。在快速演进的机器学习领域,这些健全的可复现性实践构成了可靠、持续进步的基础。

结果解读(Result Interpretation)

在运行规则的基础上,结果解读准则为理解和分析基准结果提供了必要框架。这些准则帮助研究者和从业者从基准结果中得出有意义的结论,确保不同模型或方法之间的比较公平且具参考价值。理解性能差异的统计显著性是关键。基准通常规定统计检验和置信区间的报告协议,使从业者能够区分有意义的改进与随机因素导致的波动。

然而,结果解读需结合实际应用和场景。1% 的准确率提升对于医疗诊断或金融系统可能至关重要,而其他应用可能更看重推理速度或模型效率。理解这些场景特定需求对于有意义地解读基准结果至关重要。用户还需认识到基准的固有限制,因为没有任何评估框架能涵盖所有用例。常见限制包括数据集偏见、任务特性和评估指标的约束。

现代基准常常需要对多维性能指标进行综合分析。例如,某模型准确率更高但计算资源消耗大,解读准则可帮助从业者根据自身约束权衡利弊。准则还关注基准过拟合问题,即模型可能过度针对特定基准任务优化,牺牲了真实场景下的泛化能力。为降低风险,准则通常建议在相关但不同的任务上评估模型性能,并考虑实际部署场景。

这些全面的解读框架确保基准实现其本意:提供标准化性能测量,同时支持对模型能力的细致理解。这种平衡方法有助于在研究和实际应用中做出基于证据的决策。

基准示例(Example Benchmark)

为说明这些组件如何协同工作,一个完整的基准测试通过在受控条件下整合多个组件,评估系统性能并产生可复现的测量。图 5 通过音频异常检测系统展示了这种集成,说明了如何在涵盖问题定义、数据集、模型选择、评估标准和标准化运行规则的框架下,系统测量和报告性能指标。

该基准测量了多个关键性能维度。计算资源方面,系统报告模型大小为 27 万参数,每次推理需 10.4 毫秒。任务效果方面,异常检测准确率为 0.86 AUC(曲线下面积)。操作效率方面,每次推理能耗为 516 微焦耳。

这些指标的重要性因部署场景而异。对于电池供电设备,每次推理能耗至关重要,而对持续供电系统则影响较小。模型大小约束在云端资源充足与嵌入式设备内存有限之间差异显著。处理速度要求取决于系统是否需实时运行或可批量处理。

基准揭示了机器学习系统中性能指标间的固有权衡。例如,将模型大小从 27 万参数减少,可能提升处理速度和能效,但会降低 0.86 AUC 的检测准确率。图 5 展示了这些互相关联的指标如何共同影响部署阶段的系统整体性能。

最终,这些测量是否构成“合格”基准,取决于目标应用的具体需求。基准框架提供了一致评估的结构和方法,而验收标准则需与部署约束和性能要求相匹配。

压缩基准(Compression Benchmarks)

随着机器学习模型规模和复杂度不断增长,神经网络压缩已成为资源受限环境部署的关键优化技术。压缩基准方法评估剪枝、量化、知识蒸馏和架构优化等技术的有效性,专门测量模型体积缩减、准确率保持和计算效率提升之间的核心权衡。

模型压缩基准同时评估多个维度。首要维度是体积缩减指标,包括参数数量、内存占用和存储需求(压缩文件大小)。高效压缩在保持准确率的同时实现显著缩减:MobileNetV2 以 340 万参数实现约 72% 的 ImageNet top-1 准确率,而 ResNet-50 需 2560 万参数实现 76%,参数 - 准确率效率提升 7.5 倍。

除基础体积指标外,稀疏性评估框架区分结构化与非结构化剪枝效率。结构化剪枝移除整个神经元或滤波器,速度提升稳定但压缩比通常较低(2-4 倍);非结构化剪枝移除单个权重,压缩比可达 10-100 倍,但需专用稀疏计算支持才能实现加速。基准协议需明确硬件平台和软件实现,以确保稀疏加速测量有意义。

配合稀疏技术,量化基准协议评估多种数据类型的精度降低技术。INT8 量化通常带来 4 倍内存缩减和 2-4 倍推理加速,同时保持 99% 以上的准确率。混合精度方法通过对不同层采用不同精度实现最优效率:关键层保留 FP16 精度,计算密集层采用 INT8 或 INT4,实现细粒度效率优化。

另一个关键维度是知识迁移有效性指标,衡量不同模型体积间的性能关系。成功的知识迁移可在模型体积缩减 5-10 倍的同时,保持 90-95% 的大模型准确率。紧凑模型可通过此方法实现高性能、低参数量和更快推理,展示在不显著损失能力的前提下实现高效的潜力。

最后,优化模型的加速因子测量揭示了不同硬件平台下的实际收益。稀疏模型在 CPU 上可实现 2-5 倍加速,低精度模型在移动处理器上可达 2-8 倍,效率架构在专用边缘加速器上可达 5-20 倍。这些硬件特定测量确保效率基准反映真实部署场景。

面向效率的基准弥补了传统评估框架的关键空白。当前如 MLPerf 等基准主要关注稠密、未优化模型,而实际生产部署中优化模型已成常态。未来基准框架应专设效率模型分组,专门评估优化架构、低精度推理和紧凑模型,以准确反映真实部署实践,引导效率研究产生实际影响。

移动与边缘基准(Mobile and Edge Benchmarks)

移动 SoC 集成了异构处理器(CPU、GPU、DSP、NPU),需专门基准捕捉工作负载分布的复杂性,并考虑热约束和电池限制。高效的处理器协同可实现 3-5 倍性能提升,但持续负载会触发热降频。例如,骁龙 8 Gen 3 峰值 35 TOPS,持续负载降至 20 TOPS。电池影响差异巨大:计算摄影消耗 2-5W,后台 AI 仅需 5-50mW 即可保证续航。

移动基准还需评估 5G/WiFi 边缘 - 云协同,URLLC25 场景要求关键应用延迟低于 1ms。汽车部署需增加 ASIL 验证、多传感器融合和 -40°C 至 +85°C 环境测试。这些独特需求要求基准框架全面评估热约束下的持续性能、不同使用模式下的电池效率和依赖连接的行为,远超孤立峰值测量。

训练与推理评估(Training vs. Inference Evaluation)

基准组件和粒度层次在 ML 系统的两个主要运行阶段——训练与推理——中的应用各不相同。两者虽都通过神经网络处理数据,但目标不同,导致基准需求也不同。 第 8 章:AI 训练 关注大数据集上的迭代优化,而 第 13 章:机器学习运维 则强调持续、低延迟服务。这些差异影响指标选择、资源分配和扩展行为。

训练涉及双向计算(前向与反向),而推理仅执行固定参数的前向计算。ResNet-50 训练需 8GB GPU 内存(用于梯度和优化器状态),而仅推理时仅需 0.5GB。GPT-3 训练用 1024 块 A100 GPU 持续数月,推理则需单模型支持数千并发请求,响应时间需达毫秒级。

训练优先考虑吞吐量和收敛速度,以单位时间处理样本数和训练完成时间衡量。BERT-Large 训练在批量 512 时表现最佳,收敛需 32 小时;BERT 推理则需将延迟优化至每次查询低于 10ms,批量 1-4。训练可牺牲延迟换取吞吐(如每秒处理 1 万样本),推理则牺牲吞吐以保证延迟一致性。

训练可利用大规模计算资源进行批处理,接受更长完成时间以提升资源效率。多节点训练在批量 4096-32768 时可达 90% 计算利用率。推理需对单次请求做出快速响应,批量受限于 1-16,导致 GPU 利用率仅 15-40%,但能满足严格延迟要求。

训练需同时访问参数、梯度、优化器状态和激活,内存开销为推理的 3-4 倍。混合精度训练(FP16/FP32)可将内存占用减半且保持收敛,推理则可用 INT8 量化实现 4 倍内存缩减且准确率损失极小。

训练期间采用梯度压缩、混合精度和渐进剪枝,可实现 1.8 倍加速且准确率仅损失 0.1%。推理优化则用后训练量化(4 倍加速)、知识蒸馏(模型体积缩减 5-10 倍)、神经架构搜索,实现 4 倍推理加速且准确率仅下降 0.5%。

训练能耗分摊到模型生命周期内,按每个模型总能耗计。GPT-3 训练耗电约 1287 兆瓦时。推理能耗则按每次查询累积,直接影响运营效率:变换器推理每次消耗 0.01-0.1 瓦时,亿级查询服务下能效优化至关重要。

这一对比框架指导基准设计,突出各阶段最重要的指标,以及评估方法如何针对阶段特性调整。训练基准强调收敛时间和扩展效率,推理基准则关注延迟一致性和多场景下的资源效率。

训练基准(Training Benchmarks)

基于三维基准框架,训练基准专注于评估模型训练过程中的效率、可扩展性和资源需求。它们使从业者能够评估模型架构、数据加载机制、硬件配置和分布式训练策略等设计选择,如何影响系统维度下的性能。随着机器学习系统规模不断扩大,参数量达数十亿、数据量达数 TB、分布式计算环境成为常态,训练基准尤为重要。

例如,大规模模型如 OpenAI 的 GPT-3 26,拥有 1750 亿参数,训练数据达 45TB,凸显了现代训练的巨大计算需求。训练基准为底层系统提供系统性评估,确保软硬件配置能高效应对前所未有的需求。

ML 训练基准

ML 训练基准 专注于 训练阶段,测量模型开发过程中的 收敛时间、扩展效率 和 资源利用率。这些基准评估 收敛特性、分布式训练性能 和 不同软硬件配置下的计算成本。训练基准有助于识别 数据加载、梯度计算 和 参数同步 的瓶颈,确保训练基础设施能高效应对大规模模型开发需求。

除了计算需求外,训练过程中的高效数据存储与传输同样关键。例如,目标检测模型需处理数千张图片,但通常无法将整个数据集加载到内存,因此依赖 ML 框架的数据加载器。成功训练依赖于数据的及时高效传递,因此需对数据管道、预处理速度和存储读取时间等工具进行基准测试,理解其对训练性能的影响。

除数据管道效率外,硬件选择也是训练系统的关键因素,直接影响训练时间。训练基准评估训练阶段 CPU、GPU、内存和网络的利用率,指导系统优化。理解资源使用情况至关重要:GPU 是否被充分利用?是否存在不必要的内存开销?基准可揭示资源利用中的瓶颈或低效,带来成本节约和性能提升。

在许多情况下,单一硬件加速器(如单块 GPU)难以满足大规模模型训练的计算需求。ML 模型常在多 GPU 或 TPU 的数据中心训练,分布式计算实现节点间并行。训练基准评估系统在多节点下的扩展效率、数据分片管理和节点故障处理能力。

为说明这些基准原则,本节将持续引用 MLPerf Training 。MLPerf 在 第 12 章:AI 基准测试 中已介绍,是本节分析训练基准的标准化框架。

训练基准的意义

从系统角度看,训练机器学习模型是计算密集型过程,需要精细优化资源。训练基准是评估系统效率、识别瓶颈和确保 ML 系统可扩展的关键工具。它们为测量硬件加速器、内存、存储和网络等系统组件对训练性能的影响,提供了标准化方法。

因此,训练基准使研究者和工程师能够推动技术前沿、优化配置、提升扩展性并系统性地降低资源消耗。如图 6 所示,MLPerf Training 基准的历代性能提升持续超越摩尔定律,证明了“可测量即可改进”。利用标准化基准趋势,我们能严谨展示 ML 计算的快速演进。

训练基准的重要性

随着 ML 模型复杂度提升,训练对算力、内存和数据存储的需求日益增长。衡量和比较训练效率的能力,对系统能否高效应对大规模负载至关重要。训练基准为跨硬件平台、软件框架和优化技术的性能评估,提供了结构化方法论。

训练 ML 模型的主要挑战之一,是计算资源的高效分配。训练如 GPT-3 这样的大规模语言模型,参数量达 1750 亿,需处理 TB 级数据,对现代计算基础设施造成巨大压力。没有标准化基准,难以判断系统是否充分利用资源,或是否因数据加载慢、加速器利用不足、内存开销过大等低效因素而受限。

训练基准通过测量系统吞吐量、收敛时间和硬件利用率等关键指标,帮助发现这些低效。回顾 第 11 章:AI 加速 ,GPU 混合精度操作可达 15700 GFLOPS,TPU 专用张量操作每秒 27.5 万次。训练基准可测量这些理论能力在实际训练中的加速效果。它们帮助从业者分析加速器是否被有效利用,或是否因硬件限制(如内存带宽瓶颈)而降低整体性能。例如,TF32 精度系统可能吞吐量更高,但若引入数值不稳定导致收敛迭代次数增加,整体训练时间反而更长。基准通过揭示这些因素,支持更高效训练流程的设计,最大化硬件潜力并最小化不必要计算。

硬件与软件优化

机器学习训练的性能高度依赖于硬件与软件选择。训练基准通过测量不同架构(如 GPU、TPU 及新兴 AI 加速器)处理计算负载的能力,指导系统设计者选择最优配置。基准还评估深度学习框架(如 TensorFlow、PyTorch)在不同硬件下的优化效果。

例如,MLPerf Training 基准套件广泛用于比较不同加速器架构在图像分类、自然语言处理和推荐系统等任务上的表现。通过在多种硬件配置下运行标准化基准,工程师可判断某些加速器是否更适合特定训练负载。这对大规模数据中心和云计算环境尤为有价值,选择合适的软硬件组合可带来显著性能提升和成本节约。

除了硬件选择,训练基准还指导软件优化。机器学习框架实现了多种底层优化,包括混合精度训练27、高效数据加载和分布式训练策略,这些都能显著影响系统性能。基准有助于量化这些优化的影响,确保训练系统配置达到最大效率。

可扩展性与效率

随着机器学习工作负载的不断增长,分布式计算环境下的高效扩展已成为关键问题。许多现代深度学习模型需要在多块 GPU 或 TPU 上训练,只有高效的并行化策略才能确保增加计算资源带来实际的性能提升。训练基准通过评估系统吞吐量、内存效率和整体训练时间,来衡量系统在增加计算资源时的扩展能力。

高效扩展并非理所当然。理论上,增加 GPU 或 TPU 数量应当缩短训练时间,但通信开销、数据同步延迟和内存瓶颈等问题常常限制了扩展效率。训练基准通过量化性能随硬件资源增加的变化,帮助发现这些挑战。理想情况下,系统应展现近线性扩展,即 GPU 数量翻倍,训练时间近乎减半。但现实中的各种低效因素往往阻碍了完美扩展,基准测试为系统设计优化提供了必要的洞察。

训练效率的另一个关键因素是“收敛时间”(time-to-accuracy),即模型达到目标准确率所需的时间。该指标连接了算法和系统两个维度,将模型收敛特性与计算效率结合起来。借助训练基准,系统设计者可以评估基础设施是否能够高效处理大规模负载,同时保证训练的稳定性和准确性。

成本与能耗因素

近年来,大规模模型训练的计算成本急剧上升,使得成本效率成为不可忽视的考量。训练如 GPT-3 这样的模型,可能需要数百万美元的云计算资源,因此必须在不同软硬件配置下评估训练的性价比。训练基准通过分析计算开销、云计费模型和能耗,量化每次训练的成本。

除了财务成本,能效也日益重要。大规模训练消耗大量电力,带来显著的碳排放。基准测试通过测量每单位训练进展的能耗,帮助组织识别更可持续的 AI 发展路径。

例如,MLPerf 包含能耗基准组件,跟踪训练期间各类硬件加速器的功耗。这样,研究者不仅可以比较不同计算平台的性能,还能评估其环境影响。将能效指标纳入基准研究,有助于组织设计兼顾算力与可持续发展的 AI 系统。

公平的 ML 系统比较

训练基准的核心作用之一,是为 ML 系统建立标准化的比较框架。当前硬件架构、深度学习框架和优化技术多种多样,确保公平、可复现的比较至关重要。

标准化基准提供统一的评估方法,使研究者和工程师能够在相同条件下比较不同训练系统的表现。MLPerf Training 基准通过为图像分类、语言建模、推荐系统等任务定义严格的评测标准,实现了厂商中立的对比。这确保了性能结果的科学性,不会因数据预处理、超参数调整或实现细节的差异而失真。

这种标准化方法解决了机器学习研究中的可复现性问题,提供了明确的评估流程。结果可以在不同计算环境下稳定复现,帮助研究者在选择硬件、软件和训练方法时做出明智决策,推动 AI 系统开发的系统性进步。

训练指标

评估机器学习训练性能,需要一套超越传统算法指标的科学度量。从系统角度看,训练基准关注模型在达到预定准确率门槛时的效率与效果。吞吐量、可扩展性和能效等指标,只有在模型成功收敛的前提下才有意义。否则,单纯优化速度或资源利用,反而可能导致误导性结论。

如 MLPerf Training 等训练基准,为不同任务设定了具体的准确率目标,确保性能测量公平且可复现。训练速度快但达不到准确率要求的系统,不被视为有效基准结果;反之,准确率高但耗时或资源过多的系统,也难以实际应用。有效的基准测试需在速度、效率与收敛准确率之间取得平衡。

时间与吞吐量

衡量训练效率的首要指标之一,是达到预定准确率门槛所需的时间。训练时间 $T_{\text{train}}$ 表示模型收敛到可接受性能水平所用的总时长,反映了系统的整体计算效率。其形式化定义为: $$ T_{\text{train}} = \arg\min_{t} \big{ \text{accuracy}(t) \geq \text{target accuracy} \big} $$

该指标确保基准关注系统达成有意义结果的速度与效果。

吞吐量则常以每秒处理的训练样本数衡量,公式为: $$ \text{Throughput} = \frac{N_{\text{samples}}}{T_{\text{train}}} $$ 其中 $N_{\text{samples}}$ 为训练期间处理的总样本数。但吞吐量本身并不能保证结果有意义——模型可能处理样本很快,却无法达到目标准确率。

例如,MLPerf Training 中,ResNet-50 的基准要求在 ImageNet 上达到 75.9% top-1 准确率。某系统即使每秒处理 1 万张图片,但未达标也不算有效;而另一个系统即使吞吐量较低,只要高效收敛则更优。这说明吞吐量必须结合收敛时间一起评估,而不能单独作为性能指标。

可扩展性与并行性

随着模型规模增长,训练工作负载往往需要在多处理器或加速器上分布式计算。可扩展性衡量在增加计算资源时,训练性能提升的效果。理想系统应展现近线性扩展,即 GPU 或 TPU 数量翻倍,训练时间也近乎减半。但现实中,通信开销、内存带宽和并行策略低效等因素常常限制了扩展性。

如 GPT-3 训练,OpenAI 使用约 1 万块 NVIDIA V100 GPU 进行分布式训练。谷歌的 4096 节点 TPU v4 集群也面临类似挑战,节点间的网络通信开销成为扩展瓶颈。MLPerf 等基准量化了多 GPU 扩展效率,帮助定位分布式训练中的低效环节。

训练并行分为数据并行28、模型并行29和流水线并行,每种方式都有独特挑战。数据并行最常见,将训练数据分片分配到不同计算节点,效率取决于同步机制和梯度通信开销。模型并行则将神经网络结构本身分布到不同处理器,需要高效协调。基准测试评估系统在采用这些并行策略时,是否能保证准确率收敛不受影响。

资源利用率

训练效率不仅取决于速度和扩展性,还取决于硬件资源的利用率。计算利用率衡量 GPU、TPU 等处理单元在训练期间的活跃程度。利用率低可能表明数据传输、内存访问或调度存在瓶颈。

例如,BERT 在 TPU 集群训练时,研究者发现输入管道低效限制了整体吞吐。尽管 TPU 算力强大,但数据从存储读取过慢,导致利用率不高。通过资源利用率分析,工程师优化了输入管道(如 TFRecord、数据预取),显著提升了性能。

内存带宽同样关键,深度学习模型训练需频繁访问大量数据。若内存带宽成为瓶颈,单纯提升算力也无法加快训练。基准测试需评估模型对内存的利用效率,确保存储、主存与处理单元间的数据传输不会成为性能瓶颈。

I/O 性能在处理大数据集时也极为重要,尤其是数据无法全部加载到内存时。基准测试需评估数据加载管道的效率,包括预处理、缓存和存储读取速度。数据加载低效会极大拖慢训练进度,无论算力多强都无济于事。

能效与成本

大规模模型训练需大量计算资源,带来显著能耗和财务成本。能效指标量化训练工作负载的功耗,帮助识别既高效又节能的系统。可持续发展趋势推动了能耗基准的普及,如 MLPerf Training 就测量每次训练的能耗。

GPT-3 训练估算消耗 1287 兆瓦时电力,相当于 100 户美国家庭一年的用电量。如果某系统能以更少迭代达到同样准确率,就能直接降低能耗。能效基准有助于推动硬件和训练策略的节能优化,同时保持准确率目标。

成本考量不仅包括电费,还包括硬件采购、云计算和基础设施维护。训练基准通过测量训练时间与资源消耗的关系,帮助评估不同软硬件配置的性价比。组织可据此在性能与预算之间做出平衡。

容错与稳健性

训练任务常常持续数天甚至数周,容错能力至关重要。健壮的系统必须能应对硬件故障、网络中断、内存错误等意外情况,且不影响准确率收敛。

在大规模云训练中,节点故障很常见。若分布式集群中某 GPU 节点失效,训练需能不中断地继续,且模型不被破坏。MLPerf Training 评估了如检查点(checkpoint)等容错策略,确保故障发生时无需重头开始。

可复现性与标准化

基准结果只有在不同运行、硬件和软件环境下可复现,才有意义。训练结果的波动可能由随机过程、硬件差异和软件优化引起。确保可复现性需标准化评估流程,控制模型初始化的随机性,并保证数据集处理一致。

MLPerf Training 对可复现性有严格要求,确保准确率在多次训练中保持稳定。例如,NVIDIA 提交 MLPerf 基准时,需证明其 ResNet-50 ImageNet 训练时间在不同 GPU 上一致。这样才能确保基准测量的是系统真实性能,而非随机噪声。

训练性能评估

评估机器学习训练系统的性能,远不止测量模型训练速度。全面的基准方法需从多个维度考察系统行为。具体指标取决于评估目标,无论是优化速度、提升资源效率、降低能耗,还是保证稳健性与可复现性。

下表(表 2)概述了系统级训练性能常用的核心类别与指标,为理解不同负载和配置下的训练系统行为提供了框架。

| 类别 | 关键指标 | 基准应用示例 |

|---|---|---|

| 训练时间与吞吐量 | 收敛时间(秒/分钟/小时);吞吐量(样本/秒) | 比较不同 GPU 架构的训练速度 |

| 可扩展性与并行性 | 扩展效率(理想加速比的百分比);通信开销(延迟、带宽) | 分析大模型的分布式训练性能 |

| 资源利用率 | 计算利用率(GPU/TPU 使用率%);内存带宽(GB/s);I/O 效率(数据加载速度) | 优化数据管道提升 GPU 利用率 |

| 能效与成本 | 每次训练能耗(MWh、kWh);每瓦性能(TOPS/W) | 评估节能训练策略 |

| 容错与稳健性 | 检查点开销(每次保存耗时);恢复成功率(%) | 评估云训练系统的故障恢复能力 |

| 可复现性与标准化 | 多次运行方差(准确率/训练时间差异%);框架一致性(TensorFlow vs. PyTorch vs. JAX) | 确保跨硬件基准结果一致 |

训练时间与吞吐量通常是评估系统性能的首要指标。收敛时间(time-to-accuracy)是模型达到指定准确率所需的时长,是实用且广泛采用的基准。吞吐量(如每秒样本数)反映了训练期间数据处理的效率。例如,比较 ResNet-50 在 NVIDIA A100 与 V100 GPU 上的训练,A100 通常吞吐量更高、收敛更快。但需确保吞吐提升不以收敛质量为代价,尤其在采用 TF32 等低精度加速时。

随着模型规模增长,可扩展性成为关键性能维度。高效利用多 GPU 或 TPU 对于训练 GPT-3、T5 等大模型至关重要。此时,扩展效率与通信开销是核心指标。系统在 64 块 GPU 内可线性扩展,但超过该规模后,同步与通信成本会导致性能提升趋缓。监控互连带宽和梯度聚合延迟的基准工具,可揭示分布式训练的瓶颈。

资源利用率补充了上述指标,关注系统对计算与内存资源的利用效率。GPU 利用率、内存带宽和数据加载效率等指标,有助于定位性能瓶颈。例如,BERT 预训练任务若 GPU 利用率不高,可能是数据管道性能不足。通过输入文件分片、数据预取等优化,常可解决这些低效。

除了性能,能效与成本也日益重要。大规模训练消耗大量电力,带来环境与财务压力。每次训练能耗、每瓦性能(如 TOPS/W)等指标,有助于评估不同硬件和系统配置的可持续性。例如,两个系统在相同时间内达到同样准确率,能耗更低者更适合长期部署。

容错与稳健性关注系统在非理想条件下的表现,这在实际部署中极为常见。训练任务常遇到硬件故障、抢占或网络不稳定。检查点开销和恢复成功率等指标,反映了训练系统的弹性。实际中,定期保存检查点会带来 5-10% 的吞吐损失,系统需在容错与性能间权衡。

最后,可复现性与标准化确保基准结果的一致性、可解释性和可迁移性。即使是软件库、初始化种子或浮点行为的微小差异,也会影响训练结果。比较 PyTorch(自动混合精度)与 TensorFlow(XLA)的同一模型,可能收敛速度或最终准确率不同。可靠的基准需严格控制这些变量,并多次运行以评估统计方差。

这些维度共同构成了训练性能的全景视角,帮助研究者、工程师和系统设计者超越简单对比,深入理解 ML 系统在真实条件下的行为。正如前文统计严谨性框架所述,准确测量这些维度需系统化方法,区分真实性能差异与统计噪声,考虑如 GPU Boost 时钟30 和热降频31 等对测量影响巨大的因素。

训练基准常见误区

尽管有完善的基准方法,实际评估中仍常见一些误区和错误做法,导致结论失真。理解这些陷阱有助于正确解读基准结果。

过度关注吞吐量

常见误区是认为吞吐量越高训练性能越好。实际上,可以通过降低数值精度、减少同步甚至跳过部分计算来人为提升吞吐,但这些优化未必能加快收敛。

例如,TF32 精度系统吞吐量高于 FP32,但若数值不稳定导致收敛迭代次数增加,整体训练时间反而更长。正确做法是将吞吐量与收敛时间结合评估,确保速度优化不以收敛效率为代价。

只看单节点性能

只在单节点上评测训练性能,忽略分布式扩展,容易得出误导性结论。单卡 GPU 吞吐量虽高,但在 Google 4096 节点 TPU v4 等大集群中,通信与同步开销会大幅削弱效率。

例如,单节点优化的内存策略未必适用于多节点环境。GPT-3 等大模型需高效的梯度同步,全面评估扩展性至关重要。Google 的 4096 节点 TPU 集群经验表明,梯度同步在大规模下成为主导瓶颈。

忽略故障与干扰

许多基准假设理想训练环境,不考虑硬件故障、内存损坏、网络不稳定或其他进程干扰。但实际训练常遇到意外故障和干扰,需要检查点、恢复机制和资源管理。

只优化理想场景但缺乏容错和干扰处理的系统,在受控条件下表现优异,但频繁故障、恢复低效和资源争用会使其难以大规模部署。有效基准应考虑检查点开销、故障恢复效率和进程干扰影响,而非假设完美执行。

线性扩展假设

分布式训练常被假定为增加 GPU/TPU 数量即可线性加速。实际上,通信瓶颈、内存争用和同步开销会导致边际收益递减。

例如,1000 块 GPU 并不一定比 10 块快 100 倍。到一定规模,梯度通信成本成为限制因素,抵消了并行带来的好处。正确的基准应评估扩展效率,而非假设理想线性提升。

忽略可复现性

许多基准结果未验证在不同硬件和软件环境下的可复现性。即使是浮点运算、内存布局或优化策略的微小差异,也会引入训练时间和准确率的统计差异。

例如,TensorFlow(XLA 优化)与 PyTorch(自动混合精度)同一模型的收敛特性可能不同。科学基准需跨多框架评估,确保软件特定优化不会扭曲性能对比。

训练基准总结

训练基准为 ML 系统性能提供了宝贵洞察,但解读时需充分考虑现实约束。高吞吐量若以收敛效率为代价,并不等于更快训练。扩展效率也需综合考察计算与通信开销。

避免常见误区,采用结构化评估方法,能帮助 ML 从业者深入理解如何优化训练流程、设计高效 AI 系统、构建可扩展的 ML 基础设施。随着模型复杂度提升,基准方法也需不断演进,反映现实挑战,确保基准在指导 AI 系统开发时始终具有实际意义和可操作性。

推理基准

作为训练基准的补充,推理基准聚焦于模型部署和服务阶段的效率、延迟与资源需求评估。与训练阶段侧重于大规模数据集上的计算优化不同,推理阶段要求高效地进行实时或批量预测。推理基准帮助评估模型架构、硬件配置、精度优化和运行时优化等因素对推理性能的影响。

随着深度学习模型复杂度和规模的指数级增长,高效推理成为越来越重要的挑战,尤其是在自动驾驶、医疗诊断、对话式 AI 等对实时性要求极高的场景。例如,大语言模型的推理需在保证低延迟的同时处理数十亿参数。推理基准为底层软硬件栈提供系统性评估,确保模型能在云、边缘等多种环境下高效部署。

ML 推理基准

ML 推理基准 是用于评估机器学习系统 推理阶段 的 性能、效率 和 可扩展性 的标准化工具。这些基准测量 系统级指标,如 延迟、吞吐量、能耗 和 内存占用。通过结构化评估框架,推理基准实现了跨 硬件平台、软件运行时 和 部署配置 的公平对比,帮助识别瓶颈,优化推理流程,确保计算资源高效利用,适用于实时和大规模 ML 应用。

与通常在数据中心进行的训练不同,推理需适应多样化的部署场景,包括移动设备、IoT 系统和嵌入式处理器。高效推理依赖于数据管道、模型优化和硬件加速等多因素协同。基准测试帮助评估这些优化措施对实际部署性能的提升效果。

在这些优化需求基础上,硬件选择对推理效率的影响日益突出。训练阶段常用 GPU、TPU,而推理负载则常需专用加速器,如 NPU(神经网络处理器)32、FPGA33 和 Google Edge TPU34 等。推理基准评估这些硬件的利用率和性能,帮助从业者为不同部署需求选择合适配置。

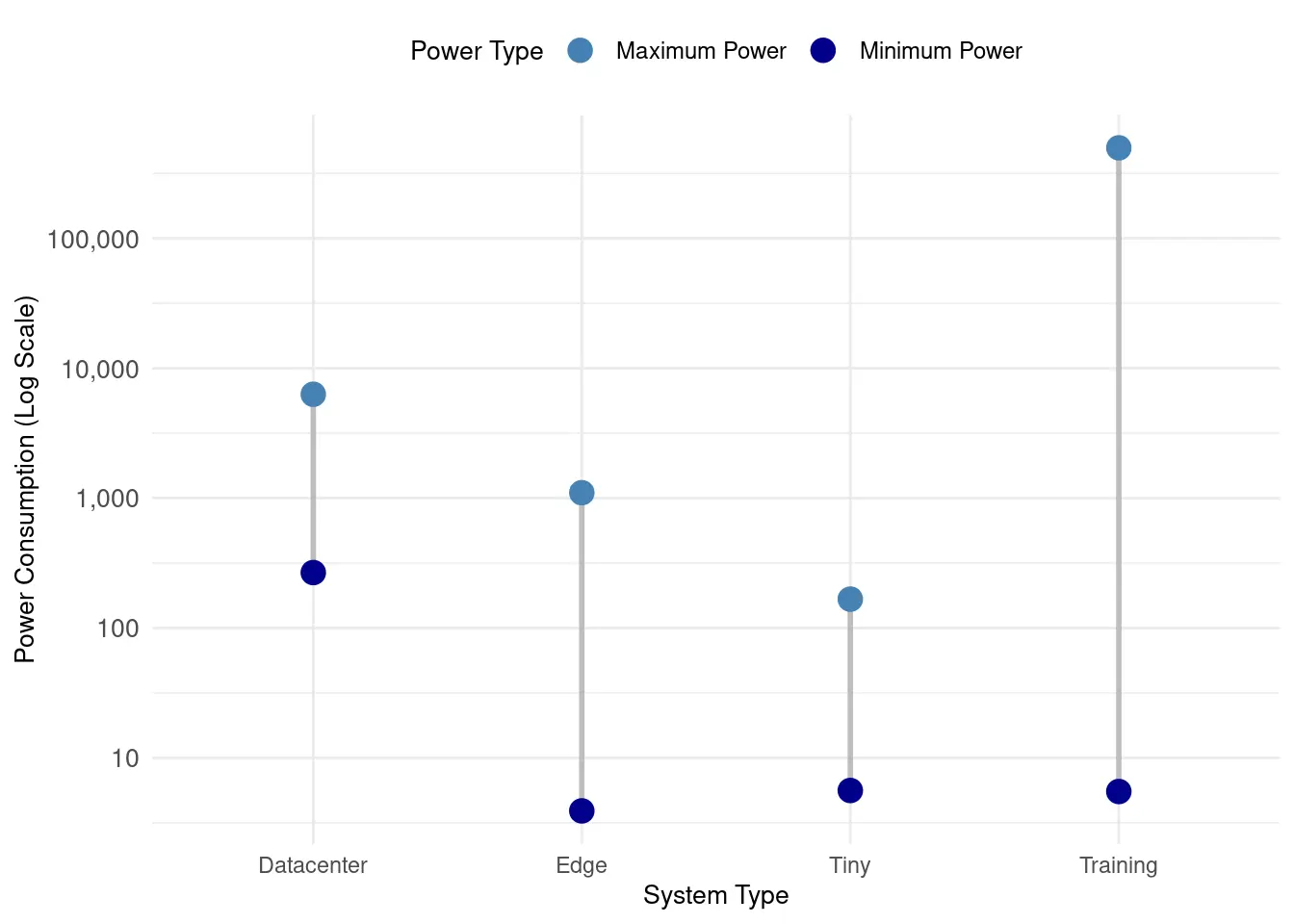

推理负载在云、边缘、移动和 tinyML 系统间的扩展带来更多复杂性。如图 7 所示,不同系统的能耗差异巨大,从微瓦到兆瓦级。推理基准评估延迟、成本与能效之间的权衡,帮助组织做出明智的部署决策。

与训练基准类似,以下章节将持续引用 MLPerf Inference 作为推理基准原则的实例。MLPerf 的推理基准为从云到边缘设备的多场景部署提供了标准化评估。

推理基准动机

机器学习模型推理部署面临的挑战,与训练阶段截然不同。训练侧重于大规模计算与数据处理,而推理则需在多变的实际环境中高效生成预测。推理基准评估这些部署特定的性能挑战,识别模型从开发到生产服务转变过程中的瓶颈。

推理基准帮助回答有关模型部署的关键问题:模型在实际条件下生成预测的速度有多快?推理速度与准确率之间的权衡是什么?推理系统能否在保持低延迟的同时处理不断增长的请求?通过评估这些因素,基准指导硬件与软件的优化,以提升整体效率。

推理基准的重要性

推理在 AI 应用中至关重要,直接影响可用性和成本。与通常离线进行的训练不同,推理需实时或近实时操作,因此延迟成为首要考虑因素。处理相机数据的自动驾驶汽车必须在毫秒内做出反应,而生成响应的语音助手则需给用户即时反馈。

不同应用对推理的要求各异。有些工作负载需要单实例推理,即尽可能快地处理每个输入,适用于机器人、增强现实和对话式 AI 等实时系统。另一些工作负载,如大规模推荐系统或搜索引擎,则需同时处理大量查询,优先考虑吞吐量而非单个查询的延迟。基准使工程师能够评估这两种场景,确保模型针对预期用例进行了优化。

推理与训练的另一个不同之处在于,推理工作负载通常在生产环境中持续运行,因此即使是微小的低效也会随着时间推移而累积。与一次性训练任务不同,云端推理系统可能每天处理数百万个查询,智能手机上的模型则需在长时间使用中管理电池消耗。基准提供了一种结构化的方法来测量推理在这些实际约束下的效率,帮助开发者在模型优化、硬件选择和部署策略上做出明智决策。

推理指标

评估推理系统性能的指标,与训练阶段截然不同。推理基准侧重于延迟、效率和实际部署环境中的资源利用率。这些指标确保机器学习模型能够在从云数据中心到移动和边缘设备的不同环境中良好运行。

与强调吞吐量和收敛时间的训练基准不同,推理基准评估经过训练的模型在处理输入和生成预测时的效率。以下部分将描述推理基准中最重要的指标,解释其相关性以及如何用于比较不同系统。

延迟与尾部延迟

延迟是推理的关键性能指标,尤其是在对实时性要求极高的应用中,延迟直接影响用户体验或系统安全。延迟是指推理系统处理输入并生成预测所需的时间。虽然系统的平均延迟有参考价值,但在高负载情况下,偶发的延迟峰值可能严重影响可靠性。

因此,基准测试通常会测量尾部延迟[^fn-tail-latency],反映系统中的最坏情况延迟。这些通常以第 95 百分位(p95)或第 99 百分位(p99)延迟报告,表示 95% 或 99% 的推理在给定时间内完成。对于自动驾驶或实时交易等应用,保持低尾部延迟至关重要,以避免不可预测的延迟导致灾难性后果。

尾部延迟与大规模用户体验的关系在生产系统中尤为关键。即使是小幅度的 P99 延迟恶化,在百万级用户中也会产生成倍的影响:如果 1% 的请求延迟增加 10 倍(例如,从 100 毫秒增加到 1000 毫秒),将影响每百万请求中的 10,000 名用户,可能导致超时错误、用户体验不佳和客户流失。搜索引擎和推荐系统对此尤为敏感:Google 发现额外 500 毫秒的延迟会减少 20% 的搜索流量,而亚马逊则发现 100 毫秒的延迟增加会使销售下降 1%。

因此,生产系统的服务水平目标(SLO)侧重于尾部延迟,而非平均延迟,以确保一致的用户体验。典型的生产 SLO 规定交互服务的 P95 < 100 毫秒,P99 < 500 毫秒,意识到偶尔的慢响应对用户满意度的影响是巨大的。像 Netflix 和 Uber 这样的大型系统则优化 P99.9 延迟,以应对影响服务可靠性的流量峰值和基础设施变化。

吞吐量与批处理效率

吞吐量是衡量推理系统每秒处理请求数量的指标,通常以每秒查询数(QPS)或每秒帧数(FPS)表示(视觉任务)。有些推理系统采用单实例处理模式,即每个输入独立处理;而另一些则采用批量推理,利用硬件优化同时处理多个输入,从而显著提高效率。

例如,处理数百万查询的云端服务受益于批量推理,将大量输入一起处理,以最大化计算效率。相比之下,机器人技术、交互式 AI 和增强现实等应用则需要低延迟的单实例推理,系统必须对每个新输入立即做出响应。

基准测试必须同时考虑单实例和批量吞吐量,以全面了解不同部署场景下的推理性能。

精度与准确率权衡

优化推理性能通常涉及降低数值精度,这可以显著加快计算速度,同时减少内存和能耗。然而,低精度计算可能导致准确率下降,因此必须基准测试速度与预测质量之间的权衡。

推理基准评估模型在不同数值设置下的表现,如 FP3235、FP1636 和 INT837。许多现代 AI 加速器支持混合精度推理,允许系统根据工作负载动态调整数值表示。模型压缩技术38 进一步提高了效率,但对模型准确率的影响因任务和数据集而异。基准测试帮助确定这些优化在部署中的可行性,确保效率提升不会以不可接受的准确率损失为代价。

内存占用与模型大小

除了计算优化,内存占用也是推理系统的关键考量,特别是在资源有限的设备上。高效推理不仅依赖于速度,还依赖于内存使用情况。与训练不同,推理通常要求模型在严格的内存限制内运行。总模型大小决定了部署所需的存储空间,而 RAM 使用则反映了执行过程中的工作内存需求。有些模型在数据处理单元间传输数据时需要大带宽,这在硬件容量不足时可能成为瓶颈。

推理基准评估这些因素,确保模型能在各种设备上有效部署。高准确率但超出内存限制的模型,可能在现实中难以应用。为此,通常采用各种压缩技术来减小模型体积,同时保持准确率。基准测试帮助评估这些优化是否在内存效率和预测性能之间取得了合理平衡。

冷启动与模型加载时间

在优化内存需求后,冷启动性能对确保推理系统在部署时快速响应至关重要。在许多部署场景中,模型并非始终保留在内存中,而是根据需要按需加载。这可能会引入显著的延迟,特别是在无服务器 AI 环境中39,资源根据传入请求动态分配。冷启动性能衡量系统从闲置到主动执行的过渡速度,确保推理可在没有过长等待时间的情况下进行。

模型加载时间是指将训练好的模型加载到内存中以便处理输入所需的时间。在某些情况下,特别是在资源受限的设备上,模型可能需要频繁重新加载,以释放内存供其他应用使用。首次推理请求所需的时间也是一个重要考量,因为它反映了用户与 AI 服务交互时的总延迟。基准测试帮助量化这些延迟,确保推理系统能够满足实际的响应速度要求。

动态工作负载扩展

冷启动延迟解决了初始响应能力,而可扩展性则确保推理系统能够处理波动的工作负载和并发需求。推理工作负载必须根据不同的使用模式有效扩展。在云 AI 服务中,这意味着高效处理数百万个并发用户,而在移动或嵌入式设备上,则涉及管理多个 AI 模型的同时运行,而不至于过载系统。

可扩展性衡量分配更多计算资源时,推理性能提升的效果。在某些情况下,增加更多 GPU 或 TPU 会显著提高吞吐量,但在其他情况下,内存带宽限制或网络延迟等瓶颈可能会限制扩展效率。基准测试还评估系统在实际部署中平衡多个并发模型的能力,不同 AI 驱动特性可能需要同时运行而不互相干扰。

对于云端 AI,基准评估系统在波动需求下的处理效率,确保推理服务器能够动态分配资源而不影响延迟。在移动和嵌入式 AI 中,高效的多模型执行对于同时运行多个 AI 驱动特性至关重要,而不会降低系统性能。

能源消耗与效率

由于推理工作负载在生产中持续运行,功耗和能源效率成为关键考量。这在移动和边缘设备上尤为重要,因为电池寿命和热限制限制了可用的计算资源。即使在大规模云环境中,电力效率也直接影响运营成本和可持续发展目标。

单次推理所需的能量通常以每次推理的焦耳数来衡量,反映系统在最小化功耗的同时处理输入的效率。在云推理中,效率通常以每瓦查询数(QPS/W)表示,以量化系统在性能和能量消耗之间的平衡。对于移动 AI 应用,优化推理功耗可以延长电池寿命,使模型能够在资源受限的设备上高效运行。降低能耗还在于使大规模 AI 系统更具环境可持续性,确保计算进步与节能部署策略相一致。通过在性能与功耗之间取得平衡,节能推理系统使 AI 能够在从数据中心到边缘设备的多种应用中可持续扩展。

推理性能评估

评估推理性能是理解机器学习系统如何满足实际应用需求的关键步骤。与通常离线进行的训练不同,推理系统必须在各种部署场景中高效处理输入并生成预测。延迟、吞吐量、内存使用和能量效率等指标提供了结构化的方法来衡量系统性能并识别改进领域。

下表(表 3)总结了评估推理系统时使用的关键指标,突显了它们在不同上下文中的相关性。虽然每个指标提供了独特的见解,但全面评估推理基准时必须综合考虑这些指标之间的权衡,包括速度与准确率、吞吐量与功耗之间的权衡,以实现有效的系统设计。

| 类别 | 关键指标 | 基准应用示例 |

|---|---|---|

| 延迟与尾部延迟 | 平均延迟(毫秒/请求);尾部延迟(p95、p99、p99.9) | 评估安全关键型 AI 的实时性能 |

| 吞吐量与效率 | 每秒查询数(QPS);每秒帧数(FPS);批量吞吐量 | 比较大规模云推理系统 |

| 数值精度影响 | 准确率下降(FP32 与 INT8 比较);降低精度带来的加速效果 | 在优化推理中平衡准确率与效率 |

| 内存占用 | 模型大小(MB/GB);RAM 使用(MB);内存带宽利用率 | 评估边缘和移动部署的可行性 |

| 冷启动与加载时间 | 模型加载时间(秒);首次推理延迟(秒) | 评估无服务器 AI 的响应能力 |

| 可扩展性 | 负载下的效率;多模型服务性能 | 测量动态高需求系统的稳健性 |

| 功率与能量效率 | 每次推理的功耗(瓦特);每瓦性能(QPS/W) | 优化移动和可持续 AI 的能耗 |

推理系统考量

推理系统面临的独特挑战,取决于其部署方式和环境。实时应用如自动驾驶汽车或语音助手要求低延迟,以确保及时响应;而大规模云部署则侧重于最大化吞吐量,以处理数百万个查询。边缘设备则受限于内存和电力,效率至关重要。

评估推理性能时,理解指标之间的权衡至关重要。例如,优化高吞吐量可能会增加延迟,使系统不适合实时应用;而降低数值精度提高能效和速度,但可能导致轻微的准确率下降。全面的评估必须平衡这些权衡,以符合预期应用。

部署环境在确定评估优先级方面也起着重要作用。云端系统通常优先考虑可扩展性和对动态工作负载的适应能力,而移动和边缘系统则需特别关注内存使用和能量效率。这些不同的优先级意味着基准测试必须针对系统的实际使用场景量身定制,而不是依赖于一刀切的评估。

最终,评估推理性能需要一种整体方法。关注单一指标(如延迟或能量效率)只能提供不完整的视图。相反,所有相关维度必须一起考虑,以确保系统在功能、资源和性能目标之间实现平衡。

上下文相关指标

不同的部署场景对指标的优先级要求截然不同,因为操作约束和成功标准差异很大。理解这些优先级使工程师能够有效地集中基准测试工作,并在适当的决策框架内解读结果。下表(表 4)说明了在五种主要部署上下文中,性能优先级如何转变,揭示了操作约束与优化目标之间的系统关系。

| 部署上下文 | 主要优先级 | 次要优先级 | 第三优先级 | 关键设计约束 |

|---|---|---|---|---|

| 实时应用 | 延迟(p95 < 50ms) | 可靠性(99.9%) | 内存占用 | 用户体验要求系统即时响应 |

| 云规模服务 | 吞吐量(QPS) | 成本效率 | 平均延迟 | 商业可行性要求大规模处理能力 |

| 边缘/移动设备 | 功耗 | 内存占用 | 延迟 | 电池寿命和资源限制主导设计 |

| 训练工作负载 | 训练时间 | GPU 利用率 | 内存效率 | 研究速度要求更快的实验周转时间 |

| 科学/医疗 | 准确率 | 可靠性 | 可解释性 | 正确性不能以性能为代价 |

表 4 中所示的层级反映了操作约束如何驱动性能优化策略。实时应用是对延迟敏感的场景,系统响应的及时性直接影响用户体验。自动驾驶车辆的感知系统必须在严格的时间限制内处理传感器数据,因此 p95 延迟比峰值吞吐量更为重要。表中还将可靠性列为次要优先级,因为自动驾驶系统的故障可能带来安全隐患,必须优先确保系统稳定。

相比之下,云规模服务则优先考虑吞吐量,以应对数百万的并发用户,同时接受较高的平均延迟以换取每次查询的成本效率。由吞吐量到成本效率再到延迟的转变,反映了云服务提供商必须优化每台服务器的收入,同时维持可接受的用户体验。注意,同一指标(延迟)在实时应用中是主要优先级,而在云服务中则是第三优先级,这表明了性能评估的上下文相关性。

边缘和移动部署面临截然不同的约束,电池寿命和热管理成为设计决策的关键。提升吞吐量 50% 但功耗增加 30% 的智能手机 AI 助手,实际上是退步,因为电池寿命的缩短直接影响用户满意度。训练工作负载则呈现出另一个独特的优化格局,研究生产力依赖于实验周转时间,因此 GPU 利用率和内存带宽对更大模型的探索至关重要。

科学和医疗应用则将准确率和可靠性视为不可妥协的要求,性能优化服务于这些主要目标,而不是替代它们。一个在 10 毫秒内达到 99.2% 准确率的医疗诊断系统,比一个在 5 毫秒内达到 98.8% 准确率的系统更具价值,表明了上下文特定优先级如何指导有意义的性能评估。

这种优先级框架从根本上影响了基准解读和优化策略。对于云部署而言,实现 2 倍吞吐量提升具有重要价值,但对于电池供电的边缘设备而言,降低 20% 功耗带来的 20% 电池寿命延长更具实际意义。

推理基准常见误区

即使有明确定义的指标,推理系统的基准评估也可能面临挑战。评估过程中的失误往往导致误导性结论。以下是分析推理性能时应注意的常见误区。

过度强调平均延迟

虽然平均延迟提供了响应时间的基线测量,但它无法捕捉系统在峰值负载下的表现。在实际场景中,尾部延迟(如 p95、p99)对系统可靠性影响重大。比如,一个对话式 AI 系统如果偶尔出现延迟峰值超过可接受阈值,就可能无法及时响应。

因此,生产系统的服务水平目标(SLO)侧重于尾部延迟,而非平均延迟,以确保一致的用户体验。典型的生产 SLO 规定交互服务的 P95 < 100 毫秒,P99 < 500 毫秒,意识到偶尔的慢响应对用户满意度的影响是巨大的。像 Netflix 和 Uber 这样的大型系统则优化 P99.9 延迟,以应对影响服务可靠性的流量峰值和基础设施变化。

忽视内存与能耗约束

如果一个模型在推理时表现出色,但其内存或功耗需求过高,则可能不适合移动或边缘部署。例如,针对云环境设计的推理系统,可能无法在电池供电的设备上高效运行。正确的基准测试必须考虑内存占用和能耗,以确保在各种部署环境中的实用性。

忽视冷启动性能

在无服务器环境中,模型按需加载时,冷启动延迟是关键因素。忽视模型初始化和处理首个请求所需时间,可能导致对响应能力的不切实际期望。评估模型加载时间和首次推理延迟,确保系统设计能满足实际响应要求。

单一指标评估

推理系统的基准测试通常涉及平衡多个竞争指标。例如,最大化批量吞吐量可能会导致延迟增加,而激进的精度降低可能会降低准确率。单独关注某一指标,而不考虑其对其他指标的影响,可能导致评估不完整或误导。

数值精度优化尤其体现了这一挑战。单个加速器的基准测试可能显示 INT8 操作的 TOPS(每秒万亿次操作)比 FP32 高出 4 倍,形成引人注目的性能叙述。

然而,当这些加速器在完整训练系统中部署时,由于收敛时间延长、精度转换开销和混合精度协调复杂性,芯片级的优势往往会消失。 “4 倍更快” 的微基准可能转化为更慢的端到端训练,说明了为何孤立的硬件指标无法替代全面的系统评估。平衡的方法(如 FP16 混合精度)尽管 TOPS 测量值较低,但通常能提供更优的系统级性能。全面的基准测试必须考虑这些跨指标的相互作用和系统级复杂性。

线性扩展假设

推理性能并不总是随着资源的增加而成比例地扩展。内存带宽、热限制或通信开销等瓶颈,可能限制增加更多 GPU 或 TPU 带来的收益。如第 11 章所述,这些扩展限制源于硬件的基本约束和互连架构。假设线性扩展行为的基准测试,可能会高估系统性能,特别是在分布式部署中。

忽视应用需求

通用基准结果可能未能考虑应用的特定需求。例如,针对云推理优化的基准,可能与边缘设备无关,后者更关注能量和内存的限制。量身定制的基准测试确保结果具有实际意义和可操作性。

统计显著性与噪声

区分有意义的性能提升与测量噪声,需要适当的统计分析。遵循前文建立的评估方法原则,MLPerf 通过要求多次基准测试和报告基于百分位的指标,而非单次测量,来解决测量变异性。例如,MLPerf Inference 报告 99 百分位延迟以及平均性能,捕捉典型行为和最坏情况,而单次测量可能遗漏这些信息。这种方法认识到系统性能因 GPU 热降频、内存分配模式和后台进程等因素而自然波动。

推理基准总结

推理基准是理解系统性能的关键工具,但其效用依赖于全面和整体的评估。延迟、吞吐量、内存使用和能量效率等指标提供了宝贵的见解,但其重要性因应用和部署上下文而异。应全面考虑这些指标之间的权衡,以确保系统在功能、资源和性能目标之间实现平衡。

避免常见误区,平衡多个指标,能帮助从业者设计可靠、高效且适合实际部署的推理系统。基准测试的最终目的是指导系统改进,以符合预期应用的需求。

MLPerf 推理基准

MLPerf 推理基准由 MLCommons40 开发,提供了一个标准化框架,用于评估机器学习推理在各种部署环境中的性能。最初,MLPerf 仅包含一个推理基准,但随着机器学习系统应用的多样化,单一基准已无法满足需求。云端 AI 服务和资源受限的嵌入式设备等不同推理场景,均需量身定制的评估。由此,衍生出一系列 MLPerf 推理基准,旨在针对特定部署场景评估性能。

MLPerf 推理

MLPerf 推理 是基础基准,最初用于评估大规模推理系统。它主要关注数据中心和云端的推理工作负载,这些场景对高吞吐量、低延迟和资源利用效率要求极高。基准评估多个深度学习模型的性能,包括图像分类、目标检测、自然语言处理和推荐系统。该版本的 MLPerf 仍然是比较 AI 加速器、GPU、TPU 和 CPU 在高性能计算环境中表现的金标准。

主要科技公司定期参考 MLPerf 结果来做出硬件采购决策。例如,在评估推荐系统基础设施硬件时,MLPerf 在 DLRM41(深度学习推荐模型)工作负载上的基准得分,直接影响不同加速器代际之间的选择。基准结果始终显示,较新 GPU 架构在推荐推理上的吞吐量比上一代高出 2-3 倍,通常足以证明在大规模生产部署中使用新硬件的额外成本。这表明了标准化基准如何直接影响行业内数百万美元的基础设施决策。

全面基准测试的成本

尽管基准测试对 ML 系统开发至关重要,但其高昂的成本限制了参与者的范围。提交 MLPerf 基准测试可能需要大量工程工作和数十万美元的硬件及云计算资源。一次全面的 MLPerf 训练提交,涉及数月的工程时间用于优化、调试和验证多个硬件配置,计算成本可能超过 $100,000,涵盖多个工作负载和系统规模。

这一成本壁垒解释了为何 MLPerf 提交主要由大型科技公司和硬件供应商主导,而较小的组织则依赖于已发布的结果,而非进行全面的自我评估。这一现象进一步推动了内部轻量级基准测试实践的需求,使组织能够在不进行全规模标准化基准测试的情况下,做出明智的决策。

MLPerf Mobile

MLPerf Mobile 将 MLPerf 的评估框架扩展到智能手机和其他移动设备。与云推理不同,移动推理在功耗和内存方面受到严格限制,因此模型必须优化以实现高效而不牺牲响应能力。该基准测量实时 AI 任务的延迟和响应能力,如基于相机的场景检测、语音识别和增强现实应用。MLPerf Mobile 已成为评估旗舰智能手机和移动 AI 芯片 AI 性能的行业标准,帮助开发者优化模型以适应设备端 AI 工作负载。

MLPerf Client

MLPerf Client 专注于消费级计算设备(如笔记本电脑、台式机和工作站)的推理性能。该基准针对直接在个人设备上运行的本地 AI 工作负载,无需依赖云推理。实时视频编辑、语音转文本和 AI 增强生产力应用等任务,均属于此类。与基于云的基准不同,MLPerf Client 评估 AI 工作负载与通用硬件(如 CPU、独立 GPU 和集成 NPU)的交互,适用于消费和企业 AI 应用。

MLPerf Tiny

MLPerf Tiny 专为嵌入式和超低功耗 AI 系统(如 IoT 设备、可穿戴设备和微控制器)设计。与其他 MLPerf 基准评估强大加速器上的性能不同,MLPerf Tiny 评估在计算、内存和电力资源有限的设备上的推理。该基准对智能传感器、AI 驱动的自动化和实时工业监控等应用至关重要,这些场景要求模型在极少的处理能力硬件上高效运行。MLPerf Tiny 在边缘 AI 发展中发挥着关键作用,帮助开发者优化模型以适应受限环境。

发展与未来方向

MLPerf 推理基准的演变,反映了 AI 部署场景的多样性。从云端、移动、桌面到嵌入式环境,不同的约束和需求使得量身定制的基准评估变得必要。

MLPerf 是理解:

不同部署环境中推理性能的变化。

不同 AI 应用中最相关的性能指标。

基于实际使用约束优化模型和硬件选择的关键工具。

认识到量身定制的推理基准的必要性,加深了我们对 AI 部署挑战的理解,突显了基准测试在开发高效、可扩展和实用的机器学习系统中的重要性。

推理阶段的能效考量贯穿于推理基准方法中,反映出功耗对推理和训练两个阶段的不同影响。训练阶段的能耗成本在模型生命周期中摊销,而推理阶段的能耗成本则是按查询累积,直接影响操作效率。以下对功率测量技术的分析,支持了每个基准测试阶段所涵盖的能量指标。

功耗测量技术

能效基准测试需要针对不同 ML 部署环境的多样化功耗量级,采用专门的测量技术。在训练与推理章节已确立能耗考量的基础上,这些技术为验证 第 10 章:模型优化 的优化主张和 第 11 章:AI 加速 的硬件效率提升,提供了系统化的量化手段。

性能基准有助于优化速度和准确率,但往往忽略了能效,而能效已成为实际部署中的关键因素。 第 9 章:高效 AI 中提出的能效原则——平衡计算复杂度、内存访问模式和硬件利用率——需要通过标准化能耗基准进行定量验证。只有这样,才能判断 第 10 章:模型优化 的架构优化和 第 11 章:AI 加速 的硬件感知设计,是否真正带来了实际的能耗节省。

然而,机器学习系统的功耗测量面临独特挑战。ML 模型在不同部署环境下的能耗需求差异极大,跨度达数个数量级,如下表 5 所示。这一从微瓦级 TinyML 设备到千瓦级数据中心机架的巨大区间,凸显了制定统一能效基准方法的根本难题。

| 类别 | 设备类型 | 功耗 |

|---|---|---|

| Tiny | 神经决策处理器(NDP) | 150 µW |

| Tiny | M7 微控制器 | 25 mW |

| Mobile | 树莓派 4 | 3.5 W |

| Mobile | 智能手机 | 4 W |

| Edge | 智能摄像头 | 10-15 W |

| Edge | 边缘服务器 | 65-95 W |

| Cloud | ML 服务器节点 | 300-500 W |

| Cloud | ML 服务器机架 | 4-10 kW |

如此巨大的功耗跨度(超过四个数量级),为测量与基准测试带来了重大挑战。因此,制定统一方法时必须充分考虑每个量级的独特特性。例如,准确测量 TinyML 设备的微瓦级功耗,需要与监控千瓦级服务器机架完全不同的仪器和技术。任何全面的基准框架都必须兼容这些极端不同的量级,同时确保在多样硬件配置下测量的一致性、公平性和可复现性。

功耗测量边界

为应对这些测量挑战,图 8 展示了从 TinyML 设备到数据中心推理节点的不同系统规模下的功耗测量边界。每种场景都用绿色标示了能耗计量的系统边界,明确哪些组件被纳入能耗统计。红色虚线框外的部分则被排除在测量之外。

系统级功耗测量比单独测量组件更具全局视角。虽然组件级指标(如加速器或处理器功耗)对性能调优有价值,但真实 ML 负载涉及计算单元、内存系统和基础设施的复杂协同。例如,Google TensorFlow Mobile 工作负载分析显示,数据移动占总推理能耗的 57.3%,说明内存绑定操作常常主导系统能耗。

共享基础设施带来额外挑战。在数据中心,冷却和供电等资源被多个负载共享,难以将能耗精确归因于特定 ML 任务。仅冷却就可占总设施能耗的 20-30%,成为能效评估的重要因素。即使在边缘,内存和 I/O 也常服务于 ML 与非 ML 功能,进一步模糊了测量边界。

共享基础设施的复杂性还因现代系统采用动态功耗管理技术而加剧。动态电压与频率调节(DVFS)根据负载自动调整处理器电压和主频,在低计算强度时显著降低功耗。先进的 DVFS 方案通过片上切换稳压器可实现 30-50% 的能耗浮动,同一模型在不同负载和并发下功耗差异巨大。这不仅影响计算组件,也影响冷却等基础设施,因为处理器活动减少会降低发热,进而减少冷却需求。即使是边缘设备也需基本的热管理。

计算效率与功耗权衡

计算性能与能效之间的权衡,是现代 ML 系统设计中最重要的议题之一。系统追求更高性能时,往往因半导体物理极限和供电瓶颈,导致能效收益递减。主频提升尤为明显:主频提升 20%,性能仅提升约 5%,但功耗却可能增加 50%,反映了电压、频率与功耗的三次方关系。

在能耗受限的场景(如电池供电的边缘和移动应用)中,优化性能 - 能耗权衡是实际可用性的前提。模型优化技术为在不显著损失准确率的前提下提升能效提供了可行路径。数值精度优化可在准确率损失 1-2% 的情况下,实现 3-4 倍的推理速度和能效提升。

这些优化策略涉及准确率、计算性能和能效三维的协同。先进优化方法可对这一权衡空间进行精细调控。模型优化与压缩同样需在准确率损失与效率提升间权衡。最佳操作点高度依赖于部署需求:移动应用优先考虑能效以延长电池寿命,云服务则可为更高准确率牺牲能耗,依赖规模经济和专用冷却。

随着基准方法不断演进,能效指标正成为 AI 系统评估与优化的核心。MLPerf Power 等标准化功耗测量协议,为跨平台能效比较提供了统一框架。未来可持续 AI 基准的进步,将推动系统在性能、能耗与环境影响间实现系统性平衡,确保 ML 系统高效运行、减少不必要能耗,并支持更广泛的可持续发展目标。

标准化功耗测量

虽然 SPEC Power 等通用计算系统的功耗测量方法已存在多年,但 ML 工作负载的独特性要求专门的测量方法。ML 系统的功耗模式具有明显阶段性,计算密集与数据移动、预处理交替出现,不同模型和任务的功耗曲线差异极大。大语言模型与计算机视觉推理的功耗特征完全不同。

直接功耗测量需关注采样频率和测量窗口。例如,某些神经网络架构在复杂计算时会产生短暂的功耗尖峰,需高于 1KHz 的高频采样才能准确捕捉;而 CNN 推理则功耗更平稳,可用较低采样率。测量时长还需覆盖 ML 特有的“热身期”,如初始推理阶段因缓存和流水线初始化而能耗更高。

ML 工作负载的内存访问模式对功耗测量影响极大。传统计算基准主要关注处理器功耗,而 ML 系统常有大量能耗用于内存层级间数据搬运。例如,推荐模型 DLRM 的能耗主要消耗在内存访问而非计算。测量方法需能同时捕捉计算与内存子系统的功耗。

加速器相关因素进一步增加了测量复杂性。许多 ML 系统采用 GPU、TPU、NPU 等专用硬件,这些加速器常有独立的功耗管理机制,可与主处理器独立运行。准确测量需同步捕捉所有相关计算单元的功耗,尤其在异构系统中,不同计算资源会根据负载或功耗约束动态切换。

ML 工作负载的规模和分布也影响测量方法。分布式训练需同时计入本地计算功耗和节点间梯度同步的能耗。边缘 ML 部署则需同时考虑主动推理功耗和模型更新、数据预处理的能耗。

批量大小与吞吐量也带来复杂性。与传统计算不同,ML 系统常通过批处理提升效率,但批量大小与功耗的关系并非线性。大批量提升计算效率的同时,也会增加内存压力和峰值功耗。测量方法需覆盖不同批量下的功耗,才能全面反映效率。

系统空闲状态在 ML 工作负载中尤需关注,尤其在边缘场景下,系统常常间歇性运行,数据到达时才激活推理,其余时间处于低功耗状态。例如唤醒词检测 TinyML 系统,实际处理音频的时间占比极低,空闲功耗成为整体能效的关键。

温度效应对 ML 系统功耗测量影响显著。持续 ML 负载会导致温度升高,触发热降频,改变功耗模式。边缘设备尤为如此,热约束可能限制持续性能。测量方法需考虑温度变化及其对功耗的影响,尤其在长时间基准测试中。

MLPerf Power 案例分析

MLPerf Power 是机器学习系统能效测量的标准方法。该全面基准框架可准确评估多样 ML 部署的功耗。在数据中心层面,测量大规模 AI 工作负载的能耗,能效优化直接影响运营成本。在边缘计算场景,评估如智能手机、笔记本等消费设备的能效,电池寿命约束至关重要。在 Tiny 推理场景,评估超低功耗 AI 系统(如 IoT 传感器、微控制器)的能耗,适用于极端功耗预算下的 AI 部署。

MLPerf Power 方法学应用了前述标准化评估原则,适配从通用 CPU 到专用 AI 加速器的多种硬件架构,确保跨平台比较的科学性和测量一致性。

该基准已累计数千份由业界机构提交的可复现测量结果,展示了最新硬件能力和全行业对能效 AI 技术的关注。图 9 展示了 MLPerf 各版本下,不同系统规模的能效提升趋势。

MLPerf Power 方法学可适配从通用 CPU 到专用 AI 加速器的多种硬件架构,同时保持统一的测量标准,确保跨平台比较的科学性和公正性。

对 MLPerf 各版本和不同规模的 ML 部署,业界机构均提交了可复现的最新硬件测量结果,以量化全行业对能效 AI 技术优化的重视。图 9 展示了从 Tiny 到数据中心系统的能效趋势。

这些趋势揭示了两个重要现象:一是传统 ML 负载在所有三种规模下的能效提升趋于平台期;二是生成式 AI 应用的能效提升极为显著。这一分化表明,常规 ML 任务的优化已接近极限,而生成式 AI 领域则在快速创新。这也凸显了行业面临的双重挑战:一方面需突破能效平台期,另一方面需确保生成式 AI 的可持续扩展。

基准局限与最佳实践

有效的基准测试需理解其固有限制,并通过改进设计和解读实践加以规避。成功的从业者不会因基准局限而放弃测量,而是主动识别挑战并调整方法。以下从四个关联类别分析基准挑战,并给出改进建议。

统计与方法学问题

可靠基准的基础在于严谨的统计方法。若忽视以下三点,基准的科学性将大打折扣。

问题覆盖不全 是最根本的限制。许多基准虽便于对比,但无法覆盖真实应用的复杂性。例如,常用的图像分类数据集(如 CIFAR-10 )图像种类有限,模型在这些数据集上表现优异,却难以应对现实中光照、视角、物体组合更复杂的场景。基准任务与现实复杂度的鸿沟,意味着高分不能保证实际部署成功。

统计不显著 源于样本或实验次数过少。例如,OCR 系统若只在小数据集上测试,难以反映其在大规模、噪声文本下的表现。若缺乏足够的实验和多样输入分布,基准结果可能误导或无法反映系统可靠性。许多基准分数未报告置信区间,掩盖了测量差异是改进还是噪声。

可复现性 是持续挑战。基准结果常因硬件配置、软件版本、依赖变化而波动。编译器、数值精度、库升级等微小差异,都会导致不同环境下测量不一致。MLPerf 通过参考实现、标准化测试环境和严格提交规范缓解了这一问题,但在多样硬件平台间实现真正一致仍极具挑战。优化库、框架版本、编译参数的组合空间极大,微小变化即可导致结果不同。

实验室到部署的性能鸿沟

除了统计严谨性,基准还需与实际部署目标对齐。与现实目标不符 是常见问题。基准常强调速度、准确率、吞吐量等指标,但实际部署需多目标权衡,包括能效、成本、稳健性等。某模型在基准上准确率领先,但若能耗过高或硬件成本过大,实际部署时反而不可行。又如,基准优化平均性能,实际生产却需关注尾部延迟。现实部署的多目标约束远超基准单一指标的优化。

系统设计挑战

物理和架构因素带来额外变异性,需通过多样部署上下文的对比方法加以应对。

环境条件

AI 基准测试中的环境条件,指实验的物理和操作环境。这些条件常被忽视,但对结果和可复现性影响极大。物理环境包括温度、湿度、空气质量和海拔等,都会影响硬件性能。例如,高温可能导致处理器热降频,降低计算速度,影响基准结果。海拔变化影响冷却效率和硬盘性能。

操作环境则包括系统运行时的后台进程、网络状况和电源稳定性。其他程序或服务会竞争计算资源,改变模型性能。为保证基准结果的有效性和可复现性,应尽量记录和控制这些环境条件,如在恒温环境下实验、监控并报告环境参数、标准化系统状态、记录后台进程等。

在无法完全控制环境变量的场景(如分布式或云基准),需详细报告环境信息,便于他人解释和复现实验。随着 ML 模型在多样环境中部署,理解环境对性能的影响愈发重要,这不仅提升基准准确性,也有助于开发能适应多变环境的稳健模型。

硬件彩票

基准测试中一个常被忽视的关键问题是“硬件彩票”42(Hooker 2021)。ML 模型的成功不仅取决于架构和数据,还取决于其与底层硬件的适配。有些模型表现优异,仅因其计算模式适合 GPU/TPU 的并行特性,而其他潜力架构因不适配主流硬件而被忽略。

这种硬件适配性带来微妙但重要的基准偏差。某模型在特定 GPU 上效率极高,但在 CPU 或定制加速器上表现平平。例如,图 10 比较了多硬件模型在不同平台的表现。多硬件模型在 CPU uint8 和 GPU 上与 MobileNetV3 Large min 相当,但在 EdgeTPU 和 DSP 上则大幅超越 MobileNetV3 Large。这说明多硬件模型在专用硬件环境下的效率优势。

若不在多样硬件配置下全面基准,行业将倾向于“赢得硬件彩票”的架构,而非本质优越的模型。这种偏差会影响研究方向、资金分配和下一代 AI 系统设计,甚至可能因不适配主流硬件而抑制创新。

组织与战略问题

竞争压力和研究激励会系统性地影响基准的使用和解读。需通过治理机制和社区标准维护基准的公正性。

基准工程

硬件彩票是硬件趋势的副产品,而基准工程则是有意为之,即模型或系统被专门优化以在特定基准上取得高分。这会导致误导性性能声明,结果难以泛化到真实环境。

基准工程表现为开发者针对基准测试精细调参、预处理或架构调整,而非提升实际性能。例如,目标检测模型可针对基准场景优化,实际部署时却难以应对复杂环境。语言模型可针对基准数据集调优,但在口语、代码混用等真实输入下表现不佳。

高分压力常源于竞争、市场和学术认可。基准常被用于排名,激励开发者专门为其优化。这虽能推动技术进步,但也可能导致过度针对基准的优化,牺牲泛化能力。这正是古德哈特定律43的体现。

偏见与过度优化

为保持基准的有效性和公平性,可采取多种策略。透明性 是维护基准公正的关键。基准提交应详细记录所有优化,区分通用改进与针对基准的调优。应同时报告基准和实际部署结果,全面反映系统能力。

多样化与动态演进 也是重要手段。应避免依赖单一静态基准,鼓励跨多个、持续更新的基准评估,反映现实复杂性,减少模型过拟合单一测试集的风险,推动通用改进。

标准化与第三方验证 也有助于减少偏见。通过行业标准和独立第三方审核,提升基准结果的可靠性和公信力。第三方验证确保结果可在不同环境下复现,防止无意的基准作弊。

应用场景测试 也不可或缺。基准虽能控制变量,但实际部署测试才是最终标准。AI 模型应在实际环境下评估,如自动驾驶模型需在多种天气和城市环境下测试,而非仅依赖受控基准数据集。

硬件公平性 也需关注。基准应在多种硬件配置下测试,避免性能仅因平台兼容性而突出,减少硬件彩票风险,获得更均衡的系统效率评价。

基准演进

基准的最大挑战之一是其永远不会静止。AI 系统演进,基准也需同步更新。今天的“好性能”明天可能已无关紧要。基准虽能衡量进步,但若不及时更新,反而会导致过度优化过时指标,阻碍实际进步。

AI 基准史正体现了这一点。早期模型基准侧重图像分类和目标检测,因深度学习最早在这些任务上取得突破。随着 AI 扩展到 NLP、推荐系统和生成式 AI,早期基准已无法反映领域挑战。新基准不断涌现,评估语言理解和生成式 AI。

基准演进不仅体现在新任务的加入,还包括评测维度的扩展。传统 AI 基准强调准确率和吞吐量,现代应用则需多维评估:公平性、稳健性、可扩展性和能效。图 11 展示了科学应用的复杂性,性能需求跨度达数个数量级。例如,大型强子对撞机传感器需以 10$^{14}$ 字节/秒(约 100 TB/s)和纳秒级延迟处理数据,而移动应用仅需 10$^{4}$ 字节/秒和更长计算窗口。这要求专门基准,如边缘 AI 需 MLPerf,科学应用需“Fast ML for Science”基准。

基准演进还需在稳定性与适应性间权衡。一方面,基准需保持足够长的稳定期,便于长期对比;若变动过快,难以追踪进步。另一方面,若不及时更新,模型只会针对过时任务优化,阻碍领域发展。如何平衡基准的持久性与适应性,是 AI 社区的持续挑战。

尽管困难重重,基准演进对确保 AI 进步的现实意义至关重要。若不更新,基准将脱离实际需求,研究者和工程师只会为人工测试集优化,而非解决实际问题。随着 AI 不断进入新领域,基准测试也必须同步演进,确保评估始终相关、公平,并与实际部署场景对齐。

MLPerf 作为行业标准

MLPerf 在提升基准测试方面发挥了关键作用,减少了偏见、提升了泛化性,并确保基准随 AI 进步不断演化。其核心贡献之一是标准化基准环境。通过参考实现、明确定义的规则和可复现的测试环境,MLPerf 保证了不同软硬件平台下结果的一致性,减少了基准结果的波动。

MLPerf 还针对多样部署场景,推出了与三维框架对应的多类推理基准,包括 MLPerf Inference、MLPerf Mobile、MLPerf Client 和 MLPerf Tiny,确保在不同部署约束下,仍能保持系统性评估原则。

MLPerf 不断引入新任务,如生成式 AI 和能效计算,确保基准始终与前沿挑战同步,防止基准过时或过拟合旧指标。

通过强调公平、透明和适应性,MLPerf 使基准测试成为指导 AI 研究和部署的有力工具。其不断演进的基准体系,力求捕捉现实世界 AI 性能的复杂性,推动更可靠、高效和有影响力的 AI 系统发展。

模型与数据基准

三维基准框架除系统外,还包括模型和数据。虽然系统基准是重点,但全面 AI 评估需理解算法和数据质量如何补充系统测量。AI 性能不仅取决于系统效率,模型和数据同样关键。模型基准评估算法性能,数据基准确保训练集高质量、公平且具代表性。理解这些方面至关重要,因为 AI 系统不仅是计算管道,更深受模型和数据的影响。

模型基准

模型基准衡量不同 ML 算法在特定任务上的表现。历史上,基准几乎只关注准确率,但随着模型复杂度提升,公平性、稳健性、效率和泛化能力同样重要。

ML 发展很大程度上受基准数据集推动。MNIST 推动了手写数字识别,ImageNet 引发了图像分类的深度学习革命。COCO 推动了目标检测,GPT-3 的训练语料则进一步拓展了模型能力边界。

但模型基准在大模型时代面临新挑战。除了传统的 Sim2Real 问题(模型在现实场景下失效),还出现了类似但不同于传统基准工程的新型“基准适应”现象。传统系统评测中,开发者会专门优化代码以在 SPEC、TPC 等基准上刷分(见前文“基准工程”)。而在 LLM 时代,这一现象通过数据而非代码发生:基准数据集可能被大模型训练时无意收录,导致模型在测试时表现优异,实则是记忆而非能力。例如,若某基准测试在网络上广泛讨论,LLM 训练时可能已见过类似样本,测试高分并非理解而是记忆。这对模型评估提出了根本挑战,高分未必代表真实能力。关键区别在于机制:系统基准工程是显式代码优化,LLM 基准适应则是数据暴露,质疑了现有评估方法的有效性。

这些挑战不限于 LLM。传统 ML 系统仍面临过拟合与偏见问题。Gender Shades 项目发现,商用人脸识别模型在深色肤色人群上表现显著更差,凸显了公平性评估的重要性。这些发现说明,仅关注总体准确率的基准已远远不够。

未来,模型基准需彻底转型,发展能多维度评估模型行为(泛化、稳健性、公平性、效率等)的新框架。关键挑战包括:如何让基准随模型进步而演化、如何区分真实能力与人工高分、如何建立基准文档和透明度标准。只有解决这些问题,基准结果才能反映模型真实能力,而非训练或评估流程的偶然产物。

数据基准

AI 发展长期以模型为中心,强调架构创新和优化技术。但现代 AI 发展表明,数据质量往往比模型设计更决定性能上限。这一认识推动了数据基准成为确保 AI 模型学习于高质量、多样且无偏数据集的关键领域。

这代表了从模型中心到数据中心的根本转变,如图 12 所示。传统范式强调模型架构、算法和计算效率,数据集被视为固定资源。数据中心范式则系统性提升数据集质量(标注、丰富性、去偏),模型和系统配置保持不变。研究表明,系统性提升数据集质量,往往比模型优化带来更大性能提升,挑战了以往对架构创新的过度依赖。

数据质量优先的理念,反映了“好数据胜于好模型”的根本转变。DataPerf、DataComp 等项目系统性评估数据集改进对模型性能的影响。例如,DataComp(Nishigaki 2024)发现,精心筛选的 30% 数据子集训练出的模型,效果优于全量数据,挑战了“数据越多越好”的传统观念(Northcutt, Athalye, and Mueller 2021)。

数据基准面临的重大挑战是数据集饱和。当模型在 ImageNet 等基准上接近完美准确率时,需区分性能提升是 AI 能力进步,还是对测试集的过度优化。图 13 展示了过去十年 AI 系统在多个应用上超越人类的趋势。

这一饱和现象带来根本性方法学问题(Kiela et al. 2021)。MNIST 就是典型案例:部分测试图片几乎无法辨认,但在 1994 年数据集创建时被赋予了特定标签。模型能正确预测这些标签,表面上超越人类,实则可能只是记忆了数据集特征,而非真正具备数字识别能力。

这些挑战已经超越了单一领域的范畴。“Are we done with ImageNet?”这一发人深省的问题,凸显了静态基准测试的局限性。针对固定数据集优化的模型,往往难以应对分布漂移——即训练数据收集后出现的真实世界变化。为此,业界推动了动态基准测试方法的发展,例如 Dynabench,会根据模型表现持续演化测试数据,以保持基准的现实相关性。

当前的数据基准测试工作涵盖了多个关键维度。标签质量评估始终是核心关注点,DataPerf 的调试挑战对此进行了深入探索。MSWC 等语音识别数据集则关注数据集中的偏见与代表性问题。针对分布外泛化,RxRx 和 WILDS 等基准提供了专门的评测。多样化的努力反映出业界日益认识到:推动 AI 能力进步不仅需要更好的模型和系统,更需要从根本上改进数据质量评估和基准设计方法。

系统 - 模型 - 数据的整体评测

AI 基准测试传统上将系统、模型和数据作为独立实体进行评估。然而,现实中的 AI 性能来源于三者的协同作用。再快的系统也无法弥补模型训练不足的问题,而再强大的模型也受限于其学习的数据质量。这种相互依赖性要求我们采用整体化的基准测试方法,将三大维度纳入统一评估框架。

如图 14 所示,未来的基准测试应建立在系统效率、模型性能和数据质量三者协同评测的基础上。这样,研究者才能发现仅靠单一维度分析时无法察觉的优化空间。例如,结合硬件感知优化的高效 AI 模型与精心策划的数据集协同设计,能够在提升性能的同时降低计算成本。

随着 AI 持续演进,基准测试方法也必须与时俱进。从系统、模型和数据三重视角评估 AI 性能,才能推动准确率、效率、公平性和稳健性等多维改进。这种整体视角对于打造既强大又实用、可扩展且可信赖的 AI 至关重要。

生产环境评测

前文介绍的基准测试方法(从微观到端到端、从训练到推理评测)主要聚焦于受控条件下的系统性能。而 第 13 章:机器学习运维 中的部署策略则揭示,生产环境带来了截然不同的挑战,需要专门的评测方法。生产级机器学习系统必须应对动态负载、多变数据质量、基础设施故障和并发用户需求,同时保持性能和可靠性。这要求我们将基准测试框架从单点性能测量扩展到对系统在压力、异常和长期运行下的行为进行评估。

静默故障检测是生产基准测试中极为关键、但在研究评测框架中常被忽略的维度。机器学习模型可能在无明显错误信号的情况下性能退化,输出看似合理但实际错误,难以被传统监控发现。生产基准测试需建立基线性能分布,并通过统计过程控制方法检测微妙的准确率下降。A/B 测试框架可在相同流量下对比新旧模型版本,不仅关注平均性能,还要衡量性能方差和尾部表现。

持续的数据质量监控应对生产数据流的动态变化,这些变化可能带来分布漂移、对抗样本或数据损坏。生产基准测试需评估模型在现实数据质量波动下的稳健性,包括特征缺失、数值越界和输入格式变化。监控系统需跟踪特征分布随时间的漂移,测量训练与生产数据的统计距离,预测何时需要重新训练。数据验证流水线则基准测试预处理的稳健性,确保模型能优雅应对数据质量问题,避免静默故障。

负载测试与容量规划评估系统在不同流量模式下的表现,反映真实用户行为。生产级 ML 系统需应对请求高峰、并发会话和持续高吞吐压力,同时满足延迟要求。基准测试协议需模拟现实负载模式,包括昼夜流量波动、突发流量事件和自然增长场景。容量规划基准测试则衡量系统利用率逼近极限时的性能退化,便于提前做扩容决策。

运维韧性基准测试评估系统在基础设施故障、网络分区和资源受限时的表现。生产系统需在部分故障下保持服务可用,资源不足时平滑降级,并能快速恢复。混沌工程方法通过有计划地引入故障(如杀死推理服务、增加网络延迟、限制计算资源)来观测系统的降级和恢复特性。

生产环境下的多目标优化要求基准测试框架同时平衡准确率、延迟、成本和资源利用率。生产系统需兼顾用户体验指标(如转化率、活跃度)和传统 ML 指标。成本效率基准测试关注单次预测的计算成本、模型存储费用和系统运维开销。服务级目标(SLO)定义多维性能的可接受区间,便于系统性评估生产健康状况。

持续模型验证通过自动化基准测试流水线,定期在留出数据集和合成测试用例上评估模型表现。影子部署技术可在不影响用户体验的前提下,将新模型与生产系统并行运行,对比输出。冠军 - 挑战者框架则通过受控灰度发布,系统性评估模型改进带来的正负影响。

因此,生产基准测试需要端到端的评估框架,远超模型准确率,涵盖系统可靠性、运维效率和用户体验优化。唯有如此,ML 系统才能在动态生产环境中持续创造价值,并具备关键业务所需的稳健性。

常见误区与陷阱

本章介绍的基准测试方法与框架(从三维评测体系到训练与推理的具体指标)为系统性评估提供了有力工具。但这些工具的有效性,极大依赖于避免常见的误区和方法论错误,否则会严重损害基准测试的有效性。标准化基准虽然便于公平对比,但也容易让人对其普适性产生虚假信心。

误区: 基准测试成绩可直接代表真实应用表现。

这种误解导致团队仅凭基准排名选择模型和系统,忽略了实际部署环境的差异。基准测试通常采用精心策划的数据集、标准化评测协议和最优配置,这些条件很难与真实环境完全一致。生产系统面临数据质量、分布漂移、延迟约束和资源限制等问题,这些在基准场景下并未体现。即便某模型在基准测试中表现优异,实际部署时也可能因环境差异而彻底失效。有效的系统选型应结合部署场景的专属评测,而非仅依赖标准化指标。

陷阱: 只关注基准指标,忽视系统整体需求。

许多实践者过度追求基准分数提升,却未理解这些优化对系统整体行为的影响。某些提升单一指标的技术,可能损害稳健性、校准性、公平性或能效。过度拟合基准评测协议,容易导致模型只在特定测试条件下表现良好,难以泛化到复杂多变的实际场景。这种狭隘优化正是 第 12 章:AI 基准测试 中提到的古德哈特定律(Goodhart’s Law)43 的典型体现,往往让系统在受控环境下表现优异,却难以应对真实世界的复杂性与不可预测性。

误区: 单一指标足以全面反映系统性能。

这种观点认为只需关注一个核心指标即可评估系统。现代 AI 系统需要在准确率、延迟、吞吐量、能耗、公平性和稳健性等多维度进行评测。只优化准确率,可能导致推理延迟不可接受;只关注吞吐量,又可能牺牲结果质量。不同利益相关方关注的指标各异,部署环境的约束也千差万别,单一指标难以全面反映系统表现。科学评测需采用多维度框架,揭示各项性能指标间的权衡。

陷阱: 沿用已过时的基准,忽视新挑战和需求。

团队常常在基准失去挑战性或不再反映现实需求后,仍继续沿用。随着模型能力提升,部分基准已趋于饱和,难以区分不同方案。同时,应用需求、部署环境和公平性标准的变化,也可能让原有基准变得无关紧要甚至误导。基准数据集还可能随时间积累隐藏偏见或质量问题。有效的基准测试需定期评估评测框架是否仍能为当前挑战和场景提供有意义的洞见。

陷阱: 用学术基准评测生产系统,忽略运维约束。

许多团队用为学术对比设计的基准评测生产系统,忽视了研究与运维环境的根本差异。学术基准通常假定计算资源无限、数据质量最优、部署条件理想,而这些在生产环境中极为罕见。生产系统需应对并发负载、输入质量波动、网络延迟、内存限制和系统故障,这些都会显著影响实际性能。此外,生产系统还需同时优化成本效率、可用性和用户体验等多目标,单一学术指标难以覆盖。有效的生产评测应结合运维指标,如高负载下的持续吞吐、故障恢复时间、资源利用效率,以及包括数据预处理和后处理在内的端到端延迟。

总结

本章将基准测试确立为验证第 II、III 部分各类性能优化策略的核心度量学科。通过构建系统、模型、数据三维一体的综合评测框架,我们展示了如何将高效 AI 设计( 第 9 章:高效 AI )、模型优化( 第 10 章:模型优化 )、硬件加速( 第 11 章:AI 加速 )等理论创新转化为可量化的工程进步。从历史计算基准到专用 ML 评测方法的演进,揭示了现代 AI 系统为何需要多维度评测框架,以真实反映实际部署的复杂性。

现代基准测试框架的技术复杂性,直接影响创新方向和资源分配决策。MLPerf 等系统基准通过标准化工作负载和指标,推动硬件优化和基础设施发展,实现跨架构公平对比。模型基准则通过定义有挑战性的任务和评测协议,推动算法创新,揭示局限并引导研究重点。数据基准则暴露代表性、偏见和质量等关键问题,直接影响模型的公平性和泛化能力。三大基准维度的整合,构建了能真实反映现实 AI 部署挑战的综合评测体系。

要点回顾

- 有效的基准测试需在系统、模型、数据三维度进行多维评测,才能反映真实部署挑战

- MLPerf 等标准化基准推动硬件创新,实现跨架构与实现的公平对比

- 基准设计选择直接影响整个 AI 生态的研究重点和资源分配

- 未来基准测试需不断演进,关注 AI 安全、公平性与环境影响等新挑战

本章奠定的基准测试基础,为第 IV 部分“稳健部署”中的运维策略提供了度量支撑。性能测量到生产部署的转变,要求基准验证超越实验室条件。虽然本章聚焦于受控环境下的系统性评测,第 IV 部分将进一步探讨动态负载、数据分布演化和运维约束等现实复杂性。在 第 13 章:机器学习运维 中,我们将基准测试原则扩展到生产环境,介绍如何通过持续监控检测静默故障、跟踪模型性能退化,并在动态负载下验证系统行为。生产监控中的 A/B 测试和冠军 - 挑战者方法,正是建立在训练与推理基准测试的对比评测原则之上。

第 15 章:安全与隐私 中的隐私与安全挑战,同样需要超越性能的专用基准测试方法。对抗稳健性基准评测模型抵御攻击的能力,隐私保护计算框架则需权衡效用与隐私保障。 第 16 章:稳健 AI 的稳健性要求,则需评测模型在分布漂移、数据损坏和极端场景下的表现,这些传统基准往往忽略。

随着 AI 系统在关键领域影响力日益提升,今天建立的基准测试框架,将决定我们能否有效衡量和优化那些远超传统性能指标的社会影响。 第 17 章:可信 AI 的责任原则与 第 18 章:可持续 AI 的可持续性考量,正成为综合系统评测中必须纳入的新维度,与效率和准确率并重。

测验:AI 基准测试

测试你对机器学习系统基准测试核心概念的理解

SPEC Power:2007 年推出,专为服务器能效设计,测量 10%~100% 负载下的性能/瓦。现代服务器能效提升 3~4 倍。 ↩︎

Green500:2007 年起,按 FLOPS/瓦排名超算,最高已达 60 GFLOPS/瓦,较 2000 年代初提升百倍。 ↩︎

ENERGY STAR:1992 年 EPA 推出,累计减少 40 亿吨温室气体排放,为用户节省 4500 亿美元。认证设备能耗比普通型号低 30~65%。 ↩︎

ImageNet:由斯坦福大学的 Fei-Fei Li 于 2007 年创建,包含 1400 万张图像,跨越 2 万个类别,其中 120 万张图像用于年度分类挑战(ILSVRC)。ImageNet 的影响深远:2012 年 AlexNet 以 15.3% 的 top-5 错误率取得突破性进展,而传统方法为 25.8%,成为计算机视觉领域的里程碑。 ↩︎

AlexNet:由多伦多大学的 Alex Krizhevsky、Ilya Sutskever 和 Geoffrey Hinton 开发的 8 层神经网络,彻底改变了计算机视觉领域。使用两块 GTX 580 GPU 训练的 6000 万个参数,使 AlexNet 的神经网络设计创新成为现代 AI 的标准技术。 ↩︎

ResNet:微软的残差网络,由 Kaiming He 等人于 2015 年提出,利用跳跃连接解决了梯度消失问题,使得 152 层以上的网络成为可能。ResNet-50 成为迁移学习的标准,而 ResNet-152 以 3.57% 的 top-5 错误率在 ImageNet 上实现超人类表现,超过了 5% 的人类错误率估计。 ↩︎

张量处理单元 (TPU):谷歌专为神经网络工作负载设计的定制 ASIC,首次秘密部署于 2015 年,2016 年公布。第一代 TPU 在推理时的性能/瓦特比同时期 GPU 高出 15-30 倍,而 TPU v4 节点提供 1.1 exaFLOPS 的 BF16 计算能力(完整节点配置),展示了专用 AI 硬件的强大能力。 ↩︎

专用集成电路 (ASIC):为特定计算任务设计的定制芯片,相较于通用处理器提供更优越的性能与能效。AI ASIC 如谷歌 TPU、特斯拉 FSD 芯片与比特币挖矿 ASIC 在其目标应用中可实现 100-1000 倍于 CPU 的效率,但缺乏对其他工作负载的灵活性。 ↩︎

FLOPS:每秒浮点运算次数,衡量计算性能的指标,表示处理器每秒能执行多少次浮点计算。现代 AI 加速器的 FLOPS 评级很高:NVIDIA A100 提供 312 TFLOPS(万亿次浮点运算)张量操作能力,而高端 CPU 则在 1-10 TFLOPS 之间。FLOPS 测量有助于比较硬件能力,确定 ML 工作负载中的计算瓶颈。 ↩︎

屋顶线模型:加州大学伯克利分校开发的可视化性能模型,将计算强度(FLOPS/字节)与性能(FLOPS/秒)绘制在二维平面上,以识别算法是受限于计算还是内存。模型的“屋顶线”表示理论峰值性能限制,平坦部分表示受限于内存带宽,斜坡部分则显示计算能力限制。该模型有助于优化算法与硬件选择,揭示性能瓶颈。 ↩︎

张量操作:神经网络的多维数组计算,包括矩阵乘法(GEMM)、卷积和逐元素操作。现代 AI 加速器优化了这些原语:NVIDIA 的 Tensor Cores 对于混合精度矩阵乘法(BF16)可实现 312 TFLOPS,而传统 FP32 计算仅为 15-20 TFLOPS,加速比约为 15-20 倍。 ↩︎

cuDNN:CUDA 深度神经网络库,NVIDIA 的 GPU 加速深度神经网络原语库。自 2014 年发布以来,cuDNN 提供了卷积、池化、归一化和激活层的高度优化实现,性能比简单实现提高了 10 倍,成为 GPU 加速深度学习的事实标准。 ↩︎

Sigmoid 函数:一种数学激活函数 S(x) = 1/(1+e^(-x)),将任何实数映射到 0 和 1 之间的值,历史上在早期神经网络中重要。尽管由于指数运算而计算开销较大,并且存在梯度消失问题,但 Sigmoid 函数仍然在二元分类输出层和 LSTM 单元的门控中保持相关性。 ↩︎

Tanh 函数:双曲正切激活函数 tanh(x) = (e^x - e^(-x))/(e^x + e^(-x)),将输入映射到 -1 和 1 之间的值,与 Sigmoid 不同的是其输出是零中心的。尽管计算开销大且仍然会出现梯度消失,但 Tanh 通常在隐藏层中表现优于 Sigmoid,因为其梯度更强且输出范围对称。 ↩︎

LSTM(长短期记忆网络):1997 年由 Hochreiter 和 Schmidhuber 提出的递归神经网络架构,旨在解决传统 RNN 中的梯度消失问题。LSTM 通过门控(遗忘门、输入门、输出门)控制信息流,使其能够学习数百个时间步长的依赖关系,成为序列建模的关键技术,直到变换器的出现。 ↩︎

CIFAR-10:一个包含 6 万张 32×32 彩色图像的 数据集,跨越 10 个类别(飞机、汽车、鸟、猫、鹿、狗、青蛙、马、船、卡车),由多伦多大学的 Alex Krizhevsky 和 Geoffrey Hinton 于 2009 年收集。尽管图像尺寸较小,CIFAR-10 却成为深度学习架构比较的基础数据集,错误率从传统方法的 18.5% 降至 2.6%,实现了重大突破。 ↩︎

SQuAD:斯坦福问答数据集,2016 年推出,包含 10 万个以上的问题 - 答案对,基于维基百科文章。SQuAD 成为阅读理解评估的金标准,人类在该数据集上的表现为 87.4% F1 分数,领先的 AI 系统在 2018 年超过 90%,标志着机器首次在该基准上超过人类表现。 ↩︎

GLUE:通用语言理解评估,包含九个英语句子理解任务,如情感分析、文本蕴含和相似性。2018 年推出的 GLUE 提供了标准化评估,人类基线为 87.1%,但在 2019 年被 BERT 的 80.5% 超越,随之而来的 SuperGLUE 基准更具挑战性。 ↩︎

ToyADMOS:NTT Communications 于 2019 年开发的机器操作声音异常检测数据集,包含玩具车和玩具传送带操作的音频录音。该数据集包括每种机器类型 1000 多个正常样本和 300 多个异常样本,旨在标准化声学异常检测研究,提供可复现的实验条件。 ↩︎

BERT:变换器的双向编码器表示,由谷歌于 2018 年推出,通过在大规模文本语料库上进行掩码语言建模预训练,彻底改变了自然语言处理。BERT-Large 包含 3.4 亿个参数,在 11 项 NLP 任务上取得了最先进的结果,为现代语言模型(如 GPT 和 ChatGPT)奠定了基础。 ↩︎

BLEU 分数:双语评估替代方案,由 IBM 于 2002 年提出,通过比较机器翻译与人工参考翻译之间的 n-gram 重叠,衡量机器翻译质量。BLEU 分数范围为 0-100,分数超过 30 被认为有用,超过 50 为好,超过 60 为高质量。到 2016 年,谷歌翻译在主要语言对上的 BLEU 分数已超过 40。 ↩︎

AUC(曲线下面积,Area Under the Curve):二分类任务常用的性能指标,衡量受试者工作特征曲线(ROC 曲线)下的面积,反映真正例率与假正例率之间的权衡。AUC 取值范围为 0 到 1,0.5 表示随机猜测,0.7-0.8 为可接受,0.8-0.9 为优秀,0.9 以上则代表极佳的区分能力。 ↩︎

泊松分布:一种描述独立事件以恒定平均速率发生频率的数学模型,以法国数学家西蒙·泊松命名(1837 年)。在服务器负载中,泊松分布可准确建模每秒 10-1000 次请求的到达,k 次请求在 t 时间内的概率为 $P(k) = (\lambda t)^k \cdot e^{-\lambda t} / k!$。 ↩︎

Docker:一种将应用及其依赖打包为轻量级、可移植容器的容器化平台,确保在不同环境下的一致执行。自 2013 年以来广泛应用于 ML 基准,消除了“只在我电脑上能跑”的问题,MLPerf 等基准套件也分发官方 Docker 镜像以保证结果可复现。 ↩︎

URLLC:5G 服务类别,要求关键任务应用的可靠性达 99.999%,延迟低于 1ms。 ↩︎

GPT-3:OpenAI 于 2020 年发布的语言模型,拥有 1750 亿参数,训练数据 3000 亿 token,使用 1 万块 NVIDIA V100 GPU 训练数月,成本约 460 万美元(Lambda Labs 估算)。GPT-3 展现了少样本学习、上下文推理等新能力,确立了“规模定律”范式,即更大模型在多任务上持续优于小模型。 ↩︎

混合精度训练:一种同时使用 16 位(FP16)和 32 位(FP32)浮点表示的训练技术,在保持模型准确率的同时加速训练。NVIDIA 于 2017 年推出,现代 GPU 的 Tensor Core 可实现 1.5-2 倍加速,同时内存占用减少约 40%,支持更大批量和更快收敛。 ↩︎

数据并行:最常见的分布式训练策略,每块 GPU 处理不同子批次,随后通过 all-reduce 等方式同步梯度。现代实现可在数百块 GPU 上近线性扩展,但 1000+ GPU 时通信开销成为主要瓶颈。 ↩︎

模型并行:将神经网络不同部分分布到不同 GPU 上,适用于单卡内存无法容纳的大模型。GPT-3 的 1750 亿参数需跨多节点模型并行,即使高内存 GPU 也只能容纳约 400 亿参数(混合精度)。 ↩︎

GPU Boost 时钟:NVIDIA 的动态频率调节技术,在热和功耗条件允许时自动提升 GPU 主频。冷却条件好时可提升 10-30% 性能,持续负载下则下降,导致基准波动。例如 RTX 4090 基础频率 2230MHz,冷却时可升至 2520MHz。 ↩︎

热降频:当温度超过安全阈值(GPU 通常为 83-90°C,CPU 为 100-105°C)时自动降低主频的保护机制。持续 AI 负载下热降频可导致 20-50% 性能损失,因此热管理对基准一致性至关重要。现代芯片每几毫米就有温度传感器,实时监控温度。 ↩︎

神经网络处理器(NPU):专为 AI 工作负载设计的处理器,架构针对神经网络操作优化。现代智能手机 NPU 性能可达 1-15 TOPS,推理同等任务时功耗比 GPU 低 100-1000 倍。 ↩︎

现场可编程门阵列(FPGA):可在出厂后编程实现定制数字电路的芯片。与固定功能 ASIC 不同,FPGA 灵活适配不同算法,对特定 ML 任务能效比 CPU 高 10-100 倍,且可随算法变化调整。 ↩︎

Edge TPU:谷歌为边缘设备设计的超低功耗 AI 加速器,功耗仅 2W,性能达 4 TOPS。Edge TPU 针对 TensorFlow Lite 优化,单价约 25 美元,使大规模分布式 AI 部署成为可能。 ↩︎

FP32:32 位浮点格式,提供约 7 位小数的高数值精度。作为研究和训练的标准格式,FP32 操作消耗最大内存和计算资源,但能确保数值稳定性。现代 GPU 在 FP32 下可达到 15-20 TFLOPS,作为精度比较的基准。 ↩︎

FP16:16 位浮点格式,与 FP32 相比内存使用量减半,同时保持合理的数值精度。现代 AI 加速器广泛支持 FP16,在大多数深度学习模型中,FP16 可实现 2-4 倍于 FP32 的速度提升,且准确率损失较小,成为推理和混合精度训练的首选格式。 ↩︎

INT8:8 位整数格式,提供最大内存和计算效率,仅需 FP32 存储的 25%。通过后训练精度降低为 INT8 可实现 4 倍内存缩减和 2-4 倍于专用硬件的加速,但需仔细校准以最小化准确率下降,通常保持原始模型性能的 95-99%。 ↩︎

模型压缩:通过降低数值精度、结构优化、知识迁移和张量分解等技术,减少模型大小和计算需求。可实现 10-100 倍的体积缩减,同时保持 90-99% 的原始准确率。 ↩︎

无服务器 AI:一种云计算范式,将 ML 模型作为函数部署,自动扩展以处理传入请求,用户仅为实际推理时间付费。流行的平台如 AWS Lambda、Google Cloud Functions 和 Azure Functions 支持无服务器 AI,但大型模型的冷启动延迟可能为 1-10 秒,影响用户体验。 ↩︎

MLCommons:一个非营利组织,成立于 2018 年(最初为 MLPerf),旨在制定机器学习基准标准。由包括 Google、NVIDIA、Intel 和 Facebook 在内的 40 多家行业领导者管理,MLCommons 已建立起云到边缘部署 AI 性能测量的事实标准。 ↩︎

DLRM(深度学习推荐模型):Facebook 于 2019 年发布的个性化推荐神经网络架构,将分类特征通过嵌入表与连续特征通过多层感知机相结合。DLRM 模型可能包含 100+ 亿参数,嵌入表可能占用数 TB 内存,因此需要针对稀疏矩阵操作进行专门的硬件优化,以满足推荐系统工作负载的需求。 ↩︎

硬件彩票:指算法进步很大程度上受限于是否与现有硬件兼容。例如,Transformer 架构因矩阵乘法与 GPU 完美匹配而大获成功,而图神经网络等架构因难以高效映射到 GPU 而被低估。这意味着部分“突破性”算法只是硬件友好,而非本质优越。 ↩︎

古德哈特定律:1975 年由英国经济学家 Charles Goodhart 提出,“一旦某项指标成为目标,它就不再是好的指标”。在 ML 基准中,这揭示了用基准作为系统质量代理与将其作为优化目标之间的根本张力。基准一旦成为优化对象,其作为系统有效性代理的价值就会下降。 ↩︎ ↩︎