第 17 章:可信 AI

目标

为什么负责任的 AI 实践已从可选的伦理考量,演变为决定系统可靠性、合规性和商业可行性的强制性工程要求?

现实环境中的机器学习系统面临远超算法准确性的严苛可靠性要求。偏见预测会引发法律责任,不透明的决策阻碍监管批准,不可问责的系统难以通过审计,不可解释的输出削弱用户信任。这些运营现实将负责任的 AI 从哲学理想转变为决定系统能否在生产环境中部署、维护和扩展的具体工程约束。负责任的 AI 实践为构建满足监管要求、通过第三方审计、维护用户信心并能在多样化人群和场景下可靠运行的系统,提供了系统化方法论。现代 ML 工程师必须将偏见检测、可解释性机制、问责框架和监督系统作为核心架构组件集成。将负责任的 AI 视为一门工程学科,有助于构建既具备技术性能又能在日益受监管的部署环境中实现可持续运营的系统。

学习目标

将公平性、透明性、可问责性、隐私和安全性定义为可度量的工程要求,约束系统架构、数据处理和部署决策

使用 Fairlearn 等工具实现偏见检测,识别模型在不同群体间的性能差异,并评估包括人口统计平等和机会均等在内的公平性指标

应用差分隐私、联邦学习和机器遗忘等隐私保护方法,在保障数据安全的同时保持模型效用

利用 SHAP、LIME、GradCAM 等后验解释技术为模型预测生成解释,并评估其在不同模型架构下的计算成本与可靠性

分析部署环境(云、边缘、移动、TinyML)如何带来架构约束,限制可实现的负责任 AI 保护措施

评估负责任 AI 原则间的权衡,理解数学不可能定理何时阻止所有公平性标准的同时最优化

设计将负责任 AI 原则转化为运营实践的组织结构和治理流程,包括角色定义、升级路径和问责机制

评估负责任 AI 技术的计算开销与公平性影响,理解资源需求如何成为不同组织实施伦理 AI 的障碍

可信 AI 简介

2019 年,亚马逊因发现其招聘算法系统性地歧视女性候选人而废弃了该系统。尽管该系统在技术上看似先进,但它学习到的“成功候选人”主要是男性,反映了历史性性别偏见而非基于能力的标准。该模型在统计上最优,却在伦理上灾难,说明技术正确性与社会危害可能并存。

这一事件揭示了可信 AI 的核心挑战:系统可以在算法上无懈可击,却在现实中延续不公,优化目标的同时违背价值观,满足性能基准却辜负社会。问题不仅限于个体偏见,还涉及透明性、问责性、隐私和安全等影响数十亿人的系统性议题。

机器学习系统工程学科正是为解决技术卓越与社会影响深度交汇的关键节点而发展。前文 第 3 章:深度学习基础、第 8 章:AI 训练、第 2 章:机器学习系统 等章节为具备强大能力和广泛影响力的系统奠定了计算基础。然而,随着这些系统在医疗诊断、司法决策、招聘筛选和金融服务等领域扮演日益重要角色,仅靠技术性能指标已难以为继。现代机器学习系统面临的根本挑战在于:它们可能在统计上最优,却产生与公平、透明和社会正义相悖的结果。

本章开启第五部分“可信系统”,将分析框架从技术正确性扩展到系统是否值得社会信任和接受的规范性问题。与“稳健 AI”关注对抗攻击和硬件故障等系统完整性威胁不同,负责任 AI 关注的是系统在正常运行时能否产出符合人类价值和集体福祉的结果。

这一学科将抽象伦理原则转化为具体工程约束和设计要求。正如安全协议需要特定架构决策和监控基础设施,负责任 AI 也要求通过可量化的技术机制和可验证的系统属性来实现公平、透明和问责。这标志着工程方法论的扩展,将规范性要求作为一等设计考量,而非将哲学理念简单套用到工程实践。

软件工程为这种学科演进提供了先例。早期计算系统关注功能正确性,即程序能否输出正确结果。随着系统复杂度和社会融合度提升,业界发展出可靠性工程、安全保障和可维护性分析等方法。现代负责任 AI 实践正是类似的学科成熟,将系统化工程方法扩展到算法决策的社会与伦理维度。

这种扩展反映了当代机器学习部署的前所未有的规模。这些系统如今主导着信贷分配、医疗诊断、教育评估和刑事司法等影响数十亿人的决策。与传统软件故障表现为崩溃或数据损坏不同,负责任 AI 失效可能导致系统性歧视、损害民主制度、削弱公众对技术的信心。该领域要求系统不仅技术过硬,还需具备伦理问责和社会责任。

负责任 AI 定义

负责任 AI 是一门_系统化工程学科_,将_伦理原则转化为机器学习系统的具体设计要求和可度量系统属性_。它涵盖_公平性_(确保不同群体结果公正)、透明性(让系统决策可理解)、问责性(明确结果责任归属)、隐私(保护敏感信息)和_安全性_(防止伤害)。负责任 AI 将这些原则视为_一等工程约束_,指导架构决策、数据处理和运营流程,确保系统在实现技术目标的同时,赢得_社会信任与接受_。

负责任 AI 作为一门系统工程学科,包含四个相互关联的维度。本章将探讨伦理原则如何转化为可度量的系统要求,分析检测和缓解有害算法行为的技术方法,解释为何负责任 AI 超越单一系统,涉及更广泛的社会技术动态,并讨论在组织和监管环境下的实际落地挑战。

学习者需同时具备技术能力和情境理解力。你将学习如何实现偏见检测算法和隐私保护机制,同时理解为何技术方案需要组织治理结构和利益相关方参与流程。内容涵盖提升系统可解释性和问责性的技术方法,并探讨算法无法彻底解决的价值冲突。

本章将建立一套分析框架,帮助工程师同时兼顾即时功能需求与长期社会考量。该框架将负责任 AI 视为现代人工智能开发中不可或缺的工程原则,而非对既有系统的补充约束。

章节导航

负责任 AI 涉及四个互补视角,缺一不可:

1. 原则与基础:定义负责任 AI 系统应达成的目标。将公平、透明、问责、隐私和安全作为工程要求,分析这些原则在云、边缘、移动和 TinyML 部署中的不同表现及理想与现实的张力。

2. 技术实现:介绍实现负责任 AI 的具体技术,包括偏见与漂移检测、隐私保护、对抗防御和可解释性验证等,将抽象原则转化为可度量的系统行为。

3. 社会技术动态:说明为何仅有技术正确性远远不够。探讨系统与环境的反馈回路、人机协作挑战、利益相关者价值冲突、可争议性机制和组织治理结构。负责任 AI 存在于算法、组织与社会的交汇处。

4. 实践现实:分析原则如何落地,包括组织障碍、数据质量约束、目标冲突、可扩展性挑战和评估缺口。以 AI 安全和价值对齐为自主系统的终章。

本章内容全面,因为负责任 AI 涉及工程、伦理、政策和组织设计。可按需查阅各节,但要认识到,负责任 AI 的有效落地需整合四个视角。单靠技术无法解决价值冲突,伦理原则若无技术实现则流于理想,单点干预若无组织支持也难以持续。

这些原则和实践为构建既能满足当前需求、又能促进长期社会福祉的 AI 系统奠定基础。将公平、透明、问责、隐私和安全作为工程要求而非事后补丁,工程师才能发展出确保 ML 系统造福社会、最小化风险的技术能力和组织方法。这种系统化方法将抽象伦理原则转化为贯穿机器学习全生命周期的具体设计约束。

核心原则

负责任 AI 指有意识地坚持伦理原则、促进社会福祉的机器学习系统开发与部署。这些原则不仅是政策理想,更是对系统设计、实现和治理的具体约束。

公平性要求机器学习系统不得基于受保护属性1(如种族、性别、社会经济地位等)歧视个人或群体。该原则既包括统计指标,也涵盖更广泛的公平、正义和结构性偏见问题。公平性的数学定义详见第 17 章:可信 AI。

实现负责任 AI 的计算资源需求带来了超越单一系统设计的公平性考量,包括访问门槛和环境正义等问题,详见后文部署约束与落地障碍。

可解释性关注利益相关方能否理解模型如何产生输出,既包括单个决策的解释(事后解释2),也包括整体行为模式。不同神经网络架构(见第 4 章:DNN 架构)的可解释性差异巨大,越深的网络越难解释。可解释性对错误分析、合规和用户信任至关重要。

透明性指公开 AI 系统的构建、训练、验证和部署过程,包括数据来源、设计假设、系统局限和性能特征。可解释性关注输出,透明性则涵盖系统全生命周期。

问责性指通过可追溯、文档化、审计和补救机制,确保个人或组织对 AI 系统结果负责。问责性确保 AI 失效不是抽象故障,而是有现实影响的后果。

价值对齐3要求 AI 系统追求与人类意图和伦理规范一致的目标,既涉及奖励设计和约束规范等技术挑战,也涉及价值观代表性等更广泛问题。

人类监督强调在自动决策中保留人类判断,包括运行时“人在环中”4和组织结构保障 AI 使用符合社会价值与现实复杂性。

隐私和稳健性等原则需专门技术实现,贯穿系统设计的安全与可靠性考量。

原则在 ML 生命周期中的集成

负责任机器学习以公平、透明、问责、隐私和安全等原则为基础,定义 AI 系统的伦理与可预测行为。这些原则不是抽象理想或事后补丁,而是需转化为具体约束,指导模型训练、评估、部署和维护。

落地这些原则需理解每一项对系统行为的具体要求。公平性关注模型对不同群体的待遇及历史偏见响应;可解释性确保开发者、审计员和用户能理解模型决策;隐私规范数据收集与使用;问责性定义责任分配、跟踪和执行;安全性要求模型在不确定环境下也能可靠运行。

| 原则 | 数据采集 | 模型训练 | 评估 | 部署 | 监控 |

|---|---|---|---|---|---|

| 公平性 | 代表性采样 | 偏见感知算法 | 群体级指标 | 阈值调整 | 子群体性能 |

| 可解释性 | 文档标准 | 可解释架构 | 行为分析 | 用户可见解释 | 解释质量日志 |

| 透明性 | 数据源追踪 | 训练文档 | 性能报告 | 模型卡 | 变更追踪 |

| 隐私 | 同意机制 | 隐私保护方法 | 隐私影响评估 | 安全部署 | 访问审计日志 |

| 问责性 | 治理框架 | 决策日志 | 审计追踪 | 覆盖机制 | 事件追踪 |

| 稳健性 | 质量保证 | 鲁棒训练方法 | 压力测试 | 故障处理 | 性能监控 |

这些原则协同定义了机器学习系统的负责任行为,不是孤立特性,而是跨生命周期的系统级约束。表 1 展示了公平性、可解释性、透明性、隐私、问责和稳健性等关键原则如何映射到数据采集、模型训练、评估、部署和监控等主要开发阶段。有些原则(如公平性、隐私)从数据阶段开始,另一些(如稳健性、问责)在部署和监督中最为关键。可解释性虽常在评估和用户交互中强调,也支持模型调试和设计时验证。这种全流程映射强化了负责任 AI 是多阶段架构承诺,而非事后补救。

资源需求与公平性影响

实现负责任 AI 原则需消耗大量计算资源,不同技术和部署场景下差异显著。这些资源需求带来多层次的公平性考量,超越单一组织,涉及社会和环境正义。资源有限的组织难以全面实施负责任 AI 保护,导致伦理保障的可及性差异。先进 AI 系统日益依赖专用硬件和高速网络,系统性地将农村、发展中地区和资源受限用户排除在外。

环境正义问题进一步加剧了访问壁垒。差分隐私模型训练需额外 15-30% 计算,实时公平监控增加 10-20ms 延迟和持续 CPU 占用,SHAP 解释需 50-1000 倍常规推理算力。这些计算需求直接转化为基础设施压力:为 1000 万用户提供负责任 AI 功能的高并发系统,所需数据中心容量远超无约束模型。

这些基础设施的地理分布带来系统性不平等。AI 工作负载数据中心集中在电价低、监管宽松的地区,这些地区往往与低收入社区重叠,承受更多污染、热量和电网压力,却常常缺乏访问 AI 服务所需的高速网络。这形成了“计算公平性”反馈回路,工程师在系统设计时必须考虑基础设施选址对系统性能和社区福祉的影响。具体技术的性能特征详见第 17 章:可信 AI。

透明性与可解释性

本节详细探讨具体原则。机器学习系统常因不可解释性受到批评,许多模型如“黑箱”般难以让用户、开发者和监管者理解或审查。这种不透明性严重阻碍信任,尤其在刑事司法、医疗、金融等高风险领域。例如,美国 COMPAS 算法被发现存在种族偏见5,但系统的专有性质和可解释性工具的缺乏,阻碍了问题调查和修正。

可解释性是理解模型如何做出预测的能力,包括_局部解释_6(单个预测)和_全局解释_7(整体行为)。透明性则涵盖系统设计和运行的公开,包括数据来源、特征工程8、模型架构、训练流程、评估协议和已知局限,还包括用例、系统边界和治理结构的文档化。

可解释性和透明性的重要性超越技术考量,已成为法律义务。例如,欧盟 GDPR 要求个人有权获得自动决策的“有意义信息”9。类似法规在全球兴起,强化了将可解释性和透明性作为架构要求的必要性。

实现这些原则需预判不同利益相关方的需求,相关价值冲突详见第 17 章:可信 AI。设计可解释性和透明性需决定何时何地向系统各阶段暴露关键信息。

这些原则也支撑系统的长期可靠性。模型重训练或更新时,可解释性和可追溯性机制有助于发现异常、定位根因和支持治理。将透明性和可解释性嵌入系统结构和运行流程,是赢得信任、监督和契合社会期望的基础。

机器学习中的公平性

机器学习中的公平性极具挑战性。如第 17 章:可信 AI所述,公平性要求自动系统不得对受保护群体造成不成比例的不利影响。由于系统训练于历史数据,极易复制和放大数据中固有的系统性偏见10。若设计不当,ML 系统可能无意中强化社会不公。

医疗领域有一著名案例。美国医院用于分配护理资源的算法,系统性低估黑人患者需求。模型以医疗支出为健康状况代理变量,但因历史性医疗支出差异,黑人患者支出较低,模型据此推断其病情较轻,实际却常需更多护理。该案例说明,看似中立的代理变量选择若未考虑历史不公,易导致歧视性结果。

面对偏见风险,工程师需形式化方法评估公平性。业界已提出一系列数学标准,量化模型在敏感属性群体间的表现。

在介绍正式定义前,先思考根本问题:什么是公平?应一视同仁,还是考虑不同基础条件?应追求结果平等、机会平等还是待遇平等?这些问题对应不同数学标准,各自反映公平性的不同侧面。

下文用概率符号介绍正式定义(人口统计平等、机会均等、均等机会),这些指标贯穿 ML 公平性文献并影响监管框架。重点理解直觉:每个指标衡量什么、为何重要,数学证明可后读。每条定义后有实际案例,便于理解。若不熟悉概率符号,可先读文字描述,后回头看公式。

人口统计平等

要求获得正向预测的概率与群体无关。形式化为: $$ P\big(h(x) = 1 \mid S = a\big) = P\big(h(x) = 1 \mid S = b\big) $$

即模型对敏感属性 $S$ 的不同子群体,赋予正向结果(如贷款批准、治疗推荐)的概率相等。

在医疗案例中,人口统计平等要求黑人和白人患者被推荐护理的比例相同,无论实际健康状况如何。表面上看似公平,但忽略了实际需求差异,可能矫枉过正。

这一局限促使更细致的公平标准出现。

机会均等

要求模型预测在给定真实标签下与群体无关,具体为真阳性率和假阳性率在各群体间相等: $$ P\big(h(x) = 1 \mid S = a, Y = y\big) = P\big(h(x) = 1 \mid S = b, Y = y\big), \quad \text{for } y \in {0, 1}. $$

即对每个真实结果 $Y = y$,模型在 $S = a$ 和 $S = b$ 间应有相同预测分布,确保错误(漏判和误判)均匀分布。

在医疗案例中,机会均等确保实际健康状况相同的患者(真实标签 $Y$ 相同),无论种族,都有相同被推荐护理的概率。原算法未满足此标准,导致黑人患者真阳性率低于白人。

更宽松的标准只关注正向结果。

均等机会

是机会均等的放宽版,仅关注真阳性率。要求在应获正向结果者中,各群体获得正向结果的概率相等: $$ P\big(h(x) = 1 \mid S = a, Y = 1\big) = P\big(h(x) = 1 \mid S = b, Y = 1\big). $$

即对 $Y = 1$ 的个体,模型在各群体间一视同仁。

在医疗案例中,该标准确保真正需要护理的黑人和白人患者被模型识别的概率相等。美国医院算法因以医疗支出为代理变量,导致黑人患者即使病重也难以获得护理,未满足均等机会。

案例:公平性指标计算

假设某贷款模型在 200 名申请人(A、B 两组各 100 人)上评估,后续观察实际还款结果:

A 组(100 人):

- 模型批准:70 人(40 人实际还款,30 人违约)

- 模型拒绝:30 人(5 人本可还款,25 人本会违约)

B 组(100 人):

- 模型批准:40 人(30 人实际还款,10 人违约)

- 模型拒绝:60 人(20 人本可还款,40 人本会违约)

人口统计平等: \begin{gather*} P(h(x) = 1 \mid S = A) = \frac{70}{100} = 0.70 \ P(h(x) = 1 \mid S = B) = \frac{40}{100} = 0.40 \end{gather*}

差异: $0.70 - 0.40 = 0.30$(30 个百分点差距)

模型批准 A 组比例远高于 B 组,未满足人口统计平等。

均等机会(真阳性率):

对实际会还款者(Y=1): \begin{gather*} P(h(x) = 1 \mid S = A, Y = 1) = \frac{40}{40 + 5} = \frac{40}{45} \approx 0.89 \ P(h(x) = 1 \mid S = B, Y = 1) = \frac{30}{30 + 20} = \frac{30}{50} = 0.60 \end{gather*}

差异: $0.89 - 0.60 = 0.29$(真阳性率差 29 个百分点)

模型未满足均等机会:A 组合格者获批率 89%,B 组仅 60%。

机会均等(真阳性率 + 假阳性率):

已算出 TPR,现算假阳性率(实际不会还款 Y=0): \begin{gather*} P(h(x) = 1 \mid S = A, Y = 0) = \frac{30}{30 + 25} = \frac{30}{55} \approx 0.55 \ P(h(x) = 1 \mid S = B, Y = 0) = \frac{10}{10 + 40} = \frac{10}{50} = 0.20 \end{gather*}

模型假阳性率也不等:A 组违约者获批 55%,B 组仅 20%。说明模型对 A 组更“宽容”。

结论: 该模型三项公平性标准均未达标。优化一项不等于满足其他,甚至可能冲突,下文详述。

这些公平性标准揭示了算法公平性的张力。

进阶话题:不可能定理

下述不可能定理为公平性理论前沿。重点理解:多项公平性标准无法同时满足,比数学证明更重要。核心观点:公平性本质上是需利益相关方协商的价值决策,而非单一技术最优问题。对大多数工程师而言,理解这一点已足够。

认识到这些张力,实际系统必须将公平性作为全流程约束,贯穿数据采集、目标选择、模型阈值和反馈机制。例如,排序模型与分类模型即使用同一数据,也会导致不同群体访问模式。

公平性指标有助于形式化目标,但常局限于预设人口类别,难以覆盖现实中的交叉身份。原则性公平性需兼顾多维群体,确保模型在未明确定义的子群体间也表现一致。最新研究强调对多样群体的预测可靠性,强化了公平性是系统级要求而非局部调整。这一扩展视角要求架构、评估和监控策略支持更细致、情境敏感的模型行为评估。

公平性考量还延伸到负责任 AI 技术的计算资源和基础设施。环境正义等更广泛公平性问题出现于高能耗 AI 基础设施集中于弱势社区时11。

负责任 AI 技术的高计算强度造成数字鸿沟,公平、透明、可问责的 AI 系统的可及性取决于经济资源。公平性约束、差分隐私和可解释性工具通常比无约束模型多消耗 15-40% 计算资源。结果是,只有资源充足的组织才能负担真正的负责任 AI,资源有限的部署则可能牺牲伦理保障以换取效率,形成“负责任 AI 特权”,加剧不平等。这些资源约束带来民主化挑战,影响弱势群体的数字权益。

这些考量指向根本结论:公平性是数据工程、建模、评估和决策政策交互作用的系统属性,无法靠单一模型或事后补救解决。负责任 ML 设计需将公平性作为基础约束,贯穿架构、流程和治理。其他原则同理:公平性需群体级指标和差异化阈值;可解释性需运行时算力预算(梯度法 10-50ms,SHAP 50-1000 倍开销);隐私涵盖数据治理、同意机制和生命周期管理;问责性需模型注册、审计日志和人工覆盖机制。

这些原则在开发全流程中相互作用并产生张力。隐私保护可能降低可解释性;公平性约束可能与个性化冲突;鲁棒监控增加计算成本。表 1 展示了各原则在数据采集、训练、评估、部署和监控阶段的体现,强化了负责任 AI 是架构承诺而非事后补救。但原则落地的可行性高度依赖部署环境:云、边缘、移动和 TinyML 各有不同约束,决定了可实现的负责任 AI 功能。

隐私与数据治理

隐私与数据治理的挑战远超第 15 章:安全与隐私中的威胁建模视角,并与前述公平性和透明性原则形成根本张力。安全导向的隐私关注“如何防止未授权访问”,负责任隐私则问“是否应采集这些数据,如何最小化全生命周期暴露”。这带来内在冲突:公平性监控需采集敏感数据,可解释性方法可能泄露训练样本,全面透明性可能侵犯个人隐私。负责任 AI 必须通过权衡设计,平衡保护、问责和效用。

ML 系统常依赖大量个人数据训练和个性化功能,这带来用户隐私、数据保护和伦理责任。数据质量与治理(见第 6 章:数据工程)直接影响负责任 AI 的可实现性。负责任设计将隐私视为核心约束,贯穿系统全生命周期。

支持隐私的核心挑战在于数据效用与个人保护的权衡。高分辨率数据提升模型准确性和适应性,但也加大敏感信息泄露风险,尤其在数据聚合或与外部数据关联时。例如,基于对话或医疗记录训练的模型,已被证明可记忆并泄露训练细节。

隐私挑战还涉及看似无害的数据。可穿戴设备采集的生理和行为信号(如心率、位置)单独看似无害,合并后却可拼出详细用户画像。用户对数据处理、保留和传输的可见性和控制权有限,风险进一步加剧。

应对这些挑战需将隐私作为系统原则,落实到数据治理,包括采集内容、条件、同意和透明度。基础数据工程实践(见第 6 章:数据工程)为治理要求提供技术基础。治理需关注标注、访问控制、日志和合规,约束数据流动并记录责任。

下图展示了数据管道早期的隐私关键节点,标明同意、加密和差分隐私等核心保护措施的应用点。实际实现更复杂,但该流程图有助于识别隐私风险和设计防护措施。

治理薄弱的后果已屡见不鲜。基于不透明或偏见数据训练的系统可能延续结构性不公或无意泄露敏感属性。COMPAS 案例中,数据来源和用途不透明阻碍了评估和补救。临床应用中,数据集常因缺失值或人口偏斜影响性能和隐私。若无数据质量和文档标准,这些漏洞将成为系统性风险。

隐私不是孤立算法或数据处理者的责任,而是系统结构属性。包括同意采集、数据保留、模型设计和可审计性在内的决策,共同决定 ML 管道的隐私态势。这要求在训练、推理和运行各阶段预判风险。成员推断攻击12等威胁凸显了在模型架构和接口层面嵌入隐私保护的必要性。

法律框架日益强化这一理解。GDPR、CCPA13、APPI 等法规对数据最小化、目的限定、用户同意和删除权提出具体要求,将伦理期望转化为可执行设计约束,强化了将隐私作为系统开发核心原则的必要性。

综上,ML 中的隐私是系统级承诺,需技术与组织协作,确保数据使用契合用户期望、法律要求和社会规范。负责任设计应从架构、接口和模型全流程集成隐私,而非将其视为功能与隐私的权衡。

安全与稳健性是负责任 AI 的另一关键维度。

安全与稳健性

安全与稳健性(见第 16 章:稳健 AI)不仅是应对硬件故障、对抗攻击和分布漂移的技术属性,也是负责任 AI 的原则。技术稳健性确保系统能抵御攻击,负责任稳健性则要求系统即使在技术上正常,也能符合人类期望和价值。模型可能对位翻转和对抗扰动鲁棒,却在边界场景下不可控失效,或目标与用户福祉不符。

ML 安全指模型在正常和异常条件下都能可预测运行,稳健性则关注模型在输入、环境或配置变化下的稳定性。两者是安全关键领域负责任部署的基础。

实现安全与稳健性需预判系统可能遇到的各种情况,设计能在训练分布外也可靠的行为。这不仅包括输入变化,还包括模型对异常相关性、罕见事件和恶意攻击的响应。例如,自动驾驶系统的失效揭示了目标检测局限和自动化依赖可能导致的危害,即使模型在测试条件下表现良好。

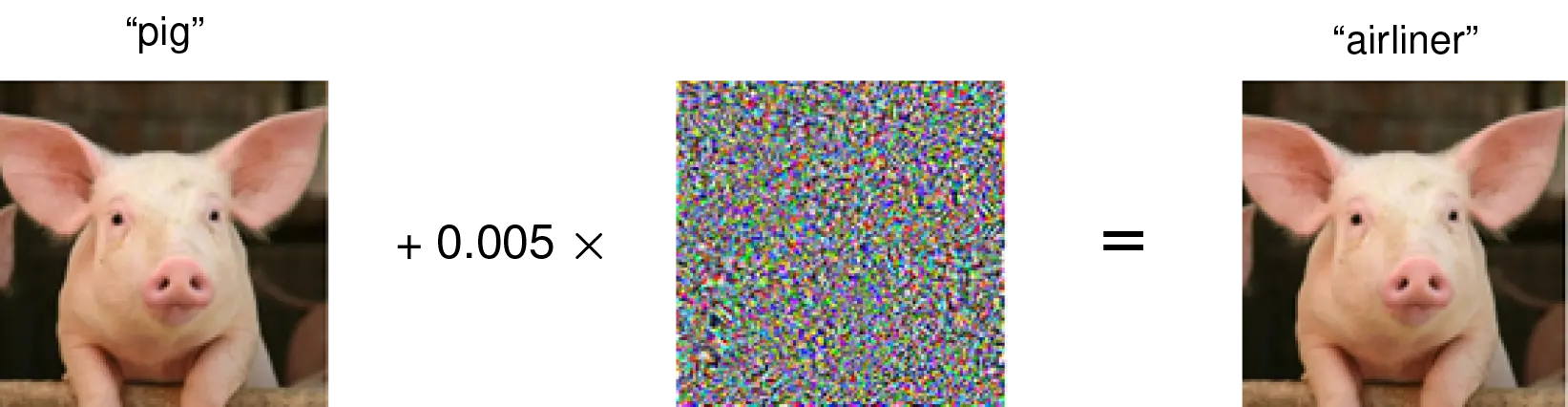

典型失效模式是对抗输入14:对人类无害但能误导模型的精细扰动。这类漏洞不限于图像分类,已在音频、文本和结构化数据等多模态中发现,暴露了高维空间下学习表示的脆弱性。应对需专门的对抗防御和稳健性技术,强调稳健性是全局系统属性。

相关挑战还有分布漂移:训练数据与部署环境不可避免的不匹配。季节性、人口变化、传感器老化或环境变化都可能导致模型可靠性下降。应对需系统化检测和适应机制。分布漂移下的失效可能影响下游决策,带来超越准确率的安全风险。在医疗、金融、交通等领域,这些风险不是假设,而是现实后果。

负责任 ML 设计将稳健性视为系统性要求,需超越单一模型性能,设计能预判不确定性、暴露局限和支持降级行为的系统。包括置信度阈值、拒绝决策和人类监督等机制,确保系统优雅降级而非无声失效。

这些模型级考量还需扩展到架构和组织层面。模型监控、失效检测和更新治理等决策,均影响系统能否应对变化。负责任设计要求将稳健性作为系统整体行为的约束。

系统级安全与稳健性引出问责与治理问题。

问责与治理

ML 问责性指能识别、归因和应对自动决策后果的能力,超越失效诊断,确保系统行为责任明确、可补救、伦理标准可监督。若无此机制,即使善意系统也可能造成重大伤害且无追责,损害信任和合法性。

与传统软件责任归属明确不同,ML 问责性是分布式的。模型输出受数据采集、目标设定、管道设计、接口行为和反馈机制等多方影响,涉及技术、法律和组织多方。例如,招聘平台若产生偏见,责任不仅在模型开发者,还包括数据提供者、界面设计者和部署机构。负责任设计需明确映射和治理这些关系。

治理不足会阻碍机构识别和纠正有害行为。Google Flu Trends 因模型假设和更新策略不透明,外部难以评估,最终被弃用。

法律框架日益强化问责设计。伊利诺伊州 AI 视频面试法案、欧盟 AI 法案等要求高风险应用的透明、同意、文档和监督。这些政策将问责嵌入系统结果和运营流程。内部改革如公平性审计和广告系统使用限制,说明监管压力可推动治理结构变革。

问责设计需全流程可追溯,包括数据溯源、模型版本、人工覆盖和日志留存。模型卡15和数据表16等工具标准化了系统行为文档化。但问责不仅是文档,还需反馈、争议和补救机制。

组织内部,治理结构如伦理审查、跨部门审计和模型风险委员会,有助于预判影响和应对新问题。这些结构需基础设施支持,如允许用户争议和开发者修正的系统,尤其在高风险领域。

架构决策同样重要。界面可设计为暴露不确定性、允许升级或暂停自动操作。日志和监控管道需检测伦理漂移,如子群体性能下降或反馈回路。分布式系统难以统一可观测性,需通过安全协议、更新约束或可信组件嵌入问责。

治理不等于集权,而是责任分布透明、可操作、可持续。技术团队、法律专家、用户和管理者都需有工具和信息评估系统行为并及时干预。随着 ML 系统日益复杂和基础设施化,问责性必须成为架构和流程的基础考量,而非事后补丁。

尽管有治理机制,问责仍面临区分合理与伪相关决策的挑战,需关注数据质量、特征选择和持续监控,确保自动决策反映公正而非历史偏见。

上述原则和技术为负责任 AI 奠定了概念和技术基础,但实际落地高度依赖部署架构。云端可支持复杂 SHAP 解释和实时公平监控,TinyML 设备则需静态可解释和编译时隐私保障。边缘部署便于本地隐私保护,但限制全局公平评估。这些架构约束不是细节,而是决定不同用户和应用可获得哪些负责任 AI 保护的根本因素。

不同部署环境下的负责任 AI

由于计算、连接性和治理等约束条件不同,负责任 AI 原则在各类部署环境中的体现也各不相同。云端系统支持全面监控和复杂的可解释性方法,但数据聚合带来隐私风险。边缘和移动端部署则强化了数据本地性,但限制了部署后的可观测性。TinyML 系统受限最严重,只能依赖静态验证,无法在运行时调整。理解这些部署特定的权衡,有助于工程师在架构约束下最大化负责任 AI 的保护能力。

这些架构差异不仅影响技术可行性,还决定了责任在系统各组件间的分配方式。资源可用性、延迟约束、用户界面设计以及连接性的有无,都影响负责任 AI 原则能否在不同部署场景下得到一致执行。第 2 章:机器学习系统中讨论的部署策略和系统架构,为理解如何在多样环境下实现负责任 AI 奠定了基础。

除了技术约束外,算力资源的地理和经济分布也为负责任 AI 部署带来了更多公平性问题。高性能 AI 系统通常需要靠近大型数据中心或高速网络,这导致服务质量差异与既有社会经济不平等高度相关。农村、发展中地区和经济弱势区域,常因网络延迟、带宽受限和远离算力基础设施而体验到更差的 AI 服务质量17。这种基础设施鸿沟意味着,实时可解释性、持续公平监控和隐私保护计算等负责任 AI 原则,在这些场景下实际上难以落地。

理解部署如何塑造公平性、可解释性、安全、隐私和问责的实际环境,对于设计在真实世界中稳健、对齐且可持续的机器学习系统至关重要。

系统可解释性

首先详细探讨可解释性原则,其在机器学习系统中的可行性极大受部署环境影响。虽然模型架构和解释方法很重要,但系统级约束(如算力、延迟、界面设计和数据可访问性)才决定了某环境下能否支持可解释性。这些约束在云平台、移动设备、边缘系统和深度嵌入式部署间差异巨大,影响了解释的形式和时机。

在高资源环境(如云端),可用 SHAP、LIME 等技术生成详细的事后解释,即使需要多次前向推理或采样。这些方法在对延迟敏感或资源受限场景下往往难以落地,解释必须轻量且快速。移动或嵌入式系统更适合基于显著性图18或输入梯度的方法,通常只需一次反向传播。TinyML 部署下,运行时解释几乎不可行,开发阶段的静态检查成为保障可解释性的唯一机会。模型压缩和优化常与可解释性需求冲突,简化模型未必更易解释。

延迟和交互性也影响解释的呈现方式。实时系统(如无人机、自动化工业控制)运行期间无法展示或计算解释,主要策略是记录内部信号或置信度供事后分析。相反,异步交互系统(如金融风控、医疗诊断)可在决策后提供更深入的延迟解释。

受众需求也影响设计选择。终端用户通常需要简洁、直观、具备情境意义的解释。例如,移动健康应用会用“睡眠时心率升高”而非抽象模型细节。开发者、审计员和监管者则需归因图、概念激活或决策轨迹等内部解释,便于调试、验证或合规审查,这些需通过开发接口或模型开发流程暴露。

可解释性还贯穿系统全生命周期。开发阶段用于诊断、特征审计和概念验证;部署后则转向运行时行为监控、用户沟通和失败案例分析。TinyML 等无法运行时解释的系统,设计时验证尤为重要,需在模型构建阶段预防下游可解释性失效。

将可解释性作为系统设计约束,意味着从一开始就为可解释性留出资源,并与延迟预算、能耗约束和界面限制等其他部署需求平衡。负责任的系统设计不仅追求预测性能,还要确保利益相关方能在部署环境的实际限制下理解和评估模型行为。

公平性也面临类似的部署特定挑战。

公平性约束

公平性虽可形式化定义,但其落地受部署约束影响,与可解释性面临的挑战类似甚至更复杂。数据可见性、模型个性化、算力、监控和再训练基础设施的差异,决定了公平性在不同系统架构下的评估、执行和持续保障方式。

关键因素之一是数据可见性。云端等中心化环境下,开发者通常能获取带人口属性的大型数据集,可用群体级公平性指标、偏见感知训练和事后审计。去中心化部署(如联邦学习19客户端、移动应用)因隐私或数据碎片化,难以获得全局统计。端上学习面临独特挑战,单设备难以了解全局人口分布,公平性干预需在训练或数据集策划阶段嵌入,部署后难以评估。

个性化和自适应机制也影响公平性权衡。全局模型可追求群体间平等,端上自适应模型(如健康监测、推荐引擎)则更关注个体公平,确保相似用户待遇一致。但缺乏清晰相似性度量或代表性数据时,难以实现。基于本地行为再训练的个性化系统,若边缘用户数据稀疏或噪声大,易加剧既有差异。

实时和资源受限环境进一步限制公平性保障。嵌入式、可穿戴或实时控制平台通常无法运行时监控公平性或动态调整阈值,需通过保守设计(如平衡训练目标、静态评估子群体性能)在部署前预防。例如,低功耗可穿戴语音识别系统需在设计时确保不同口音下的稳健性,因部署后无法再校准。

决策阈值和系统策略也影响实际公平性。即使模型在各群体间表现相近,统一阈值若分数分布不同,仍会导致不平等。例如,移动贷款审批系统若不考虑群体特定阈值,可能系统性低批某一群体。此类决策需提前推理、论证并嵌入系统策略。

长期公平性还受反馈动态影响。基于用户行为再训练的系统(如排序、推荐、自动决策管道)若反馈回路管理不善,易放大历史偏见。例如,招聘平台若偏好特定院校,基于历史结果再训练会加剧不平等。需治理机制贯穿训练、部署监控、数据日志和影响评估。

公平性如同其他负责任 AI 原则,不局限于模型参数或训练脚本,而是全生命周期决策(数据采集、模型设计、策略阈值、再训练、用户反馈)共同作用的系统属性。尤其在受限或去中心化部署下,将公平性作为系统级约束,需预判权衡点,并在架构、决策规则和生命周期管理中提前嵌入公平目标。

公平性面临的部署挑战同样体现在隐私架构上,中心化与分布式约束间也存在类似张力。

隐私架构

机器学习系统中的隐私问题延续了公平性的模式:不仅仅是保护单条记录,更取决于数据的采集、存储、传输和系统行为集成方式。这些决策与部署架构紧密相关。系统级隐私约束因模型托管于云端、本地还是用户控制环境而异,各自面临不同的风险最小化与功能保障挑战。

架构上的关键区别在于数据处理的中心化与去中心化。云端系统通常聚合大规模数据,便于高容量建模和监控,但也加大了泄露和监控风险,需强加密、访问控制和可审计性。去中心化部署(如移动应用、联邦学习、TinyML)数据留在本地,降低中心风险但限制全局可观测性,开发者难以获取监控或合规所需的人口或行为统计,隐私保护需在开发阶段嵌入。

个性化行为的系统隐私挑战尤为突出。智能键盘、健身追踪、语音助手等应用持续处理敏感信号(如位置、输入、健康指标),即使原始数据被丢弃,训练后的模型也可能保留可被推理恢复的用户特征。架构中若有持久内存和频繁交互,长期隐私需在模型生命周期内深度集成保护机制。

连接性假设也影响隐私设计。云端系统可集中执行加密协议和远程删除策略,但可能带来延迟、能耗或传输风险。边缘系统多为离线或间歇连接,隐私保障依赖特征最小化、本地数据保留和编译时混淆。TinyML 设备通常无持久存储或更新通道,隐私只能在固件和模型二进制中静态实现,部署后无法调整。

隐私风险还涉及服务和监控层。若模型允许日志或主动学习更新,日志基础设施若无隐私保护,可能无意泄露敏感信息。例如,成员推断攻击可通过分析模型输出判断用户数据是否参与训练。防御需将隐私保护延伸到接口设计、速率限制和访问控制。

隐私不仅取决于技术机制,还取决于用户体验。模型即使形式上满足隐私定义,若数据采集不透明或缺乏解释,仍会违背用户期望。界面设计至关重要:系统需清晰告知采集何种数据、用途及用户如何退出或撤回同意。隐私敏感应用若未契合用户规范,即使技术合规也会失信。

因此,架构决策影响数据全生命周期的隐私,从采集、预处理到推理和监控。隐私设计不仅要选安全算法,还需基于部署约束、用户需求和法律义务做原则性权衡。高资源环境可集中执行政策工具,受限环境则需在模型和系统行为中静态嵌入隐私,通常无法动态监督。

隐私不是部署后的附加功能,而是需与部署环境架构现实协同规划、实现和验证的系统级属性。

与隐私关注数据保护相辅相成,安全与稳健性架构确保即使隐私机制无法防范所有风险,系统输出也能在压力下保持可靠、对齐人类期望。

安全与稳健性

机器学习系统的安全与稳健性实现高度依赖部署架构。动态不可预测环境(如自动驾驶、医疗机器人、智能基础设施)需实时管理不确定性,防范高影响失效。嵌入式控制器或端上 ML 系统则需在资源受限、可观测性有限和恢复机会稀缺下稳定运行。无论何种场景,安全与稳健性都是系统级属性,既依赖模型质量,也取决于部署中如何检测、遏制和管理失效。

常见挑战之一是分布漂移:部署条件与训练时不同。即使输入特征(如光照、传感器噪声、环境变化)略有变化,若未建模或监控不确定性,性能也会大幅下降。缺乏运行时监控或回退机制的架构,性能劣化常常直到失效才被发现。面向真实世界变异性的系统,必须能识别输入超出预期分布,并据此校准或推迟决策。

对抗稳健性带来额外架构考量。安全敏感决策系统(如反欺诈、内容审核、生物识别)易受对抗输入攻击,需模型级防御(如对抗训练、输入过滤)和部署级策略(如 API20 访问控制、速率限制、输入冗余校验)。这些防护常带来延迟和复杂性权衡,需与实时性能需求平衡。

对延迟敏感的部署进一步限制稳健性策略。自动导航、实时监控或控制系统需在严格时限内决策,重型鲁棒机制难以落地,回退动作需提前定义。此类系统常用置信度阈值、拒绝预测21或规则覆盖降低风险。例如,送货机器人仅在行人检测置信度足够高时前进,否则暂停或交由人工。此类控制策略虽常在模型外实现,但必须与系统安全逻辑紧密集成。

TinyML 部署约束更严。运行于微控制器,无操作系统、无连接,无法依赖运行时监控或远程更新。安全与稳健性只能通过保守设计、充分预部署测试和本身简单可预测的模型静态实现。部署后,系统需在传感器老化、电源波动、环境变化下无外部干预地可靠运行。

所有部署场景下,监控和升级机制对长期稳健性至关重要。云端或高资源环境可用不确定性估计、分布变化检测或人在环反馈检测失效并触发恢复。受限环境下,这些机制需简化或预计算,但原则不变:稳健性不是一次性达成,而需持续识别和应对新风险。

安全与稳健性必须视为系统涌现属性,取决于输入感知与校验、输出执行、失效识别和纠正措施的触发。鲁棒系统不是零错误,而是能可见、可控、安全地失效。安全关键应用中,这种设计不是可选,而是基础要求。

这些安全与稳健性考量引出治理与问责问题,也需适应部署约束。

治理结构

机器学习系统的问责性需通过具体架构选择、界面设计和运营流程实现。治理结构通过明确责任归属、条件和机制,使责任可操作。治理结构深受部署架构影响。问责的可追溯、可审计和可执行程度,在中心化、移动、边缘和嵌入式环境间差异巨大,各自面临系统监督和完整性维护的独特挑战。

中心化系统(如云平台)通常有完善的日志、版本控制和实时监控基础设施。模型注册、遥测22仪表盘和结构化事件管道,便于团队将预测追溯到具体模型、数据输入或配置状态。

边缘部署则将智能分布到可能独立于中心基础设施的设备。嵌入式模型(如车辆、工厂、家庭)需本地机制检测异常、触发告警和升级。例如,工业传感器置信度下降时可本地报警并启动预设升级流程。设计此类自治需提前规划:工程师需决定采集哪些信号、如何本地存储、连接中断或延迟时如何重新分配责任。

移动部署(如个人理财、数字健康工具)处于用户界面与后端系统交汇处。出错时,问题可能源于本地模型、远程服务或用户交互设计。此类治理需考虑这种模糊性。有效问责需清晰文档、可访问的申诉路径和机制,让用户能理解、解释和质疑自动决策。理解和申诉结果的能力需嵌入界面和服务架构。

TinyML 部署治理最受限。设备可能无连接、无持久存储、无运行时可配置性,动态监督或干预机会极少。此时,问责需通过加密固件签名、固定审计链和预部署文档静态嵌入。有时治理只能在制造或配置阶段执行,部署后无法修正。这些约束使治理结构设计与早期架构决策密不可分。

界面也在问责中扮演重要角色。能展示解释、暴露不确定性或允许用户查询决策历史的系统,使开发者、审计员或用户能理解发生了什么及原因。相反,黑箱 API、未文档化阈值或闭环决策系统阻碍监督。有效治理需信息流契合技术、监管和用户需求,使失效模式可观测、可补救。

治理还需适应领域风险和机构规范。高风险应用(如医疗、司法)常有法定影响评估和审计链。低风险领域更多依赖内部实践,受客户期望、声誉或技术惯例影响。无论何种场景,治理都应视为系统级设计属性,而非外部政策叠加。它通过代码结构、部署管道、数据流和决策接口实现。

要在多样部署环境下持续问责,需不仅为成功做规划,更要为失效做准备,包括异常检测、角色分配、记录维护和补救流程。这些流程需嵌入基础设施:日志可追溯、接口可执行、架构约束下仍具韧性。

负责任 AI 治理还需考虑算力基础设施选择对环境和分布的影响。部署 AI 系统的组织不仅对算法结果负责,也对资源利用模式对环境正义和公平接入的系统性影响负责,详见资源需求与公平性影响部分。

设计权衡

不同部署场景下的治理挑战揭示了一个根本事实:部署环境带来根本约束,决定了负责任 AI 实现中的权衡。机器学习系统不是在理想孤岛中运行,而是在有限资源、严格延迟、用户行为变化和监管复杂性下权衡目标。

云端系统因算力和存储充足,常能支持全面监控、公平性审计、可解释性服务和隐私保护工具。但这些优势通常伴随数据中心化,带来监控、泄露和治理复杂性风险。相反,端上系统(如移动、边缘、TinyML)数据本地性和用户控制更强,但部署后可见性、公平性监控和模型适应性受限。

目标间的张力常在架构层面显现。例如,需实时响应的系统(如可穿戴手势识别、自动刹车)无法在推理时计算复杂解释,设计者需选择预计算简化输出、异步分析还是放弃运行时可解释性。

个性化与公平性也常冲突。基于本地数据自适应的系统,往往缺乏评估群体间差异所需的全局视角。要确保个性化预测不导致系统性排斥,需在架构上平衡用户级适应与群体级公平和可审计性。

隐私与稳健性目标也可能冲突。鲁棒系统常需记录罕见事件或异常用户以提升可靠性,但记录这些数据可能违背隐私目标或违反数据最小化法律。在敏感行为需本地或加密保存的场景,稳健性必须在模型架构和训练阶段提前设计,事后优化不可行。

负责任 AI 的算力需求带来的张力超越技术优化,涉及环境正义和公平接入。能效部署常需简化模型,减少公平监控能力,在环境可持续性与伦理保障间权衡。例如,联邦学习中实现差分隐私会使单设备能耗增加 25-40%,对电池受限设备而言,隐私保护可能因能耗成本而不可及23。

这些例子说明了更广泛的系统级挑战。负责任 AI 原则不能孤立考虑,彼此交互,优化一项常常约束另一项。合适的平衡取决于部署架构、利益相关方优先级、领域风险、错误后果,以及算力资源需求对环境和公平的影响。

负责任机器学习设计的区别不在于消除权衡,而在于能否清晰、审慎地权衡。设计决策需透明,充分理解部署环境的限制及其对系统行为的影响。

为总结这些洞见,表 2 对比了云、移动、边缘和 TinyML 系统下负责任 AI 原则的架构张力。每种环境在可解释性、公平性、隐私、安全和问责等方面因算力、连接性、数据访问和治理可行性而有不同约束。

如表 2 所示,没有哪种部署场景能在所有原则上占优,各有取舍。云端支持复杂解释(SHAP、LIME)和中心化公平监控,但数据聚合带来隐私风险。边缘和移动部署数据本地性强,但限制了部署后可观测性和全局公平评估。TinyML 受限最严重,只能静态验证和编译时隐私保障,无法运行时调整。这些约束不仅是技术限制,还决定了不同用户和应用能获得哪些负责任 AI 功能,导致只有资源充足的部署才能负担全面保障。理解这些部署约束,为后续负责任 AI 技术方法的实际落地提供了必要背景。

| 原则 | 云端 ML | 边缘 ML | 移动端 ML | TinyML |

|---|---|---|---|---|

| 可解释性 | 支持复杂模型和 SHAP、采样等方法 | 需轻量、低延迟方法如显著性图 | 需为用户输出可解释结果,深度分析常转云端 | 极度受限,仅支持静态或编译时解释 |

| 公平性 | 大数据集便于检测和缓解偏见 | 本地偏见难检测,但可端上调整 | 高度个性化使群体公平追踪复杂 | 数据极少,难以分析和缓解偏见 |

| 隐私 | 数据中心化易泄露,但可用强加密和差分隐私 | 端上敏感数据需本地保护 | 与用户身份紧密耦合,需同意机制和本地处理 | 数据分布式降低中心风险,但匿名化难度大 |

| 安全性 | 易受黑客和大规模攻击 | 需关注现实交互的可靠性 | 用户监督下运行,仍需优雅降级 | 需分布式安全机制保障自治 |

| 问责性 | 企业政策和审计便于追溯和监督 | 供应链碎片化使问责复杂 | 需清晰的用户披露和反馈通道 | 需跨长链条硬件追溯 |

| 治理 | 易于外部监管(如 GDPR、CCPA) | 需开发者和集成商自我治理 | 平台政策与开发者选择平衡 | 依赖内置协议和加密保障 |

技术基础

负责任的机器学习需要将伦理原则转化为具体系统行为的技术方法。这些方法应对实际挑战:检测偏见、保护隐私、保障稳健性、提升可解释性。其成效取决于这些技术在数据质量、算力资源和部署需求等真实系统约束下的表现。

理解这些方法为何必要,首先要认识到机器学习系统如何产生问题行为。模型从训练数据中学习模式,包括历史偏见和不公平关联。例如,若招聘算法训练于有偏历史数据,就会复制歧视性模式,将某些人口特征与“成功”错误关联。

这是因为机器学习模型学到的是相关性而非因果关系。它们识别的统计模式可能反映不公的社会结构,而非有意义的因果联系。这种系统性偏见使历史上占优群体在模型中受益。

解决这些问题不能仅靠训练后的简单修正。传统机器学习只优化准确率,与公平目标存在张力。有效方案必须将公平性直接融入学习过程,而非作为次要考量。

每种技术路径都涉及准确率、算力开销和实现复杂度的权衡。这些方法并非通用,需根据系统需求和约束选择。所用框架决定了哪些负责任 AI 技术能实际落地。

本节将探讨负责任 AI 原则的实用技术方案。每种方法在系统中有特定作用,并带来相应的需求和性能影响。这些工具协同构建可信的机器学习系统。

负责任 AI 的技术路径可分为三类互补方法:检测方法用于发现系统问题行为,为偏见、漂移和性能问题提供预警;缓解技术通过算法干预和稳健性增强主动防止有害结果;验证方法为利益相关方理解和解释系统行为提供机制。

负责任 AI 技术的计算开销

实现负责任 AI 原则会带来可量化的计算成本,系统设计时必须考虑。理解这些性能影响,有助于工程师根据算力资源和质量要求,理性决策采用哪些技术。表 3 系统比较了不同负责任 AI 技术带来的计算开销。

| 技术 | 准确率影响 | 训练开销 | 推理成本 | 内存开销 |

|---|---|---|---|---|

| 差分隐私 | -2% ~ -5% | +15% ~ +30% | 极小 | +10% ~ +20% |

| (DP-SGD) | ||||

| 公平性感知训练 | -1% ~ -3% | +5% ~ +15% | 极小 | +5% ~ +10% |

| (重加权/约束) | ||||

| SHAP 解释 | N/A | N/A | +50% ~ +200% | +20% ~ +100% |

| 对抗训练 | +2% ~ +5% | +100% ~ +300% | 极小 | +50% ~ +100% |

| 联邦学习 | -5% ~ -15% | +200% ~ +500% | 极小 | +100% \~ +300% |

表 3 的性能数据为主流基准和生产系统的典型区间24。实际开销因模型架构、数据集规模和实现质量差异很大。例如,SHAP 在线性模型上仅增加约 10ms,但在深度集成模型上可超 1000ms。对抗训练的开销取决于攻击强度:PGD-7 约增 150%,PGD-50 约增 300%。联邦学习的开销主要受通信轮次和客户端异构性影响。

这些计算成本带来显著的公平性考量,详见多处章节。资源有限的组织可能无法实施负责任 AI 技术,导致伦理保护的可及性差异,这一主题在部署、落地和组织障碍中反复出现。

检测方法是所有负责任 AI 干预的基础。

偏见与风险检测方法

检测方法为识别机器学习系统问题行为提供基础能力,是偏见、漂移和性能退化的预警系统,防止问题造成重大损害。

偏见检测与缓解

将公平性落地到实际系统,不能只靠原则目标或理论指标,必须有系统感知的方法,贯穿机器学习全生命周期检测、度量和缓解偏见。实用偏见检测可用 Fairlearn25 等工具实现:

示例 1:Fairlearn 偏见检测:系统性评估贷款审批模型在不同群体间的表现,揭示审批率和假阳性率的潜在差异,提示需干预的歧视模式。

from fairlearn.metrics import MetricFrame

from sklearn.metrics import accuracy_score, precision_score

# 贷款审批模型在不同群体的评估

mf = MetricFrame(

metrics={

"approval_rate": accuracy_score,

"precision": precision_score,

"false_positive_rate": lambda y_true, y_pred: (

(y_pred == 1) & (y_true == 0)

).sum()

/ (y_true == 0).sum(),

},

y_true=loan_approvals_actual,

y_pred=loan_approvals_predicted,

sensitive_features=applicant_demographics["ethnicity"],

)

# 展示各族群审批表现差异

print("各族群贷款审批表现:")

print(mf.by_group)

# 输出示例:Asian: 94% 审批,White: 91%, Hispanic: 73%, Black: 68%

实际落地常受数据可访问性和系统监控能力限制。许多真实环境(尤其移动、联邦、嵌入式系统)在推理时无法获得性别、年龄、种族等敏感属性,难以追踪或审计模型在不同群体间的表现。第 6 章:数据工程中讨论的数据采集和标注策略对全生命周期公平性评估至关重要。在此类场景,公平性干预需前置到数据策划或训练阶段,部署后难以再校准。即使数据可用,若持续再训练管道未监控公平性,用户反馈也可能加剧既有差异。例如,端上推荐模型若无法检测用户交互或输出中的人口失衡,可能放大原有偏见。

下图展示了公平性约束与部署选择的张力。在二元贷款审批系统中,A(蓝)B(红)两子群体需不同阈值才能实现相等真阳性率。统一阈值会导致结果不均,B 群体受损。通过分群调整阈值可提升公平性,但需模型服务栈支持条件逻辑、推理时可访问敏感属性,并有治理框架解释和证明差异化处理。

公平性干预可在管道不同环节实施,但各自带来系统级影响。预处理方法通过采样、重加权或增强平衡训练数据,需访问原始特征和群体标签,常依赖特征库或数据湖保留数据溯源。适合中心化训练和高质量标注数据的系统。处理中方法将公平约束直接嵌入优化目标,需训练基础设施支持自定义损失或约束求解器,训练周期更长或需额外正则化验证。[第 8 章:AI 训练]详述了公平性训练的基础。

后处理方法(如分群阈值、分数调整)需推理系统能基于敏感属性或外部策略规则做条件处理。这要求模型服务、访问控制和日志管道协同,确保差异化处理可审计、符合法规。模型服务架构详见第 2 章:机器学习系统。任何后处理策略都需验证不会损害用户体验、模型稳定性或违反属性使用法规。

可扩展的公平性保障常需更高级策略,如多重校准(multicalibration)26,确保模型在大量交叉子群体间均校准。

大规模多重校准需动态生成子群体分区、计算分组校准误差,并将公平性审计集成到自动监控系统。这通常只在云端大规模部署、成熟可观测性和指标管道下可行。嵌入式或 TinyML 等受限环境,遥测有限且模型逻辑固定,只能在设计时验证公平性。

跨部署环境,维护公平性需全生命周期机制。模型更新、反馈回路和界面设计都会影响公平性随时间的演化。若再训练管道无公平性检查、日志系统无法追踪子群体结果,或用户反馈引入训练分布未覆盖的微妙偏见,公平性模型会退化。监控系统需能暴露公平性回退,再训练协议需能访问带子群体标签的验证数据,可能需数据治理和伦理审查。实现这些监控需生产级 MLOps 基础设施,联邦公平性评估则需隐私保护技术。

公平性不是一次性优化,也不是模型孤立属性。它源于数据采集、特征工程、模型设计、阈值、反馈和系统监控等协同决策。将公平性嵌入机器学习系统需架构前瞻、运营规范和贯穿训练、服务、用户界面的工具链。

偏见检测的社会技术影响远超技术测量。当公平性指标发现差异,组织需如第 17 章:可信 AI所述,协调多方利益、法规合规和价值权衡,这些无法仅靠技术手段解决。

实时公平性监控架构

生产系统中落地负责任 AI 原则,需将公平监控、可解释性和隐私控制直接集成到模型服务架构。下图为参考架构,展示负责任 AI 组件如何与现有 ML 基础设施集成。

该架构通过多组件协作,实现大规模负责任 AI:

数据匿名化层在模型推理前执行隐私保护变换,如 k-匿名27或差分隐私噪声注入。每请求增加 2-5ms 延迟,内存开销 15-25%,但提供正式隐私保障。

实时公平监控跟踪每次预测的人口统计平等和机会均等指标,维护各保护群体的滚动统计。系统对超阈值差异(如审批率差异超 5%)报警。监控增加 10-20ms 延迟,需 100-500MB 额外内存。

解释引擎为模型决策(尤其需用户申诉的负面结果)生成 SHAP 或 LIME 解释。快速近似法将解释延迟从 200-500ms(全 SHAP)降至 20-50ms(流式 SHAP),保真度 90%。内存增加 50-100%,用于梯度计算和特征重要性缓存。

实现深度剖析

下例演示生产级实时偏见检测的公平监控实现。重点理解:(1) 公平性指标如何集成到服务基础设施,(2) 实现如何权衡性能,(3) 阈值超限时如何触发告警。具体实现细节可在构建类似系统时参考。

示例 2 展示了将这些组件集成到实时监控系统的生产实现:

import asyncio

from dataclasses import dataclass

from typing import Dict, List, Optional

import numpy as np

from sklearn.metrics import confusion_matrix

@dataclass

class FairnessMetrics:

demographic_parity_diff: float

equalized_odds_diff: float

equality_opportunity_diff: float

group_counts: Dict[str, int]

class RealTimeFairnessMonitor:

def __init__(

self, window_size: int = 1000, alert_threshold: float = 0.05

):

self.window_size = window_size

self.alert_threshold = alert_threshold

self.predictions_buffer = []

self.demographics_buffer = []

# For actual outcomes when available

self.labels_buffer = []

async def process_prediction(

self,

prediction: int,

demographics: Dict[str, str],

actual_label: Optional[int] = None,

) -> FairnessMetrics:

"""处理单次预测并更新公平性指标"""

# 存入滚动窗口缓冲区

self.predictions_buffer.append(prediction)

self.demographics_buffer.append(demographics)

if actual_label is not None:

self.labels_buffer.append(actual_label)

# 保持窗口大小

if len(self.predictions_buffer) > self.window_size:

self.predictions_buffer.pop(0)

self.demographics_buffer.pop(0)

if self.labels_buffer:

self.labels_buffer.pop(0)

# 计算公平性指标

metrics = self._compute_fairness_metrics()

# 检查偏见告警

if (

metrics.demographic_parity_diff > self.alert_threshold

or metrics.equalized_odds_diff > self.alert_threshold

):

await self._trigger_bias_alert(metrics)

return metrics

def _compute_fairness_metrics(self) -> FairnessMetrics:

"""计算各群体间的人口统计平等和机会均等"""

if len(self.predictions_buffer) < 100: # 最小样本量

return FairnessMetrics(0.0, 0.0, 0.0, {})

# 按保护属性分组预测

groups = {}

for i, demo in enumerate(self.demographics_buffer):

group = demo.get("ethnicity", "unknown")

if group not in groups:

groups[group] = {"predictions": [], "labels": []}

groups[group]["predictions"].append(

self.predictions_buffer[i]

)

if i < len(self.labels_buffer):

groups[group]["labels"].append(self.labels_buffer[i])

# 计算人口统计平等(审批率)

approval_rates = {}

for group, data in groups.items():

if len(data["predictions"]) > 0:

approval_rates[group] = np.mean(data["predictions"])

demo_parity_diff = (

max(approval_rates.values())

- min(approval_rates.values())

if len(approval_rates) > 1

else 0.0

)

# 计算机会均等(真阳性率/假阳性率差异),需标签可用

eq_odds_diff = 0.0

eq_opp_diff = 0.0

if self.labels_buffer and len(groups) > 1:

tpr_by_group = {}

fpr_by_group = {}

for group, data in groups.items():

if (

len(data["labels"]) > 10

): # 最小可靠指标样本量

tn, fp, fn, tp = confusion_matrix(

data["labels"], data["predictions"]

).ravel()

tpr_by_group[group] = (

tp / (tp + fn) if (tp + fn) > 0 else 0

)

fpr_by_group[group] = (

fp / (fp + tn) if (fp + tn) > 0 else 0

)

if len(tpr_by_group) > 1:

eq_odds_diff = max(

abs(tpr_by_group[g1] - tpr_by_group[g2])

for g1 in tpr_by_group

for g2 in tpr_by_group

)

eq_opp_diff = max(tpr_by_group.values()) - min(

tpr_by_group.values()

)

group_counts = {

group: len(data["predictions"])

for group, data in groups.items()

}

return FairnessMetrics(

demographic_parity_diff=demo_parity_diff,

equalized_odds_diff=eq_odds_diff,

equality_opportunity_diff=eq_opp_diff,

group_counts=group_counts,

)

async def _trigger_bias_alert(self, metrics: FairnessMetrics):

"""当偏见超阈值时触发告警"""

alert_message = (

f"偏见告警:人口统计平等差异:"

f"{metrics.demographic_parity_diff:.3f}, "

)

alert_message += (

f"机会均等差异:"

f"{metrics.equalized_odds_diff:.3f}"

)

# 记录到审计系统

print(f"[审计] {alert_message}")

# 可触发其他动作:

# - 发送告警到监控面板

# - 暂时启用人工审核

# - 触发模型再训练管道

# - 调整决策阈值

该生产实现展示了负责任 AI 原则如何转化为具体系统架构及可量化性能影响。公平监控每请求增加 10-20ms 延迟,需 100-500MB 额外内存,解释引擎增加 20-50ms 响应和 50-100% 内存。这些开销需与可靠性和合规性权衡。

检测能力需与主动防护的缓解技术结合。

风险缓解技术

缓解技术通过系统设计和运行主动干预,防止有害结果并降低对用户和社会的风险。这包括保护敏感数据的隐私方法、保障系统可靠性的对抗防御,以及支持数据治理和用户权利的机器遗忘28等。

隐私保护

隐私是负责任机器学习的基础原则,影响数据采集、模型行为和用户交互。隐私约束不仅受伦理和法律义务影响,还取决于系统架构和部署场景。隐私保护技术旨在防止数据泄露、限制记忆、保障用户同意、退出和数据删除权,尤其在个性化或敏感信息学习系统中。

现代大规模神经网络已知会记忆训练样本,包括姓名、位置或私密通信片段。这在智能助手、可穿戴设备、医疗平台等隐私敏感应用中风险极大,训练数据可能包含受保护或受监管内容。例如,语音助手适应用户语音时,可能无意中保留特定短语,后续可被特定查询提取。

这一风险不限于语言模型。训练于图像数据集的扩散模型也能再现训练集实例,如下图所示。这说明许多现代模型架构能内化并再现训练数据,且难以检测和控制。

模型还易受成员推断攻击,攻击者试图判断某数据是否参与训练。这类攻击利用模型对见过与未见输入的微妙行为差异。在医疗、法律等高风险应用中,仅仅知道某人记录被用于训练就可能违反隐私期望或法规。

为缓解这些漏洞,业界发展了多种隐私保护技术。最广泛采用的是差分隐私29,它能正式保证单条数据的加入或移除对模型输出影响有界。差分隐私随机梯度下降(DP-SGD)通过裁剪梯度并注入噪声实现。正确实现后,模型不会记忆单条数据,降低推断攻击风险。

但差分隐私带来系统级权衡。训练噪声会降低模型准确率、增加迭代次数、需更大数据集维持性能。移动、边缘、嵌入式等资源受限场景尤为突出,内存、算力、能耗预算紧张。此时需结合轻量隐私技术(如特征混淆、本地差分隐私)与架构策略(如限制采集、缩短保留、边缘严格访问控制)。

隐私保障还依赖模型外基础设施。数据采集界面需支持知情同意和透明度。日志系统应避免保留敏感输入,支持访问控制、过期策略和可审计性。模型服务基础设施需防止输出泄露内部行为或重构私密数据。这些机制需 ML 工程、安全和治理协同。

隐私需贯穿全生命周期。再训练管道需考虑已删除或撤回数据,尤其在有删除权法规下。监控基础设施应避免日志或仪表盘中记录个人信息。隐私感知遥测、可信执行环境、用户级审计链日益普及,尤其在法律监管严格的应用中。

架构决策也因部署场景而异。云端可集中执行差分隐私、加密和访问控制,配合遥测和再训练。边缘和 TinyML 则需在模型本身静态实现隐私约束,通常无运行时配置或反馈通道。此时需编译时静态分析、保守设计和嵌入式隐私保障,部署前完成验证。

隐私不是模型孤立属性,而是管道各环节设计决策的系统级产物。负责任的隐私保护需技术防护、界面控制、基础设施政策和法规合规协同,贯穿部署系统全生命周期。

隐私保护技术带来复杂的社会技术张力。差分隐私机制可能降低模型准确率,且对弱势群体影响更大,导致隐私与公平目标冲突。这些挑战需持续利益相关方参与,详见第 17 章:可信 AI,组织需在数据控制、个性化和合规间权衡。

用户权利和数据治理的动态性使隐私挑战更复杂。

机器遗忘

隐私保护不止于训练阶段。现实系统中,用户需有权撤回同意或请求删除数据,即使模型已训练和部署。支持这一需求带来核心技术挑战:如何让模型“遗忘”特定数据影响,而无需全量重训?这在算力、存储、连接受限的边缘、移动、嵌入式部署中尤为难以实现。

传统数据删除假设可访问全量训练集,删除目标记录后重训模型。下图对比了传统重训与新兴机器遗忘方法。重训需用修改后的数据集重建模型,遗忘则试图在不重训的情况下移除特定数据影响。

在延迟、算力或隐私约束紧张的系统中,这一区别尤为重要。现实中,许多已部署 ML 系统因安全、合规或成本原因不保留原始训练数据。此时全量重训不可行,且操作中断大,尤其需可验证、可追溯的数据删除。

机器遗忘旨在无需全量重训即可移除单条数据对已训练模型的影响。当前方法通过调整内部参数、修改梯度路径或隔离/剪枝模型组件,近似实现删除数据未参与训练时的预测。这些技术尚在成熟中,常需简化模型架构、额外元数据或牺牲准确率和稳定性。还带来验证难题:如何证明删除已生效,尤其在模型内部状态不可解释时。

法规进一步推动机器遗忘。GDPR、CCPA、加拿大、日本等法规均规定“被遗忘权”,包括用于模型训练的数据。这些法规要求不仅防止未授权访问,还要主动撤销,让用户能要求其信息不再影响系统行为。生成模型复现个人或版权内容的事件,凸显将遗忘机制集成到负责任系统设计的紧迫性。

系统视角下,机器遗忘带来非平凡的架构和运维需求。系统需能追踪数据谱系,包括哪些数据贡献了某模型版本,常需结构化元数据和训练管道监控。还需支持用户删除流程,包括认证、提交和状态反馈。验证可能需维护模型版本库,并能确认更新后模型无残留影响。这些操作需覆盖数据存储、训练编排、模型部署和审计基础设施,并能应对失败或回滚。

资源受限部署中挑战更大。TinyML 设备通常无持久存储、无连接、模型高度压缩,部署后无法响应删除请求。此时机器遗忘只能在开发阶段通过静态数据最小化和保守泛化实现。即使云端可重训,遗忘仍需应对分布式训练、服务副本和模型快照同步难题。

尽管挑战重重,机器遗忘正成为负责任系统设计的关键。随着 ML 系统日益嵌入、个性化和自适应,撤销训练影响能力对维护用户信任和符合法规至关重要。关键是,遗忘不能事后补丁,需在架构和政策设计阶段考虑,支持谱系追踪、重训编排和部署回滚。

机器遗忘代表隐私观念的转变——从保护采集数据到控制数据影响系统行为的时长。这一生命周期视角带来模型设计、基础设施和合规新挑战,也为更可控、透明和自适应的 ML 系统奠定基础。

负责任 AI 系统还需在恶劣条件下保持可靠,包括应对恶意攻击。

对抗稳健性

对抗稳健性在第 16 章:稳健 AI和第 15 章:安全与隐私中作为防御攻击的核心,也为负责任 AI 部署奠定基础。它不仅防范恶意攻击,还保障模型在自然变异、边界场景和分布外输入下可靠。对抗脆弱性暴露了模型学习表示的根本脆弱性,即使非对抗场景也影响可信度。

深度神经网络等模型已知对微小、精心设计的扰动极为敏感,可显著改变预测。这一漏洞通过对抗样本概念首次形式化,揭示了训练数据表现与真实世界变异下行为的鸿沟。模型在干净输入上表现良好,但对仅有微小变化的输入(人类难以察觉)却可能完全失效。

这不仅是理论问题。对抗样本已被用于操纵内容审核、广告拦截检测、语音识别等真实系统。在自动驾驶、医疗诊断等安全关键领域,即使极少数失效也会带来高后果,损害信任或暴露攻击面。

下图展示了肉眼难辨的扰动导致高置信度误判,说明微小变化可带来巨大危害。

本质上,对抗脆弱性源于模型假设与部署条件的不匹配。许多训练流程假设数据干净、独立同分布,而实际部署需应对不确定性、噪声、领域漂移和对抗篡改。稳健性不仅是抗攻击,还包括在退化或不可预测条件下保持一致行为。

提升稳健性从训练阶段开始。对抗训练是最常用技术之一,通过扰动样本增强训练,帮助模型学习更稳定的决策边界,但通常增加训练时间并降低干净数据准确率。大规模实现需数据预处理、模型检查点和能处理扰动输入的验证协议。

架构改进也可提升稳健性。限制 Lipschitz 常数、正则化梯度敏感性或约束表示平滑性等技术可让预测更稳定。这些设计需兼容模型表达需求和训练框架。例如,平滑模型适合输入精度有限或需严格阈值的嵌入式系统。

推理时,系统可实现不确定性感知决策。模型在置信度低时拒绝预测,或将不确定输入路由到回退机制(如规则组件或人在环)。这需部署基础设施支持回退逻辑、用户升级流程或可配置拒绝策略。例如,移动诊断应用若置信度低于阈值则返回“不确定”,而非给出潜在有害预测。

监控基础设施对部署后稳健性维护至关重要。分布漂移检测、异常跟踪和行为漂移分析可发现稳健性随时间退化。实现需持久记录模型输入、预测和上下文元数据,并有安全通道触发再训练或升级。这些工具自身也有系统开销,需与遥测、告警和模型版本管理集成。

除经验防御外,形式化方法可提供更强保障。认证防御(如随机平滑)能概率性保证模型输出在有界输入区间内稳定。这类方法需每次推理多次前向传播,计算量大,适合高保障、资源充足场景。集成到生产流程还需兼容模型服务和概率验证工具。

更简单的防御如输入预处理,通过去噪、压缩或归一化滤除对抗噪声。这些变换需足够轻量以实时执行,尤其在边缘部署下,且要能保留任务相关特征。集成建模也是一法,通过多模型集成提升稳健性,但增加推理复杂度、内存占用和运维难度。

系统约束(如延迟、内存、能耗、模型更新频率)强烈影响可行的稳健性策略。对抗训练增加模型体积和训练时长,挑战 CI/CD 流程并提升再训练成本。认证防御需算力和推理时间冗余。监控需日志、数据保留和访问控制。端上和 TinyML 部署通常无法运行时检查或动态更新。此时稳健性需静态验证并编译时嵌入。

对抗稳健性不是模型孤立属性,而是训练、架构、推理逻辑、日志和回退路径协同的系统级产物。模型单独看似鲁棒,若部署系统缺监控或接口防护,仍会失效。反之,部分鲁棒模型若嵌入能检测不确定性、限制暴露和支持恢复的架构,也能提升系统可靠性。

稳健性如同隐私和公平,需嵌入模型及其周边系统。负责任 ML 设计需预判模型在真实压力下的失效方式,并构建能检测、恢复和安全失效的基础设施。

验证方法让利益相关方能理解和审计系统行为。

验证方法

验证方法为利益相关方理解、审计和解释系统行为提供机制,帮助评估自动决策是否契合伦理和运营要求。这些技术支持透明性、合规和用户信任。

可解释性与可解释性

随着 ML 系统进入高影响领域,理解和解释模型预测变得至关重要。可解释性和可解释性指让模型行为对人类利益相关方(开发者、专家、审计员、监管者、终端用户)可理解的技术和设计机制。两者常混用,严格区分时,interpetability 指模型本身的透明性(如决策树、线性分类器),explainability 指为复杂或黑箱模型生成事后解释的技术。

可解释性在系统验证、错误分析、用户信任、合规和事故调查中居核心地位。医疗、金融、自动决策等高风险领域,解释有助于判断模型是否基于合理原因决策,还是依赖伪相关。比如解释工具可揭示诊断模型过度依赖图像伪影而非医学特征,否则难以发现。许多行业法规已要求 AI 系统提供“有意义信息”,强化了系统化解释支持的必要性。

可解释性方法可按操作时机和与模型结构关系分类。事后方法在训练后应用,将模型视为黑箱,无需访问内部权重,通过模型行为推断影响模式或特征贡献。常见方法有特征归因(输入梯度、集成梯度30、GradCAM31)、LIME、SHAP 等。

这些方法广泛用于图像和表格领域,解释可渲染为显著性图或特征排序。以 SHAP 归因为例,假设用随机森林预测贷款审批(approve=1, deny=0),特征有 income、debt_ratio、credit_score。某申请人被拒,收入 $45,000,债务比 0.55,信用分 620,模型预测拒绝概率 0.72。SHAP 基于合作博弈论的 Shapley 值,度量每个特征将预测从基线(全体平均 P(approve)=0.50)推向个体预测的贡献。

SHAP 框架通过评估所有特征子集,计算每个特征贡献。基线 0.50,加 income(略低于均值)降 0.05,加 debt_ratio(高)再降 0.25,加 credit_score(低)再降 0.12,最终 0.50-0.05-0.25-0.12=0.08,即 P(deny)=0.72。可见高债务比贡献最大(-0.25),其次信用分(-0.12),收入影响最小(-0.05)。这类解释具备可操作性:若债务比降至 40% 以下,决策可能翻转。

但这种严谨性带来高昂计算成本。3 特征需 2³=8 次子集评估,20 特征需 2²⁰≈百万次,解释 50-1000 倍于梯度法。树模型 SHAP 可降为多项式,深度模型需采样近似(KernelSHAP、DeepSHAP)。SHAP 理论上满足局部准确性、缺失性、一致性等优良性质,但高开销使其在高吞吐系统中难以实时解释,需近似或缓存。

另一类事后方法是反事实解释,描述若输入变化模型输出如何改变,适用于信贷、招聘等决策场景。例如,反事实解释可指出若申请人收入更高或债务更低就能获批。生成反事实需领域约束和真实数据流形,集成到实时系统有挑战。

第三类是基于概念的解释,试图将模型特征与人类可解释概念对齐。例如,CNN 分类室内场景时,激活“灯”、“床”、“书架”等滤波器。这类方法适合专家需语义解释的领域,但需概念标注数据或辅助模型,增加基础设施依赖。

事后方法虽灵活广泛,但有局限。因其为事后近似,可能生成合理但误导的解释。效果依赖模型平滑性、输入结构和解释方法保真度。最适合探索分析、调试或用户摘要,不宜作为内部逻辑的最终解释。

相对地,固有可解释模型天生透明,如决策树、规则列表、单调线性模型、KNN。这些模型直接暴露推理结构,便于利益相关方追踪预测路径。在司法预测、医疗分诊等受监管领域,固有可解释模型常被优先选用,哪怕牺牲部分准确率。但这类模型难以扩展到高维或非结构化数据,复杂任务下性能有限。

不同模型类型的可解释性可视为光谱。如下图,决策树、线性回归等天生透明,神经网络等复杂架构需外部解释。该区分对受监管或需信任的应用尤为关键。

混合方法试图结合深度模型的表达能力与可解释组件的透明性。如 Concept Bottleneck(Koh 等 2020)先预测可解释中间变量,再用简单分类器输出最终预测。ProtoPNet(Chen 等 2019)通过与原型比对分类,便于用户理解。混合方法适合需部分透明性的领域,但引入原型存储、推理时索引等新系统设计考量。

更前沿的是机制可解释性,试图逆向工程神经网络内部运算,受程序分析和神经科学启发,映射神经元、层或激活到具体计算功能。该领域尚处探索阶段,主要用于分析大模型。

系统视角下,可解释性带来架构依赖。解释需生成、存储、展示和评估,需解释 API、归因图存储、可视化库和中间行为日志。模型常需插桩或配置以支持采样、扰动或反向传播。

这些需求直接受部署约束影响,带来可量化性能成本。SHAP 解释通常需 50-1000 倍前向推理,单次解释 200ms-5s,复杂模型更高。LIME 需训练代理模型,单次 100-500ms。生产系统若每秒 1 万次预测、10% 需解释,仅解释就需 50-500 倍算力。

资源受限环境下,基于梯度的归因法更高效,通常每次仅增 10-50ms,利用已有反向传播。但复杂模型下可靠性差,模型更新后解释可能不一致。边缘部署常用预计算规则近似或简化决策边界,牺牲解释保真度换取 100ms 内延迟。

存储需求也随解释需求大幅提升。表格数据存 SHAP 值每预测每特征约 4-8 字节,图像梯度归因图每次 1-10MB。生产系统若每日 100 万次解释,月需 50GB-10TB 存储,需严格数据生命周期管理。

可解释性贯穿 ML 全生命周期。开发时用于数据审计、概念验证、调试,推理时支持问责、决策验证、用户沟通,部署后可日志、审计或错误调查时查询。系统设计需支持各阶段,将解释工具集成到训练框架、服务基础设施和用户应用。

压缩和优化也影响可解释性。剪枝、量化和结构简化常用于 TinyML 或移动端,可能扭曲内部表示或阻断梯度流,降低归因解释可靠性。此时需优化后验证解释质量,若解释重要,需将其纳入设计约束。

可解释性不是附加功能,而是系统级关注。设计时需明确谁需解释、何种解释有意义、如何在延迟、算力和界面预算下交付。ML 日益嵌入关键流程,解释能力成为安全、可信、可问责系统的核心要求。

可解释性的社会技术挑战在于技术解释与人类理解的鸿沟。算法可生成特征归因和梯度图,但利益相关方常需契合其心智模型、领域知识和决策流程的解释。放射科医生需医学概念和视觉模式解释,而非神经网络激活。这一翻译挑战需技术团队与领域专家协作,开发既准确又实用的解释格式。解释还会影响人类决策,带来新责任。

模型性能监控

训练时评估再严谨,也不能保证部署后模型可靠。真实环境动态变化:输入分布因季节、用户行为、政策变动而变,导致预测性能和系统可信度随时间退化。模型在训练/验证集表现良好,生产中仍可能做出不可靠或有害决策。

这种漂移影响超越准确率。若子群体分布变化,公平性保障可能失效,特征与结果的相关性在新场景下变得不可靠。可解释性需求也会变化,如新利益相关方需解释,或监管要求提升透明度。可信度不是训练时静态属性,而是随部署和反馈动态变化的系统特性。

为确保长期负责任行为,ML 系统需集成持续监控、评估和纠正机制。监控涉及的不仅是整体准确率,还需暴露子群体指标、检测输入分布漂移、识别异常输出、采集用户反馈。这些信号需与公平、鲁棒、透明等预期对比,并能触发再训练、校准或回滚等系统响应。

实现有效监控依赖健壮基础设施。系统需结构化、安全地记录输入、输出和上下文元数据,需遥测管道捕获模型版本、输入特征、预测置信度和后续反馈。这些日志支持漂移检测和公平鲁棒审计。监控系统还需集成告警、更新调度和政策复审,支持及时、可追溯干预。

监控还支持反馈驱动改进。例如,用户反复异议、纠错或人工覆盖可提示问题行为。反馈需聚合、验证并转化为数据集、标注或模型架构更新。但反馈回路有风险:用户偏见可能引入新不公,过度日志损害隐私。设计需协调用户体验、安全和伦理治理。

监控机制因部署架构而异。云端可用丰富日志和算力实现实时遥测、定期公平审计和持续再训练。移动端连接间歇、存储有限,监控需轻量、能容忍同步延迟,本地推理系统常异步收集性能数据后汇总上传,隐私约束更严,需本地聚合和数据最小化。

边缘部署(如自动驾驶、智能工厂、实时控制)需低延迟响应,外部监督最少。监控需嵌入运行时,内部检查传感器完整性、预测置信度和行为偏差,常用低开销不确定性估计、异常检测或一致性校验。需预判失效条件,确保异常行为能触发安全回退或人工介入。

TinyML 系统运行于无连接、无持久存储、无动态更新的嵌入式硬件,监控最受限。此时监控需在部署前设计和编译进系统,常用输入范围检查、内置冗余、静态回退逻辑或保守阈值。部署后模型独立运行,失效需物理更换或固件重置。

核心挑战普遍:部署 ML 系统需不仅初始表现良好,还能随环境变化持续负责任。监控提供将系统性能与伦理目标和问责结构连接的可观测层。无监控,公平和鲁棒不可见;无反馈,失配无法纠正。监控是 ML 系统保持自适应、可审计和对齐目标的运行基础。

本节探讨的技术方法——偏见检测、差分隐私、对抗训练、可解释性框架——为负责任 AI 实现提供了关键能力。但这些工具也揭示了根本局限:技术正确性本身无法保证有益结果。举三例说明:

公平性审计系统检测到贷款模型种族偏见,但组织缺乏解释和修正流程,技术能力有,组织惰性阻碍整改。差分隐私保障了数据保护的数学证明,但用户不了解保护机制,仍不当分享敏感信息,隐私方法有效但行为环境削弱效果。可解释性系统生成了准确的特征重要性,但受影响个体因界面设计和素养障碍无法访问或理解。

这些例子说明,负责任 AI 落地依赖技术能力与社会技术环境(组织激励、人类行为、价值观、治理结构)的对齐。

社会技术动态

负责任 AI 系统运行在复杂的社会技术环境中,技术方法与人类行为、组织实践和多元利益冲突相互作用。前文介绍的偏见检测、隐私保护和可解释性等技术为系统提供了必要能力,但其实际效果完全取决于这些能力如何与决策流程、用户界面、反馈机制和治理结构集成。理解这些互动对于实现可持续、真正有益的负责任 AI 落地至关重要。

上一节聚焦于解决明确定义问题的技术工具:检测偏见的算法、保护隐私的方法、生成解释的技术。现在我们将分析视角转向那些无法仅靠算法解决的挑战。

下文将探讨负责任 AI 系统如何与人、组织和多元价值观互动。这一转变需要不同的推理能力:不再是优化目标函数,而是分析利益冲突;不再是调参,而是权衡伦理取舍;不再是度量技术性能,而是评估社会影响。这正是社会技术工程的挑战——设计既要满足计算约束,又要契合人类价值观的系统。

负责任机器学习系统设计远不止于技术正确性和算法保障。系统一旦部署,就会在复杂的社会技术环境中运行,其输出既影响、又被人类行为、制度实践和社会规范所影响。随着时间推移,机器学习系统会成为其所建模环境的一部分,形成反馈动态,影响未来数据采集、模型再训练和下游决策。

本节关注机器学习技术部署带来的更广泛伦理和系统性挑战。将分析模型与环境间的反馈回路如何加剧偏见,人机协作如何引入新风险和责任,利益相关者价值冲突如何复杂化公平与问责的落地,以及可争议性和制度治理在持续负责任系统行为中的作用。这些考量凸显:责任不是算法的静态属性,而是系统设计、使用和监督随时间演化的动态结果。

系统反馈回路

机器学习系统不仅仅是观察和建模世界,它们也在塑造世界。一旦部署,模型的预测和决策常常会影响其分析的环境。这种反馈会改变未来数据分布、用户行为和制度实践,形成模型输出与系统输入之间的递归回路。随着时间推移,这种动态可能放大偏见、固化差异,甚至无意中改变模型最初服务的目标。

预测性警务就是这一现象的典型案例。模型基于历史逮捕数据预测某社区犯罪率较高,执法部门据此加派警力,结果导致该地区记录的案件更多,这些数据又被用于后续模型训练,进一步强化原有预测。即使模型最初并无明显偏见,进入反馈回路后也会自我实现,最终对本已被过度执法的社区造成更大影响。

推荐系统在数字环境中也有类似动态。以参与度为目标的内容推荐模型,会逐步收窄用户可见内容范围,形成反馈回路,强化既有偏好或加剧观点极化。这些效应用传统性能指标难以察觉,因为系统持续优化训练目标的同时,可能已偏离更广泛的社会或知识目标。

从系统视角看,反馈回路是负责任 AI 的核心挑战。它破坏了数据独立同分布假设,复杂化了公平性、稳健性和泛化能力的评估。标准验证方法依赖静态测试集,难以捕捉模型对数据生成过程的动态影响。一旦反馈回路形成,单纯提升公平性或准确率的干预往往难以奏效,除非能解决底层数据动态。

要在反馈回路下实现责任,需要对机器学习系统有全生命周期视角。不仅要持续监控模型表现,还要理解系统输出如何影响环境,这些变化如何被新数据捕获,再训练实践如何缓解或加剧这些效应。

云端系统可高频大规模更新,遥测丰富,便于检测行为漂移。相反,边缘和嵌入式部署常常离线或可观测性有限。例如,智能家居系统根据用户交互自适应温控,可能强化某种能耗或舒适偏好,进而改变家庭环境,影响未来模型输入。若无连接或中心化监督,这些回路可能长期不被察觉,却已影响用户行为和系统性能。第 13 章:机器学习运维中介绍的运维监控实践对生产系统中反馈动态的检测和管理至关重要。

系统需具备检测分布漂移、识别行为塑造效应和支持对齐目标的纠正更新的机制。反馈回路本身并非有害,但必须被识别和管理。若放任不管,会带来系统性风险;若有意识应对,则为学习系统在复杂动态环境中负责任地自适应提供了机会。

当人类操作员被纳入决策流程时,这些系统级反馈动态会变得更加复杂。

人机协作

机器学习系统越来越多地作为人类决策流程的组成部分而非独立智能体部署。在医疗、金融、交通等领域,模型作为决策支持工具,为人类操作员提供预测、风险评分或推荐。此类协作配置引发了责任分担、信任校准和监督机制落地等重要问题。

人机协作既带来机遇,也带来风险。设计得当时,系统可增强人类判断、减轻认知负担、提升决策一致性。设计不当则可能导致自动化偏见(用户即使面对明显错误也过度依赖模型输出),反之,过度不信任又会导致算法规避(用户因缺乏透明度或可信度而忽视有用预测)。协作系统的有效性不仅取决于模型性能,还取决于系统如何传达不确定性、提供解释,以及是否允许人工覆盖或纠正。

监督机制需根据部署场景定制。在高风险领域(如医疗分诊、自动驾驶),人类需实时监督自动决策。这对操作员的认知和时间提出高要求,假定关键时刻能及时可靠地介入。但实际中,持续人工监督往往不切实际或效果有限,尤其当操作员需同时监控多个系统或缺乏明确介入标准时。

从系统设计角度看,有效监督远不止于暴露原始模型输出。界面需在合适时机、以合适格式和上下文呈现关键信息。置信度分数、不确定性估计、解释和变更提醒都能支持人工监督。工作流需定义何时、如何介入,谁有权覆盖模型输出,如何记录、审计和反馈这些覆盖。

以医院分诊系统为例,模型为每位急诊患者生成风险分和建议分诊等级,原则上由护士确认或覆盖建议。但若模型输出缺乏充分理由(如关键特征解释或不确定性背景),护士即使遇到边界案例也可能默认模型建议。随着时间推移,模型输出可能成为事实上的分诊决策,尤其在高压环境下。若出现分布漂移(如新疾病或患者结构变化),护士可能既缺乏情境感知,也缺乏界面支持,无法发现模型性能下降。此时,表面上的人工监督掩盖了责任已无形转移给模型、却无明确问责或补救的现实。

在此类系统中,人工监督不是政策声明,而是基础设施设计的产物:预测如何呈现、信息如何保留、介入如何实现、反馈回路如何连接人工决策与系统更新。若这些组件未集成,监督就会碎片化,责任可能在无形中从人转移到机器。

决策支持与自动化的边界常常模糊。最初为辅助人类设计的系统,随着信任提升或组织激励变化,可能逐步获得更大自主权。这种转变可能在无明确政策变更下发生,导致事实上的自动化却无配套问责结构。负责任系统设计需预判使用方式随时间变化,确保即使自动化程度提升,必要的检查机制仍在。

人机协作需模型能力、界面设计、运营政策和制度监督的协同集成。协作不是简单“人在环”,而是跨技术、组织和伦理的系统挑战。设计监督需嵌入介入机制、支持知情信任和人机共担责任。

人机协作的复杂性还因不同利益相关方常常持有冲突价值观而加剧。

规范多元与价值冲突

本节分析多元价值体系及其对 ML 设计的影响,超越纯技术内容。核心观点:技术卓越虽必要,但不足以实现可信 AI,因为利益相关方对公平、隐私、问责有合理但不可调和的不同理解。理解这些价值张力对权衡影响现实生活的设计决策至关重要。这一视角是对技术能力的补充,而非替代。

具体场景:现实中的价值冲突

假设团队开发面向青少年的心理健康聊天机器人,利用 ML 检测危机并推荐干预。系统需平衡多项合理但互斥的目标:

医疗有效性:以循证最佳结果为目标,倾向激进干预——只要模型检测到自伤风险(即使置信度低),就通知家长、辅导员或急救服务,因为漏报可能致命。

患者自主权:尊重青少年隐私和自主。许多青少年求助正因无法与家长或权威沟通。激进通知政策可能让脆弱群体放弃使用,反而失去支持。

隐私保护:最小化数据采集和保留,保护敏感心理健康信息。倾向本地处理、不记录对话、不与第三方共享,但这也阻碍系统通过交互学习或在模型不确定时人工复核。

资源效率:受算力和人工监督预算约束。每次警报都让人工辅导介入虽效果更好,但大规模下成本高昂。全自动响应则可能在复杂场景下给出不当建议。

法律合规:满足强制报告和责任标准。许多司法辖区要求检测到紧急风险时必须通知权威——无论是否有助于患者,都会覆盖患者自主和隐私。

这些价值不是工程可调和的模糊需求,而是对系统目标和优先级的根本分歧。优化医疗有效性(激进干预)直接冲突于患者自主(最小干预);隐私保护(不留数据)与资源效率(需交互学习)冲突;法律合规(强制报告)可能与临床有效性(基于信任的治疗关系)冲突。

没有算法能决定哪种价值应优先。 不同利益相关方有合理不同立场:临床医生重疗效,青少年重自主,律师重合规,财务重效率。技术团队需引导利益相关方协商,确定在具体场景下可接受的权衡——这是规范性决策,先于并约束技术优化。

对某一方公平的结果,另一方可能视为不公。同理,优先准确率或效率的决策可能与透明、个体自主或伤害最小化目标冲突。这些张力不是偶然,而是结构性的,反映了 ML 系统所嵌入社会和机构的多元性。

公平性是价值冲突最突出的领域。公平可被多种、常常互斥的方式形式化。满足人口统计平等的模型可能违背机会均等,优先个体公平的模型可能削弱群体平等。选择哪种定义不是纯技术决策,而是规范性选择,需结合领域背景、历史歧视和受影响者视角。实际中,工程师、用户、审计员、监管者等多方常对何种定义最合适及其原因持冲突观点。

这种张力不限于公平。可解释性与预测性能、隐私与个性化、短期效用与长期后果等目标也常冲突。这些权衡因系统部署架构不同而表现各异,说明价值冲突深深嵌入 ML 系统设计与运行。

以移动端语音助手为例,为提升个性化,系统可本地学习用户偏好,无需上传原始数据。这样提升隐私、降低延迟,但若用户行为模式稀有,预测准确率会下降。提升公平性的方式是用群体统计集中更新,但这又带来隐私风险,违背本地数据期望。此时,设计需在隐私、公平、个性化三者间权衡。

云端部署(如信贷评分、推荐引擎)常在透明性与商业机密间张力突出。用户或监管者要求解释决策,尤其在高影响场景,但模型可能依赖复杂集成或专有数据。披露内部细节可能涉及商业敏感或技术不可行。此时,系统需在机构问责和商业保密间权衡。

边缘系统(如家庭安防摄像头、无人机)常受资源约束,决定模型选择和更新频率。优先低延迟和能效需部署压缩或量化模型,稳健性和分布漂移适应性下降。更鲁棒模型提升安全,但可能超出内存或能耗预算。此时,安全、效率和可维护性需在硬件约束下平衡。效率技术和优化方法对资源受限环境下负责任 AI 实现至关重要。

TinyML 平台上,模型部署到无持久连接的微控制器,权衡更突出。系统可针对固定数据集静态优化,但无法后续引入新公平约束、再训练或生成解释。硬件约束根本决定了资源受限设备上可实现的负责任 AI 能力。价值冲突不仅在于模型优化什么,更在于系统部署后能否支持哪些责任实践。

这些例子说明,规范多元不是抽象哲学难题,而是反复出现的系统约束。多目标优化、约束训练、公平性评估等技术可帮助显式化权衡,但无法替代判断。关于代表谁的价值、缓解哪些伤害、如何平衡目标的决策无法算法化,需协商、利益相关方参与和超越模型本身的治理结构。

参与式和价值敏感设计方法提供了可能路径。这些方法不把价值当作部署后优化的参数,而是在需求阶段就让利益相关方参与,明确伦理权衡,并追踪其在系统架构中的体现。虽然无法让所有价值同时满足,但能公开权衡、可修正的系统更易赢得信任和问责。

机器学习系统不是中立工具,无论显式还是隐式,都嵌入并执行价值判断。负责任 AI 的承诺在于承认这一点,构建能反映并响应其运行环境伦理和社会多元性的系统。

解决这些价值冲突不仅需技术方案,还需透明和可争议性机制,让利益相关方能理解并质疑系统决策。

透明性与可争议性

透明性被广泛认为是负责任机器学习的基础原则。它让用户、开发者、审计员和监管者能理解系统如何运行、评估其局限、发现伤害源。但透明性本身并不够。在高风险领域,个人和机构不仅要理解系统行为,还需有能力在必要时质疑、纠正或逆转系统决策。可争议性(contestability)即为质询和挑战系统决策的能力,是问责的重要特征。

机器学习系统的透明性通常聚焦于披露:公开模型如何训练、依赖哪些数据、设计假设和已知局限。模型卡、数据表等文档工具通过结构化元数据支持这一目标,提升治理、合规和用户预期。但披露本身不保证实际控制力。即使技术细节可查,用户可能缺乏制度、界面或流程工具,无法对不利决策提出异议。

要从透明性走向可争议性,ML 系统需设计解释、补救和反馈机制。解释指系统能为输出提供可理解理由,针对接收者需求和情境。补救指个人能改变自身条件并获得不同结果。反馈指用户能报告错误、质疑结果或表达关切,并让这些信号被系统更新或监督流程采纳。

这些机制在实际中常常缺失,尤其在大规模或低资源设备嵌入的系统中。例如,移动贷款申请系统,用户被拒绝却无解释,也无法补充信息或申诉。即使有文档,界面层缺乏透明性,使系统实际上无法被挑战。又如,临床预测模型生成风险分指导治疗,但未向医生展示推理依据。若模型对某患者子群体表现不佳,且不可观测或质疑,可能造成难以诊断或纠正的无意伤害。

系统视角下,实现可争议性需技术与制度协同。模型需暴露足够信息支持解释,界面需及时可用地呈现,组织流程需能审查反馈、响应申诉并更新系统行为。日志和审计基础设施需追踪模型输出、用户介入和覆盖决策。有时,技术防护(如人在环覆盖、拒绝阈值)也可通过让高风险决策交由人工,提升可争议性。

可争议性的可行程度因部署环境而异。中心化云平台可提供完整解释 API、用户面板和申诉流程。边缘和 TinyML 部署则可能仅限于日志和基于批量同步反馈的周期性更新。无论何种场景,ML 系统设计需承认:透明性不仅是技术披露,而是决定用户和机构能否实质性质疑、纠正和治理自动决策行为的结构性属性。

要实现有效的透明性和可争议性机制,需有超越单一技术团队的制度支持和治理结构。

责任的制度嵌入

机器学习系统不是孤立运行的。其开发、部署和持续管理都嵌入在包括技术团队、法务、产品、合规和外部利益相关方的制度环境中。责任不是单一角色或组件的属性,而是分布于角色、流程和治理机制之中。负责任 AI 设计需关注系统所处的制度环境。

这种分布式责任既带来机遇,也带来挑战。一方面,多方参与可形成制衡,防止有害结果。另一方面,责任扩散可能导致问责空白,出现问题时无人有明确权力或激励介入。伤害发生时,可能难以界定是数据管道、模型架构、部署配置、用户界面还是组织环境的责任。

Google Flu Trends 是制度失配导致失败的典型案例。该系统最初表现良好,但因用户行为和数据分布变化逐渐偏离现实。问题多年未被纠正,部分原因是缺乏系统验证、外部审计和性能下降时的升级流程。失败不是单一技术缺陷,而是缺乏能应对漂移、不确定性和外部反馈的制度框架。

将责任制度化不仅需分配问责,还需设计能促进行动的流程、工具和激励。技术基础设施如模型版本库、模型卡、审计日志需与伦理审查会、模型风险委员会、红队测试等组织结构结合。这些机制确保技术洞见可转化为行动,反馈能跨团队集成,用户、开发者或监管者提出的关切能系统性响应。

所需制度支持因部署环境而异。大规模云平台可有内部问责审计、合规流程和专职监控团队。小规模部署(如嵌入医疗设备或公共基础设施的边缘/移动系统)则依赖跨职能工程实践和外部认证。TinyML 部署因连接和可观测性有限,责任需通过上游控制(如安全验证、嵌入安全约束、固件生命周期追踪)实现。

无论何种场景,负责任机器学习需技术与制度系统协同。这种协同需贯穿模型全生命周期——从数据采集、训练到部署、监控、更新和退役。还需纳入外部参与者(如领域专家、社会组织、监管机构),确保责任不仅在开发团队内部实现,也能覆盖更广泛的生态。

责任不是模型或团队的静态属性,而是系统如何被治理、维护和质疑的动态产物。通过政策、基础设施和问责机制将责任嵌入制度,是让 ML 系统契合其服务的社会价值和运营现实的关键。

对制度责任和价值冲突的考量进一步说明,负责任 AI 的落地超越技术方案,涉及可及性、参与和环境影响等更广泛议题。前文探讨的算力资源需求带来系统性壁垒,决定了谁能开发、部署和受益于负责任 AI,将责任从单一系统属性转变为集体社会挑战。

本节探讨的社会技术议题——反馈回路导致自强化差异、人机协作中的自动化偏见与算法规避、利益多元与算力公平鸿沟——说明仅靠第 17 章:可信 AI的技术基础无法确保负责任 AI。这些动态发生在算法、人、组织与社会的交汇处,静态公平指标难以胜任,价值冲突无法算法化调和。即便原则明确、技术方法健全,将负责任 AI 转化为运营实践仍面临重大落地挑战。

落地挑战

前述技术基础和社会技术动态明确了负责任 AI 系统应达成的目标,但实际运行中存在大量障碍。以前文方法为例:Fairlearn 等偏见检测算法需持续数据采集和监控基础设施,但许多组织缺乏将公平性指标转化为行动的流程。差分隐私机制需精细参数调优和性能监控,但团队可能不懂隐私 - 效用权衡。可解释性框架能生成特征归因分数,但若设计系统未让受影响用户可访问和理解解释,这些技术能力毫无实际意义。

这些例子说明了技术能力与运营落地之间的根本鸿沟。负责任 AI 方法提供了必要工具,但其效果完全取决于组织结构、数据基础设施、评估流程和超越算法开发的持续投入。理解这些落地挑战对构建能长期保持责任行为的系统至关重要,而非仅在初始部署时达标。

本节将用经典的“人 - 流程 - 技术”三维框架,系统分析嵌入负责任 AI 实践到生产 ML 系统时遇到的实际挑战。

人员挑战 涉及组织结构、角色定义、激励对齐和利益相关方协作,决定负责任 AI 原则能否转化为持续的组织行为。流程挑战 包括标准化缺口、全生命周期维护、目标冲突和评估方法,影响负责任 AI 实践如何融入开发工作流。技术挑战 涉及数据质量、算力资源、可扩展性瓶颈和基础设施短板,决定负责任 AI 技术能否在生产规模下有效运行。

这些挑战共同体现了理想原则与运营现实的摩擦。理解其关联对发展将责任嵌入 ML 部署架构、基础设施和工作流的系统级策略至关重要。

下文将从三大维度分析落地障碍,强调负责任 AI 需三者协同解决。

组织结构与激励

负责任机器学习的落地不仅受技术可行性影响,更受系统开发和部署的组织环境塑造。在企业、研究机构和公共部门,责任需转化为具体角色、流程和激励。但实际中,组织结构常常割裂责任,难以在工程、产品、法务和运营团队间协调伦理目标。

负责任 AI 需持续投入,如子群体性能评估、可解释性分析、对抗稳健性测试和差分隐私/联邦训练等隐私保护。这些活动耗时耗力,却常常不计入团队绩效指标。例如,团队可能被激励快速上线功能或达成性能基准,即使这样会损害公平或忽视潜在伤害。若伦理工作被视为可选任务而非系统生命周期的组成部分,遇到截止压力或组织变动时就易被边缘化。

责任还因归属不明而复杂化。许多组织中,无单一团队对系统长期伦理行为负责。模型性能归属一队,用户体验归另一队,数据基础设施归第三队,合规归第四队。出现问题(如预测差异、解释不足)时,常无明确流程定位根因或协调缓解。结果是,开发者、用户或审计员提出的关切常被搁置,并非恶意,而是缺乏流程和跨职能协作。

建立有效的负责任 AI 组织结构需超越政策声明。需有操作机制:指定伦理监督角色、明确定义升级路径、部署后监控问责、激励团队前瞻性伦理和系统可维护性。有的组织设立负责任 AI 委员会、跨职能评审会或模型风险团队,贯穿模型全生命周期。也有的将领域专家或用户代表嵌入产品团队,预判下游影响并在情境中评估价值权衡。

如图 8 所示,伦理系统行为责任分布于产业、学术、社会和政府多方。组织内部需有机制将技术设计与战略监督、运营控制连接。若无这些联结,责任就会扩散,善意努力也会被系统性失配削弱。

负责任 AI 不仅是技术卓越或合规问题,而是系统级挑战,需将伦理目标与 ML 系统设计、部署和维护的制度结构对齐。创建和维持这些结构,是让责任嵌入模型和组织治理的关键。

除组织挑战外,团队还面临数据质量和可用性等重大技术障碍。

数据约束与质量缺口

尽管数据质量对负责任机器学习至关重要,但改进数据管道在实践中仍是最难的落地挑战之一。开发者和研究者普遍理解代表性数据、准确标注和历史偏见缓解的重要性,但即使目标明确,结构性和组织障碍常常阻碍有效干预。数据责任常分散于多团队,由遗留系统管理,或嵌入难以变更的制度流程。

第 6 章:数据工程中介绍的数据验证、模式管理、版本控制、谱系追踪和质量监控等原则,为应对这些挑战提供了技术基础。但应用于负责任 AI 时更复杂:公平性需评估群体代表性,偏见缓解需理解历史采集实践,隐私保护又限制可用验证技术。组织挑战反映了拥有强大数据工程基础设施与有效支持负责任 AI 目标之间的差距。

子群体不平衡、标签歧义和分布漂移等问题影响泛化和跨领域表现,是负责任 ML 的老问题。这些问题常表现为校准差、分布外失效或评估指标的人口差异。但在真实场景下解决它们需的不仅是技术知识,还需数据访问、制度支持和充足资源迭代数据集。许多 ML 流水线中,数据一旦采集、训练集一旦确定,数据管道就基本冻结。团队既无权限也无基础设施在中途修正或扩展数据集,即使发现性能差异。即使现代数据管道有自动验证和特征库,生产中锁定数据版本和谱系后,事后修正训练分布仍极难。

医疗、教育、社会服务等领域尤为突出。数据采集受法律、隐私或跨机构协调约束。例如,开发分诊模型的团队可能发现训练数据低估小型或农村医院患者。要纠正需与外部伙伴协商数据访问、统一特征标准、解决标注不一致。即使各方同意,后勤和运营成本也极高。

为提升代表性采集更多数据也可能引发伦理和政治问题。有时,额外采集会让弱势群体暴露于新风险。这种“暴露悖论”——最易受排斥伤害者也是最易被滥用者——让通过扩展数据集提升公平性变得复杂。例如,为提升性别敏感应用的公平性采集更多非二元群体数据,虽提升模型覆盖,但也带来同意、可识别性和下游用途等严重隐忧。团队需谨慎权衡,往往缺乏明确制度指引。

上游采集系统的偏见即使数据充足也常被忽视。许多组织依赖第三方数据商、外部 API 或非为公平/可解释性设计的运营数据库。例如,临床 ML 常用的电子健康记录反映了护理系统性差异和记录习惯中的种族/经济偏见。下游团队难以了解这些记录如何生成,也难以干预嵌入的伤害。

数据集质量改进常无专责团队。数据管道由基础设施或分析团队维护,独立于 ML 工程或模型评估团队。组织割裂使数据审计、溯源追踪或将模型行为反馈到数据问题的闭环难以实现。实际中,数据集质量责任常被忽视,虽被认可但很少被优先或资源化。

解决这些挑战需长期投入基础设施、工作流和跨职能沟通。数据验证、自动审计、数据集文档(如模型卡、数据表、Data Nutrition Project)等技术工具有帮助,但前提是团队有权力和支持将发现转化为行动。提升数据质量不仅是工具问题,更是数据责任如何分配、共享和全生命周期维持的问题。

即使数据质量问题解决,团队在平衡多目标时仍面临复杂性。

多目标权衡

ML 系统设计常被视为优化过程——提升准确率、降低损失或最大化效用。但在负责任 ML 实践中,优化必须与公平、可解释性、稳健性、隐私和资源效率等多目标平衡。这些目标常常不一致,一项提升可能导致另一项下降。理论上这些张力已被充分讨论,但在真实系统中管理它们仍是持续未解的难题。

以准确率与可解释性的权衡为例。许多情况下,更可解释的模型(如浅层决策树、线性模型)预测性能低于复杂集成或深度网络。低风险应用下,这种权衡可接受甚至优选。但在医疗、金融等高风险领域,决策影响个体福祉或机会,团队常在性能与透明性需求间两难。即使开发阶段优先可解释性,部署时也可能为微小准确率提升而放弃。

个性化与公平性也常冲突。以最大化用户参与为目标的推荐系统会高度个性化,利用细粒度行为数据为个体定制输出。这提升部分用户满意度,却可能加剧人口群体间差异,尤其当个性化特征与种族、性别、经济地位相关时。加公平约束可降低群体差异,但会牺牲部分用户的个性化体验。这些效应难以度量,更难向以参与度为目标的产品团队解释。

隐私又带来新约束。差分隐私、联邦学习、本地数据最小化等技术能有效降低隐私风险,但也会引入噪声、限制模型容量或减少训练数据。中心化系统可通过扩展基础设施或混合训练架构吸收这些成本。边缘或 TinyML 部署下,权衡更为尖锐。可穿戴设备需本地推理,常需同时平衡模型复杂度、能耗、延迟和隐私保障。支持一项约束通常削弱另一项,系统设计者被迫在同等重要目标间优先排序。这些张力还因量化级别、激活裁剪、压缩策略等部署决策而加剧,影响模型能否同时支持多目标。

这些权衡不仅是技术问题,更是系统目标和服务对象的规范性判断,详见第 17 章:可信 AI。负责任 ML 开发需让这些判断显性化,在情境中评估,并纳入利益相关方和制度监督。

实际落地难点在于,这些目标常无单一团队或职能负责。性能由建模团队优化,公平由负责任 AI 组监控,隐私由法务或合规部门管理。若无刻意协调,系统级权衡常被隐性、碎片化或无视长期后果地做出。最终,模型单独看似合规,嵌入生产基础设施后却难以达成伦理目标。

平衡多目标需技术能力,也需透明、协商和跨团队对齐。系统需设计为暴露权衡而非掩盖,支持约束感知开发而非单一优化。实际中,这可能意味着重新定义“成功”——不是单一指标的性能,而是系统行为与其在更广泛社会或运营语境中的持续对齐。

在组织结构、数据质量和多目标权衡三大挑战中,规律显现:负责任 AI 失败很少因技术无知。团队懂公平指标、隐私技术和偏见缓解方法。失败发生在组织割裂导致责任无问责、数据约束带来技术壁垒、目标冲突让规范性权衡被技术问题掩盖。当建模团队独立优化性能、合规团队独立处理隐私、产品团队独立追求参与度时,系统级伦理行为只能偶然出现。这本质上是社会技术治理问题,需跨组织边界的清晰责任结构、支持伦理审计的数据基础设施和显性化价值权衡的协商流程。系统需在规模化和长期运行中持续保持责任行为,这些挑战尤为突出。

可扩展性与维护

负责任 ML 实践常在模型开发早期引入:公平性审计用于初评,可解释性方法用于模型选择,隐私保护技术用于训练。但系统从原型到生产部署后,这些实践常常退化或消失。原则与可持续性之间的落地鸿沟,是负责任 AI 的核心挑战。

许多负责任 AI 干预未考虑可扩展性。公平检查只在静态数据集上做,未集成到持续数据管道。解释方法只在开发工具中实现,未转化为可部署的用户界面。隐私约束只在训练时执行,部署后监控或模型更新时被忽视。结果是,负责任设计初衷难以跨系统扩展和生命周期变化持续。

生产环境带来新压力,重塑系统优先级。模型需适配多样硬件、对接演化 API、服务百万用户、保证高可用。例如,跨 CPU、GPU、边缘加速器保持一致需框架抽象、运行时调度和硬件编译器紧密集成。这些约束需持续适应和快速迭代,难以自动化或度量的责任实践(如人工评审、利益相关者协商、事后评估)易被 DevOps32 流水线边缘化。

维护带来更多复杂性。机器学习系统很少静态。新数据持续引入、再训练、特征废弃或新增、使用模式随时间变化。若无严格版本控制、变更日志和影响评估,难以追踪系统行为演化或责任属性(如公平、鲁棒)是否被保持。组织流动和团队重组会 erode 制度记忆。维护团队常非原开发或审计团队,导致系统目标与现实现状无意失配。流式或持续学习场景下,概念漂移和分布变化需主动监控和实时更新,问题尤为突出。

多模型系统和跨平台部署下挑战更大。推荐引擎可能由数十个子模型协作,每个针对不同子任务或用户群体。语音助手跨移动和边缘环境部署,需维护多版本模型,适配本地硬件。协调更新、保证一致性和持续责任行为需基础设施追踪代码、数据、价值和约束。

解决可扩展性和维护挑战需将负责任 AI 视为生命周期属性,而非一次性评估。这意味着在系统基础设施中嵌入审计钩子、元数据追踪和监控协议,也意味着创建能跨团队流转的文档、定义能跨项目交接的问责结构,确保系统更新不会无意抹去公平、透明或安全的改进。虽难以事后补丁,但可通过责任优先的工具和工作流在设计阶段集成。

责任需随系统扩展。现实环境中部署的 ML 模型不仅需上线时达标,还要在复杂性、用户规模和运营范围扩大时持续达标。这需持续的组织投入和架构规划,而非某一时点的技术正确性。

标准化与评估缺口

负责任 ML 领域虽已产出大量工具、指标和评估框架,但对如何系统性评估系统是否真正负责任仍无共识。许多团队认可公平、隐私、可解释性和稳健性的重要性,却难以将这些原则转化为一致、可度量的标准。基准方法为标准化评估提供了有价值的框架,但将其适配到负责任 AI 指标仍是活跃研究领域。缺乏正式评估标准,加上工具和框架碎片化,是大规模落地负责任 AI 的重大障碍。

这种碎片化在机构间和机构内部都很突出。学术研究常提出难以在实验外复现的新指标。工业团队则需优先集成到生产基础设施、非专家可解释、可持续监控的指标。结果是,一处开发的实践难以迁移,系统间性能对比也不可靠。例如,某模型在一个基准数据集上用人口统计平等评估公平,换到另一个领域或司法辖区的机会均等标准就可能不达标。无共享标准,评估只能临时拼凑,难以建立跨场景的责任信心。

负责任 AI 评估还存在分析单元与部署层级不匹配的问题。评估常聚焦单一模型或批处理作业,而实际部署包括数据采集管道、特征变换、推理 API、缓存层和人在环工作流。单独看似公平或可解释的模型,集成到应用后可能失效。支持系统级整体评估的工具仍不成熟,如何跨现代 ML 堆栈的组件评估责任也缺乏指导。

更复杂的是缺乏生命周期感知指标。大多数评估工具只在某一时点(常为部署前)应用。但公平、鲁棒等责任属性是动态的,取决于数据分布如何演化、模型如何更新、用户如何交互。无持续或定期评估,难以判断系统部署后是否仍契合伦理目标。虽有部署后监控工具,但很少与开发时评估指标集成,导致伦理性能漂移难以检测,或观察到的伤害难以追溯到上游原因。

工具碎片化进一步加剧挑战。负责任 AI 工具常分散在不同包、面板或内部系统,各自针对特定任务或指标。团队可能用一套工具做解释,另一套做偏见检测,第三套做合规报告,缺乏统一界面协同系统级权衡。互操作性差阻碍团队协作,文档复杂,重要评估易被跳过或不一致。元数据传播或事件日志在特征库、推理网关、模型注册等组件间缺乏钩子,问题更严重。

解决这些缺口需多方面进展。首先,需开发共享评估框架,定义系统负责任行为的可度量、可审计标准。其次,评估需超越单模型,覆盖全系统管道,包括用户界面、更新策略和反馈机制。最后,评估需成为持续生命周期活动,有基础设施追踪系统行为随时间变化,并在伦理属性退化时告警开发者。

无标准化、系统感知的评估方法,负责任 AI 只能停留在原则层面,难以实际验证。建立 ML 系统信心需更好的模型和工具,也需共享规范、持久指标和反映部署现实的评估实践。

负责任 AI 不能靠孤立干预或静态合规检查实现。它需架构规划、基础设施支持和制度流程,贯穿系统生命周期维持伦理目标。随着 ML 系统规模化、多样化并嵌入敏感领域,公平、鲁棒、隐私等属性的保障需贯穿模型选择、再训练、量化、服务和监控各阶段。若无持续监督,责任实践会随系统演化而退化,尤其当工具、指标和文档未设计为跨部署和后续维护而保留时。

应对这一挑战需更高标准化、更深度集成责任实践到 CI/CD 流水线,以及对支持伦理前瞻的系统基础设施的长期投入。目标不是让代码完美伦理决策,而是让责任成为可追踪、可测试、与 ML 系统规模和约束对齐的运营属性。

落地决策框架

面对这些落地挑战,实践者需有系统方法,基于部署场景和利益相关方需求优先排序责任原则。设计 ML 系统时,需在多目标权衡下,维持与系统风险和约束相适应的伦理保障。表 4 提供了一个决策框架,指导在不同系统类型下做情境化选择。

决策启发:

- 多原则冲突时:召集利益相关方,确定最严重的伤害。心理健康机器人案例(见第 17 章:可信 AI)说明此类冲突需协商而非算法解决。

- 算力预算受限时:按风险优先原则排序。高风险决策即使代价高也需公平/可解释性。低风险应用可用轻量方法。

- 部署环境变化时:重新评估原则优先级。云模型迁移到边缘后失去中心化监控能力,需用部署前验证和本地防护补偿。

- 利益相关方价值观分歧时:显式记录权衡,并建立可争议机制,让受影响用户能质疑决策。

| 部署场景 | 主要原则 | 落地优先级 | 可接受权衡 |

|---|---|---|---|

| 高风险个体决策(医疗诊断、信贷/贷款、司法、就业) | 公平、可解释性、问责 | 各保护群体强制公平指标;负面结果可解释;边界案例人工监督 | 可接受 2-5% 准确率下降换取可解释性;解释延迟 20-100ms;更高算力成本 |

| 安全关键系统(自动驾驶、医疗设备、工业控制) | 安全、稳健性、问责 | 认证对抗防御;形式化验证;失效保护机制;全量日志 | 可接受显著训练开销(对抗训练增 100-300%);保守置信度阈值;冗余推理 |

| 隐私敏感应用(健康、金融、通信) | 隐私、安全、透明 | 差分隐私(ε≤1.0);本地处理;数据最小化;用户同意 | 可接受 DP 损失 2-5% 准确率;更高客户端算力;有限模型更新;个性化下降 |

| 大规模消费系统(推荐、搜索、广告) | 公平、透明、安全 | 各群体偏见监控;解释机制;内容政策执行;反馈回路 | 解释性成本与规模权衡(流式 SHAP vs 全 SHAP);公平检查延迟 5-15ms;监控基础设施投入 |

| 资源受限部署(移动、边缘、TinyML) | 隐私、效率、安全 | 本地推理;数据本地化;输入校验;优雅降级 | 牺牲实时公平监控;用轻量解释(梯度法替代 SHAP);仅部署前验证;模型复杂度有限 |

| 研究/探索系统(内部工具、原型、A/B 测试) | 透明、安全(防伤害) | 已知局限文档化;限制用户群体;监控意外伤害 | 内部可暂缓复杂公平/可解释性,优先可观测性和快速迭代 |

该框架仅为起点。负责任 AI 落地需随系统、场景和社会预期演化持续评估。

随着 AI 系统自主性和能力提升,落地挑战更为复杂。第 17 章:可信 AI提出的价值对齐原则——确保 AI 系统目标与人类意图和伦理规范一致——在系统独立运行时尤为重要。前述负责任 AI 技术可解决监督场景下的偏见、隐私和可解释性,但自主系统需额外安全机制,防止系统目标与人类价值失配。

AI 安全与价值对齐

价值对齐挑战随着机器学习系统自主性和能力的提升而急剧放大。前述的偏见检测、可解释性、隐私保护等负责任 AI 技术提供了基础能力,但在系统独立运行时暴露出根本局限。看如下场景:

Fairlearn 等偏见检测算法需持续人工解读和纠正。自动驾驶感知系统可能对使用助行器的行人系统性漏检,但无人工监督时,偏见检测指标只是被记录,无法修正。技术上能测量偏见,但自主系统缺乏判断何时、如何响应的能力。

可解释性框架假定有人类受众能解读和行动。自动交易系统可为决策生成准确 SHAP 解释,但若无人审核,系统每秒执行数千笔交易,解释只是事后记录而非决策依据。系统用设计者未预见的方法优化目标(如利润),解释变成事后追溯而非决策辅助。

差分隐私等隐私保护技术能防止单条数据泄露,但无法解决更广泛的价值失配。自动内容推荐系统可用本地差分隐私保护用户数据,但同时以参与度为目标,可能推送虚假或有害内容。技术上隐私合规,但系统目标本身与用户福祉冲突时,保护无效。

这些例子说明,随着系统自主性提升,负责任 AI 框架虽必要但已不足。这些技术假定有人类监督、目标受限、环境可预测。AI 安全需扩展到系统可能优化与人类意图失配的目标、运行于不可预测环境、用设计者未预见方法达成目标的场景。

随着机器学习系统的自主性、规模和部署复杂度的提高,责任已超越模型级的公平或隐私,包含确保系统追求正确的目标、在不确定的环境中安全地运行,以及随着时间的推移与人类意图保持一致。这些问题属于 AI 安全的范畴,重点是防止强大的 AI 系统产生意外或有害的结果。一个核心挑战是,当前的机器学习模型通常优化代理指标,例如损失函数、奖励函数或参与度信号,而不是完全捕捉人类价值的真实目标。

一个具体的例子来自推荐系统,其中一个被训练来最大化点击率(CTR)的模型可能最终促使了增加参与度但降低用户满意度的内容,包括标题党、虚假信息和情感操控。这种行为与代理目标一致,但与实际目标不符,导致强化不良结果的反馈循环。如下图所示,系统学会优化可测量的奖励(点击),而不是以人为本的结果(满意度),从而导致规范性失配和奖励黑客,这是价值对齐和 AI 安全的核心问题。

在最近几年,基于人类反馈的强化学习(RLHF)成为了一种有影响力的方法,其中大型预训练模型通过人类提供的偏好信号进行微调。虽然这种方法比标准的强化学习更能提高对齐,但它也带来了新的风险。Ngo 指出 RLHF 可能引入三类失效:1)情境感知奖励黑客,模型利用人类的易错性;2)训练分布外涌现失配目标;3)为保留奖励最大化能力发展寻求权力行为,哪怕牺牲人类监督。

这些问题并非假设。@amodei2016concrete 总结了 AI 安全的六大具体挑战:1)避免负面副作用,2)缓解奖励黑客,3)可扩展监督,4)安全探索,5)分布漂移稳健性,6)任务泛化下的对齐。随着系统规模化、跨场景部署和实时反馈/持续学习,这些挑战愈发突出。

这些安全挑战在自主系统(人类监督减少)中尤为明显。

自主系统与信任

自主系统独立于人类监督、常常超出人类判断边界运行,其后果已在多个行业被充分记录。近期典型案例是加州 DMV 因“对公共安全构成不合理风险”暂停 Cruise 自动驾驶测试许可。某次事故中,行人刚进入斑马线,红灯变绿,系统未能正确识别,导致碰撞。2018 年,Uber 自动驾驶车辆未将推车行人识别为需避让对象,导致死亡。

自动驾驶虽是公众关注焦点,类似风险在其他领域同样存在。远程无人机和自主军事系统已在重塑现代战争,不仅带来安全和效能问题,还引发伦理监督、交战规则和责任归属难题。自主系统失效时,谁应负责仍是法律和伦理未解之题。

本质上,这反映了人机自主的深层张力。工程和计算机学科历史上强调机器自主——提升系统性能、最小化人工干预、最大化自动化。对 ACM Digital Library 的文献计量分析显示,2019 年前 90% 的“autonomy”高被引论文聚焦机器而非人类自主。生产力、效率和自动化被视为默认目标,常常未反思其对人类能动性和监督的影响。

但在动态、不确定环境下,系统目标若无法完全规范,过度自动化会威胁人类利益。这一难题被形式化为框架问题和资格问题,强调现实行动所需前提和情境不可能穷举。实际中,这表现为脆弱自主:系统在标称条件下表现良好,遇到歧义或分布漂移时无声或危险失效。

为应对这一点,研究者提出了如责任敏感安全(RSS)等形式化安全框架,将抽象安全目标分解为可数学定义的行为约束(如最小距离、制动曲线、路权条件)。这些方法可在特定假设和场景下验证安全属性。但它们仍受自身假设限制,需大量领域建模,难以泛化到未预见边界场景。

另一思路强调以人为中心的系统设计,确保人类判断和监督在自主决策中居核心。价值敏感设计(Value-Sensitive Design)主张在系统设计中显式考虑能力、复杂性、误表征和用户控制流动性等因素。最新的 METUX 模型(用户体验中的动机、参与和繁荣)提出技术体验的六大领域——采纳、界面、任务、行为、生活和社会,影响技术如何支持或削弱人类繁荣。这些思想根植于自我决定理论(SDT),将自主定义为按自身价值和目标行动的能力,而非技术意义上的控制。

在 ML 系统中,这些观点强调需设计能保留人类能动性的架构、界面和反馈机制。例如,优化参与度的推荐系统可能通过不透明方式影响用户偏好,损害行为自主。用 METUX 六领域评估系统,可预判并缓解下游影响,即使短期系统性能最优。

超越技术安全,部署自主 AI 系统还带来经济冲击等更广泛社会议题。

AI 自动化的经济影响

AI 技术普及引发的反复担忧是大规模失业。随着 ML 系统能完成越来越复杂的认知和体力任务,担心其取代现有工人、减少就业机会的声音日益高涨。物流、制造、客服等任务结构清晰的行业尤为突出,AI 自动化既技术可行又经济激励强烈。

但自动化的经济影响并非史无前例。以往技术变革(如工业机械化、信息化)往往带来岗位转移而非绝对减少。自动化降低成本、提升质量,扩大了商品和服务的可及性,进而带动需求,创造新型生产、分发和支持岗位——有时在邻近行业,有时在全新领域。

工业机器人和流程自动化的实证研究进一步挑战了“黑灯工厂”(全自动无人工厂)的可行性。MIT 未来工作小组指出,绝大多数全自动化尝试都失败了。零和自动化提升了生产率,却牺牲了系统灵活性、适应性和容错性。人类工人在需情境判断、跨领域泛化或系统级调试等任务上仍不可替代,这些能力难以用 ML 或自动化编码。

该小组主张“正和自动化”,即增强而非取代人类工作。策略包括将 AI 系统集成到人类保留监督和控制的流程,如半自动装配线或协作机器人。还建议自下而上识别可自动化任务,优先减轻认知负担或消除危险工作,并选用能同时衡量效率和韧性的指标。仅以吞吐量或成本最小化为目标的指标,可能无意中惩罚人在环设计,而以安全、可维护性和长期适应性为目标的指标能更全面反映系统表现。

但长期经济趋势并不能消除短期冲击。被自动化淘汰的工人可能面临工资停滞、议价能力下降或长期失业,尤其在缺乏再培训或劳动力流动性的情况下。公共和立法努力将在这一转型中发挥重要作用,包括提升自动化红利公平可及性的政策。负责任 AI 的正面应用包括技能提升、社会保障、最低工资提升和企业责任框架,确保 AI 的分配影响被持续监测和应对。

应对这些经济问题不仅需政策,还需有效的 AI 能力与局限科普。

AI 素养与沟通

1993 年对 3000 名北美成年人关于“电子思考机”的调查显示,公众对早期计算机有两种主流看法:“人类有益工具”和“令人敬畏的思考机器”。后者反映了对计算机神秘、智能、难以控制的感知——“比人更聪明、无限、快速、令人恐惧”。这些感知在 ML 时代依然 relevant。随着创新加速,负责任 AI 开发需配合清晰、准确的科学传播,尤其是关于 AI 能力、局限和不确定性的沟通。

现代 AI 超越普通人理解,影响高风险决策时,公众叙事易极化为乌托邦或反乌托邦。这不仅是媒体渲染造成,更是技术社会中科学系统输出常被视为“魔法”——“只能理解其结果,无法理解其原理”。缺乏技术理解支撑,生成模型、自主智能体、大规模推荐平台等系统易被误解或不信任,阻碍理性公共讨论。

科技公司对此负有责任。夸大宣传、拟人化营销或不透明发布加剧炒作与失望循环,损害公众信任。但提升 AI 素养不仅需企业自律,更需系统性研究 AI 语境下的科学传播。尽管 ML 社会影响巨大,Scopus 学术库分析发现“人工智能”与“科学传播”交集论文极少。

解决这一缺口需关注 AI 叙事如何被塑造——不仅由企业,也包括学术、监管、媒体、非营利和政策倡导者。这些参与者使用的框架和隐喻极大影响公众对 AI 能动性、风险和控制的认知,进而影响采纳、监督和抗拒,尤其在教育、医疗、就业等与现实生活直接相关的领域。

系统视角下,公众理解不是外部性,而是部署环境的一部分。对 AI 系统如何运行的误解会导致过度依赖、错误归因或安全机制被忽视。同样,缺乏对模型不确定性、数据偏见或决策边界的理解,会加剧自动化伤害风险。对受 AI 影响的岗位,针对性提升领域素养也有助于再培训和适应。

AI 素养不仅是技术能力,更是建立公众信心,让系统设计者目标与社会福祉对齐——让 AI 构建者不是“与众不同的科学家”,而是“共享价值观的社会成员”。正如 Handlin 1965 年所言:“即使永远无法理解技术原理,人们也需相信科学目标与自身福祉相关,科学家不是完全异类,而是共享部分价值观的人。”

常见误区与陷阱

负责任 AI 将技术工程与复杂伦理和社会考量相交织,容易导致对机器学习系统中偏见、公平和问责性质的误解。技术方案对伦理问题的吸引力,可能掩盖创造真正负责任 AI 系统所需的更深层次制度和社会变革。

误区: 偏见可以通过更好的算法和更多数据从 AI 系统中消除。

这一误解假定偏见是一个纯技术问题,具有纯技术解决方案。AI 系统中的偏见往往反映了更深层次的社会不平等和历史不公,这些问题嵌入数据采集过程、标注决策和问题表述中。即使在全面数据集上训练的完美算法,如果潜在数据或评估框架中存在偏见,也可能延续或放大社会偏见。算法公平性需要持续的人类判断,涉及价值观和权衡的持续审视,而非一次性技术修复。有效的偏见缓解需要持续的监测、利益相关者参与和制度变革,而不仅仅依赖算法干预。

陷阱: 将可解释性视为可选特性,而非系统必备。

许多团队将可解释性视为一种可有可无的能力,可以在模型开发和部署后再添加。这种做法未能考虑到,可解释性要求如何显著影响模型设计、评估框架和部署策略。事后解释方法往往提供误导性或不完整的见解,无法支持实际决策需求。高风险应用需要在系统架构中从一开始就设计可解释性,影响模型复杂性、特征工程和评估指标的选择,而不是事后附加。

误区: 伦理 AI 指导方针和原则会自动转化为负责任的实施。

这一信念假定,建立伦理原则或指导方针就能确保负责任的 AI 开发,而不考虑实施中的挑战。公平、透明和问责等高层原则,往往在实践中相互冲突,也与技术要求相悖。那些专注于原则表述而不投资于操作化机制的组织,往往会形成对实际系统行为影响不大的伦理框架。

陷阱: 假设负责任 AI 实践只会带来成本,而不会提供业务价值。

团队常将负责任 AI 视为合规负担,认为必然与性能和效率目标相冲突。这种看法忽视了负责任 AI 实践通过提高系统可靠性、增强用户信任、降低法律风险和扩大市场准入所能带来的显著业务价值。负责任 AI 技术可以改善模型的泛化能力,降低维护成本,防止在部署中出现代价高昂的失败。将责任视为纯成本而非战略能力的组织,错失了通过可信 AI 系统建立竞争优势的机会。

陷阱: 在不考虑系统级性能和可扩展性影响的情况下,实施公平性和可解释性特性。

许多团队在现有系统上添加公平性约束或可解释性方法时,未分析这些特性对整体系统架构、性能和可维护性的影响。实时公平监控可能引入显著的计算开销,降低系统响应速度;而存储复杂模型的解释可能产生大量存储和带宽需求。有效的负责任 AI 系统需要从初始设计阶段就仔细协同公平性和可解释性要求与系统架构,考虑责任 AI 特性与系统性能之间的权衡。

总结

本章通过四个互补视角探讨了负责任 AI,这些视角共同定义了构建可信机器学习系统的综合工程方法。公平、透明、问责、隐私和安全等基础原则确定了负责任 AI 系统应实现的目标,但这些原则只有通过与技术能力、社会技术动态和实施实践的集成,才能真正落地。

我们考察的技术基础,通过偏见检测算法、隐私保护机制、可解释性框架和稳健性增强,将抽象原则转化为具体系统行为。然而,算力开销分析揭示了这些技术带来的重大公平性考量。并非所有组织都能负担得起全面的负责任 AI 保护措施,这可能导致伦理保障获取上的差异。

然而,单靠技术正确性无法保证有益结果。社会技术动态决定了这些能力是否能转化为现实世界的影响:组织激励、人类行为、利益相关者价值观和治理结构共同决定了结果。完美的偏见检测算法若无组织流程落实其发现,便无用武之地;隐私保护方法若用户不理解其保护机制,则形同虚设。

实施挑战进一步凸显了原则与实践之间的鸿沟,显示出组织结构、数据约束、目标冲突和评估缺口如何阻碍即便是出于良好意图的负责任 AI 努力。将孤立的谬误转化为情境警示,强调负责任 AI 需要对常见误解保持持续警惕,而非一次性技术修复。

关键要点

- 集成至关重要:负责任 AI 源于原则、技术能力、社会技术动态和实施实践之间的对齐,单靠任何一方面都不足够

- 技术方法赋能但不保证责任:偏见检测、隐私保护和可解释性工具提供了必要能力,但其有效性完全依赖于组织和社会环境

- 公平性超越算法:计算资源需求造成系统性壁垒,决定了谁能获得负责任 AI 保护,将责任转变为集体社会挑战

- 部署情境决定可能性:云系统支持全面监控,而 TinyML 设备则需静态验证——负责任 AI 必须适应架构约束,而非强加统一要求

- 价值冲突需协商:公平性不可能定理表明,竞争原则无法通过算法调和,需利益相关方参与和明确的权衡决策

随着机器学习系统日益融入关键社会基础设施,负责任 AI 框架为可信系统奠定了基础。然而,责任不仅限于算法公平、可解释性和安全性。负责任 AI 技术的计算需求——训练大型模型需多 15-30% 的资源、解释需 50-1000 倍的推理计算、监控基础设施需大量投入——引发了对环境影响和资源消耗的深刻质疑。

下一章将探讨责任如何涵盖可持续性,审视大型模型训练的碳足迹、数据中心运营的环境成本,以及开发节能 AI 系统的紧迫性。正如负责任 AI 关注我们的系统是否公平,可持续 AI 则关注我们的系统是否对地球负责。可信系统的原则最终要求在技术性能、社会责任和环境保护之间取得平衡——确保 AI 发展在不妨碍我们共同未来的前提下,提升人类福祉。

测验:可信 AI

测试你对负责任 AI 原则和技术实现的理解

受保护属性:法律禁止歧视的特征,通常包括种族、性别、年龄、宗教、残疾和性取向。具体范围因国家而异:欧盟 GDPR 涵盖 9 类,美国民权法案涵盖 5 类。在 ML 系统中,这些属性因与结果的历史相关性常反映过去歧视而需特殊处理。 ↩︎

事后解释:模型训练后用于解释决策的可解释性方法。LIME 通过扰动输入特征并训练线性模型近似复杂模型的局部行为,类似“如果我稍微改变这个特征会怎样?”SHAP 为每个特征分配重要性分数,总和等于预测与平均预测的差值。从工程角度看,LIME 每次解释需 1000+ 次模型评估,SHAP 需 50-1000 倍常规推理算力,实时系统成本高昂。 ↩︎

价值对齐:AI 安全领域的挑战,由 Stuart Russell(2015)和 Nick Bostrom(2014)首次正式提出。问题在于如何让 AI 优化人类复杂、多变且常常冲突的价值观。典型失败案例包括 Facebook 2016 年“年度回顾”功能让经历丧失的用户痛苦回忆,以及 YouTube 推荐算法为“提升参与度”而推送极端内容。 ↩︎

人在环中(HITL):人类主动参与模型训练或决策的设计模式,而非完全自动化。典型如内容审核(大型平台雇佣数千审核员)、医疗诊断(放射科医生复核 AI 标记的影像)、自动驾驶(安全员随时介入)。研究表明,HITL 系统可显著降低错误率,但也带来人机协作与信任新挑战。 ↩︎

COMPAS 算法争议:2016 年 ProPublica 调查发现,COMPAS(罪犯管理画像系统)将黑人被告错误标记为未来犯罪分子的概率几乎是白人的两倍(45% vs 24%),而白人被告被错误标记为低风险的概率也更高(48% vs 28%)。该算法被多个州用于量刑决策,尽管存在已证实的差异。 ↩︎

局部解释:解释单个预测的可解释性方法,显示哪些输入特征驱动了具体决策。例如,“该贷款被拒因债务收入比(65%)超阈值(40%)且信用分(580)偏低。”实现通常依赖特征归因算法,需在推理时增加 20-200ms 延迟,并需 UI 展示结果。 ↩︎

全局解释:描述模型整体行为的方法,如“该模型主要依赖信用分(40%)、收入(25%)、还款历史(20%)做贷款决策。”技术包括特征重要性排序、决策树代理模型和偏依赖图。全局解释有助于开发者调试和审计员评估公平性。 ↩︎

特征工程:将原始数据转化为机器学习可用输入变量的过程,如类别变量数值化、交互项构造、归一化等。不当特征工程会嵌入偏见,如用邮编做特征可能因居住隔离间接歧视。 ↩︎

GDPR 第 22 条:即“解释权”,影响约 5 亿欧盟公民,并推动全球类似立法。自 2018 年实施至 2024 年,监管机构已累计罚款超 45 亿欧元,算法决策合规成为重点。全球 120 多国已制定以 GDPR 为蓝本的隐私法。 ↩︎

系统性偏见:嵌入社会系统和机构的偏见,导致不同群体结果不平等。在 ML 中,表现为历史数据反映过去歧视。例如,若历史晋升数据男性占优,模型可能学会偏向男性。研究表明,若无干预,ML 系统会因优化历史数据模式而放大既有偏见。 ↩︎

数据中心环境正义:研究显示,美国主要云计算设施中有相当比例距离低收入或少数族裔社区 10 英里以内。这些地区承受更多备用发电机污染、冷却系统热量和电网压力,却常常缺乏访问 AI 服务所需的高速网络,形成“计算公平性”鸿沟。 ↩︎

成员推断攻击:通过分析模型对特定数据的反应,判断该数据是否用于训练。Shokri 等 2017 年首次提出,因模型对训练数据更自信。若能判断某人医疗记录是否参与训练,即泄露了敏感健康信息。 ↩︎

加州消费者隐私法案(CCPA):美国加州的综合性隐私法,补充了 GDPR。赋予居民知情、删除、拒绝出售和反歧视权利。对 ML 系统,CCPA 要求数据处理文档、用户同意机制和技术能力以履行删除请求,包括从已训练模型中移除数据影响的复杂挑战。 ↩︎

对抗输入:通过微小扰动误导 ML 模型的恶意输入。Szegedy 等 2013 年首次提出,揭示了深度神经网络的根本漏洞,对自动驾驶、医疗等安全关键应用影响重大。 ↩︎

模型卡:Google 2018 年提出的 ML 模型标准化文档,类似食品营养标签,包含用途、群体性能、局限和伦理考量。Google、Facebook、IBM 等已广泛采用,便于开发者理解和审计员评估。 ↩︎

数据表:微软和华盛顿大学 2018 年提出的数据集标准化文档,仿照电子元件数据表,记录数据集创建、组成、用途和偏见。ImageNet、CIFAR-10 等主流数据集已采用,帮助评估适用性和风险。 ↩︎

数字基础设施鸿沟:美国联邦通信委员会估算,39% 的农村居民无法接入高速宽带,而城市仅为 2%。对于需实时响应的 AI 服务,欠发达地区用户会多出 200-500 毫秒延迟,使交互式可解释性和实时偏见监控难以实现。这种基础设施差距导致最易受算法伤害的群体反而最难获得伦理 AI 保护,形成“需求与可及性反比”的局面。 ↩︎

显著性图:高效的解释方法,突出输入区域(如图像像素、文本单词)对模型预测的影响。实现方式为计算输出对输入特征的梯度,利用标准反向传播(与训练同一机制)。工程优势:只需一次反向传播(约 10 毫秒开销),而 LIME/SHAP 需数百次前向推理。但梯度结果可能噪声大,易突出输入伪影,生产环境需预处理和平滑。 ↩︎

联邦学习:一种分布式机器学习方法,模型在多个设备/服务器上训练,无需集中数据。2016 年 Google 首创,用于提升 Gboard 输入预测且数据留在本地。现被 Apple(Siri)、医院(医疗研究)等采用。虽保护隐私,但因无法观测全局人口分布,公平性评估更难。 ↩︎

ML API 安全:面向外部请求的 ML 系统需 API 保护。关键防御包括速率限制(每用户 100-1000 次/秒)、输入校验(类型、范围、格式)和认证令牌。ML API 独有攻击如模型窃取(重复查询盗取模型)和对抗输入。Google Cloud AI、AWS SageMaker 等生产系统采用多层 API 安全,包括请求限流、输入净化和异常检测。 ↩︎

ML 拒绝预测:当置信度低于阈值时,模型拒绝输出预测而非强行给出结果。对安全关键系统尤为重要,拒绝预测可将错误率降低 40-70%,但覆盖率下降(10-30% 输入被拒绝)。实现方式包括置信度阈值、预测区间或集成分歧。自动驾驶遇到模糊场景会交还人工,医疗 AI 对不确定病例交由专家。 ↩︎

ML 系统遥测:对部署 ML 系统的模型性能和运行指标实时监控。现代遥测平台(如 MLflow、云监控)捕获预测延迟(1-100 毫秒)、准确率、资源利用和错误率。对检测模型漂移和失效至关重要,通常准确率下降超 5% 或延迟超 200 毫秒会触发告警。但数百模型服务多样用户时,失效路径易被掩盖,问责归因更难。 ↩︎

能耗 - 隐私权衡:斯坦福和 MIT 研究表明,差分隐私和安全多方计算等隐私保护技术会使算力能耗增加 20-60%。联邦学习场景下,移动设备电池消耗加快 15-30%。对老旧设备、续航有限或电费敏感用户,这些能耗要求会让其无法享受隐私保护 AI 服务,形成“隐私依赖经济资源”的系统。 ↩︎

测量上下文:基准假设:8x A100 GPU(训练)、T4 GPU/8 核 CPU(推理)、标准模型(ResNet-50、BERT-Base、XGBoost)、常用数据集(ImageNet、GLUE、UCI Adult/COMPAS)。数据为生产优化实现,非科研原型。开销随架构、数据集和实现质量变化很大。 ↩︎

Fairlearn:微软开源的 Python 工具包,用于测量和缓解机器学习系统中的偏见。工程上,它提供 API 计算人口统计平等、机会均等等公平性指标,并有算法调整模型预测或重训练以满足公平约束。实现方式为用 fairlearn 包装 scikit-learn 模型,应用公平性后处理或约束训练。典型开销为训练时间增加 10-30%,推理监控增加 5-15% 延迟。 ↩︎

多重校准:高级公平性技术,确保模型在大量交叉人口子群体间均校准。Úrsula Hébert-Johnson 等 2018 年提出,解决了全局校准但子群体失效的问题。需比简单阈值调优高 10-100 倍算力,可支持数千重叠群体,是服务多样人群的大平台必备。 ↩︎

k-匿名:隐私技术,确保数据集中每个体在识别属性上与至少 k-1 个体不可区分。ML 系统中通过泛化或抑制字段(如年龄段替代具体年龄、地区替代具体位置)实现。工程上需预处理管道识别准标识符、实现泛化层级并验证匿名约束,通常数据效用下降 10-30%,但能防止重识别攻击。 ↩︎

机器遗忘:无需全量重训即可移除特定训练数据影响的能力。Cao 和 Yang 2015 年首次提出,解决 GDPR“被遗忘权”等隐私法规。现代方法如 SISA(分片、隔离、切片、聚合)训练可将遗忘时间从小时降至分钟,但准确率较全量重训低 2-5%。 ↩︎

差分隐私:系统级隐私方法,通过在训练算法中添加精确校准的噪声,防止从模型中恢复单条数据。DP-SGD 实现为裁剪梯度限制个体影响,再加高斯噪声更新权重。工程上需修改训练循环,增加 15-30% 训练时间,准确率下降 2-5%。隐私保障用“隐私预算”(epsilon)量化隐私 - 效用权衡。 ↩︎

集成梯度:通过从基线到实际输入的路径积分梯度,计算特征重要性。Google Sundararajan 等 2017 年提出,满足敏感性和实现不变性等数学公理。计算成本为基础梯度的 50-200 倍,但对深度网络归因更可靠。 ↩︎

GradCAM:用梯度高亮 CNN 预测中重要图像区域的可视化技术。2017 年 Georgia Tech 等提出,适用于任意 CNN 架构,无需结构修改。广泛用于医学影像和自动驾驶,10-50ms 可生成,适合实时应用。 ↩︎

ML DevOps:面向机器学习系统的开发与运维实践,强调自动化测试、持续集成和快速部署。与传统软件不同,ML DevOps 需处理数据版本、模型训练流水线和算法变更 A/B 测试。Netflix、Uber 等公司每天自动部署数百模型。但偏见审计、可解释性测试难以自动化,导致部署速度(以小时计)与伦理验证(需数天/周)矛盾。结果是,原型阶段的伦理承诺在系统成熟后被边缘化。 ↩︎