第 18 章:可持续 AI

目标

为什么资源效率不仅仅是环境议题,而是决定机器学习系统可行性与可扩展性的核心工程约束?

机器学习系统在实际部署和经济可行性上,面临着巨大的算力资源消耗。这些资源需求带来了严苛的工程约束:高昂的能耗可能超出模型开发预算,散热极限限制了硬件密度,电力基础设施决定了部署地点。资源效率直接决定了系统的可行性、运营成本和竞争优势,使可持续性成为关键的工程学科。掌握资源优化技术,能够让工程师在满足性能目标的同时,将系统运行控制在实际的功耗、热量和经济边界之内。随着算力需求呈指数级增长,资源效率已成为决定 AI 应用能否从原型走向大规模服务全球用户的首要约束。

学习目标

通过能耗、碳足迹和资源利用等指标,量化 AI 系统的环境影响

应用测量框架,评估训练与部署架构中的可持续性权衡

评估硬件、算法和基础设施层面的能效优化工程策略

设计在功耗、热量和资源约束下运行的可持续 AI 系统

分析生物智能原理,指导能效 AI 架构开发

实施碳感知计算策略,实现负责任的 AI 系统部署

可持续 AI:一门工程学科

随着机器学习系统大规模普及,环境可持续性危机已成为制约行业发展的核心挑战。本章在 第 17 章:可信 AI 的基础上,进一步探讨算力需求与环境责任的交汇,将可持续性提升为系统工程的核心学科,而非附属考量。

现代机器学习应用的规模空前,其环境影响已堪比传统重工业。训练(详见 第 8 章:AI 训练 )一个最前沿的 AI 模型,所消耗的电力相当于 100 个美国家庭一整年的用电量,碳排放相当于数百次纽约与旧金山之间的往返航班。随着 AI 的普及,其环境成本正成为 21 世纪最重大且隐蔽的挑战之一。

现代 AI 系统的高算力密度,带来了全球基础设施的能耗压力:训练大模型所需能量可供数千户家庭长期用电,而大规模推理负载(详见 第 13 章:机器学习运维 )则推动数据中心容量和资源需求呈指数级增长。

这一环境现实,使可持续性从可选设计项转变为决定 AI 系统能否从实验室走向生产部署的核心工程约束。能耗、热量和电力基础设施等经济与物理极限,成为系统设计决策的瓶颈。算力需求的指数级增长,远超底层硬件效率提升,形成了所谓的“AI 可持续性悖论”。

但这些约束也为我们提供了将 第 9 章:高效 AI 和 第 10 章:模型优化 等系统工程方法,系统性地扩展到环境责任领域的机会。提升性能的工程方法,同样可用于能效目标。提升推理吞吐量的硬件加速技术,也能降低碳足迹。支持可扩展性的分布式计算架构,可以实现基于可再生能源的碳感知调度。

可持续 AI 定义

可持续 AI 是一门 将环境因素融入机器学习系统设计、开发与部署全流程 的 工程学科。它涵盖了 能耗测量与最小化、碳排放减少、硬件利用率优化 以及 AI 系统从制造到报废的 全生命周期环境影响管理。可持续 AI 将 资源效率 作为与性能和成本同等重要的 核心工程约束,确保系统在 地球资源边界内 实现计算目标,通过 系统化的测量、建模与减缓 环境影响,推动 AI 技术的可持续发展。

本章将可持续 AI 作为一门新兴的跨学科领域,系统性地将环境因素融入 ML 系统工程的每个环节。该学科涵盖了将算力需求转化为碳排放的建模、评估硬件全生命周期资源消耗、以及影响系统性能与环境可持续性的基础设施选择。所介绍的测量、建模与减缓框架,是与传统性能优化同等重要的工程能力。

本章内容涵盖了从算法效率优化(详见 第 9 章:高效 AI )、硬件架构选择(详见 第 11 章:AI 加速 ),到数据中心基础设施决策,再到负责任部署的政策框架,系统性地将环境因素贯穿于 ML 系统设计全流程。该方法将可持续 AI 建立为一套完整的工程框架,助力开发在地球资源边界内运行、同时释放 AI 变革潜力的系统。

AI 的可持续性危机

AI 系统推动了各行业的技术变革,但其背后的环境成本威胁着这些进步的长期可行性。AI 的算力需求带来了超越能耗的可持续性挑战,包括碳排放、资源开采、制造影响和电子垃圾,规模之大已威胁到技术发展的可持续性。

这一可持续性危机体现在三个相互关联的层面。首先,问题识别关注 AI 环境影响的范围与紧迫性,包括伦理责任和长期可行性。其次,测量与评估提供了训练(详见 第 8 章:AI 训练 )与推理(详见 第 13 章:机器学习运维 )阶段碳足迹、能耗和生命周期影响的量化框架。最后,实施与解决方案则通过可持续开发实践、基础设施优化和政策框架,提出了切实可行的环境责任减缓策略。

环境影响的规模

AI 系统的资源消耗已堪比传统重工业。训练一个大语言模型需消耗数千兆瓦时(MWh)电力,相当于数百户家庭数月用电1。预计到 2030 年,数据中心(包括 AI 负载)将占全球用电量的 8%,超过航空业(2.1%),接近水泥生产(4%)。算力需求的增长速度是硬件效率提升的 350,000 倍,形成了不可持续的指数级增长。

除了直接能耗,AI 系统还通过硬件制造和资源消耗带来环境影响。训练与推理依赖的专用处理器需用到稀土金属,其开采和加工会造成污染2。AI 应用需求的增长加速了电子垃圾的产生,全球电子垃圾年产量已达 5,400 万吨,AI 硬件因性能迭代加速,报废周期仅 3-5 年3。

这些环境挑战需要技术、政策和伦理多维度的系统性理解与协同应对,确保 AI 发展可持续且负责任。

第一部分:环境影响与伦理基础

AI 环境影响的规模,提出了关于发展优先级与责任的关键问题。在探讨测量与减缓策略前,需理解指导可持续 AI 开发的伦理框架。技术进步与环境正义的交汇,迫使我们做出谁将受益、谁承担生态成本的紧迫决策。

AI 的环境影响不仅是技术指标,更关乎公平、正义与长期可行性,决定了应对挑战的紧迫性。

能耗与硬件制造的技术现实,直接转化为环境正义的伦理关切。当训练(详见 第 8 章:AI 训练 )一个语言模型的用电量相当于数千户家庭年用电时,必须思考 AI 进步的受益者与环境成本的承担者。随着算力需求指数级增长、资源消耗加剧,行业必须在创新与环境责任之间做出艰难抉择,探索可持续发展路径。

环境正义与负责任发展

AI 的环境影响带来了超越技术优化的伦理责任。环境可持续性已成为可信 AI 系统的重要组成部分,扩展了 第 17 章:可信 AI 中的责任原则。AI 开发所需的算力资源,将环境成本集中在特定社区,而收益却分布不均。数据中心消耗全球 1-3% 的电力和每年 2000 亿加仑冷却用水,且多建于依赖化石能源、气候压力大的地区。

这种地理上的环境负担集中,带来了环境正义问题4,与更广泛的责任 AI 框架相呼应。正如公平性要求关注 AI 受益者与风险承担者,环境责任也要求理解 AI 进步的生态成本由谁承担。AI 基础设施所在社区往往承受着环境负担,却难以获得 AI 带来的经济红利,凸显了将伦理框架从算法公平扩展到环境治理的必要性。

指数级增长与物理极限

算力需求的指数级增长,挑战着 AI 训练与部署的长期可持续性。过去十年,AI 系统规模空前,2012-2019 年算力需求增长了 350,000 倍。随着模型参数量(详见 第 4 章:DNN 架构 )、训练数据集和计算复杂度的提升,这一趋势仍在持续。硬件效率提升已难以跟上 AI 负载的增长,形成了可持续性挑战。

历史上,半导体技术进步带来了计算效率提升。摩尔定律5(芯片晶体管数每两年翻一番)推动了处理能力和能效的持续提升。但摩尔定律已接近物理极限,进一步缩小晶体管变得困难且昂贵。丹纳德缩放律6(更小晶体管可降低功耗)也已终结,导致单位能效提升停滞。

AI 模型规模和能力持续提升,但硬件效率已无法同步指数级增长。这种算力需求与硬件效率的背离,导致 AI 能耗持续攀升,形成不可持续的发展轨迹。这一技术现实,凸显了可持续 AI 需要从算法到基础设施、从工程到政策的全栈协同。

训练复杂 AI 系统(如大型深度学习模型)需巨大的算力,带来显著能耗。以 OpenAI 的 GPT-3 为例,训练耗电 1,287 兆瓦时,相当于 130 户美国家庭一年的用电量。这一能耗反映了大数据集上模型参数优化的计算过程7,是现代大语言模型的典型特征。

如此规模的能耗,凸显了提升 AI 系统效率的紧迫性。近年来,生成式 AI 模型日益流行,模型参数量持续增长,训练能耗不断攀升。

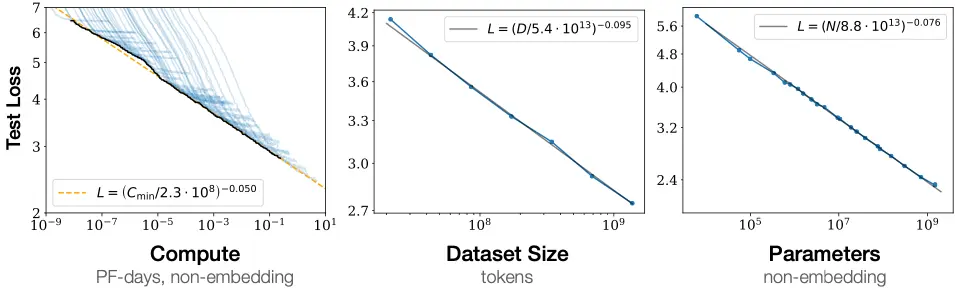

研究表明,增加模型规模、数据集和训练算力,能平滑提升性能且无明显饱和迹象。如下图所示,测试损失随三者增加而持续下降。这些“规模定律”推动了更大模型和更多数据的持续投资。除了训练,推荐系统和生成模型等 AI 应用在大规模推理阶段也持续消耗能量。随着 AI 在金融、医疗、娱乐等行业普及,AI 负载的累计能耗持续上升,引发了对大规模部署环境影响的担忧。

除了用电,AI 的可持续性挑战还体现在硬件资源需求和当前架构的能效极限。不同处理器类型的能耗特性,影响环境影响,详见 第 11 章:AI 加速 :CPU 每次乘加操作约 100 皮焦耳(pJ/MAC),GPU 为 10 pJ/MAC,TPU 达到 1 pJ/MAC8,专用加速器可低至 0.1 pJ/MAC。这些硬件平台需用到稀土金属和高碳制造工艺。

AI 芯片的生产极为耗能,涉及多道工序,成为 AI 系统全生命周期 Scope 3 排放的重要来源。随着模型规模增长,对 AI 硬件的需求加剧,进一步加重半导体制造和报废的环境影响。

生物智能:可持续性的工程范式

理解 AI 能源挑战的规模,最直观的对比是人脑。人脑能以约 20 瓦功耗完成复杂推理、学习和模式识别。这一惊人的效率为可持续 AI 设计提供了工程启示。人脑每次突触操作的能效约为 10⁻¹⁵ 至 10⁻¹⁴ 焦耳,尽管生物与数字系统的“操作”难以直接等价9。

训练一个大语言模型如 GPT-3,其能效与生物智能相比存在 10⁶ 倍的差距。这一对比凸显了核心可持续性挑战:人脑仅用灯泡级功耗即可实现卓越学习,而当前 AI 系统则需工业级能源基础设施才能完成类似任务。

人脑的高能效源于与当前 AI 系统截然不同的原理。生物系统并非持续处理所有信息,而是选择性、事件驱动地激活,仅在处理信息时消耗能量10。这些设计原则为开发更高能效的 AI 架构提供了思路。

生物智能的优势还体现在学习样本效率。儿童通过约 10^8 个词的语言输入即可掌握语言,而大语言模型需训练 10^12+ token,数据效率相差 10,000 倍。这表明当前 AI 架构与生物高效学习原理存在巨大差距。

这些洞见为可持续 AI 提供了有前景的研究方向。类脑计算11架构通过实现脉冲神经网络12,可模仿生物稀疏激活模式,实现 100-1000 倍能耗降低。类似地,受生物启发的局部学习算法和自监督学习方法,有望提升样本与能效。理解这些生物原理,为开发接近生物能效、同时保持性能的 AI 系统提供了路线图。

这些生物学启示表明,实现可持续 AI 需系统性转向事件驱动、稀疏计算架构,而非持续激活的传统模式。随着算力需求超越效率提升,解决 AI 环境影响需基于生物原理,重塑系统架构、能耗感知计算与全生命周期管理。

算力需求的指数级增长与物理效率极限的交汇,形成了威胁 AI 长期可行性的不可持续轨迹。理解这些约束,为建立测量框架和实施策略,系统性应对可持续性危机奠定了基础。

第二部分:测量与评估

系统化的测量方法为 AI 环境影响的工程决策提供了基础。可持续 AI 的发展需要针对三个关键领域的量化框架:训练与推理阶段的能耗追踪、系统全生命周期的碳足迹分析,以及硬件与基础设施的资源利用评估。这些测量工具将可持续性从抽象关切转化为具体的工程约束,指导架构选择、部署策略和优化优先级。

有效的测量让工程师能够发现优化机会、对比不同设计方案,并验证可持续性改进效果。如果没有系统性地评估环境成本的来源及设计选择对整体足迹的影响,可持续性努力就会流于零散,甚至适得其反。

碳足迹分析

碳足迹分析为 AI 系统可持续性的设计决策提供了基础。随着 AI 系统规模不断扩大,系统化地测量能耗和资源需求,使得环境优化能够前置于设计阶段。开发和部署 AI 系统的个人和企业,必须同时考虑性能、效率和环境后果。

伦理挑战在于如何平衡技术进步与生态责任。对更大模型的追求,往往优先考虑准确率和能力,而忽视能效,导致碳排放呈指数级增长。虽然可持续性优化可能带来权衡,比如开发周期延长 10-30%,或通过剪枝、量化等技术带来 1-5% 的精度损失,但这些成本远低于环境收益。从伦理角度看,将环境因素纳入 AI 系统设计已是必然。这要求行业规范向可持续计算实践转变,如能耗感知训练、低功耗硬件设计和碳感知部署策略。

这种伦理责任不仅限于可持续性,还涵盖了透明度、公平性和问责制等更广泛议题。下图(图 2)展示了 AI 开发相关的伦理挑战,将不可解释性、不公平结果和可追溯性等问题与不透明性、偏见和自动化偏差等因素关联起来。这些问题同样适用于可持续性,因为 AI 开发的环境权衡往往不透明且难以量化。能耗和碳排放缺乏可追溯性,可能导致企业在未充分理解或披露环境成本的情况下,盲目追求性能提升。

应对这些问题,需要 AI 企业提升透明度和问责制。大型科技公司运营着支撑现代 AI 应用的庞大云基础设施,但其环境影响却鲜为人知。组织应在 AI 全生命周期内测量、报告并减少碳足迹,从硬件制造到模型训练与推理。自律是第一步,但长期可持续性还需政策干预和行业标准。能耗、碳排放和效率基准等公开指标,有助于推动企业承担责任。

伦理 AI 开发需要就环境权衡展开公开讨论。研究者应在机构和组织内部倡导可持续性,确保环境议题纳入 AI 开发优先级。更广泛的 AI 社区已开始关注这些问题,例如 呼吁暂停大规模 AI 实验的公开信 ,就表达了对无序扩张的担忧。营造透明和伦理责任文化,有助于让 AI 行业在技术进步与生态可持续性之间实现平衡。

AI 有潜力重塑产业和社会,但其长期可行性取决于负责任的发展实践。伦理 AI 开发不仅要防止对个人和社区的伤害,还要确保 AI 驱动的创新不会以环境恶化为代价。作为技术的守护者,开发者和组织必须将可持续性纳入 AI 的未来发展轨迹。

将这些伦理原则落地,需要具体的工程解决方案,能够带来可衡量的环境改善。以下案例展示了如何通过 AI 系统自身的设计,优化其环境影响,体现了可持续 AI 原则的实际应用。

案例分析:DeepMind 提升数据中心能效

Google 的数据中心是 Search、Gmail 和 YouTube 等服务的基础,每天处理数十亿次请求。这些设施消耗大量电力,尤其是用于保障服务器性能的冷却系统。提升数据中心能效一直是重点,但传统工程方法在面对冷却系统复杂性和动态环境条件时,优化空间有限。为此,Google 联合 DeepMind 开发了机器学习优化系统,实现了大规模的能耗自动管理。

在优化数据中心设计、能效硬件和可再生能源集成十余年后,DeepMind 的 AI 方法聚焦于冷却系统——数据中心最耗能的环节之一。传统冷却依赖人工设定的启发式规则,考虑服务器发热、外部气候和建筑约束等因素。由于系统存在非线性耦合,简单的规则往往无法捕捉全部复杂性,导致冷却效率低下,能源浪费严重。

DeepMind 团队利用 Google 的历史传感器数据(包括实时温度、电力消耗、冷却泵运行等参数)训练神经网络模型,学习这些因素间的复杂关系,并能动态预测最优冷却配置。与传统依赖工程师定期调整系统不同,AI 模型可实时适应环境和负载变化,持续优化能效。

实际部署结果显示,DeepMind 的 AI 冷却系统将冷却能耗降低了 40%,整体 PUE(电力使用效率)提升 15%13。PUE 是衡量数据中心能效的行业标准,表示总能耗与 IT 设备能耗之比。这一提升无需额外硬件改造,充分展示了软件驱动优化在降低 AI 碳足迹方面的潜力。

不仅如此,DeepMind 的 AI 模型还可适配不同设计和气候条件,为全球数据中心网络的能耗优化提供了可扩展方案。该案例表明,AI 不仅是算力资源的消耗者,也能成为推动可持续性的工具,提升支撑机器学习的基础设施效率。

数据驱动决策、实时自适应和可扩展 AI 模型的结合,展示了智能资源管理在可持续 AI 系统设计中的作用。机器学习优化自身基础设施,为大规模 AI 部署实现更高能效提供了范例。

碳足迹分析需同时考察生命周期阶段和排放范围。下文介绍的“三阶段生命周期评估框架”,为理解环境成本来源及设计选择对整体足迹的影响提供了系统方法。

三阶段生命周期评估框架

有效的碳足迹测量需系统性分析三个决定环境影响的阶段:

训练阶段(占排放 60-80%)是碳排放最高的时期,涉及大规模并行计算和数学优化14。以 GPT-3 为例,大语言模型训练极为耗能。地理位置影响巨大:在魁北克(以水电为主,0.01 kg CO₂/kWh)训练,与在西弗吉尼亚(以煤电为主,0.75 kg CO₂/kWh)相比,碳强度相差 75 倍15。

推理阶段(占排放 15-25%)则是模型服务和预测生成的持续计算成本。单次推理计算量虽小,但大规模部署和高频使用下,累计排放可在长期超过训练阶段。

制造阶段(占排放 5-15%)则是硬件生产带来的“隐含碳”16,包括半导体制造、稀土开采和供应链物流。该部分常被忽视,但属于无法通过运营优化消除的基线排放。

地理与时序优化

碳强度因地理和时段差异巨大,带来优化空间。通过将计算任务调度到可再生能源高峰时段(如白天太阳能高峰),可将排放降低 50-80%。碳感知调度系统可自动将非紧急训练任务迁移到碳强度更低的地区和时段。

这些地理与时序因素凸显了量化 AI 碳影响的复杂性。评估需综合模型规模、训练时长、硬件类型和数据中心能源结构等多重因素。以 GPT-3 为例,大型 AI 模型训练需数千兆瓦时电力,相当于一个社区的用电量。推理阶段(如实时翻译、图像生成、个性化推荐)同样能耗巨大。与传统软件不同,AI 模型推理能耗持续增长,带来长期可持续性挑战。

除直接能耗外,AI 的碳足迹还包括硬件生产和供应链的间接排放。制造 GPU、TPU 等 AI 加速器需高能耗工艺和稀土金属,供应链复杂。AI 系统的全生命周期排放(涵盖数据中心、硬件制造和全球部署)必须纳入考量,才能制定更可持续的实践。

理解 AI 碳足迹需整合上述测量框架:

- 三阶段生命周期分析:训练(60-80%)、推理(15-25%)、制造(5-15%)排放

- 三类排放范围:直接运营、购电、供应链影响

- 地理与时序优化:利用可再生能源和碳感知调度

分析这些要素,有助于更准确评估 AI 系统的真实环境影响,并通过高效设计、能耗感知部署和可持续基础设施选择,发现减排机会。

开发阶段的碳足迹测量需将追踪工具集成到 ML 工作流中,见代码示例 1。

代码示例 1:碳足迹追踪:使用 CodeCarbon 库在模型训练期间测量排放,为数据驱动的可持续性决策提供依据。

from codecarbon import EmissionsTracker

import torch

# 初始化碳排放追踪器

tracker = EmissionsTracker()

tracker.start()

# 模型训练代码

model = torch.nn.Linear(100, 10)

optimizer = torch.optim.Adam(model.parameters())

for epoch in range(100):

# 训练步骤

loss = model(data).mean()

loss.backward()

optimizer.step()

# 获取排放报告

emissions = tracker.stop()

print(f"Training emissions: {emissions:.4f} kg CO2")

数据中心能耗模式

AI 系统是最耗能的计算负载之一,涉及密集运算17,其能耗贯穿训练、推理、数据存储和通信基础设施。理解这些模式有助于发现优化空间,实现环境影响减缓。能耗随模型复杂度呈非线性增长,针对性架构和运维优化可带来显著能效提升。

数据中心能耗与 AI 负载

数据中心是 AI 系统的主要能耗来源,其用电规模既反映了挑战,也揭示了优化机会。

数据中心能效差异巨大:PUE 从 Google 最优设施的 1.1 到普通企业数据中心的 2.5,后者的基础设施开销几乎翻倍。地理位置影响碳强度:同一模型在魁北克(水电)与西弗吉尼亚(煤电)训练,单位电量碳排放相差 10 倍。缺乏可再生能源时,数据中心高度依赖煤炭和天然气,推高全球碳排放。当前估算,数据中心占全球 CO₂ 排放的 2%,接近航空业。AI 能耗预计将因数据中心扩容、训练负载和推理需求增长而呈指数级上升。如不加干预,AI 的环境足迹将变得不可持续。

数据中心的能耗需求

AI 负载是现代数据中心中最密集的计算任务。Meta 等公司运营着占地数十个足球场、容纳数十万台 AI 优化服务器的超大规模数据中心18。训练(详见 第 8 章:AI 训练 )大语言模型(如 GPT-4)需 25,000 多块 Nvidia A100 GPU 持续运行 90-100 天,消耗数千兆瓦时电力。这些设施依赖高性能 AI 加速器(如 NVIDIA DGX H100),单台峰值功耗可达 10.2 kW。硬件代际能效差异明显:H100 GPU 训练能效比 A100 提升 2.5-3 倍,混合精度训练可根据模型和硬件将能耗降低 15-30%,且精度损失极小。

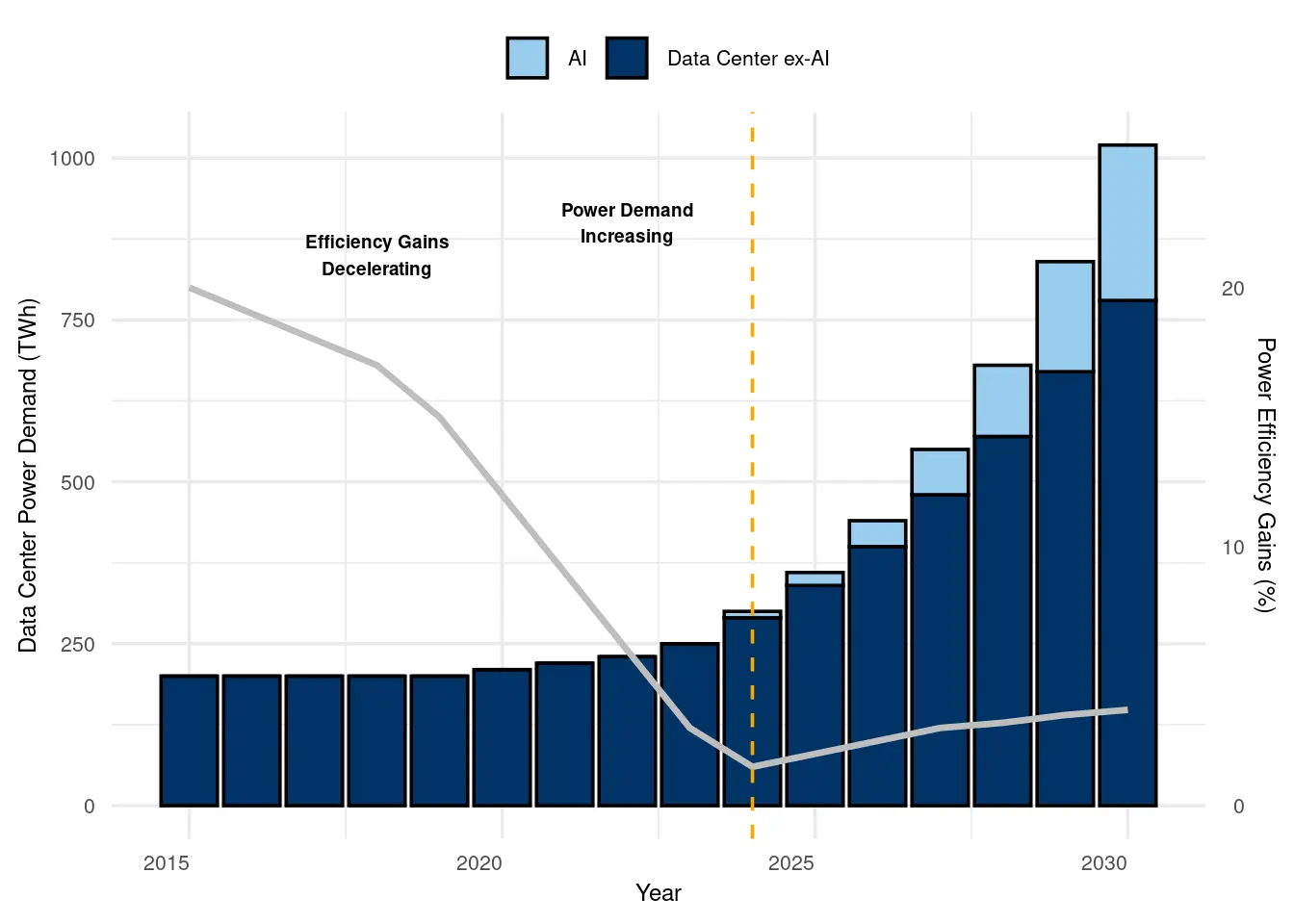

如此巨大的能耗,反映了 AI 在各行业的快速普及。如下图(图 3)所示,AI 负载的能耗预计将大幅提升数据中心总能耗,尤其在 2024 年后。虽然效率提升部分抵消了用电增长,但提升速度放缓,AI 的环境影响日益突出。

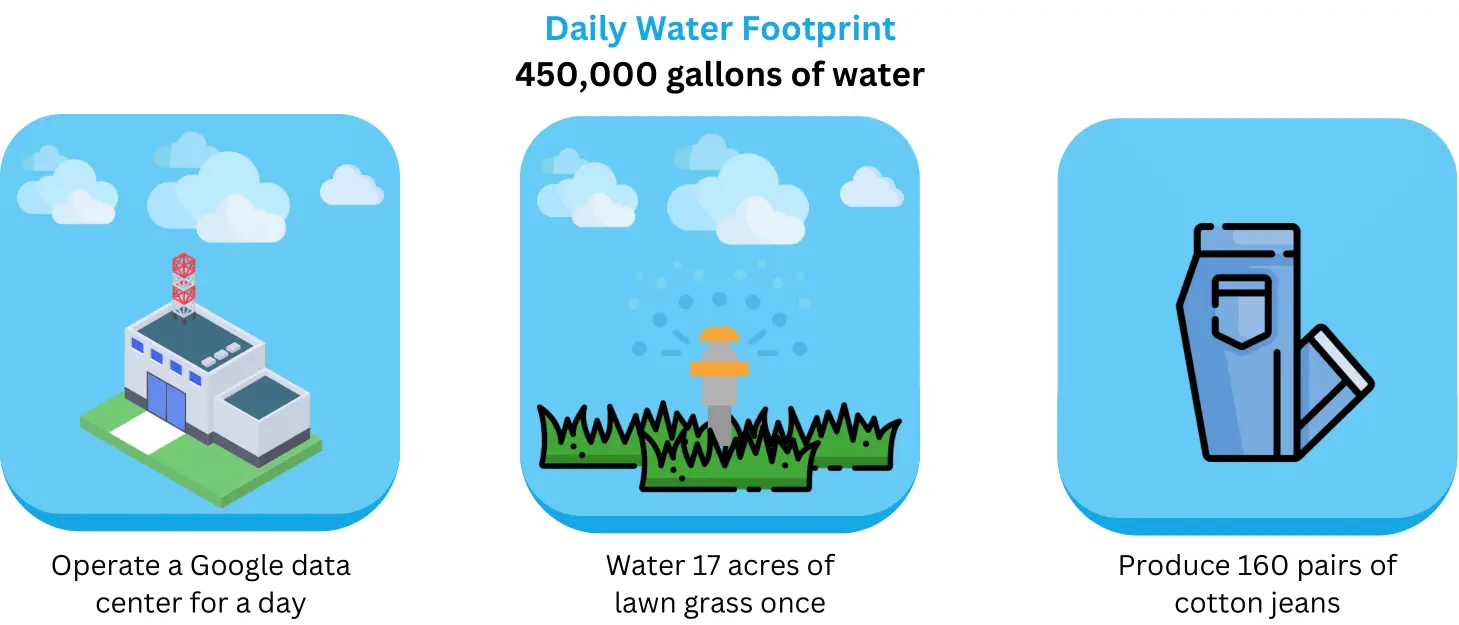

除计算负载外,冷却也是 AI 能耗的重要组成。大规模训练和推理产生大量热量,需先进冷却方案防止硬件故障。企业已采用替代冷却方式降低能耗。例如微软爱尔兰数据中心利用附近峡湾,每天消耗 50 多万加仑海水散热。但随着 AI 模型复杂度提升,冷却需求持续增长,可持续基础设施设计成为紧迫挑战。

分布式系统能耗优化

大规模 AI 训练本质上需要分布式系统协作,带来额外能耗开销。分布式训练19引入的网络通信成本,在大型集群中可占总能耗的 20-40%。数千 GPU 的分布式训练需持续同步计算更新和模型参数20,节点间数据传输量巨大。通信开销扩展性差:集群规模翻倍,网络能耗可增至 4 倍,因梯度聚合采用全互联通信模式。

为降低通信开销,集群级能耗优化需超越单机效率,进行资源协同管理。动态负载调度可在低负载时将训练任务集中到更少节点,使闲置硬件进入低功耗状态,节能 15-25%。智能调度跨数据中心协调训练,利用时区差异和区域可再生能源,可通过时序负载均衡将碳强度降低 30-50%。

基础设施共享是可持续性分析中常被忽视的效率机会。多租户训练环境下,多模型训练作业共享同一集群,可将 GPU 利用率从 40-60% 提升至 80-90%,有效将单模型能耗减半。资源共享还支持批处理优化,将多个小型训练作业合并,提升算力利用率,降低维护闲置基础设施的能耗。

AI 能耗与其他行业对比

AI 负载的环境影响已引发关注,其碳排放接近传统高碳行业。研究显示,训练一个大型 AI 模型的碳排放,相当于多辆乘用车全生命周期排放。下图(图 4)将大规模机器学习任务的碳排放与洲际航班等日常活动对比,直观展示了训练和推理负载的能耗。图中从最低到最高依次为纽约 - 旧金山往返航班、平均人类年排放、美国人年排放、美国汽车全生命周期、以及神经架构搜索的 Transformer 模型21,后者碳足迹最高。这些对比凸显了推动 AI 可持续实践、减缓行业碳影响的必要性。

大型自然语言处理模型训练阶段的 CO₂ 排放,相当于数百次洲际航班。从行业整体看,AI 的总算力碳足迹正逼近民航业。随着 AI 应用服务全球数十亿用户,持续推理的累计排放最终可能超过训练阶段。

下图(图 5)展示了 Meta 各类大规模机器学习任务的碳排放,量化了不同 AI 应用和架构的环境影响。这一评估凸显了开发和部署更可持续机器学习方法的紧迫性。理解这些环境成本,是实施有效减缓策略、推动行业负责任发展的基础。

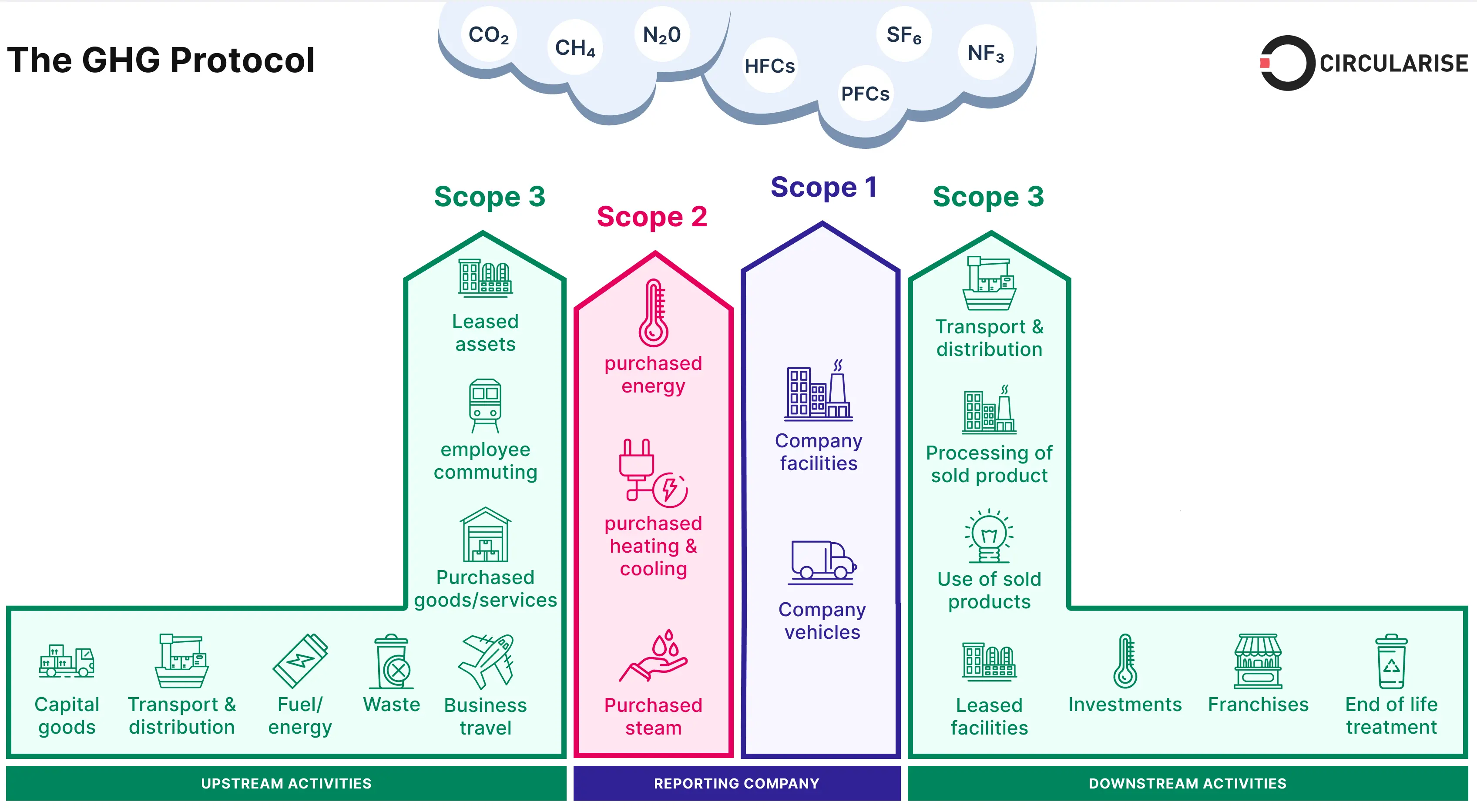

碳足迹的纵向分析

AI 的影响不仅限于运行期间的能耗。其全生命周期排放还包括硬件制造、供应链和报废处理,使 AI 成为环境退化的重要推手。AI 模型训练和推理需电力,还依赖半导体制造、稀土开采和电子垃圾处理等复杂基础设施。下一节将碳排放细分为 Scope 1(直接排放)、Scope 2(购电间接排放)和 Scope 3(供应链与全生命周期排放),以更细致地呈现其环境影响。

全面碳核算方法

全面的碳足迹评估需将三阶段生命周期分析(训练、推理、制造)与三类排放范围(直接运营、购电、供应链)结合。预计到 2030 年,AI 年复合增长率达 37.3%,算力能耗或将增长 1000 倍。这一指数级扩张要求理解各阶段和范围的总生命周期成本,才能发现最具影响力的可持续干预点。

Scope 1(5-15%)为现场发电(如柴油发电机)、冷却系统和自有电厂的直接排放。多数 AI 数据中心以电网供电为主,但自有化石能源备份系统或自建电厂会带来直接排放。

Scope 2(60-75%)为购电间接排放,是 AI 基础设施运营的主导排放,受地理和电网结构影响极大。同一模型在魁北克(水电)与西弗吉尼亚(煤电)训练,碳强度相差 75 倍。

Scope 3(15-25%)最复杂,涵盖硬件制造、运输和报废。半导体制造22碳排放极高:生产一块高性能 AI 加速器的排放,相当于数年运营能耗。该部分常被忽视,但属于无法通过运营优化消除的基线排放。

Scope 3 还包括 AI 部署后的下游影响。搜索引擎、社交平台和云推荐系统等 AI 服务规模巨大,需持续推理,累计能耗最终可能超过训练。终端设备(如手机、IoT、边缘计算23)也贡献 Scope 3 排放,其 AI 功能需持续计算。Meta、Google 等公司报告,AI 服务的 Scope 3 排放占其总环境足迹最大份额,因 AI 运行规模极大。

软件开发的隐形碳成本

除训练和推理能耗外,AI 软件开发生态本身也有巨大但难以量化的碳足迹。数以百万计的 CI/CD 流水线、开发过程中的持续编译、大型版本控制系统(如 GitHub)、代码评审、自动化测试和协作平台都消耗大量算力。大型 AI 研究机构常运行数千次实验训练,大多未进入生产,探索过程本身能耗巨大。这说明 AI 生态的能耗远不止最终模型训练和推理阶段。

这些超大设施为复杂神经网络在海量数据集上的训练提供基础。例如,行业分析显示,OpenAI 的 GPT-4 在 Azure 数据中心用 25,000 多块 Nvidia A100 GPU 持续训练 90-100 天。

GHG Protocol 框架(见下图,图 6)为可视化 AI 相关碳排放来源提供了结构化方法。该框架将排放分为三类,帮助组织全面理解环境影响:

- Scope 1(直接排放):来自公司自有运营,如数据中心柴油发电机和自有电厂。比如停电时数据中心后方轰鸣的柴油机。

- Scope 2(购电间接排放):来自电网购电,是云计算负载的主排放来源。即为数千块 GPU 供电的发电厂。

- Scope 3(价值链排放):超出组织直接控制,涵盖半导体制造、跨洋运输和 AI 加速器最终报废。

理解这一结构,有助于制定更有针对性的可持续策略,确保减排努力不仅聚焦能效,还覆盖供应链和全生命周期的重大排放。

训练与推理能耗分析

准确评估环境影响需理解训练与推理阶段的能耗模式。训练是一次性高强度计算,创造可复用模型能力。推理则是持续能耗,随部署规模和使用频率动态增长。对于大规模 AI 服务,长期推理能耗常超过训练。

生命周期视角揭示了不同阶段的优化机会。训练优化聚焦计算效率和硬件利用,推理优化则强调延迟、吞吐和边缘部署。理解这些权衡,有助于针对不同 AI 应用的主导能耗环节实施可持续干预。

训练能耗需求

训练最前沿 AI 模型需巨量算力,依赖数十万核和专用加速器持续运行数月。OpenAI 的专用超级计算机包含 28.5 万 CPU 核、1 万 GPU,单服务器带宽超 400 Gbps,充分体现了训练基础设施的规模和能耗。

高强度计算带来大量热量,需庞大冷却系统,进一步推高总能耗。训练系统的架构和硬件优化需专业 AI 加速技术,算法层的训练效率优化也极为复杂。

这些能耗仅在模型训练时发生。主要的可持续性挑战在于模型部署后,推理负载需持续服务数百万乃至数十亿用户。

推理能耗成本

每当 AI 模型响应查询、图像分类或做出预测时,都会产生推理能耗。与训练不同,推理在搜索、推荐、生成式 AI 等应用中持续扩展。单次推理能耗虽远低于训练,但每日数十亿次 AI 交互的累计能耗很快超过训练。

例如,AI 搜索引擎每日处理数十亿请求,推荐系统持续个性化内容,生成式 AI(如 ChatGPT、DALL-E)单次推理计算量也很大。Transformer 模型推理能耗高,因其对内存和带宽要求极高。

如下图(图 7)所示,数据中心推理市场规模预计将从 2017 年的 40-50 亿美元增长到 2025 年的 90-100 亿美元,翻倍增长。边缘推理市场也将从不足 1 亿美元增至 40-45 亿美元。推理市场扩张速度远超训练,说明运行 AI 应用的能耗正成为主导成本。

与传统软件的固定能耗不同,推理负载随用户需求动态扩展。Alexa、Siri、Google Assistant 等 AI 服务依赖持续云端推理,每分钟处理数百万语音请求,需数据中心基础设施 24 小时不间断运行。

边缘 AI 影响

推理并非总在大型数据中心完成。边缘 AI 正成为降低云依赖的可行方案。部分 AI 模型可直接部署在用户设备或边缘节点,减少数据传输能耗和对高功耗云推理的依赖。

但大规模部署时,边缘推理同样存在能耗问题。自动驾驶等场景需毫秒级推理,云端处理不可行,车辆需配备板载 AI 加速器,相当于“车轮上的数据中心”,即便不依赖云推理,单车能耗也很高。

同样,手机、可穿戴和 IoT 传感器等消费设备单体能耗虽低,但数量庞大,累计能耗巨大。因此,边缘计算的效率优势需与设备规模的能耗权衡。

资源消耗与生态影响

碳足迹分析虽关键,但无法全面反映 AI 的环境影响。完整评估还需量化水资源消耗、有害化学品使用、稀有材料开采和生物多样性破坏等生态影响,这些往往被忽视但极具生态意义。

现代半导体工厂生产 AI 芯片需每日数百万加仑水,并使用 250 多种有害物质。在台湾、亚利桑那、新加坡等水资源紧张地区,这种高强度用水威胁当地生态和社区。AI 硬件还高度依赖镓、铟、砷、氦等稀缺材料,存在地缘风险和枯竭隐患。

全面影响评估有助于发现能耗之外的环境热点,制定覆盖 AI 系统全生态足迹的减缓策略。

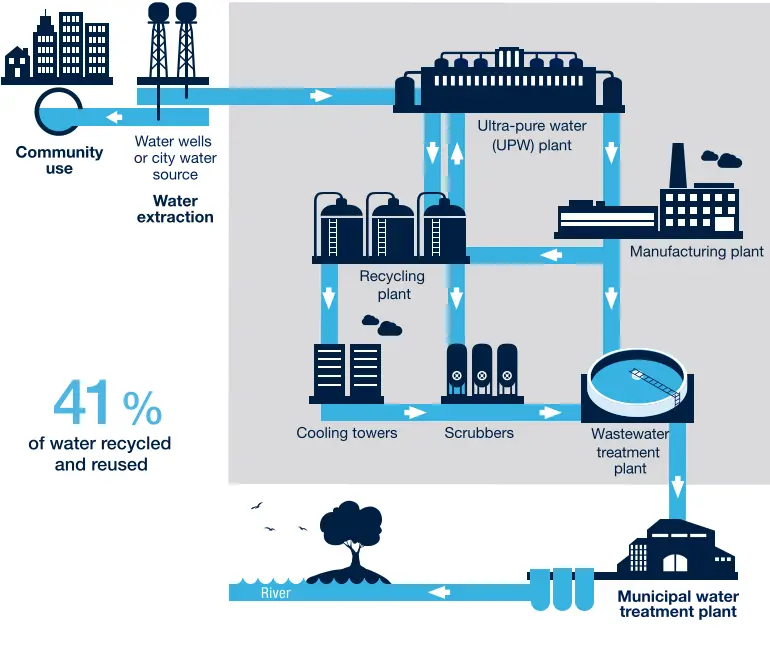

用水消耗

半导体制造极度依赖水资源,需大量超纯水用于清洗、冷却和化学处理。现代工厂的用水量堪比城市人口。例如台积电亚利桑那新厂预计每日用水 890 万加仑,占全市供水近 3%。在台湾、亚利桑那、新加坡等水资源紧张地区,半导体制造压力尤大。企业正投资回收技术和高效用水管理。意法半导体约 41% 用水实现回收,大幅降低环境足迹。下图(图 8)展示了典型半导体厂的水循环流程,从原水取用到废水处理和回用。

超纯水主要用于各生产阶段冲洗晶圆杂质,也用于热氧化、化学沉积和平坦化等工艺的冷却和载体。单片 300mm 硅片全流程需 8,300 升水,超纯水占比超三分之二。

如此巨量用水带来的影响远不止消耗。过度抽取地下水会导致水位下降,引发地面沉降和海水入侵等问题。在台湾新竹等半导体重镇,工厂大量抽水已导致地下水位下降和海水渗入,影响农业和饮用水。

下图(图 9)将数据中心的日用水量与其他工业用途对比,直观展示了高科技基础设施的用水需求。

部分半导体企业已实施水回收系统,但效果差异较大。英特尔报告其直接用水的 97% 用于制造,尽管回用比例提升,但总用水量依然巨大。

除消耗外,半导体厂废水若处理不当会带来污染风险。废水含金属、酸和化学残留,需彻底净化后才能排放。现代工厂虽有先进净化系统,但提取出的有害副产物若处置不当,仍威胁本地生态。

AI 加速和算力基础设施扩张推动半导体制造需求增长,使水资源管理成为可持续 AI 的关键。保障半导体生产长期可行性,不仅需降低直接用水,还需提升废水处理和开发替代冷却技术,减少对淡水的依赖。

有害化学品

半导体制造高度依赖有害化学品,广泛用于刻蚀、掺杂和清洗。AI 硬件(GPU、TPU 等)制造需用强酸、挥发性溶剂和有毒气体,若管理不善将带来健康和环境风险。工厂每年消耗数千吨有害物质。

刻蚀和去氧化常用强酸,如氢氟酸、硫酸、硝酸和盐酸。这些酸虽高效,但极具腐蚀性和毒性,操作不当可致严重灼伤和呼吸损伤。大型工厂需专门的密闭、过滤和中和系统防止泄漏和污染。

溶剂主要用于溶解光刻胶和清洗晶圆,如二甲苯、甲醇和 MIBK。这些溶剂为挥发性有机物(VOC),易挥发成空气,造成室内外污染。VOC 暴露可致神经损伤和呼吸问题,长期影响工人健康。

毒性气体如砷烷、磷烷、二硼烷和锗烷用于掺杂和化学气相沉积,是调控半导体性能的关键。这些气体极毒,低浓度即可致命,需严格防护、气体净化和应急预案。

尽管现代工厂有严格安全措施和化学处理系统,事故仍时有发生,导致泄漏和污染。AI 加速器制造工艺日益复杂,对新型化学品的需求不断增长,管理难度加大。

除直接安全风险外,有害化学品的长期环境影响也是重大可持续性问题。工厂产生大量化学废弃物,若处理不当会污染地下水、土壤和生态系统。许多国家要求中和和净化后才能排放,但全球合规和执法水平不一,环境保护效果参差不齐。

为降低风险,工厂需持续推进绿色化学,探索低毒替代品,优化工艺减少废弃物,提升回收利用,降低 AI 硬件生产的环境足迹。

资源枯竭

硅资源丰富,但 AI 加速器、GPU 和专用芯片制造依赖稀缺且地缘敏感的材料。AI 硬件需多种稀有金属、惰性气体和半导体化合物,许多面临供应瓶颈、地缘风险和环境开采成本。随着 AI 模型规模和算力需求增长,对这些材料的需求持续上升,长期可用性和可持续性令人担忧。

高性能 AI 芯片依赖镓、铟、砷等稀有元素,支撑高速低功耗电子器件。镓和铟广泛用于化合物半导体,尤其在 5G、光电子和 AI 加速器领域。美国地质调查局已将铟列为关键材料,按当前消耗速度,全球储量不足 15 年。

氦气是半导体冷却、等离子刻蚀和 EUV 光刻的关键惰性气体。氦一旦释放即逸散至太空,无法回收,是不可再生资源。半导体行业为氦气最大用户,供应短缺已导致价格飙升和生产中断。

稀土供应的地缘垄断也带来挑战。中国掌控全球 90% 以上稀土精炼能力24,包括 AI 芯片所需的钕(高性能磁体)和钇(高温超导体)。供应链高度集中,贸易摩擦或地缘冲突将严重影响 AI 硬件生产。

下表(表 1)列举了 AI 半导体制造的关键材料、应用及供应风险。

| 材料 | AI 半导体制造应用 | 供应风险 |

|---|---|---|

| 硅(Si) | 芯片基底、晶圆、晶体管 | 加工瓶颈、地缘风险 |

| 镓(Ga) | GaN 功率放大器、高频元件 | 储量有限、为铝锌副产品 |

| 锗(Ge) | 高速晶体管、光电探测器、光互连 | 稀缺、地理集中 |

| 铟(In) | ITO、光电子 | 储量有限、依赖回收 |

| 钽(Ta) | 电容器、稳定集成元件 | 冲突矿产、供应链脆弱 |

| 稀土元素(REEs) | 磁体、传感器、高性能电子 | 高地缘风险、环境开采问题 |

| 钴(Co) | 边缘设备电池 | 人权问题、地理集中(刚果) |

| 钨(W) | 互连、屏障、散热器 | 产地有限、地缘风险 |

| 铜(Cu) | 互连、屏障、散热器 | 高纯度资源有限、地缘风险 |

| 氦(He) | 半导体冷却、等离子刻蚀、EUV 光刻 | 不可再生、大气逸散、开采能力有限 |

AI 基础设施向光互连转型,进一步加剧了材料挑战。Google TPU、Mellanox 等高性能互连方案日益依赖光学技术,以满足分布式训练和推理的带宽需求。光互连带来更高带宽(如 TPUv4 达 400 Gbps)、更低功耗和抗电磁干扰优势,但对锗等材料依赖增强。AI 系统采用光互连后,对锗基元件的需求将加剧供应链脆弱性,凸显 AI 基础设施材料可持续规划的重要性。

废弃物产生

半导体制造产生大量有害废弃物,包括气体、VOC、化学废水和固体毒性副产物。AI 加速器、GPU 等高性能芯片生产涉及多道化学处理、刻蚀和清洗工序,每一步都产生需妥善处理的废弃物。

工厂在化学气相沉积(CVD)、等离子刻蚀和离子注入等环节排放气体废弃物,包括砷烷、磷烷、锗烷等有毒腐蚀性气体,需高效净化后才能排放。若过滤不彻底,这些气体将危害健康并加剧空气污染和酸雨。

VOC 是另一大类废弃物,主要来自光刻胶处理、清洗溶剂和涂层。二甲苯、丙酮、甲醇等易挥发成空气,导致地面臭氧和工厂室内空气污染。台湾、韩国等半导体重镇已实施严格 VOC 排放管控。

半导体厂还产生大量废酸和含金属废水,需彻底中和和过滤后才能排放。硫酸、氢氟酸、硝酸等强酸用于刻蚀硅片,去除多余材料。废酸含重金属、氟化物和化学残留,若处理不当会污染地下水。历史上多次因废水管理不善导致地下水污染,凸显废弃物管理系统的重要性。

AI 硬件制造的固体废弃物包括污泥、滤饼和化学残渣,常含高浓度重金属、稀土和半导体工艺化学品,常规填埋处理存在环境风险。部分工厂焚烧有毒废弃物,带来空气污染和有毒灰渣处置问题。

除制造废弃物外,AI 硬件报废也带来可持续性挑战。AI 加速器、GPU 和服务器硬件更新周期短,数据中心设备通常 3-5 年即更换,每年产生数百万吨电子垃圾,含铅、镉、汞等有毒重金属。尽管电子回收力度加大,全球回收率仅 17.4%,大部分仍被填埋或非法处理。

应对 AI 废弃物影响需推动半导体制造和电子垃圾回收技术进步。企业正探索稀有金属闭环回收、化学废弃物处理优化和低毒替代材料。随着 AI 模型对高性能芯片和大规模算力基础设施需求增长,行业能否管理好废弃物足迹,将成为实现可持续 AI 的关键。

生物多样性影响

AI 硬件的环境足迹不仅限于碳排放、资源枯竭和有害废弃物。半导体工厂、数据中心及其配套基础设施的建设和运营,直接影响自然生态系统,导致栖息地破坏、水资源压力和污染。这些环境变化对野生动物、植物和水生生态系统有深远影响,凸显了可持续 AI 发展需兼顾更广泛生态效应。

半导体厂和数据中心需大面积土地,常导致森林砍伐和自然栖息地破坏。尽管多建于工业园或城市周边,但随着 AI 硬件需求增长,工厂正向未开发区域扩张,侵占森林、湿地和农田。

AI 基础设施的物理扩张破坏了野生动物迁徙通道,道路、管道、输电塔和供应链割裂了自然景观。依赖大面积连通生态系统的物种(如候鸟、大型哺乳动物、传粉昆虫)迁徙受阻,基因多样性和种群稳定性下降。台湾、韩国等半导体密集区,栖息地丧失已导致生物多样性下降。

半导体厂巨量用水对水生生态系统构成严重威胁,尤其在水资源紧张地区。AI 芯片生产过度抽取地下水,导致水位下降,影响河流、湖泊和湿地。在台湾新竹,工厂每日抽水数百万加仑,已出现海水入侵,改变水体化学性质,不利于本地鱼类和植被。

废水排放带来化学污染风险。尽管多数工厂有先进过滤和回收系统,微量重金属、氟化物和溶剂仍可能积累于水体,生物富集于鱼类,破坏水生生态。数据中心热水排放提升水温,影响本地物种的耐受性、氧气水平和繁殖周期。

半导体厂排放多种空气污染物,包括 VOC、酸雾和金属颗粒,可远距离沉降。空气污染和酸沉降损害植物、土壤和农田。空气化学沉降已导致树木衰退、作物减产和土壤酸化,尤其在半导体工业区。VOC 高排放区,植物生长受抑,影响生态韧性和食物链。化学品泄漏或气体泄露事故对野生动物和人类均有严重风险,需严格监管防止长期生态损害。

AI 硬件制造的环境后果,凸显了推动可持续半导体生产的紧迫性,包括减少土地占用、提升水回收和加强排放管控。若不加干预,AI 芯片需求的加速增长将进一步加剧全球生物多样性压力,强调了在技术进步与生态责任间寻求平衡的重要性。

硬件全生命周期环境评估

AI 系统的环境足迹不仅体现在模型训练和推理阶段的能耗。要全面评估 AI 的可持续性,必须覆盖从硬件制造所需原材料的开采,到最终计算基础设施的报废处理的整个生命周期。生命周期分析(LCA)25为量化 AI 在设计、制造、使用和处置四大阶段的累计环境影响,提供了系统化方法。

通过将 LCA 应用于 AI 系统,研究者和政策制定者可精准定位减排、提升资源效率和实施可持续实践的关键干预点。这一方法让我们从整体上理解 AI 的生态成本,将可持续性考量从运营能耗扩展到硬件供应链和电子废弃物管理。

下图(图 10)展示了 AI 系统生命周期的四个主要阶段,每一阶段都对总环境足迹有贡献。

每个生命周期阶段都带来独特的环境影响和可持续性挑战,从设计优化到制造再到部署运维。

设计阶段

AI 系统的设计阶段涵盖模型的研究、开发与优化,部署前需多次迭代架构、调整超参数、反复训练实验以提升性能。这一过程极为耗算力,需大量硬件资源和能耗。AI 模型设计的环境成本常被低估,但反复训练、算法改进和探索性实验对整体可持续性影响巨大。

开发 AI 模型需多次实验以确定最优架构。自动化架构搜索(NAS)26可自动评估数百甚至数千种结构,每种都需单独训练。同样,超参数调优需反复调整学习率、批量大小、优化器等参数,常用穷举搜索。预训练和微调进一步加大算力需求,模型需在不同数据集上多轮训练。如此反复迭代导致能耗极高,超参数调优和架构搜索对训练相关排放贡献巨大。

以 GPT-3 为例,其公开的训练能耗仅反映最终训练轮次,未计入前期大量试错,实际能耗远高于报告值。深度强化学习如 AlphaZero,需反复训练以优化策略,进一步放大能耗。

AI 设计阶段的碳足迹因所需算力和数据中心能源结构差异极大。有研究指出,训练单个大规模 NLP 模型的排放,相当于 5 辆汽车全生命周期碳足迹。若在以化石能源为主的数据中心(如美国弗吉尼亚州煤电)训练,排放更高;而水电或核电地区则显著降低。硬件选择同样影响排放,采用高能效的 TPU 可大幅优于传统 GPU。

下表(表 2)总结了不同 AI 模型训练的碳排放估算,直观展示了模型复杂度与环境影响的相关性。

| AI 模型 | 训练 FLOPs | 估算 $\textrm{CO}_2$ 排放(kg) | 等效汽车里程 |

|---|---|---|---|

| GPT-3 | $3.1 \times 10^{23}$ | 502,000 kg | 120 万英里 |

| T5-11B | $2.3 \times 10^{22}$ | 85,000 kg | 21 万英里 |

| BERT (Base) | $3.3 \times 10^{18}$ | 650 kg | 1,500 英里 |

| ResNet-50 | $2.0 \times 10^{17}$ | 35 kg | 80 英里 |

应对设计阶段的可持续性挑战,需要在训练效率和算力管理上创新。研究者已探索稀疏训练、低精度计算、权重共享等方法,在不牺牲性能的前提下减少计算量。预训练模型的广泛应用,也有助于降低资源消耗。通过微调小型预训练网络,利用已有知识,可在低算力下取得类似效果。

优化模型搜索算法同样有助于可持续性。传统 NAS 需评估大量候选架构,最新的能效感知 NAS 则通过减少训练轮次优先筛选高效结构。企业也开始实施碳感知计算策略,将训练任务调度到碳强度低的时段或清洁能源数据中心。

设计阶段为 AI 全生命周期奠定基础,影响训练和推理阶段的能耗。随着模型复杂度提升,开发流程必须重审,将可持续性纳入每一环节。模型设计决策不仅决定计算效率,也塑造了 AI 技术的长期环境足迹。

制造阶段

AI 系统制造阶段是生命周期中资源消耗最密集的环节,涉及 GPU、TPU、FPGA 等专用半导体硬件的生产。芯片制造需大规模工业流程,包括原材料开采、晶圆制造、光刻、掺杂和封装,每一步都对环境有重大影响。该阶段不仅能耗高,还会产生有害废弃物,依赖稀缺材料,并加剧资源枯竭。

制造材料

AI 硬件的基础是半导体,主要为硅基集成电路。但现代 AI 芯片远不止硅,还需镓、铟、砷、氦等特殊材料,这些材料因稀缺、地缘敏感和高能耗开采而被列为关键元素。

硅资源丰富,但提纯为高纯度晶圆需极高能耗。单片 300mm 晶圆制造需 8,300 升水,并用氢氟酸、硫酸、硝酸等强酸刻蚀清洗。半导体制造对超纯水的需求给本地水资源带来巨大压力,领先工厂每日用水达数百万加仑。

除硅外,镓和铟是高性能化合物半导体(如 AI 加速器、5G 通信)的关键。美国地质调查局已将铟列为极度濒危材料,按当前消耗速度全球储量不足 15 年。氦气是芯片制造的关键冷却剂,不可再生,一旦释放即永久流失。AI 硬件制造的持续扩张正加速这些关键元素的枯竭,长期可持续性堪忧。

EUV 光刻等先进工艺进一步加重了半导体制造的环境负担。EUV 系统需高功率激光和复杂光学,每台设备耗电约 1 兆瓦,极大提升了先进芯片生产的碳足迹。

制造能耗

AI 硬件制造所需能耗极高,单芯片的总能耗常超过其整个运营生命周期。单块 AI 加速器的制造排放,可能大于其在数据中心多年运行的排放,使制造成为 AI 环境影响的关键环节。

有害废弃物与用水

半导体制造还会产生大量有害废弃物,包括气体、VOC、化学废水和固体副产物。芯片生产用酸和溶剂产生的有毒废物流需专门处理,防止污染生态系统。尽管废水处理技术进步,微量金属和化学残留仍可能流入河流湖泊,影响水生生态和人类健康。

半导体厂对水的需求也引发了区域水资源压力。台积电亚利桑那工厂预计每日用水 890 万加仑,占全市供水近 3%。部分工厂已投资水回收系统,但整体需求增长仍难以抵消。

可持续举措

面对半导体制造的可持续性挑战,行业龙头已开始实施减能耗、减废弃和减排放的举措。Intel、台积电、三星等承诺向碳中和制造转型,主要措施包括:引入可再生能源(如台湾、欧洲工厂用水电、风电)、推广闭环水回收系统、采用绿色刻蚀和光刻工艺减少有害废弃物、开发高能效芯片架构(如低功耗 AI 加速器)等。尽管如此,随着 AI 加速器需求激增,整体环境足迹仍在扩大。若无材料效率、回收和制造工艺的重大突破,制造阶段将持续成为 AI 可持续性的主要挑战。硬件架构能效优化详见 第 11 章:AI 加速 ,基础设施可持续性见 第 13 章:机器学习运维 ,算法降算力技术见 第 10 章:模型优化 。

AI 硬件制造阶段是 AI 生命周期中资源消耗和环境影响最重的环节。关键材料开采、高能耗制造和有害废弃物排放,共同加剧了 AI 的碳足迹。尽管行业正加速可持续制造转型,但要满足 AI 需求增长,仍面临巨大挑战。

提升 AI 硬件可持续性需材料创新、供应链透明和循环经济模式(芯片回收再利用)的大力投入。AI 系统的长期可行性不仅取决于算力效率,更取决于底层硬件基础设施的环境负担能否有效降低。

使用阶段

AI 系统的使用阶段是生命周期中能耗最高的环节,涵盖训练和推理负载。随着 AI 在各行业普及,模型开发和部署的算力需求持续增长,带来更高能耗和碳排放。AI 系统的运营成本不仅包括直接计算用电,还包括数据中心、冷却和网络设备的能耗。理解该阶段的可持续性挑战,对减缓 AI 的长期环境影响至关重要。

AI 模型训练是使用阶段最耗算力的活动。训练大模型需在 GPU、TPU 等专用硬件上运行数十亿乃至数万亿次数学运算,持续数周甚至数月。近年来,随着模型复杂度提升,训练能耗急剧上升。大语言模型训练的碳足迹高度依赖数据中心的能源结构。若在以煤电为主的地区训练,排放远高于水电或核电地区。

训练完成后,AI 的能耗并未结束。推理阶段的持续计算成本,随部署规模和使用频率动态增长。实际应用中,推理负载需 7×24 小时运行,服务搜索、推荐、语言模型、自动驾驶等场景,每日处理数十亿请求。虽然训练能耗高,但大规模推理的累计能耗常在长期超过训练。研究显示,推理已占 AI 总能耗的 60% 以上,许多场景下碳足迹超过训练。

数据中心是 AI 训练和推理的核心基础设施,依赖数千台高性能服务器,每台都需大量电力。数据中心的 PUE(电力使用效率)直接影响 AI 的碳足迹。现代数据中心 PUE 多在 1.1-1.5,即每 1 单位计算用电需额外消耗 10-50% 的能耗用于冷却、变压和基础设施。冷却系统尤其是能耗大户,AI 加速器运行时发热极高。

数据中心地理位置直接影响可持续性。位于可再生能源丰富地区的设施,排放远低于依赖化石能源的地区。Google、微软等公司已投资碳感知计算,将 AI 任务调度到可再生能源高峰时段,最大限度降低碳影响。

AI 能耗的持续增长引发了电网容量和可持续性权衡的担忧。AI 负载常与制造、交通等高能耗行业争夺有限电力。在部分地区,AI 数据中心的兴起已加剧电网压力,需新建基础设施。可再生能源的“鸭子曲线”问题(发电随昼夜波动)也带来 AI 能耗与电网平衡的新挑战。分布式 AI 计算和边缘处理正成为减少对中心化数据中心依赖的潜在方案,将部分计算任务前移至用户侧。

减缓使用阶段环境影响需硬件、软件和基础设施多层优化。高能效芯片架构(如低功耗 AI 加速器、专用推理硬件)可降低单次推理能耗。模型本身也通过量化、剪枝、蒸馏等技术优化,实现更小更快的模型,在保持高精度的同时大幅降低算力需求。冷却效率、可再生能源集成和数据中心运维的持续改进,也是保障 AI 可持续扩展的关键。

随着 AI 应用持续扩张,能效必须成为模型部署策略的核心考量。使用阶段将长期主导 AI 的环境足迹,若无重大干预,行业用电量或将呈指数级增长。可持续 AI 发展需行业、学界和政策制定者协同,推动负责任的 AI 部署,确保技术进步不以环境可持续性为代价。

报废阶段

AI 系统的报废阶段常被可持续性讨论忽视,实则带来重大环境挑战。AI 硬件迭代加速,导致硬件寿命缩短,电子垃圾(e-waste)和资源枯竭问题加剧。AI 加速器、GPU、高性能处理器常在数年内即被淘汰,报废管理已成为紧迫的可持续性议题。与传统计算设备不同,AI 硬件含有复杂材料、稀土和有害物质,回收和废弃管理难度大。若无有效的再利用、回收或安全处置策略,AI 基础设施的环境负担将持续上升。

AI 硬件寿命较短,尤其在数据中心,性能效率要求频繁升级。GPU、TPU、AI 加速器平均 3-5 年即被新型号替换,大规模 AI 部署带来大量电子垃圾。与消费电子不同,AI 加速器一旦落后即难以二次利用,难以进入二手市场。对更快更高效模型的追求加速了这一循环,废弃高性能硬件的体量不断增长。

AI 硬件报废的主要环境风险在于有害物质。加速器含铅、镉、汞等重金属,以及半导体制造用的有毒化学品。若处理不当,这些物质会渗入土壤和水体,带来长期环境和健康危害。焚烧电子垃圾会释放有毒气体,非正规回收作业工人暴露于有害物质。研究估算,全球仅 17.4% 电子垃圾被正规回收,大部分被填埋或非法处理,缺乏环境保护。

AI 硬件结构复杂,回收难度高。与传统计算部件相比,AI 加速器采用多层电路、特殊金属合金和高度集成内存,材料回收难度大。金、钯、稀土等有价值元素的分离需先进技术,混合材料的化学结合和嵌入结构进一步加大提取难度。

尽管如此,业界正努力开发 AI 硬件的可持续处置方案。部分厂商已设计模块化架构,便于更换部件,延长设备寿命。材料回收工艺也在进步,如湿法冶金和生物冶金等新技术,可低环境影响提取稀有金属。

循环经济27为缓解 AI 电子垃圾危机提供了新思路。与线性“用完即弃”模式不同,循环经济强调再利用、翻新和回收,延长计算设备生命周期。Google、微软等已启动退役 AI 硬件再利用计划,将其用于低优先级任务或捐赠给科研机构,减少新半导体生产需求,降低废弃量。

政策干预和监管框架对报废阶段治理至关重要。全球多国已实施生产者延伸责任(EPR)政策,要求厂商对产品全生命周期环境影响负责。欧盟等地已强制电子制造商参与认证回收,确保有害物质安全处置。但全球电子垃圾追踪和管理仍存在巨大缺口。

AI 硬件报废的未来取决于回收技术进步、监管执行和行业可持续设计的普及。AI 电子垃圾问题日益紧迫,需将全生命周期管理纳入 AI 基础设施规划。若无系统性提升硬件可持续性,AI 的快速扩张将持续加剧全球资源和废弃物压力。

第三部分:实施与解决方案

具体的减缓策略需建立在数据驱动的测量框架之上,通过碳足迹分析、生命周期评估和资源利用指标,帮助工程师发现优化机会、验证改进效果,并在性能与可持续性之间做出明智权衡。这一量化基础支撑了算法设计、基础设施优化、政策框架和行业实践四大领域的系统性实施。

可持续 AI 实践面临著名的“朱文斯悖论”28:单纯提升效率可能因 AI 更易用、更便宜而反而加剧总消耗。因此,成功策略需将技术优化与使用治理结合,防止效率提升被部署规模的指数级增长抵消。

多层次减缓策略框架

应对 AI 环境足迹需多层集成:能效算法设计、硬件部署优化、可持续基础设施运维和碳感知计算策略。AI 框架本身的选择与优化也影响效率,需评估计算效率和资源利用模式。同时,AI 系统设计需贯穿生命周期可持续性,确保模型从训练到推理始终高效。

本节将系统梳理可持续 AI 的关键减缓策略,从开发原则到工程落地。下图(图 11)直观展示了效率提升未必带来净环境收益的核心挑战。

下图(图 11)展示了该效应。AI 系统效率提升后,单位计算成本下降(A→B),如每个 token、推理或推荐的成本降低。但价格下降带来 AI 应用总量激增(C→D),总消耗反而更快增长,最终导致资源消耗和环境影响上升。这正是 AI 领域朱文斯悖论的本质:效率提升本身无法保证可持续性。

效率是可持续性的基石

前述“模型优化”( 第 10 章:模型优化 ) 和“高效 AI”( 第 9 章:高效 AI ) 章节中的每项技术,不仅是性能优化工具,更是可持续性的核心手段。例如,剪枝通过去除冗余参数,直接降低计算复杂度和能耗;量化减少内存需求、加速推理,同时大幅降低功耗;知识蒸馏让小模型以更低资源实现媲美大模型的性能。

这些优化技术是性能工程与环境责任的桥梁。优化模型运行速度或内存占用的同时,也在降低碳足迹。高效架构和软硬协同设计,既提升性能,也推动可持续性。

这揭示了一个重要洞见:可持续 AI 本质上就是高效 AI。支撑系统扩展、提升性能、降低运营成本的工程原则,与环境责任高度一致。理解这一关系,将可持续性从附加约束转变为优秀系统工程的内在组成。

生命周期感知开发方法

可持续 AI 实践需将环境因素系统性融入开发全流程,涵盖算法设计、基础设施优化、运维实践和治理机制,协同降低环境影响,保障技术能力。

能效算法设计

许多深度学习模型参数量达数十亿,训练和推理需万亿次 FLOPS29。尽管大模型性能卓越,研究表明其计算复杂度中有大量冗余,许多参数对预测贡献有限,导致资源浪费。可持续 AI 将能效作为设计约束,需软硬协同优化,实现单位算力最大效率。

模型剪枝是提升能效的常用方法,通过去除冗余连接30,显著减少模型规模和推理计算量。研究表明,结构化剪枝可将 ResNet-50 等模型权重减少 90%,精度几乎不变。该方法让 AI 模型可在低功耗硬件高效运行,适合资源受限场景。

量化31则通过降低计算精度,进一步降低能耗。标准深度学习模型常用 32 位浮点,实际许多操作可用 8 位甚至 4 位整数,精度损失极小。8 位整数运算能耗仅为 32 位浮点的 1/16,4 位可降至 1/64。该优化需算法与硬件协同。量化减少内存、加速推理、降低功耗。例如 NVIDIA TensorRT 框架可对模型后量化,推理速度提升 3 倍,精度几乎不变。Intel Q8BERT 将 BERT 量化为 8 位,模型体积缩小 4 倍,性能损失极小。

知识蒸馏则让大模型将知识迁移给小模型。大模型(教师)训练小模型(学生)逼近其预测,小模型以更少参数实现高性能。Google DistilBERT 仅用原 BERT 40% 参数,保留 97% 精度。知识蒸馏让轻量模型以低算力实现高质量预测。

这些优化技术是可持续 AI 的核心策略。全面掌握需理解其实现细节、性能权衡及与高效系统设计的集成。

优化虽提升效率,但也带来权衡。剪枝、量化可能略降精度,需微调平衡性能与可持续性。知识蒸馏需额外训练轮次,节能主要体现在部署阶段。朱文斯悖论提醒我们,效率提升需配合资源使用治理,防止总消耗反增。只有将效率与资源限制结合,才能真正降低环境足迹。

生命周期感知系统

除单模型优化外,AI 系统需具备全生命周期视角。许多 AI 部署采用短周期思维,模型训练、上线、数月后即弃,频繁重训导致算力浪费。将可持续性纳入开发流程,可延长模型寿命、减少冗余计算、降低环境影响。

减少冗余计算的有效方法是限制全量重训频率。许多生产系统无需从零重训,可用增量学习适应新数据。迁移学习是常用方法,预训练模型微调于新数据集,算力消耗远低于全量训练。该方法对领域适配尤为有效,大模型可快速定制于特定场景。相关运维与部署策略详见 ML 运维生命周期章节。

LCA 方法的集成也是生命周期感知开发的重要环节。LCA 为量化 AI 系统各阶段环境影响提供系统框架,从初始训练到长期部署。MLCommons 等组织正开发能效与碳排放基准,衡量每次推理和训练的能耗。将 LCA 原则嵌入 AI 工作流,可在设计早期发现可持续性瓶颈,及时修正。

部署策略同样影响可持续性。云端 AI 常依赖中心化数据中心,数据传输和推理能耗高。边缘计算让模型直接在终端运行,减少云通信,提升延迟和隐私,同时大幅降低能耗。高效边缘系统的设计需平衡算力与资源约束,涉及复杂的架构原理。

朱文斯悖论表明,单阶段优化未必带来整体可持续性。例如,即便提升硬件可回收性,若产量因需求激增而上升,资源枯竭问题仍难缓解。因此,限制不必要硬件生产同样重要。采用生命周期感知方法,才能在推动 AI 发展的同时,降低其环境影响。

政策与激励

技术优化虽关键,但需政策激励和行业承诺配合。多项新兴举措正推动可持续性原则在 AI 开发中的落地。

碳感知 AI 调度是一大亮点,将 AI 任务动态分配到可再生能源充足时段。Google 已开发调度算法,将训练任务延后至风能、太阳能高峰,减少化石能源依赖。该策略在大型数据中心尤为有效,可将高峰能耗与低碳发电对齐。

以可持续性为导向的基准和排行榜也在 AI 社区兴起。ML.ENERGY Leaderboard 按能效和碳足迹排名模型,鼓励研究者兼顾性能与可持续性。MLCommons 正制定以每次推理能耗为指标的标准基准,为模型环境影响对比提供透明框架。这些指标与传统性能基准互补,形成能力与环境影响并重的评估体系。

监管也在塑造可持续 AI 的未来。欧盟《可持续数字市场法》已要求 AI 能耗透明,科技公司需披露 AI 运营碳足迹。随着监管完善,企业将面临更大压力,将可持续性纳入开发实践。

通过将技术优化与行业激励、政策法规结合,AI 从业者可确保可持续性成为开发的内在组成。向能效模型、生命周期感知设计和环境透明报告转型,将是减缓 AI 生态影响、推动创新的关键。

基础设施优化

除算法优化外,基础设施创新为可持续 AI 部署提供了补充路径。本节聚焦三大方向:数据中心可再生能源集成、碳感知任务调度和 AI 驱动冷却优化。这些基础设施策略针对算力效率落地的运行环境。

绿色数据中心

AI 算力需求激增,使数据中心成为数字经济的用电大户。大型云数据中心为机器学习模型训练和部署提供基础设施,但能耗巨大。单个超大规模数据中心用电可超 100 兆瓦,相当于小城市用电32。若无干预,AI 负载增长将使数据中心能耗超出可持续水平。

转向可再生能源是降低数据中心排放的有效途径。Google、微软、AWS 等已承诺数据中心用可再生能源,但落地仍有挑战。与化石能源稳定输出不同,风能、太阳能等可再生能源间歇性强,发电随时段波动。AI 基础设施需配套储能(如大规模电池)和智能调度,将 AI 任务移至可再生能源高峰。Google 目标 2030 年实现 24/7 碳中和,确保每度电均为清洁能源,而非仅靠碳抵消。

冷却系统是数据中心能耗大户,常占总用电 30-40%33。传统冷却依赖空调和机械冷却,需大量电力和水资源。

除硬件优化外,AI 也被用于提升数据中心能效。DeepMind 开发的机器学习算法可基于实时传感器数据动态调整冷却参数。AI 驱动冷却系统分析温度、湿度、风扇转速,持续优化能效。在 Google 数据中心部署后,冷却能耗降 40%,充分展示了 AI 优化自身基础设施的潜力。

朱文斯悖论提醒我们,即便数据中心极高效,若推动 AI 服务大规模扩张,仍可能加剧总能耗。提升数据中心能效是减排关键,但效率本身不足以解决问题。还需限制数据中心容量扩张。可再生能源集成、先进冷却和 AI 优化的结合,将在 AI 扩展过程中发挥核心作用,确保机器学习与可持续目标一致。

碳感知调度

除硬件和冷却优化外,合理安排 AI 任务的执行时空也是减排关键。数据中心用电来自碳强度随时段和地区波动的电网。全球电力仍以化石能源为主,可再生能源占比随地区和时段变化。若不优化,AI 任务可能在高碳时段执行,排放不必要增加。碳感知调度可将计算任务动态迁移到低碳时段和地区,显著减排且不影响性能。

Google 在云基础设施中率先实现了碳感知计算。2020 年推出调度系统34,将非紧急 AI 任务延后至风能、太阳能高峰。该方法让 AI 负载与清洁能源自然波动对齐,减少化石能源依赖,保持高算力效率。Google 还通过地理分布,将任务迁移到清洁能源丰富的数据中心。大规模训练任务从高碳电网迁移到低碳地区,显著减排。

碳感知调度不仅适用于超大云厂商,企业也可将碳强度指标集成到自身计算流程,智能选择低碳虚拟机。微软的可持续云计算计划允许用户选择碳优化 VM,确保任务以最低排放执行。开源碳感知调度框架也在开发中,助力更广泛 AI 从业者采纳可持续计算策略。

碳感知调度的有效性依赖于实时电网排放数据。电力公司和可持续组织已通过 API 公布碳强度数据,AI 系统可动态响应电力结构变化。例如 Electricity Maps API 提供全球实时 CO₂ 排放数据35,AI 基础设施可据此调整任务调度。随着电网排放数据可用性提升,碳感知计算将成为大规模减排的可行方案。

通过将 AI 任务迁移到清洁能源高峰,碳感知调度为 AI 基础设施减排提供了强大工具。与硬件升级不同,调度优化可通过软件快速落地,成本低、见效快。随着更多组织集成碳感知调度,全球 AI 相关碳排放有望大幅下降。

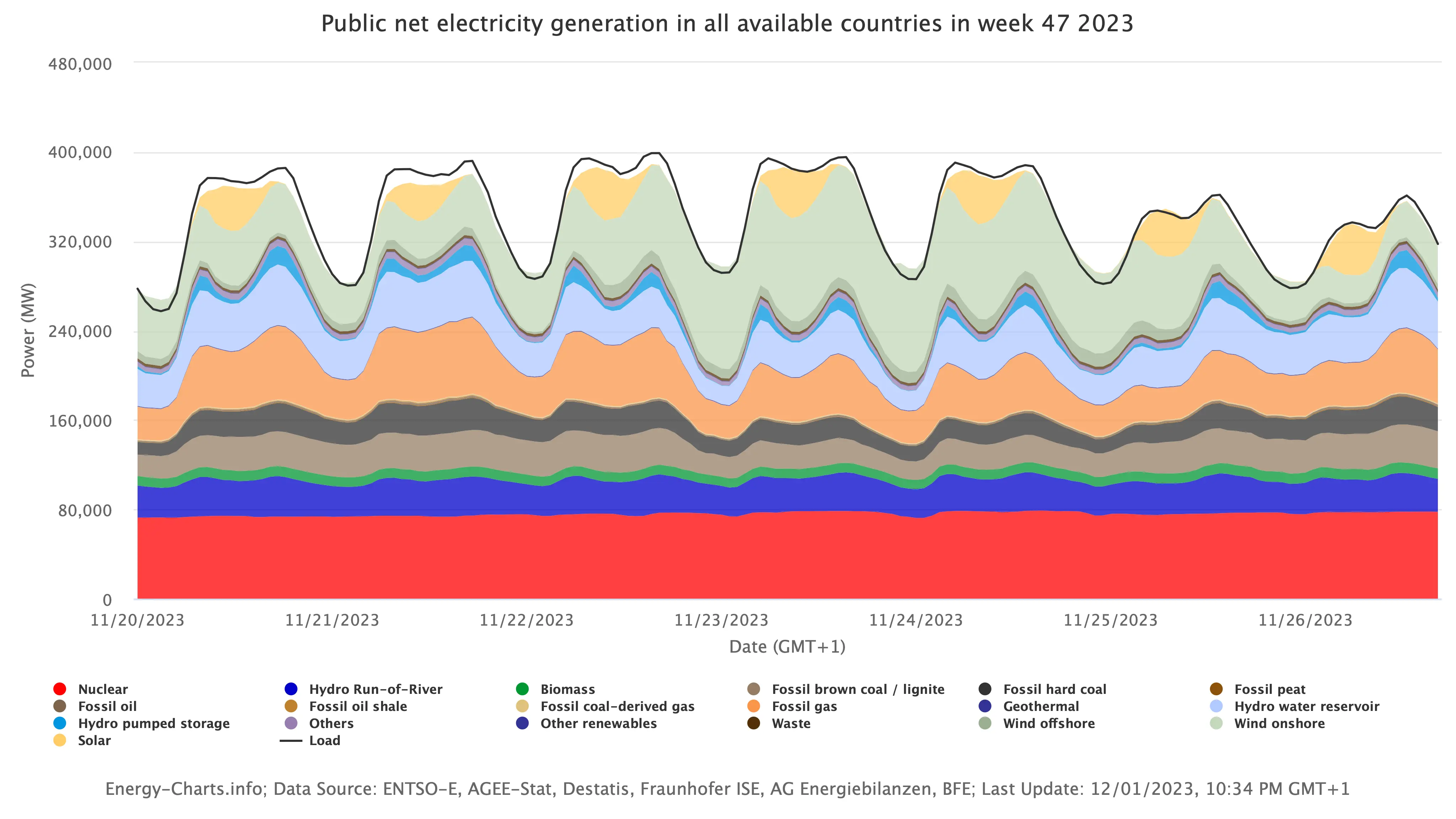

这些策略适用于所有 AI 负载,推理环节尤具挑战和机遇。与一次性训练不同,推理是持续增长的能耗大户。云厂商正将碳感知调度应用于推理,将任务动态迁移到可再生能源丰富地区。但如图 12 所示,可再生能源产能波动大。欧洲电网数据显示,太阳能中午峰值,风能早晚高峰。目前仍需化石能源补足缺口。

要充分利用碳感知调度,需创新储能方案,实现可再生能源的持续利用。当前基载主要靠核能,虽无直接碳排放,但灵活性不足。微软等企业已关注核能供电36,其稳定负载与数据中心需求高度匹配。

除调度外,推理可持续性还需软硬件协同创新。模型量化可用低精度算术大幅降能耗,知识蒸馏让小模型复制大模型性能,专用推理加速器(如 TPU)进一步降低环境影响。

能效 AI 框架如 Zeus、Perseus 可在训练和推理阶段平衡速度与能耗,分析速度与能耗权衡,推动能效 AI 策略在大规模推理场景落地。

AI 驱动热管理优化

冷却系统是 AI 基础设施能耗大户,常占数据中心总用电 30-40%。随着 AI 负载算力密度提升,GPU、TPU 等高性能加速器发热量持续上升。若无高效冷却,数据中心需依赖高能耗空调或高耗水热管理,进一步加重环境足迹。AI 驱动冷却优化已成为提升能效、保障可靠性的有效手段。

DeepMind 已在 Google 数据中心部署机器学习模型优化温控。传统冷却依赖固定策略,按预设温度和风量调整,常因规则僵化导致能耗浪费。AI 驱动冷却系统则实时分析温度、湿度、泵速、风扇等数据,动态调整冷却配置,最小化能耗并保障硬件安全。深度强化学习让系统持续自适应,能耗显著降低。

实际部署中,DeepMind 系统将冷却能耗降 40%,总用电降 15%。这一成效表明,AI 可直接用于减缓自身基础设施的环境影响。该系统的成功推动了更多云厂商探索机器学习驱动的热管理。

除 AI 控制外,液冷和浸没式冷却等新技术也在提升能效。液冷通过冷却液直接带走芯片热量,能耗远低于风冷,适合高密度集群。部分设施采用浸没式冷却,将服务器浸入绝缘液体,彻底消除风冷系统,极大降低用电和用水。

微软还探索了水下数据中心,利用海洋自然冷却,降低能耗并延长硬件寿命。尽管仍属实验阶段,但显示了替代冷却技术在可持续 AI 基础设施中的潜力。

AI 驱动冷却和热管理为降低 AI 基础设施环境影响提供了立竿见影的机会。与硬件升级不同,软件优化可快速部署,见效快、成本低。结合液冷、浸没冷却等新技术,行业可大幅降低能耗、运营成本,推动 AI 长期可持续发展。

全面环境影响减缓

随着 AI 系统规模扩展,减缓环境影响的努力多聚焦于模型设计能效和数据中心优化。尽管这些进步重要,但仅解决了部分问题。AI 的环境影响远超运营能耗,还包括半导体制造用水、电子垃圾等。真正可持续的 AI 生态需覆盖硬件和软件全生命周期,将可持续性嵌入每一环节——从材料采购到报废回收。

LCA 研究揭示了 AI 硬件制造和部署的碳排放、水消耗和材料浪费。许多环境成本隐藏在供应链中,未体现在运营能耗报告中,导致对 AI 可持续性的认知不完整。数据中心依然高耗水,冷却系统每日消耗数百万加仑,AI 加速器更新周期短,电子垃圾堆积。

本节将在此基础上,探讨如何系统性减缓 AI 的环境足迹,从供应链、水资源到硬件寿命,推动全生态可持续性。

生命周期影响再审视

AI 的环境足迹远超训练和推理用电。硬件制造和报废同样贡献了大量碳排放、资源枯竭和电子垃圾。LCA 揭示,AI 硬件的排放不仅来自用电,还包括加速器、存储和网络设备的材料和工艺。

LCA 研究显示,AI 硬件的“隐含碳”16成本巨大。与可通过清洁能源降低的运营排放不同,隐含排放来自原材料开采、半导体制造和供应链物流,部署前即已产生。

AI 的用水消耗常被忽视。AI 加速器生产的半导体厂是全球最耗水的工业设施,每日用于晶圆清洗和化学处理的水量达数百万加仑。数据中心冷却同样需大量用水,部分超大设施每日用水 45 万加仑,且随 AI 负载密度提升持续增长。许多芯片制造中心位于台湾、亚利桑那等水资源紧张地区,AI 对水的依赖带来严峻可持续性挑战。

除排放和用水,AI 硬件还加剧了电子垃圾问题。AI 加速器迭代快,GPU、TPU 常被频繁替换。虽然效率提升重要,但频繁淘汰功能完好的硬件导致电子垃圾和资源浪费。许多 AI 芯片含稀土和有毒成分,若不回收将污染环境。

减缓 AI 环境影响需超越能效提升,重塑硬件生命周期、减少高耗水工艺、发展可持续回收。下述策略将正面应对这些挑战,确保 AI 进步与长期可持续目标一致。

供应链影响减缓

AI 环境影响的关键在于供应链环节,半导体制造、原材料开采和硬件运输在部署前即产生大量排放、资源消耗和废弃物。这些排放难以通过运营优化抵消,需源头减缓。

半导体制造的碳强度是首要问题。GPU、TPU、ASIC 等 AI 加速器制造需极高精度,EUV 光刻、化学气相沉积、离子注入等工艺耗电巨大。许多制造中心仍以化石能源为主,芯片制造能耗成为 AI 总排放的 30%。需推动低能耗工艺和可再生能源制造。

AI 对稀土和关键矿物的依赖也带来可持续性挑战。高性能硬件需镓、钕、钴等材料,开采过程资源消耗大、污染重,且多由中国等少数国家控制,供应链脆弱。推动负责任采购和材料替代,是降低生态和社会影响的关键。

减缓供应链环境负担的措施包括:推广低能耗芯片制造、延长硬件寿命(如将退役加速器用于推理)、回收和闭环供应链(回收 GPU、TPU、ASIC 提炼稀有金属)。行业回收计划和可回收性设计,将显著提升 AI 的长期可持续性。

供应链可持续性不仅是环境需求,也是创新机遇。集成能效制造、负责任采购和循环设计,AI 行业可在运营前即大幅减排。结合能效计算进步,确保 AI 增长不以生态为代价。

水资源与材料保护

减缓 AI 环境影响需直接降低用水和材料消耗。AI 依赖半导体制造和数据中心,给水资源和关键材料带来巨大压力,尤其在资源紧张地区。与碳排放可通过清洁能源抵消不同,水和材料消耗有直接、局部影响,需在设计和运营层面集成可持续措施。

提升半导体厂水回收是降低 AI 用水的有效策略。领先制造商已实施闭环水系统,回收和净化废水,减少新水消耗。Intel、台积电等已实现 80% 以上水回收,需推动行业普及。

数据中心可通过冷却优化降低用水。许多超大设施仍依赖蒸发冷却,耗水巨大。转向直芯液冷或风冷技术可大幅降水耗。部分水资源紧张地区已采用废水或海水冷却,减少对饮用水依赖。

材料方面,减少对稀土和关键矿物的依赖是长期可持续的关键。研究者正探索替代材料和低废工艺,推动 AI 硬件回收计划,回收稀有金属,减少原生开采。

行业协作也至关重要。政府可通过水资源保护、负责任采矿和电子垃圾回收法规,激励可持续实践。优先实施这些策略,AI 行业可在推动技术进步的同时,最小化生态足迹。

系统性可持续路径

减缓 AI 环境影响需超越局部优化,推动系统性转型。实现 AI 长期可持续需集成循环经济、政策法规和行业协作,将可持续性嵌入生态底层。

朱文斯悖论提醒我们,单点效率提升难以解决总量问题。需系统性解决 AI 消耗驱动因素,包括政策推动、资源使用激励和公众意识提升。

循环经济是实现可持续性的有效路径。与“制造 - 使用 - 废弃”线性模式不同,循环模式强调再利用、翻新和回收,延长硬件寿命。制造商和云厂商可采用模块化设计,便于升级和回收。AI 硬件应以可回收性为目标,确保材料可提取再用。

政策法规同样关键。政府可推行碳透明、强制报告全生命周期排放,包括制造隐含碳。加强半导体厂用水和电子垃圾回收监管,推动生产者延伸责任,激励可持续设计。

行业协作有助于规模化可持续实践。头部企业和研究机构应共建能效、碳足迹和资源使用基准,推动绿色 AI 认证,引导用户选择可持续技术。云厂商可承诺 24/7 碳中和,确保 AI 负载实时用清洁能源,而非仅靠碳抵消。

实现 AI 可持续性的系统性变革需多方协作。政府、行业和学界需共建标准、投资绿色基础设施、推动循环经济。将可持续性嵌入开发全流程,行业才能超越渐进优化,构建创新的可持续基础。

案例分析:Google 的“四 M”框架

为减缓 AI 负载扩张带来的排放,Google 工程师总结出“4M”优化法:模型(Model)、机器(Machine)、机制(Mechanization)、选址(Map),系统性提升可将机器学习碳足迹大幅降低:

- 模型(Model):高效架构选择可在不降质的前提下将计算需求降 5-10 倍。Google 在稀疏模型和 NAS 领域有深厚积累,Evolved Transformer、Primer 等高效架构即为代表。

- 机器(Machine):专用 AI 硬件可比通用系统提升 2-5 倍每瓦性能。Google TPU 的碳效率比非优化 GPU 高 5-13 倍。

- 机制(Mechanization):高利用率云基础设施比传统本地数据中心节能 1.4-2 倍。Google 设施 PUE 持续优于行业均值。

- 选址(Map):数据中心选址于低碳电力地区可将总排放降 5-10 倍。Google 实时监控全球可再生能源使用。

这些措施叠加带来乘数级效率提升。例如,将优化 Transformer 部署于 TPU 并选址低碳数据中心,能耗降 83 倍,CO₂ 排放降 747 倍。

尽管 Google AI 部署量大幅增长,系统性效率提升有效遏制了能耗增长。2019-2021 年间,AI 负载始终占 Google 总能耗 10-15%。随着 AI 功能扩展,算力增长被算法、硬件、基础设施和选址优化抵消。

实证案例表明,聚焦可持续 AI 的工程原则可同步提升性能与环境表现。例如,GPT-3(2020 年中 SOTA)与 Google GLaM 对比,后者在提升精度的同时,训练算力和碳排放大幅下降,18 个月内 CO₂ 排放降 14 倍。

Google 分析指出,早期公开估算因方法局限和缺乏实测,常高估机器学习能耗 100-100,000 倍。通过透明报告优化指标,Google 为行业效率提升提供了事实基础,纠正了对机器学习环境影响的过度担忧。

尽管 AI 运营碳足迹已大幅收敛,Google 仍强调持续效率提升对负责任创新至关重要。其持续优化框架包括:

- 生命周期分析:证明如 NAS 等高算力投资虽初期能耗高,但带来下游大幅效率提升,累计减排远超初始消耗。

- 资源分配优先级:聚焦数据中心和服务器端优化,因能耗最集中。边缘推理效率持续提升,但主力仍在训练基础设施和可再生能源采购。

- 规模经济:通过云基础设施整合提升效率,算力从分散本地向集中云迁移,整体减排加速。

- 可再生能源集成:自 2017 年起 Google 实现 100% 可再生能源匹配,进一步降低算力负载环境影响。

这些综合措施表明,AI 效率提升正加速而非停滞。Google 的多维策略(系统测量、碳感知开发、透明报告、可再生能源转型)为可持续 AI 扩展提供了可复制框架,实证结果为行业推广全面可持续实践奠定基础。

可持续 AI 工程实践清单

本节策略和框架为可持续 AI 开发提供了基础,落地需具体可操作步骤。以下清单汇总了 AI 工程师和从业者可立即实施的关键实践,助力降低环境影响:

- 先测量再优化:用 CodeCarbon 等工具追踪训练排放。没有基线就无法改进,量化是验证优化成效的前提。

- 优选训练地区:在可再生能源数据中心训练模型。关注电网碳强度,将任务调度到清洁能源高峰。

- 模型先优化再扩展:避免盲目追求大模型。用剪枝、量化、蒸馏等方法找到满足精度目标的最小模型。90% 精度、资源消耗仅 10% 的模型,往往比 95% 精度、资源全开的模型更具实际价值。

- 避免全量重训:优先用迁移学习和微调,减少从零训练。站在已有预训练模型肩膀上,可将算力需求降数个数量级。

- 关注硬件能效:部署时选择高能效加速器(如 TPU、专用推理芯片)。考虑硬件全生命周期,选用针对负载优化的平台。

- 全生命周期思维:推动组织延长硬件更新周期,制定负责任的电子垃圾政策。制造阶段的环境影响常超运营能耗,硬件寿命是可持续关键。

嵌入式 AI 与电子垃圾

AI 的部署正迅速从集中式数据中心扩展到边缘和嵌入式设备,实现了无需持续云连接的实时决策。这一转变带来了显著的效率提升,降低了延迟、带宽消耗和网络拥堵,并推动了智能消费设备、工业自动化、医疗健康和自动化系统等新应用的诞生。分布式 AI 系统的架构与设计需在计算效率、延迟需求和资源约束之间做出复杂权衡。然而,嵌入式 AI 的兴起也带来了新的环境挑战,尤其是在电子垃圾、一次性智能设备和计划性报废方面。

与数据中心中为长期高性能计算设计的 AI 加速器不同,嵌入式 AI 硬件通常体积小、成本低且易于丢弃。许多 AI 驱动的物联网传感器、可穿戴设备和智能家电寿命短、升级受限,几乎无法维修或回收。因此,这些设备正成为快速增长的电子垃圾危机的重要推手,而这一问题在 AI 可持续性讨论中常被忽视。

问题的规模令人震惊。如图 13 所示,预计到 2030 年,物联网(IoT)设备数量将超过 300 亿,AI 芯片正被广泛嵌入家用电器、医疗植入物、工业监测系统和农业传感器等各类产品。这些专为边缘计算优化的硬件架构推动了连接设备的指数级增长,但由于许多设备在短短几年内即被淘汰,导致电子垃圾激增。若缺乏可持续设计和完善的生命周期管理,AI 在边缘的扩张将加剧全球电子垃圾的堆积,给回收体系带来巨大压力。

尽管 AI 数据中心因碳足迹和能耗问题备受关注,但将 AI 融入数十亿短命设备的环境代价却鲜有人问津。要应对这一挑战,必须重新思考 AI 硬件的设计、制造与处置方式,确保边缘 AI 推动技术进步的同时,不会留下不可持续的废弃遗产。

全球电子垃圾加速

电子垃圾(e-waste)已成为数字时代日益严峻的环境挑战。它指的是含有电池、电路板和半导体元件的废弃电子设备,对人类健康和环境均构成严重威胁。AI 相关硬件中常见的铅、汞、镉和溴化阻燃剂等有毒物质,若处理不当会污染土壤和地下水。尽管具备回收和材料再利用的潜力,大多数电子垃圾仍未被妥善处理,导致有害废弃物积累和环境恶化。

问题规模同样惊人。当前全球每年产生的电子垃圾已超 5000 万吨,预计到 2030 年将突破 7500 万吨,联合国预测若消费模式不变,2050 年电子垃圾年产量或达 1.2 亿吨。产品寿命短、全球需求上升和回收基础设施薄弱共同加剧了危机。

AI 驱动的消费电子,如智能音箱、健身追踪器和家居自动化系统,是电子垃圾的重要来源。与可拆卸、可维护的计算设备不同,许多此类产品被设计为一次性,电池损坏或部件故障时,用户只能整体丢弃。这种内置的易弃性加剧了不可持续的消费与废弃循环,导致原材料开采增加,给废弃物管理体系带来更大压力。

发展中国家在电子垃圾倾倒问题上尤为受害,因其往往缺乏安全处理废弃电子产品的基础设施。2019 年,低收入国家仅有 13%~23% 的电子垃圾被正式回收,其余要么被焚烧、非法倾倒,要么在不安全条件下手工拆解。许多废弃的 AI 设备流入非正规回收渠道,工人缺乏防护,暴露于有害物质。塑料部件露天焚烧、粗放金属提取释放有毒烟雾和重金属,严重危害环境与健康。

全球电子垃圾回收率依然极低,仅有 17.4% 的废弃电子产品通过环保渠道回收,其余 82.6% 被填埋、焚烧或非法倾倒,造成长期环境污染和资源枯竭。若无更强有力的政策、更优的产品设计和更完善的回收体系,AI 设备的快速增长将极大加剧这一危机。

AI 电子产品不应成为全球电子垃圾问题的又一推手。应对这一挑战需多管齐下,包括更可持续的设计、更严格的监管和对全球回收基础设施的投资。否则,AI 的环境影响将远超能耗,留下有毒废弃物和资源枯竭的遗产。

一次性电子产品

低成本 AI 微控制器、智能传感器和连接设备的快速普及,正在改变消费电子、医疗、工业自动化和农业等行业。尽管这些嵌入式 AI 系统提升了效率和自动化,但其短寿命和不可回收的设计带来了重大可持续性挑战。许多设备被视为一次性电子产品,耐用性有限、电池不可更换、几乎无法维修,几年内即进入废弃流程。

AI 设备易弃性的主要驱动力是微电子成本的持续下降。硬件小型化让制造商能以每芯片不足 1 美元的成本,将 AI 处理器和无线模块嵌入日常产品。AI 功能正被集成到一次性和短命产品中,如智能包装、联网医疗设备、可穿戴设备和家用电器。这些面向资源受限环境的优化实现提升了便利性和实时数据采集,但缺乏完善的生命周期管理,导致难以回收的电子垃圾激增。

不可更换电池的代价

许多一次性 AI 设备采用密封、不可更换的锂电池,极不环保。智能耳机、无线传感器甚至部分健身追踪器,电池衰减后整个设备即报废。与可拆卸、可维护的模块化电子产品不同,大多数 AI 可穿戴和物联网设备采用胶合或焊接封装,无法更换电池或维修。

这一问题不仅限于消费电子。工业 AI 传感器和远程监测设备(如农业、基础设施和环境监测)也常用不可更换电池,寿命有限。电池耗尽后,这些部署在偏远或难以接近地区的传感器即成为电子垃圾,处理和更换成本高昂且对环境有害。

电池废弃物的环境影响尤为严重。锂矿开采(电池生产所需)能耗巨大,消耗大量水资源并产生有害副产物。此外,锂电池处理不当易引发火灾和爆炸,尤其是在垃圾填埋场和废弃物处理设施。随着 AI 设备需求增长,解决电池可持续性危机对减缓 AI 的长期环境足迹至关重要。

回收难题

与可拆卸、可翻新的传统计算硬件(如台式机、服务器)不同,大多数 AI 消费电子产品并未考虑回收。许多设备采用混合材料外壳、嵌入式电路和永久连接部件,难以拆解和材料回收。

此外,AI 物联网设备体积太小,难以用常规电子垃圾处理方法高效回收。大型电子产品(如笔记本、手机)有完善的回收体系,而微型 AI 传感器、耳机和嵌入式芯片则因分离成本高、劳动密集,往往直接填埋或焚烧,造成污染和资源浪费。

电池废弃物的环境影响尤为严重。锂矿开采(电池生产所需)能耗巨大,消耗大量水资源并产生有害副产物。此外,锂电池处理不当易引发火灾和爆炸,尤其是在垃圾填埋场和废弃物处理设施。随着 AI 设备需求增长,解决电池可持续性危机对减缓 AI 的长期环境足迹至关重要。

可持续设计的必要性

解决一次性 AI 电子产品的可持续性挑战,需要根本性的设计理念转变。制造商应将可持续性原则融入 AI 设备开发,而非仅追求低成本和短期功能。这与负责任 AI 的伦理开发理念一致,将环境责任纳入道德考量。具体措施包括:

- 设计长寿命产品:AI 设备应采用可更换部件、模块化设计和可升级软件,延长使用周期。

- 支持电池更换:消费级和工业级 AI 设备应采用易于更换的电池,避免密封设计阻碍维修。

- 标准化可维修性:AI 硬件应采用通用维修标准,确保部件可维修而非直接丢弃。

- 开发可降解或可回收材料:推动环保电路板、生物降解聚合物和可持续包装材料的研究,减少废弃物。

激励和监管也可推动制造商优先考虑可持续设计。政府可出台“维修权”法规、生产者延伸责任政策和电子垃圾回收计划,确保 AI 设备被妥善处置。消费者教育也能提升环保意识,促进可持续消费决策。

AI 电子产品的未来应是循环而非线性的,确保设备从设计之初就考虑可持续性,避免成为电子垃圾危机的主要推手。通过优化设计、提升可回收性和推广负责任处置,行业可在推动技术进步的同时,减缓 AI 在边缘侧的环境负担。

AI 硬件的计划性报废

计划性报废指产品被有意设计为寿命有限,迫使用户提前升级或更换。这一做法长期存在于消费电子和家用电器领域,如今在 AI 硬件(智能手机、可穿戴设备、工业 AI 传感器和云基础设施)中愈发普遍。加速的更换周期不仅推高消费和生产,也极大加剧了电子垃圾危机。

AI 硬件计划性报废的典型表现是软件驱动的性能退化。许多厂商通过系统更新(如苹果 iOS 升级)降低旧设备性能,表面上为安全和功能升级,实则促使用户更换新机而非维修或更换电池。

这一模式同样出现在 AI 消费电子领域,固件升级常导致旧型号无法兼容新功能,迫使用户更换设备。许多智能家居系统、连接家电和 AI 助手因云服务或软件支持中断而被迫淘汰,即便硬件本身完好无损。

封闭与专有部件

另一种计划性报废表现为硬件锁定,厂商通过专有部件阻止用户维修或升级设备。许多 AI 设备采用专有设计,无法更换电池、升级内存或替换部件。厂商优先采用密封外壳和焊接部件,导致即便小故障也需整体更换。

例如,许多 AI 可穿戴和智能设备采用不可更换电池,电池衰减后(通常仅 2~3 年)整个设备即成电子垃圾。智能手机、笔记本和 AI 平板也越来越多采用焊接内存和存储,用户无法升级,缩短了设备寿命。

计划性报废同样影响工业 AI 硬件,如 AI 摄像头、工厂传感器和机器人。许多工业自动化系统依赖厂商锁定的软件生态,厂商通过停止旧型号支持,迫使客户购买新设备,形成强制升级循环。

环境代价

计划性报废不仅增加用户负担,更带来严重环境后果。缩短产品寿命、阻碍维修性,推高电子元件需求,导致资源开采、能耗和碳排放增加。

半导体制造的环境成本尤为高昂。AI 芯片、GPU 等高端计算元件的生产需消耗大量水、稀土和能源。例如,单座 5nm 芯片厂每日需数百万加仑超纯水,工艺能耗巨大,CO₂ 排放显著。AI 设备被过早淘汰,制造环节的环境成本被浪费,进一步加剧可持续性挑战。

此外,许多废弃 AI 设备含有铅、汞和溴化阻燃剂等有害物质,若未妥善回收会污染环境。AI 消费电子和工业硬件的加速更替将加剧全球电子垃圾危机,进一步加重废弃物管理和回收体系负担。

延长硬件寿命

解决计划性报废需转向可维修、可升级和长寿命的 AI 硬件设计。可行措施包括:

- 维修权立法:许多国家正推动“维修权”法规,要求厂商提供维修手册、零部件和诊断工具,延长 AI 设备寿命,减少整体更换。

- 模块化 AI 硬件:采用可更换电池、可升级内存和标准化接口的模块化设计,既能减少电子垃圾,也提升用户性价比。

- 延长软件支持周期:企业应承诺更长的软件支持,避免因兼容性限制导致设备被迫淘汰。

- 消费者意识与循环经济:推广以旧换新、回收计划和可持续消费教育,引导用户选择可维修、长寿命设备。

部分科技公司已在探索更可持续的 AI 硬件。例如,Framework 推出的模块化笔记本电脑,支持完全维修和升级,优先考虑长期可用性。智能手机和 AI 物联网领域的类似创新,有望减少计划性报废的环境影响。

AI 设备的普及为电子产品生命周期重塑提供了契机。若不加以干预,计划性报废将持续推动浪费性消费,加速电子垃圾堆积和资源危机。但通过政策、行业创新和消费者倡导,AI 硬件可向耐用、可维修和可持续方向发展。

AI 的未来不应是一次性的。企业、研究者和政策制定者必须优先考虑长期可持续性,最大化 AI 的益处,最小化环境足迹。解决 AI 硬件的计划性报废,是实现真正可持续 AI 的关键一步,不仅要关注能效,更要贯穿设计到处置的全生命周期。

政策与监管

第三部分探讨的技术与基础设施方案,需有政策框架支持方能广泛落地。算法优化、基础设施改进和生命周期管理虽能降低 AI 环境影响,但仅靠市场驱动力难以在所需速度和规模上实现变革。有效监管需在鼓励创新与环境责任之间寻求平衡,制定激励可持续实践的政策,而非遏制技术进步。本节将梳理应对 AI 环境足迹的政策工具与治理机制,从测量标准、监管限制到市场激励。

监管机制与全球协同

可持续 AI 治理主要通过四类政策机制实现:测量与报告要求、排放限制、金融激励和行业自律。但全球政策碎片化带来实施难题。欧盟通过 AI 法案37和企业可持续报告指令(CSRD)38引领强制监管,美国则侧重自愿报告和市场激励。中国及其他国家各自制定独立框架,全球可持续战略协同面临壁垒。

测量与问责

透明的测量与报告是可持续 AI 治理的基础。没有标准化追踪机制,组织难以准确评估环境影响或发现改进空间。

测量与报告

缓解 AI 环境影响的第一步是准确测量与透明报告能耗和碳排放。没有标准化追踪机制,难以评估 AI 的真实可持续性或发现改进空间。政府和行业正推动能耗审计、排放披露和 AI 工作负载效率标准化。政策目标是提升透明度、优化决策并强化环境责任。

目前缺乏公认的 AI 环境影响评估指标。现有可持续性评估多依赖企业自报,能耗和排放测量方法不一。政策制定者和行业领袖正推动正式的可持续性基准,要求多层次评估 AI 的碳足迹。计算复杂度和模型效率是关键因素,决定了 AI 任务的计算需求。数据中心效率(如 PUE)衡量能耗中直接用于计算的比例。能源供应的碳强度同样重要,化石能源主导的地区 AI 运行环境影响远高于可再生能源地区。

多个行业组织正推动 AI 可持续性报告标准化。MLCommons 基准联盟已将能效纳入 AI 模型评估,推动模型能耗的标准化对比。这些指标补充传统性能评估,形成兼顾能力与环境影响的综合框架。监管机构也在推动强制披露。欧盟 AI 法案草案要求大规模 AI 用户报告模型能耗和碳排放,欧盟委员会计划将 AI 可持续性报告与 CSRD 等更广泛环境披露法规对齐。

推行 AI 可持续性报告的难点在于平衡透明度与企业负担。过度细致的报告要求可能增加中小企业和科研机构的合规压力。政策制定者正探索可扩展方案,将可持续性纳入现有行业标准,避免僵化合规成本。利用数据中心和云平台现有监控工具开发轻量级报告机制,可在提升可见性的同时减轻负担。

最具建设性的测量与报告政策应聚焦于持续改进,而非简单限制或刚性上限。鉴于 AI 发展迅速,灵活嵌入可持续性评估的法规更能有效推动能耗和排放的持续下降。合理设计的政策可激励 AI 开发者从源头重视效率,培育负责任 AI 设计文化,助力长期可持续目标。

限制机制

除了测量与报告要求,政策干预还可通过对能耗、排放或模型规模的监管限制,直接降低 AI 对环境的影响。尽管 AI 的快速发展推动了创新,但也带来了新的可持续性挑战,可能需要政府设定保护性措施,以遏制过度的环境成本。计算能力上限、公共资源使用条件、财政激励,甚至对低效 AI 行为的全面禁令,都是潜在的政策工具。然而,这些工具的有效性取决于政策设计的合理性,需在可持续性与技术进步之间取得平衡。

一种潜在的限制机制是对大规模 AI 模型训练所需计算能力设定上限。欧盟委员会在其提议的 AI 法案中探讨了这一概念,提出对 AI 训练工作负载实施经济范围的限制。这种做法类似于环境政策中的排放交易体系(ETS)39,即组织必须在预定的能源预算内运作,或通过受监管的交易所采购额外的计算能力。尽管此类限制有助于防止不必要的计算资源浪费,但也引发了对限制创新的担忧,尤其是对那些可能难以获得高性能计算资源的研究人员和小型企业而言。

另一种政策工具是根据模型效率对公共数据集和政府资助的计算基础设施的访问进行限制。AI 研究人员和开发者越来越依赖大规模公共数据集和补贴的云资源来训练模型。有人建议,政府可以将这些资源的使用限制在符合严格能效标准的 AI 项目上。例如,MLCommons 基准联盟可以将可持续性指标纳入其标准化性能排行榜,激励组织在准确性和效率之间寻求平衡。然而,尽管有条件的访问可以促进可持续 AI 实践,但也可能通过限制无法满足预定义效率标准的用户获取计算资源而导致不平等。

财政激励和惩罚措施是推动可持续 AI 的另一种监管机制。对 AI 相关计算消耗征收碳税,可以抑制过度的模型扩展,同时为以效率为中心的研究提供资金。类似于现有的环境法规,组织可能需要根据其 AI 工作负载的排放情况支付费用,鼓励其优化能耗。相反,税收抵免可以奖励开发高效 AI 技术的公司,促进对绿色计算技术的投资。尽管财政机制可以有效引导市场行为,但必须经过精心校准,以避免对小型 AI 开发者施加过重负担或抑制有益的用例。

在极端情况下,可能会考虑全面禁止某些浪费性 AI 应用。如果测量数据持续显示某些 AI 行为对环境造成不成比例的危害,而又没有可行的补救措施,政府可能会选择禁止这些活动。然而,由于 AI 技术的双重用途特性(即同一技术可能具有有益和有害的应用),因此在实施禁令时必须谨慎,确保限制措施仅针对明显不可持续的做法,而不抑制更广泛的 AI 创新。

最终,限制机制必须在环境责任和经济增长之间取得平衡。设计良好的政策应鼓励 AI 效率,同时保留持续技术进步所需的灵活性。通过将限制与激励和报告要求相结合,政策制定者可以为引导 AI 朝着更可持续的未来发展创造一个全面的框架。

政府激励

除了监管限制,政府还可以通过财政支持、税收优惠、补助金和对绿色 AI 研究的战略投资,积极推动可持续 AI 的发展。这些激励措施旨在鼓励能源高效的实践,使可持续性成为竞争优势,而非监管负担。

促进可持续性的常见方法是通过税收激励。各国政府已对采用可再生能源的企业提供税收抵免,例如美国的 住宅清洁能源抵免 和 商业能源效率扣除 。类似的项目可以扩展到通过优化模型和基础设施以降低能耗的 AI 公司。采用效率提升技术(如模型剪枝、量化或自适应调度)的 AI 开发者可以获得税收减免,从而为绿色 AI 发展创造财务激励。

除了税收激励,政府对可持续 AI 研究的直接资金支持也是一种新兴策略。西班牙已承诺拨款 3 亿欧元 用于明确关注可持续发展的 AI 项目。这类资金可以通过支持低功耗算法、专用 AI 硬件和环保数据中心设计的研究,来加速能源高效 AI 的突破。公私合营伙伴关系可以进一步增强这些努力,使 AI 公司与研究机构和政府机构合作,开创可持续解决方案。

政府还可以通过将绿色 AI 标准纳入公共采购政策,来激励可持续性。许多 AI 公司向政府机构提供云计算、软件服务和 AI 驱动的分析。通过要求供应商达到可持续性基准(如在碳中和数据中心运营和使用能源高效的 AI 模型),政府可以利用其采购权设置行业标准。类似的政策已在绿色建筑倡议中得到应用,政府要求承包商满足环境认证。将同样的方法应用于 AI 有望加速可持续实践的采用。

另一个创新的政策工具是为 AI 工作负载量身定制的碳信用额度。通过该制度,超出预定排放阈值的 AI 公司需要购买碳信用,以抵消其排放。未达到预定排放阈值的公司则可以出售多余的碳信用,从中获利。这种机制类似于制造业和能源生产等行业成功实施的更广泛的限额与交易计划。然而,正如在 非捆绑能源属性证书(EACs) 中所见,碳信用计划的设计必须谨慎,以确保真正减少排放,而不是让公司通过购买碳信用“逃避”可持续性承诺。

尽管政府激励措施在推动绿色 AI 方面具有强大作用,但其设计和实施需要谨慎考虑。激励措施应旨在推动实质性变化,而非制造漏洞,让组织在没有真正改善可持续性的情况下获得利益。此外,政策必须保持足够的灵活性,以适应 AI 技术的快速发展。通过战略性地结合税收激励、资金计划、采购政策和碳信用制度,政府可以创造一个可持续性不仅仅是监管要求,而是经济优势的生态系统。

自我监管

尽管政府政策在塑造可持续 AI 实践中发挥着重要作用,但 AI 行业本身也可以通过自我监管推动显著的环境改善。许多领先的 AI 公司和研究机构已经自愿承诺减少碳足迹、提高能效和促进可持续发展。这些努力可以补充监管政策,在某些情况下,甚至设定比政府规定更高的标准。

一个明显的自我监管策略是主要 AI 公司承诺使用可再生能源运营。谷歌、微软、亚马逊和 Meta 等公司已承诺采购足够的清洁能源,以匹配其电力消耗。谷歌更是通过确保其数据中心每小时、每天都完全依靠可再生能源运行,力争实现 24/7 碳中和能源 。这些承诺不仅减少了运营排放,还为可再生能源创造了市场需求,加速了向更绿色电网的转型。然而,正如在使用非捆绑 EACs 时所看到的,确保可再生能源声明的透明度和问责制对于确保真正的脱碳至关重要,而非表面文章。

另一种自我监管方式是内部采用碳定价模型。一些公司实施影子定价,即在财务决策中对碳排放赋予内部成本。通过将这些成本纳入预算和投资策略,AI 公司可以优先考虑能源高效的基础设施和低排放的 AI 模型。这种方法类似于航空、制造等行业的更广泛企业可持续发展努力,在这些行业中,内部碳定价已被证明是推动减排的有效工具。

除了能源消耗,AI 开发者还可以实施自愿效率清单,以指导可持续设计选择。像 AI 可持续性联盟 这样的组织提出了最佳实践框架,涵盖模型开发、硬件选择和操作能源管理。这些清单可以作为 AI 工程师将可持续性融入工作流程的实用工具。公开承诺遵循这些指南的公司,为更广泛的行业树立了榜样,表明可持续性不仅仅是事后考虑,而是核心设计原则。

独立的可持续性审计通过提供第三方评估,进一步增强了问责制。这些审计评估能源消耗、碳排放和绿色计算最佳实践的遵循情况。自愿接受审计并公布结果的 AI 公司,有助于建立与消费者、投资者和监管机构的信任。环境报告的透明度使利益相关者能够核实公司是否履行可持续性承诺。

AI 可持续性中的自我监管还体现在开源合作中。 CodeCarbon 和 ML $\textrm{CO}_2$ Impact 等倡议提供工具,允许开发者估算和跟踪其 AI 模型的碳足迹。通过将这些工具集成到 TensorFlow 和 PyTorch 等主流 AI 开发平台,行业可以将可持续性追踪规范化为标准实践。鼓励开发者测量和优化其能耗,培养问责和持续改进的文化。

尽管自我监管是朝可持续发展迈出的重要一步,但它不能替代政府监管。自愿承诺的力度取决于驱动它们的激励机制,缺乏外部问责,一些公司可能会将利润置于可持续性之上。然而,结合监管框架,自我监管可以通过允许行业领导者设定高于法律规定的标准,加速可持续发展进程。通过将可持续性嵌入企业战略,AI 公司可以证明技术进步与环境责任并不矛盾。

全球影响

尽管 AI 可持续性努力正获得动力,但在国家政策、行业倡议和区域能源基础设施之间仍然存在碎片化。AI 的环境足迹具有全球性,跨越供应链、云数据中心和国际市场。政府和企业之间缺乏协调,可能导致低效、相互矛盾的法规,以及允许公司转移环境负担而非真正减少负担的漏洞。因此,建立全球框架以实现 AI 可持续性,对于政策协调、问责制和推动减轻 AI 环境影响的实质性进展至关重要。

全球 AI 可持续性努力面临的主要挑战是监管差异。各国和地区对 AI 治理的方式截然不同。例如,欧盟的 AI 法案引入了全面的基于风险的监管,其中包括对 AI 系统进行能效和环境影响评估的规定。相比之下,美国主要采取市场驱动的方法,强调企业自我监管和自愿可持续性承诺,而非强制性规定。同时,中国通过大量政府投资优先发展 AI,尽管可持续性在技术领导力之前的地位相对较低。这种监管上的碎片化导致 AI 相关排放、资源消耗和能源效率的追踪和管理方式不一致。

解决这种碎片化问题的一种建议是标准化 AI 系统的可持续性报告指标。经济合作与发展组织(OECD)、IEEE 和联合国等机构已推动类似于财务披露框架的统一环境影响报告标准。这将使公司能够使用通用方法追踪和比较其碳足迹、能源使用和资源消耗。将 LCA 标准应用于 AI(如同更广泛的环境核算实践)将允许更准确地评估 AI 的整体环境影响,包括硬件制造、部署和退役。

除了报告,能源电网脱碳仍然是全球关注的一个重要问题。AI 的可持续性在很大程度上取决于不同地区电力的碳强度。例如,在像波兰这样依赖煤炭的地区训练大型 AI 模型,其碳排放量显著高于在水电占主导的挪威进行同样训练的情况。然而,基于市场的能源核算实践,包括购买非捆绑的能源属性证书(EACs),使一些公司能够声称碳中和,尽管其运营在高排放电网中进行。这导致人们担心,可持续性声明可能并不总是反映实际的减排,而是依赖于转移碳责任而非消除责任的金融工具。作为回应,谷歌倡导的 24/7 碳中和能源(CFE)目标是实时匹配当地能源消耗与可再生能源,避免依赖远程补偿。如果广泛采用,这一模式可能成为全球 AI 可持续性核算的基准。

另一个全球关注的关键领域是 AI 硬件的供应链和电子垃圾管理。AI 加速器、GPU 和数据中心硬件的生产依赖于跨越多个大洲的原材料开采、半导体制造和电子组装的复杂网络。这一供应链的环境影响,包括在非洲的稀土矿开采、在台湾的芯片制造和在中国的最终组装,往往超出了 AI 公司自身的管辖范围。这凸显了在可持续半导体生产、负责任的采矿实践和电子垃圾回收政策方面达成国际协议的必要性。

《巴塞尔公约》对危险废物出口的管制,可能为全球应对 AI 相关电子垃圾挑战提供了一个范例。该公约限制了发达国家向发展中国家转移有毒电子垃圾的行为,以防止在环境保护措施较弱的地区进行不安全的回收。将此类协议扩展到涵盖 AI 特定硬件组件(如 GPU 和推理芯片),可以确保废弃物的最终处置得到负责任的处理,而非外包给环境保护措施较弱的地区。

国际间在 AI 可持续性方面的合作,不仅是为了减少危害,也是为了利用 AI 作为推动环境进步的工具。AI 模型已被用于气候预测、可再生能源优化和精准农业,展示了其对全球可持续发展目标的潜在贡献。这些应用代表了 AI 能力与社会利益的交汇,表明 AI 可以为积极的环境和社会成果做出贡献。各国政府、研究机构和行业领袖必须就扩大支持气候行动的 AI 解决方案的最佳实践达成一致,确保 AI 不仅仅是可持续性挑战,更是全球环境韧性的强大工具。

最终,实现可持续 AI 需要协调一致的全球方法,整合监管对齐、标准化可持续性报告、能源脱碳、供应链问责和负责任的电子垃圾管理。如果没有这种合作,地区间在 AI 治理上的差异可能会阻碍实质性进展,使低效和外部化的环境成本持续存在。随着 AI 的不断发展,建立全球框架,以平衡技术进步与环境责任,将在塑造一个既智能又可持续的 AI 驱动的未来中发挥重要作用。

公众参与

随着人工智能(AI)日益与应对环境挑战的努力交织在一起,公众认知在塑造其采用、监管和长期社会影响方面发挥着关键作用。尽管 AI 常被视为推动可持续发展的强大工具,应用于智能能源管理、气候建模和保护工作,但其环境足迹、伦理问题和透明度仍受到审视。

围绕 AI 与可持续性的公众话语通常是两极分化的。一方面,AI 被誉为能够加速气候行动、减少碳排放和优化资源利用的变革性力量。另一方面,人们对 AI 模型的高能耗、潜在的意外环境后果以及 AI 驱动的决策过程缺乏透明度等问题表示担忧。这些对立的观点影响着政策制定、资金优先级以及社会对 AI 驱动的可持续发展倡议的接受度。

弥合 AI 研究人员、政策制定者与公众之间的鸿沟,对于确保 AI 在可持续发展中的贡献既有科学依据又符合社会责任至关重要。这需要对 AI 的能力和局限性进行清晰的沟通,提高 AI 决策过程的透明度,并建立公众参与的机制。若缺乏知情的公众参与,误解和怀疑可能会阻碍 AI 解决方案的采用,而这些解决方案有潜力推动有意义的环境进步。

公众对 AI 环境影响的理解

公众对 AI 及其在可持续性中作用的理解仍然有限,往往受到媒体叙事的影响,这些叙事要么强调其变革潜力,要么强调其风险。皮尤研究中心的调查显示,尽管大多数人听说过 AI,但他们对其具体应用(尤其是在可持续性方面)的理解仍然肤浅。许多人将 AI 与自动化、推荐系统或聊天机器人联系在一起,但可能不知道其在气候科学、能源优化和环境监测等方面的更广泛影响。这种公众认知与技术现实之间的差距,凸显了对 AI 系统及其在应对社会挑战中的实际应用进行基础教育的必要性。

影响公众认知的一个关键因素是 AI 可持续性贡献的表述方式。乐观的描述强调 AI 增强可再生能源整合、提高气候建模准确性和实现智能基础设施以减少排放的能力。像 气候变化 AI 这样的组织积极宣传 AI 在环境应用中的潜力,促进了积极的叙事。相反,人们对 AI 能源密集型训练过程、伦理考量和潜在偏见的担忧,导致了怀疑的声音。分析 AI 可持续性公众话语的研究表明,乐观与谨慎的观点大致各占一半,有些人担心 AI 的环境成本可能超过其收益。

在许多情况下,公众对 AI 驱动的可持续发展努力的态度,受到对相关机构信任度的影响。由信誉良好的环境组织或与科学界合作部署的 AI 系统,往往更容易获得公众的认可。然而,企业主导的 AI 可持续性倡议则常常面临怀疑,特别是当这些倡议被视为“绿色洗涤”时,即公司夸大其对环境责任的承诺,而没有采取实质性行动。

为了促进知情的公众参与,提高 AI 素养至关重要。这涉及对 AI 实际能耗、优化潜力和在可持续性中实际应用的教育。大学、研究机构和行业领袖可以通过公开报告、互动工具和清晰的沟通策略,在提高公众对 AI 可持续性影响的认识方面发挥关键作用。

AI 可持续性权衡的沟通

AI 的沟通方式对其在可持续性中的作用的公众认知有重大影响。围绕 AI 驱动的环境努力的信息传递,必须在技术准确性、现实期望和透明度之间取得平衡,以确保建设性话语。

乐观的叙事强调 AI 作为可持续性强大工具的潜力。 气候变化 AI 和 AI 驱动的保护项目突出了在野生动物保护、气候建模、能源效率和污染监测等方面的应用。这些例子通常被表述为 AI 增强了人类能力,使我们能够更精确和大规模地解决环境挑战。这种积极的表述方式鼓励了公众对 AI 驱动的可持续发展研究的支持和投资。

然而,怀疑的声音依然存在,特别是针对 AI 自身的环境足迹。批判性观点强调了 AI 模型训练过程的巨大能源需求,尤其是大规模神经网络的训练。 阿西洛马 AI 原则 等警示性框架强调了透明度、伦理防护措施和节能型 AI 发展的必要性。生成性 AI 模型的兴起,进一步加剧了人们对数据中心能耗、供应链可持续性和计算密集型 AI 工作负载长期可行性的担忧。

在 AI 可持续性信息传递中面临的一个关键挑战是避免极端化。公众话语往往陷入两种极端的看法:一种是将 AI 视为解决气候变化的不可或缺的工具,另一种是将其描绘为加剧生态危害的失控技术。这两种观点都未能全面反映现实。AI 和任何技术一样,都是一种工具,其环境影响取决于其开发、部署和治理方式。

为了建立公众信任和参与,AI 可持续性信息传递应优先考虑三个关键方面。首先,必须通过呈现 AI 对可持续性的利弊、能源消耗、数据偏见和实际部署挑战,来承认明确的权衡。其次,信息传递应基于证据,通过数据驱动的评估、生命周期分析和透明的碳核算来传达 AI 的影响,而非投机性的承诺。第三,表述应以人为本,强调 AI 系统与科学家、政策制定者和社区协作,而非完全自动化和不透明的决策系统。通过这种平衡和透明的方法,AI 可以在推动有意义的环境进步的同时,保持其可信度。

有效的公众参与依赖于弥合 AI 从业者与非专业人士之间的知识差距,确保 AI 在可持续性中的作用是基于现实的、公开讨论的,并不断评估的。

透明度与信任

随着 AI 系统越来越多地融入可持续发展工作,透明度和信任对于确保公众对其部署的信心至关重要。AI 模型的复杂性,尤其是那些用于环境监测、资源优化和排放跟踪的模型,往往使利益相关者难以理解其决策过程。如果没有清晰的 AI 系统操作方式的解释,关于偏见、问责和意外后果的担忧可能会削弱公众信任。

透明度的一个关键方面是确保用于可持续性应用的 AI 模型是可解释和可理解的。 国家标准与技术研究院(NIST) 的可解释 AI 原则为设计提供了框架,确保系统能够对其输出提供有意义和可理解的解释。这些原则强调,AI 生成的决策应具有上下文相关性,准确反映模型逻辑,并清晰传达系统的局限性。在可持续性应用中,AI 影响环境政策、保护策略和能源管理,因此可解释性对于公众问责至关重要。

在 AI 可持续性声明中,透明度同样必要。许多科技公司宣传其 AI 驱动的可持续发展倡议,但由于缺乏标准化报告,实际影响难以核实。蒙特利尔碳承诺为这一领域的问责提供了宝贵的框架:

“作为机构投资者,我们必须以受益人的最佳长期利益行事。在这一受托责任下,温室气体排放、气候变化和碳监管相关的长期投资风险日益凸显。测量我们的碳足迹是更好地理解、量化和管理投资中碳和气候变化相关影响、风险和机遇的关键一步。因此,作为第一步,我们承诺每年测量和披露我们投资的碳足迹,并利用这些信息制定参与战略,确定和设定碳足迹减少目标。” — 蒙特利尔碳承诺

对 AI 可持续性声明采取类似的承诺,即公司披露训练和部署模型的环境足迹,将使公众对 AI 的可持续性贡献有更清晰的了解。若无此类措施,公司可能面临“绿色洗涤”的指控,即夸大或误导性宣传可持续性利益。

除了企业问责,AI 治理中的透明度确保了部署用于可持续性的 AI 系统受到伦理监督。将 AI 融入环境决策中,提出了对这些技术的控制权及其与社会价值观的一致性的问题。OECD AI 政策观察等努力强调了监管框架的必要性,要求 AI 开发者在重要的可持续性应用中披露能耗、数据来源和模型偏见。公众获取这些信息的渠道,将允许更大的审查并促进对 AI 驱动解决方案的信任。

建立对可持续性 AI 的信任,不仅需要清晰解释模型如何运作,还需要主动让利益相关者参与决策过程。透明机制,如开放获取数据集、公共 AI 审计和参与式模型开发,可以增强问责制。通过确保可持续性中的 AI 应用保持可理解、可验证和伦理治理,可以建立信任,从而获得更广泛的公众支持 AI 驱动的环境解决方案。

在 AI 治理中建立公众参与

公众参与在塑造 AI 驱动的可持续发展努力的采用和有效性方面发挥着重要作用。尽管 AI 有潜力带来显著的环境效益,但其成功在很大程度上取决于公众对其应用的理解和支持。广泛的误解、对 AI 在可持续性中作用的有限认识,以及对伦理和环境风险的担忧,可能会阻碍有意义的参与。解决这些问题需要通过教育、参与和赋权不同社区,来促进对 AI 环境可持续性影响的讨论。

调查显示,尽管 AI 被广泛认可,但其与可持续性交叉的具体方式仍不为公众所知。皮尤研究中心的一项研究发现,虽然 87% 的受访者听说过 AI,但只有一小部分人能够解释其如何影响能源消耗、排放或保护工作。对 AI 作用的这种理解差距,可能导致公众怀疑 AI 是否会因其高计算需求而对环境造成贡献,而非作为应对气候挑战的工具。为了建立公众对 AI 可持续发展倡议的信心,清晰的沟通至关重要。

提高公众 AI 素养的努力可以采取多种形式。突出 AI 在优化可再生能源电网、减少食物浪费或监测生物多样性方面的作用,可以帮助揭开这项技术的神秘面纱。气候变化 AI 和 AI 合作伙伴关系等项目,积极提供研究、案例研究和政策建议,说明 AI 在应对气候变化中的益处。媒体的报道方式在塑造公众认知中也发挥着重要作用,负责任的报道 AI 的环境潜力及其挑战,可以提供更为平衡的叙事。

除了教育,参与还需要各利益相关方的积极参与,包括地方社区、环境团体和政策制定者。许多 AI 驱动的可持续发展项目侧重于数据收集和自动化,但在让受影响社区参与决策方面却缺乏机制。例如,用于水资源保护或野火预测的 AI 模型,可能依赖于忽视当地居民经验的数据。创建参与式 AI 设计渠道,让社区提供见解、验证模型输出和影响政策,可以导致更具包容性和上下文相关的可持续解决方案。

当 AI 决策影响资源分配、环境公正或监管行动时,透明度和公众参与尤为重要。例如,AI 驱动的碳信用市场,需要确保发展中国家的社区从可持续发展倡议中受益,而不是面临土地流失或剥削等意外伤害的机制。公众咨询、开放数据平台和独立的 AI 伦理委员会,可以帮助将社会价值观融入 AI 驱动的可持续发展政策中。

最终,促进公众参与和提高 AI 可持续性意识,需要多方面的努力,结合教育、沟通和参与式治理。通过确保 AI 系统可被访问、理解和响应社区需求,可以增强公众对 AI 驱动的可持续解决方案的信任和支持。这一参与对于将 AI 创新与社会优先事项对齐,以及确保环境 AI 系统服务于更广泛的公众利益至关重要。

环境正义与 AI 访问

确保公平获取 AI 驱动的可持续解决方案,对于促进全球环境进步至关重要。尽管 AI 在优化能源电网、监测森林砍伐和改善气候建模方面展现了潜力,但这些技术的获取仍然分布不均。发展中国家、边缘化社区和小型环境组织,往往缺乏有效利用 AI 的基础设施、资金和专业知识。解决这些差距,对于确保 AI 可持续解决方案的益处惠及所有人群,而不是加剧现有的环境和社会经济不平等至关重要。

公平获取 AI 的主要障碍是数字鸿沟。许多 AI 可持续性应用依赖于先进的计算基础设施、云资源和高质量的数据集,而这些主要集中在高收入地区。经济合作与发展组织(OECD)关于国家 AI 计算能力的最新报告指出,许多国家缺乏发展 AI 基础设施的战略路线图,导致 AI 富国和穷国之间的差距不断扩大。若不针对性地投资 AI 基础设施,低收入国家将被排除在 AI 驱动的可持续发展进程之外。扩大计算资源的获取、支持开源 AI 框架以及提供基于云的环境监测 AI 解决方案,可能有助于弥合这一差距。

除了基础设施限制,缺乏高质量、特定于地区的数据也是一个重大挑战。基于工业化国家数据集训练的 AI 模型,可能无法很好地推广到其他地理和社会经济背景。以北美的水资源保护 AI 模型为例,其在面临不同气候模式、农业实践或监管结构的地区可能效果不佳。通过收集多样化的数据集、与地方组织建立伙伴关系以及融合本土知识,地方化 AI 可持续性应用的努力,可以提高 AI 解决方案在欠代表地区的相关性和影响力。

获取 AI 工具还需要技术素养和能力建设的举措。许多小型环境组织和社区驱动的可持续发展项目,缺乏有效开发或部署 AI 解决方案所需的内部专业知识。能力建设工作,如 AI 培训项目、知识共享网络以及学术机构与环境团体之间的合作,可以使地方利益相关者能够采用 AI 驱动的可持续发展实践。气候变化 AI 和 AI 合作伙伴关系等组织,已采取措施提供资源和指导,帮助环境应用中的 AI 使用,但仍需更广泛的努力来实现 AI 访问的民主化。

资金机制在决定谁能从 AI 驱动的可持续发展中受益方面也发挥着重要作用。大型企业和资金充足的研究机构能够投资于 AI 驱动的环境解决方案,而小型组织则常常缺乏必要的财务资源。政府补助、慈善资金和国际 AI 促进可持续发展的倡议,可以帮助确保基层可持续发展努力能够使用 AI 技术。例如,西班牙已专门拨款 3 亿欧元用于 AI 和可持续发展项目,为公共投资环保 AI 创新树立了先例。全球范围内扩大此类资金模式,可能促进更具包容性的 AI 采用。

除了技术和财务障碍,政策干预也是确保 AI 可持续发展努力公平分配的必要条件。如果没有优先考虑包容性的监管框架,AI 驱动的环境解决方案可能会使已有技术优势的地区受益,而忽视了可持续发展挑战最为迫切的地区。各国政府和国际机构应制定政策,鼓励公平采用 AI,例如要求 AI 可持续发展项目考虑社会影响评估,或强制透明报告 AI 驱动的环境倡议。

确保公平获取 AI 可持续性解决方案,不仅是一个技术挑战,更是环境正义的核心问题。随着 AI 在全球可持续发展中的作用日益加重,必须采取积极措施,防止技术加剧现有的不平等。通过投资 AI 基础设施、地方化 AI 应用、支持能力建设和实施包容性政策,AI 可以成为赋能所有社区应对气候变化和环境恶化的工具。

未来挑战

随着 AI 的不断发展,其在环境可持续性中的作用也将扩大。AI 的进步有潜力加速可再生能源、气候建模、生物多样性保护和资源效率等领域的进展。然而,实现这一潜力需要解决与能源效率、基础设施可持续性、数据可用性和治理相关的重大挑战。AI 和可持续发展的未来在于创新与负责任的环境管理之间取得平衡,确保 AI 驱动的进步不会以增加环境恶化为代价。

新兴技术研究方向

AI 可持续性的一个主要优先事项是开发更节能的模型和算法。优化深度学习模型以最小化计算成本是一个关键研究方向,模型剪枝、量化和低精度数值等技术显示出在不影响性能的情况下减少能耗的显著潜力。这些策略旨在提高 AI 工作负载的效率,同时利用专用硬件加速器最大化计算吞吐量,最小化能量消耗。非冯·诺依曼计算40范式(如类脑计算和内存计算)的持续发展,为通过专用硬件设计实现节能 AI 架构提供了另一条途径。

另一个重要方向是将可再生能源纳入 AI 基础设施。鉴于数据中心是 AI 碳足迹的主要来源之一,向太阳能、风能和水电等清洁能源转型势在必行。这一转型的可行性取决于可持续能源存储技术的进展,例如麻省理工学院衍生的初创公司 Ambri 正在开发的液态金属电池解决方案。这些创新有望使数据中心更可靠地使用可再生能源,从而减少对化石燃料电网电力的依赖。然而,要大规模实现这一转型,需要 AI 公司、能源供应商和政策制定者之间的协作,制定电网感知的 AI 调度和碳感知的工作负载管理策略,确保计算密集型 AI 任务在可再生能源供应高峰期进行。

除了能源效率,AI 可持续性还将受益于智能资源配置和废物减少策略。提高计算资源的利用率、减少冗余模型训练周期和实施高效数据采样技术,可以大幅降低能耗。AI 模型开发中的一个关键挑战是实验与效率之间的权衡——神经架构搜索和超参数优化等技术可以提高模型性能,但通常需要大量计算资源。研究高效实验方法学,有助于找到平衡点,在改进模型的同时,减轻过度训练带来的环境影响。

实施障碍与标准化需求

尽管有这些有希望的研究方向,但要实现真正可持续的 AI,仍需解决重大障碍。一个紧迫的挑战是缺乏标准化的测量和报告框架,以评估 AI 的环境足迹。与传统行业不同,后者的生命周期评估方法已相对成熟,AI 系统则需要更全面和灵活的方法,考虑硬件(计算基础设施)和软件(模型训练和推理周期)的整体环境影响。尽管像 MLCommons 这样的努力已将能效纳入基准实践,但仍需更广泛、全球公认的标准,以确保 AI 相关排放报告的一致性。

另一个重要挑战是优化 AI 基础设施的使用寿命和可持续性。AI 加速器和数据中心硬件的设计,必须以最大化利用率、延长操作寿命和最小化环境影响为目标。未来的 AI 基础设施必须优先考虑可重复使用、模块化设计和循环经济原则,以尽量减少电子垃圾和对稀土材料的依赖,而非仅仅追求性能提升。

从软件角度来看,减少冗余计算对于降低能源密集型工作负载至关重要。仅关注训练和推理能耗的做法,未能考虑系统的整体环境影响。通过更智能的数据采样策略,优化训练过程,确保仅使用最相关的数据子集来优化模型,减少能源足迹,而不牺牲模型质量。

数据可获取性和透明度同样是一个挑战。许多 AI 可持续性工作依赖于企业和政府对能耗、碳排放和环境影响数据的披露。然而,数据缺口和不一致性,妨碍了对 AI 足迹的准确评估。AI 公司对其可持续发展举措的透明度提高,以及环境影响研究的开放获取数据集,将允许更严格的分析,并为可持续 AI 开发提供最佳实践。

最后,AI 创新的快速步伐对监管和治理提出了挑战。政策制定者必须制定灵活、前瞻性的政策,促进可持续性,同时保留 AI 研究和创新所需的灵活性。监管框架应鼓励高效的 AI 实践,例如促进碳感知计算、激励节能的 AI 模型开发,并确保 AI 驱动的环境应用与更广泛的可持续发展目标相一致。这需要 AI 研究人员、环境科学家、能源部门利益相关者和政策制定者之间的密切合作,以制定促进负责任 AI 增长的监管环境,同时尽量减少生态危害。

可持续 AI 系统的综合方法

AI 在可持续发展中的未来充满希望,但也面临挑战。为充分利用 AI 的潜力,同时减轻其环境影响,必须采用节能的模型开发、可再生能源整合、硬件和软件优化以及透明的环境报告。解决这些挑战需要跨技术、工业和政策领域的多学科合作,确保 AI 的发展轨迹与全球可持续发展努力相一致。

通过将可持续性原则嵌入 AI 系统设计、优化计算基础设施和建立明确的问责机制,AI 可以成为推动环境进步的催化剂,而非生态恶化的推手。未来几年将是塑造 AI 在可持续发展中角色的关键时期,决定其是加剧现有挑战,还是成为应对气候变化和资源枯竭的重要工具。

常见误区与陷阱

可持续 AI 涉及计算性能与环境影响之间的复杂权衡,这常常挑战着人们对高效和负责任的系统设计的传统假设。AI 工作负载的规模不断扩大,以及云计算便利性的吸引,可能导致人们对真实环境成本和最有效减少生态影响策略的误解。

误区: 云计算自动使 AI 系统在环境上更可持续。

这一误解认为,云部署固有地提供了环境效益,而不考虑云基础设施的实际能源来源和利用模式。尽管云提供商的资源利用率通常高于个别组织,但它们往往依赖化石燃料能源,并在碳密集的电力电网区域运营数据中心。云计算的便利性也可能通过过度配置和低效的工作负载调度,导致资源浪费。要实现真正的可持续性,需谨慎选择云服务提供商、考虑地区差异并合理管理资源,而非单纯依赖云部署的绿色假设。

陷阱: 仅关注操作能耗,而忽视嵌入式碳和生命周期影响。

许多从业者仅通过训练和推理的能耗来衡量 AI 的可持续性,而未考虑其系统的整体环境足迹。正如我们在三阶段生命周期评估框架中所阐述的,硬件制造、数据中心建设、冷却基础设施和电子垃圾处置,均对环境影响显著。专用 AI 加速器的嵌入式碳足迹可能超过操作排放。全面的可持续性评估需要生命周期分析,涵盖所有三个阶段——训练、推理和制造,而非仅关注操作能耗。

误区: 效率的提高会自动转化为环境影响的减少。

这一信念假设,使 AI 系统更具计算效率必然会减少其环境足迹。然而,效率提升往往通过反弹效应导致使用增加,即更便宜的计算促使更广泛的部署和应用范围。更高效的模型可能会被更广泛地部署,从而增加总资源消耗,尽管单元性能得到了改善。此外,要求专用硬件的效率优化,可能通过加速硬件更换周期而增加嵌入式碳。可持续的 AI 发展需要同时考虑效率提升及其更广泛的部署影响。

陷阱: 将碳补偿视为减少实际排放的替代方案。

组织通常通过购买碳补偿来抵消其 AI 系统的排放,而不解决潜在的能源消耗模式。许多补偿项目的额外性、持久性或验证标准存疑,未能提供承诺的环境效益。依赖补偿可能延缓对可再生能源和高效计算实践的必要转型。可持续的 AI 发展应优先考虑通过采用可再生能源、提高能效和合理管理资源来减少实际排放,仅将补偿作为减排策略的补充,而非替代。

陷阱: 优化单个组件以实现可持续性,而不考虑整个系统生命周期影响。

许多可持续性努力集中于单独优化系统组件,而未分析这些优化对更广泛系统架构和生命周期环境影响的影响。通过更小的模型来减少训练能耗,可能会在广泛部署时增加推理计算需求,从而增加系统总排放。同样,通过高效软件延长硬件寿命,可能不如采用更新、更节能的硬件在整体生命周期排放方面可持续。边缘部署虽然减少了数据中心能耗,但可能增加分布式硬件的制造需求,并带来复杂的电子垃圾管理挑战。网络优化虽然减少了带宽使用,但可能需要额外的计算资源用于压缩或缓存。有效的可持续 AI 需要全面的生命周期评估,考虑硬件采购、软件部署、操作使用模式、维护需求和废弃处置等各方面的环境影响,而非孤立地优化单一指标。

总结

可持续 AI 代表了技术进步与环境责任和资源保护之间的交汇点。机器学习系统通过计算密集型训练消耗能源,通过耗能巨大的推理基础设施运行,并推动对资源密集型硬件制造的需求。然而,这些系统同样具备气候建模、减排、资源优化和生物多样性保护的能力,形成了环境影响与环境效益之间复杂的关系,亟需工程师的深思熟虑。

AI 系统的整体生命周期影响超出了操作能耗,还包括硬件制造、数据中心基础设施、冷却系统和电子垃圾管理。绿色 AI 实践侧重于节能的模型架构、可再生能源的整合、碳感知计算和考虑生命周期的开发过程。政策框架和测量标准通过环境报告要求、效率激励和治理机制,推动问责制,使技术创新与可持续发展目标相一致。

关键要点

- AI 系统在其整个生命周期内都会产生环境影响,从硬件制造到训练、部署和处置

- 可持续 AI 需要通过高效的架构和负责任的基础设施选择,在计算能力与环境成本之间取得平衡

- 绿色 AI 实践包括节能的模型设计、可再生能源整合、碳感知计算和全面的生命周期评估

- 成功需要 AI 研究人员、环境科学家、政策制定者和行业利益相关者之间的跨学科合作可持续 AI 的未来取决于我们今天在系统设计、基础设施部署和治理框架方面的选择。气候应用展示了 AI 加速环境解决方案的潜力,从提高能源电网效率到优化资源使用和对复杂生态系统进行建模。然而,要实现这一潜力,需要将可持续性考虑嵌入 AI 开发的各个方面,创造出在推动技术能力进步的同时,增强而非损害环境福祉的系统。

测验:可持续 AI

测试你对可持续 AI 核心概念的理解,包括环境影响、测量框架和优化策略

家庭用电对比:美国普通家庭年均用电量为 10,500 千瓦时(约每月 875 千瓦时)。尽管 OpenAI 未公布 GPT-4 训练能耗数据,但有估算认为其能耗远超 GPT-3 的 1,287 MWh。作为对比,GPT-3 的训练用电量相当于 122 户美国家庭一年的总用电。 ↩︎

GPU 制造影响:生产一块高端 GPU(如 NVIDIA H100)在计算前就会产生 300-500 千克二氧化碳。制造过程需消耗 2,500 升超纯水、15 种以上稀土元素,并经历高达 1,000°C 的能耗工艺。台积电 4nm 工艺虽然单位能效更高,但制造流程更复杂,整体能耗高于 7nm 工艺。 ↩︎

计算设备电子垃圾:2019 年全球电子垃圾达 5,400 万吨,计算设备占 15%。AI 硬件加速了这一趋势:2020-2023 年 NVIDIA GPU 销量增长 200%,每块高端 GPU 重 2-4 磅,含有需特殊处理的有害物质。由于性能迭代快,AI 硬件通常 3-5 年即报废。 ↩︎

环境正义:确保环境利益与负担在所有社区间公平分配,无论种族、肤色或收入。在 AI 领域,数据中心常选址于经济欠发达地区以获取廉价土地和电力,将污染、水资源消耗和热量等环境负担转嫁给缺乏话语权的社区,而 AI 带来的就业和经济增长则集中于富裕科技中心。例如微软在爱荷华州农村的数据中心每日用水 600 万加仑,而当地农民却面临干旱限水。 ↩︎

摩尔定律起源:由英特尔联合创始人戈登·摩尔于 1965 年提出,最初预测每年翻番,后修正为两年。摩尔定律推动了全球 4 万亿美元电子产业,使智能手机和超级计算机成为可能。但在 3nm 工艺节点,原子级别成为极限。 ↩︎

丹纳德缩放律:1974 年 IBM 的 Robert Dennard 发现,更小的晶体管可通过降低电压保持功耗密度不变。该规律带来了 30 年的“免费”性能提升,直到 2005 年左右因漏电流和电压缩放极限终结。若无丹纳德缩放,现代 CPU 功耗将达千瓦级。其终结促使多核和 AI 专用加速器(如 GPU)的兴起。 ↩︎

训练过程:通过数据优化模型参数的计算过程,详见 第 8 章:AI 训练 。 ↩︎

能耗指标:pJ/MAC(每次乘加操作的皮焦耳数)衡量不同处理器类型的计算能效。 ↩︎

FLOP 对比:FLOPS(每秒浮点运算次数)衡量计算吞吐量。人脑能效对比有助于理解 AI 硬件的能耗需求。 ↩︎

动作电位:神经元用以通信的电脉冲,持续约 1 毫秒,每次消耗约 10⁻¹² 焦耳。与持续耗电的数字电路不同,神经元仅在激活时消耗能量。这种事件驱动机制让 86 亿神经元的人脑仅用 20W 功耗。现代类脑芯片如 Intel Loihi 模仿这种脉冲通信,实现 1000 倍能效提升。 ↩︎

类脑计算:受生物神经网络启发的硬件架构,采用模拟电路和事件驱动计算。由加州理工 Carver Mead 于 1980 年代提出,现代代表有 Intel Loihi(128 个类脑核,支持 13 万神经元)、IBM TrueNorth(100 万神经元)、BrainChip Akida。这些芯片仅在输入变化时处理信息,能耗比 GPU 低 1000 倍。 ↩︎

脉冲神经网络(SNN):第三代人工神经网络,通过离散脉冲(类似生物神经元)而非连续值通信。异步、时序处理,适合音视频等事件驱动数据。更接近生物机制且能效高,但训练难度大,标准任务准确率低于传统深度网络。 ↩︎

电力使用效率(PUE):行业标准指标,计算方式为总设施用电 ÷ IT 设备用电。理想值为 1.0(实际无法达到),典型数据中心为 1.6-2.0,Google 最优设施达 1.08。每提升 0.1 PUE 可节省数百万美元电费。Facebook Prineville 数据中心通过外部空气冷却实现 1.09 PUE。老旧数据中心常超 2.5。 ↩︎

优化过程:寻找最优模型参数的数学过程。梯度下降等方法详见 第 8 章:AI 训练 ↩︎

碳强度:每千瓦时电力产生的 CO₂ 排放量,单位为 kg CO₂/kWh。不同能源差异极大:煤(~0.82)、天然气(~0.36)、风能(~0.01)、核能(~0.006)、水电(~0.024)。电网碳强度随地区(如冰岛 99% 可再生,波兰 77% 煤电)和时段(如中午太阳能高峰)变化。这为碳感知计算提供了基础:将 AI 任务调度到碳强度最低的时空。 ↩︎

隐含碳:产品制造、运输和报废阶段的碳排放,与使用阶段排放区分。AI 硬件的隐含碳包括稀土开采、半导体制造、包装和运输。单块 NVIDIA H100 GPU 隐含碳 300-500 kg,相当于开车 1,000-1,600 英里。GPU 700W 功耗年排放 300 kg(按美电网均值),制造排放相当于 1-2 年运营。研究表明,制造排放可占 AI 系统总碳足迹 30%,且随数据中心清洁能源占比提升而占比上升。 ↩︎ ↩︎

密集运算:需大量数学操作的计算模式。具体神经网络操作详见 第 8 章:AI 训练 。 ↩︎

超大规模数据中心规模:Meta Prineville 数据中心占地 250 万平方英尺(57 个足球场),容纳 15 万台服务器。微软爱荷华州最大 Azure 数据中心占地 700 英亩,电力容量 300 MW。Google 全球 21 个超大规模设施年耗电 12.2 TWh,超过立陶宛或斯里兰卡全国用电。 ↩︎

训练范式:当前模型优化方法需分布式系统协作。详见 第 8 章:AI 训练 ↩︎

分布式训练:跨多节点训练模型需协调与通信。详见 第 8 章:AI 训练 。 ↩︎

Transformer + NAS 环境影响:62.6 万磅 CO₂ 指训练一个 Transformer 并进行架构搜索,包含评估 12,800 个模型配置。相当于 312 次纽约 - 伦敦经济舱往返航班,或 140 个美国人一年的排放。现代高效 NAS 技术已将该成本降低 1000 倍。 ↩︎

EUV 光刻:极紫外光(13.5nm 波长)用于 7nm 以下芯片制造。每台 EUV 设备价值超 2 亿美元,重 180 吨,需持续 1 MW 电力(相当于 800 户家庭),每日用水 3 万升。ASML 为全球唯一供应商。EUV 支撑现代 AI 芯片,但能耗是传统深紫外光刻的 10 倍。 ↩︎

AI 边缘计算:在数据源附近处理数据,减少云端延迟(云 100-200ms,边缘 1-10ms),适用于自动驾驶等场景。但边缘 AI 芯片数十亿台持续 5-50W 功耗,总体能耗远超偶发云推理。特斯拉 FSD 电脑行驶时功耗 72W,若全球 14 亿辆车都用 AI,需 50 座大型电厂供电。 ↩︎

中国稀土主导:中国产出全球 85% 稀土,精炼能力占 95%。2010 年中日外交危机导致对日出口骤降 40%,价格暴涨 20 倍。单块 NVIDIA H100 含 17 种稀土共 200-300 克。美国战略储备仅够 3 个月,重建供应链需 10-15 年和 500 亿美元投资。 ↩︎

生命周期评估(LCA):一种系统性方法,评估产品从原材料开采、制造、使用到处置全生命周期的环境影响。起源于 1960 年代,已由 ISO 14040/14044 标准化。对于 AI 系统,LCA 揭示硬件制造常占总排放的 30-50%,即便其本身不消耗运营能耗。研究发现,单块 NVIDIA H100 GPU 生产过程产生 300-500 kg CO₂,相当于开车 1,200 英里,尚未进行任何计算。 ↩︎

架构搜索:自动寻找最优模型结构的方法。神经架构搜索(NAS)详见 第 10 章:模型优化 。 ↩︎

循环经济:通过资源持续再利用消除浪费的经济模式,对比线性“开采 - 制造 - 废弃”模式。由艾伦·麦克阿瑟基金会 2010 年提出,现已被欧盟采纳,目标 2035 年电子产品回收率达 65%。电子领域的循环原则包括模块化、可维修和材料回收。戴尔海洋塑料计划、Fairphone 模块化手机是典型案例。AI 硬件采用循环模式,可将 GPU 寿命从 3-5 年延长至 8-10 年。 ↩︎

朱文斯悖论:由英国经济学家 Jevons 1865 年提出,发现煤炭效率提升反而导致总消耗增加。现代例子如 LED 灯——尽管比白炽灯节能 85%,但总照明能耗因使用量激增而上升。AI 领域同理,模型效率提升 10 倍,可能带来 100 倍应用增长,导致总环境影响反增。 ↩︎

FLOPS vs FLOPs:FLOPS(大写)为每秒浮点运算数,FLOPs(混合)为总运算数。GPT-3 训练需 3.1×10²³ FLOPs,总算力由 1.25×10¹⁷ FLOPS 硬件完成。不同硬件能效差异极大:CPU ~100 pJ/FLOP,GPU ~10 pJ/FLOP,TPU ~1 pJ/FLOP,专用加速器可达 0.1 pJ/FLOP,能效差异达 1000 倍,决定了可持续性空间。 ↩︎

剪枝技术:去除模型冗余部分以提升效率的方法,详见 第 10 章:模型优化 。 ↩︎

量化技术:降低模型数值精度以提升能效的方法,详见 第 10 章:模型优化 。 ↩︎

电力使用效率(PUE):数据中心效率以 PUE 衡量——总用电 ÷ IT 设备用电。行业均值 1.67(冷却/基础设施开销 67%),领先企业达 1.1-1.2。Google 最优数据中心 PUE 1.08,仅 8% 能耗为非计算。全球清洁能源投资超 150 亿美元。 ↩︎

数据中心冷却能耗:冷却平均占总能耗 38%。10 MW 数据中心年冷却电费 380 万美元。Google 机器学习优化冷却能耗降 40%,全球年省 1.5 亿美元。液冷对高密度 AI 负载能效比风冷高 3,000 倍,可将冷却能耗占比降至 10% 以下。为提升效率,数据中心正采用液冷、自然风冷等替代方案。液冷通过专用冷却液直接带走 AI 芯片热量,效率远超风冷,已在高密度集群部署。自然风冷利用外部空气,无需机械制冷,适合温带地区。微软更进一步,部署水下数据中心,利用海洋自然冷却,减少主动温控需求。 ↩︎

Google 碳感知调度成效:Google 碳智能计算平台通过区域内任务迁移,小时碳足迹降 15%;全球数据中心间迁移降 40%。系统每日处理 950 亿次搜索,动态优化电网碳强度。非紧急任务如批量训练可将 70% 负载迁移到低碳时段,年减排相当于 5 万辆汽车。 ↩︎

实时电网碳强度:全球碳强度差异极大——法国(核电)50g CO₂/kWh,波兰(煤电)820g/kWh。德州日内波动 10 倍(150-1,500g/kWh),取决于风能。Electricity Maps API 日均 5,000 万请求,支持碳感知计算。WattTime API 提供边际排放数据,优化效果优于平均强度 2-5 倍。 ↩︎

AI 数据中心核能:微软与 Helion Energy 签署 2028 年商业聚变协议,亚马逊投资 5 亿美元建小型模块化反应堆(SMR),Google 与 Kairos Power 探索 24/7 核能。美国核能占电力 20%,生命周期排放 12g CO₂/kWh,煤电 820-1,050g。新核能成本 $150-200/MWh,远高于可再生能源加储能。 ↩︎

欧盟 AI 法案:全球首部全面 AI 法规,2024 年通过,历时三年多。采用风险分级,分为最小、有限、高和不可接受风险。高风险 AI(含算力超 10²⁵ FLOPs 的基础模型)需合规评估、透明文档和能耗报告。最高罚款 3500 万欧元或全球营收 7%。旨在平衡创新、安全、核心权利与环境保护。 ↩︎

企业可持续报告指令:欧盟法规,要求 5 万多家大企业自 2024-2028 年起披露环境、社会和治理(ESG)影响。以强制、审计的可持续报告取代自愿指引,涵盖范围 1、2、3 排放,包括 AI 能耗。企业需按欧洲可持续报告标准(ESRS)披露,数据与财报可比。全欧年合规成本约 30-80 亿欧元。 ↩︎

排放交易体系(ETS):政府设定总排放上限(cap),并向企业分配可交易的排放配额的市场机制。2005 年启动的欧盟 ETS 是全球最大的碳市场,涵盖了 40% 的欧盟温室气体排放,涉及 10,000 多个设施。超出配额的企业必须购买碳信用(2023 年约 85 欧元/吨 CO₂),而高效的企业可以出售多余的配额。加州的限额与交易计划涵盖了 85% 的州排放。理论上,类似的体系可以限制 AI 计算资源消耗,创建“计算碳信用”的市场。 ↩︎

冯·诺依曼架构:传统计算模型,处理单元和内存分离,需不断在 CPU 和 RAM 之间移动数据。由约翰·冯·诺依曼于 1945 年提出,主导现代计算,但造成“冯·诺依曼瓶颈”——数据传输能耗高,消耗系统 60%~80% 的电力。类脑芯片、内存计算和数据流架构等非冯·诺依曼方法,通过在数据存储地处理数据,消除这一瓶颈,可能将 AI 能耗降低 100~1000 倍。 ↩︎